本文提出一种Transformer辅助跟踪框架,可与判别式跟踪器结合(如组成:TrDiMP),表现SOTA!性能优于SiamRPN++等,代码刚刚开源!

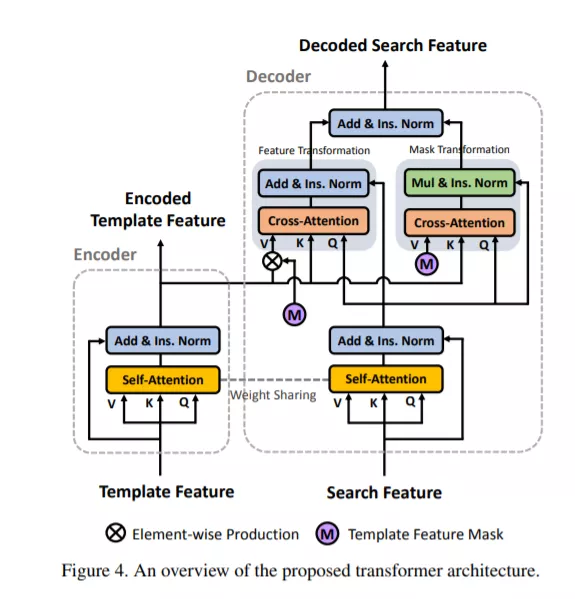

在视频目标跟踪中,连续帧之间存在丰富的时间上下文,在现有的跟踪器中已大大忽略了这些上下文。在这项工作中,我们桥接单个视频帧,并通过一个用于稳固对象跟踪的Transformer架构探索跨它们的时间上下文。与在自然语言处理任务中使用转换器的经典用法不同,我们将其编码器和解码器分为两个并行分支,并在类似于Siamese的跟踪pipeline中精心设计它们。Transformer编码器通过基于注意力的特征增强来促进目标模板,这有利于高质量跟踪模型的生成。Transformer解码器将跟踪提示从先前的模板传播到当前帧,从而简化了对象搜索过程。我们的Transformer辅助跟踪框架整洁并以端到端的方式进行了训练。使用提出的Transformer,一种简单的连体匹配方法就可以胜过当前表现最佳的跟踪器。通过将我们的Transformer与最新的判别式跟踪pipeline相结合,我们的方法在流行的跟踪基准上创下了一些新的最新记录。

https://www.zhuanzhi.ai/paper/c862787c6e21054a17ed51c178372f5e

成为VIP会员查看完整内容

相关内容

Arxiv

7+阅读 · 2021年3月22日