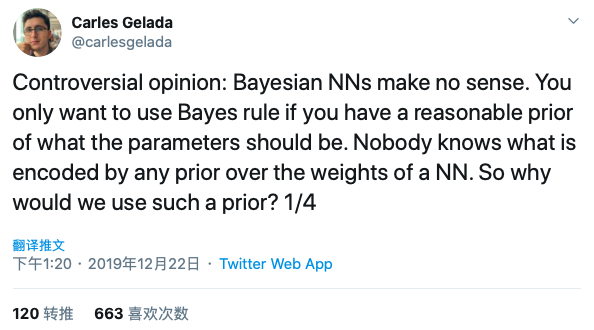

贝叶斯神经网络毫无意义吗?Twitter、Reddit双战场辩论,火药味十足!

最近Twitter、Reddit上有一股争论的热潮涌动,先是 有 François Chollet 、Yann LeCun 等人隔空辨析「到底什么是深度学习」 ,后是有一大批研究者争论「贝叶斯神经网络到底有没有意义」。新的一年,火药味十足,这是否也意味着深度学习的研究正进入一个混乱的时期?道理,不辨析不明朗;学问,不争论不清晰。

一、贝叶斯神经网络有用吗?

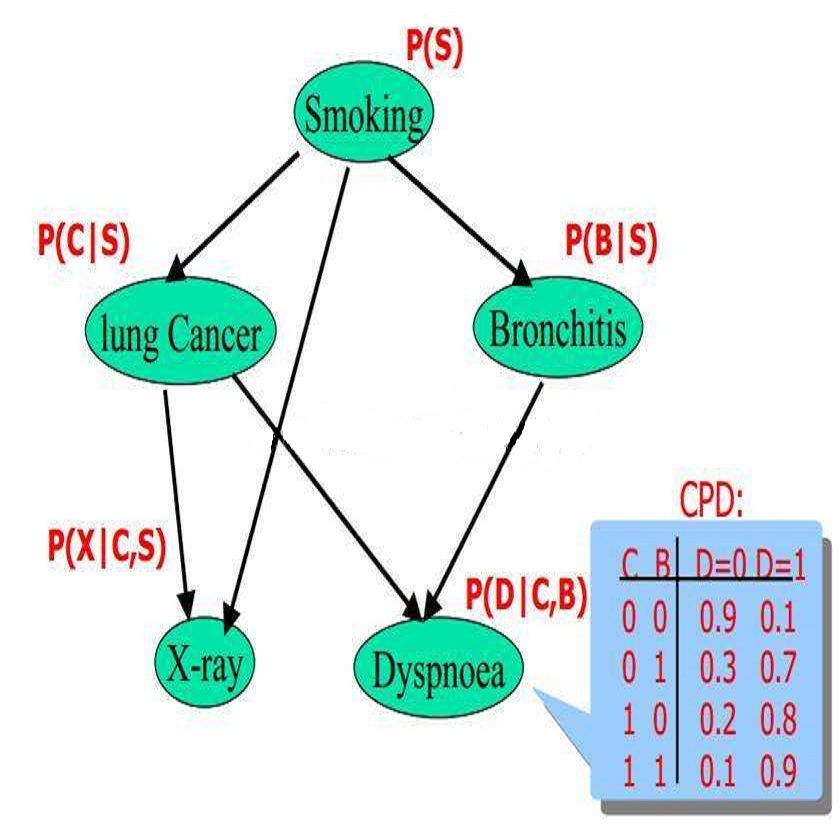

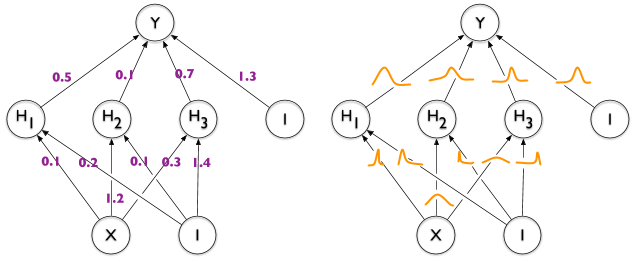

1、贝叶斯神经网络具有不确定性的原因:

泛化不可知先验

里面包含两种数据对:一种是给定输入,输出正确;另一种是给定输入,输出错误。训练神经网络所得到的参数

里面包含两种数据对:一种是给定输入,输出正确;另一种是给定输入,输出错误。训练神经网络所得到的参数

必须让神经网络既能够表达正确输出,也能够表达错误的输出。

必须让神经网络既能够表达正确输出,也能够表达错误的输出。

在数据集

在数据集

上训练后,能够得到条件概率

上训练后,能够得到条件概率

,但在测试集上模型也可能表现很差。另外,定义一种先验概率

,但在测试集上模型也可能表现很差。另外,定义一种先验概率

,可以让

,可以让

,这意味着如果泛化良好的函数与泛化不好的函数得到的分配概率是相同的。但这种先验是有问题的:由于

,这意味着如果泛化良好的函数与泛化不好的函数得到的分配概率是相同的。但这种先验是有问题的:由于

和

和

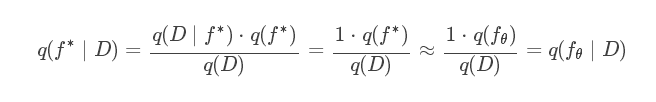

的数据的可能性为1,并且由于先验概率相似,这意味着后验概率也是相似的(如下公式)。

的数据的可能性为1,并且由于先验概率相似,这意味着后验概率也是相似的(如下公式)。

可以产生错误的输出,即

可以产生错误的输出,即

。

。

综上,Carles和Buckman认为在泛化不可知的先验条件下,无论数据集如何,都无法降低模型的不确定性。即贝叶斯神经网络起作用的关键因素是:先验能够区分泛化良好的函数和泛化不好的函数。

2、当前贝叶斯网络的泛化能力不可知

3、理性批判BNNs

二、反驳与批评:Twitter、Reddit双战场

这篇博客同步发在了推特和 Reddit 上,自然也就在两个平台上都引来了反驳的声音。

1、Twitter 战场:存在技术错误

在Twitter上,纽约大学数学和数据科学教授Andrew Gordon Wilson就表示他们的观点存在错误:

这篇博客中存在错误。

1,如果数据是来自我们想要拟合的分布的,那么随着我们使用的数据的规模增大,似然性会收缩到那个“好的函数”上,因为不好的函数会越来越少出现,这也和我们的观测值一致。

2,能拟合噪声的模型并没有什么出奇之处,而且也和“存在归纳偏倚,更倾向于选择有噪声的解”是两码事。在函数上简单增加一个标准的GP-RBF先验就可以支持噪声了,但它仍然更善于建模有结构的解。

3,对于通常会使用神经网络来解决的问题,好的解的数量通常都会比不好的解的数量更多。神经网络的结构中就含有帮助带来更好的泛化性的归纳偏倚。神经网络函数“与泛化性无关”的说法有点不负责任。

4,实际上,想要在函数空间创造许多不同的“泛化性无关”的先验是很简单的事,而它们的行为会和神经网络非常不同。它们可以由平凡的结构组成,而且也肯定不会具有任何泛化能力。

5,缺少理想的后验收缩会在这么几种情况下发生:

-

假想空间中并不包含好的解;

-

先验对某个

坏的解太过自信(比如给任意的 x 都分配同一个标签 p)。

但神经网络有很强的表达能力,这里的b情况根本就和“有模糊的权重先验”完全相反!

除了技术讨论之外,我建议两位可以多提问、多学习,以及对贝叶斯深度学习抱有开放的心态。也许是你们的“贝叶斯神经网络不合理”的先验太强了才觉得理解不了(微笑)。

Carles Gelada 对这份质疑的回应是:

如果情况是像你说的这样,那么证明这件事是贝叶斯支持的责任(而不是我们质疑者的),尤其是当他们声称模型可以提供好的不确定性的时候。实际上我们提出质疑的理由就是,每个初始值附近都同时有好的和坏的泛化函数,那么他们声称的东西也就值得怀疑了。

另外,关于“拟合损坏的样本”的讨论不应该和“拟合噪声”混为一谈。我们在讨论中假设了分类任务中不存在噪声,但即便是有噪声的分类任务,我们的观点也是成立的。

用简单的测试就可以说明目前使用的先验不是泛化无关的:训练一个好的函数、训练一个坏的函数,然后看看先验是否会给好的函数更高的概率。我怀疑状况不是这样的,但这里需要贝叶斯的支持者向我证明他们的先验是好的。

2、Reddit 回帖:水平不足+双重标准

Reddit上网友们的回应更激烈、更情绪性一些,甚至得到最多赞同意见的帖子就含有辛辣的批评和嘲讽。

adversary_argument:

由于博客作者们对贝叶斯推理中的真正的先验缺乏了解,所以我觉得这个讨论很没意思,甚至有一股双重标准的味道。全体深度学习研究人员(以及作者们自己)都已经接受了神经网络的大规模使用,即便我们还没有找到明确的泛化边界,也对神经网络的理论理解甚少。但是既然神经网络运行起来令人满意,这些问题就一股脑地被视而不见 —— 神经网络就是好的、正义的。

然而,现在作者们要求贝叶斯神经网络必须在先验方面提供很强的理论保证,虽然他们同时也承认贝叶斯神经网络是有效的…… emmm,你们觉得这像不像贼喊捉贼?做深度学习的人挺能散布负面言论的啊……

尤其是,我觉得他们的讨论方式,针对某个任意的、损坏的测试集 C 的讨论,只不过是在攻击他们自己造出来的一个靶子而已。我解释给你们看看:他们没有给出被损坏的数据的数量,但是他们就声称 f_theta 肯定在 D_test 上会有糟糕的表现?他们的依据是什么?那比如 D 是一百万个好的数据点组成的数据集,C 是 D 加上一个损坏的数据点,所以按照他们的理论,D_test 上的测试误差肯定会特别糟糕?

他们洋洋洒洒了一大堆,最后只证明了损坏训练数据会降低贝叶斯神经网络的测试准确率而已…… 呃…… 所以这有什么好奇怪的吗……

博客作者回应:

可能我们在博客里写得不够清楚。我们考虑含有损坏数据的数据集,不是为了说明只要有损坏数据就会有糟糕的预测表现(尤其对于一百万比一这种情况),而是想说明有损坏数据的、神经网络拟合之后会有糟糕的泛化表现的数据集是存在的。我们是为了说明存在性。如果先验对这样的网络分配很高的概率,那么贝叶斯推理就没有什么好处。

我们的博客也不是为了表达贝叶斯神经网络没用,而是想表示“如果没有好的先验,贝叶斯神经网络就无法带来好的不确定性估计”,“关于非信息性的先验的标准讨论方式是有问题的”,以及“想要有好的不确定性估计,我们需要先理解神经网络的泛化性”。

除此之外,其它多篇Reddit 的网友回帖也认为原博客两人的讨论态度有问题,立场很难称得上是“冷静看待”,有些简单的实验也完全可以自己先尝试。

重磅!CVer-学术交流群已成立

扫码可添加CVer助手,可申请加入CVer大群和细分方向群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索等群。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

![]()

▲长按加群

![]()

▲长按关注我们

麻烦给我一个在看!

登录查看更多