百度 ERNIE 在 GLUE 大赛中击败了微软和谷歌

受中英文差异的启发,ERNIE 的成功表明人工智能研究可以集百家之长。

以下为译文:

本月初,中国的一家科技巨头在一场持续的人工智能竞争中悄悄击败了微软和谷歌。该公司就是百度,其在中国的地位就相当于谷歌在北美。而这场比赛就是通用语言理解评估测试(General Language Understanding Evaluation,即GLUE)。

GLUE 是评价AI系统理解人类语言方面广泛认可的标准。该比赛由9个不同的测试组成,其中包括找出句子中的人名和组织,以及理解“it”等代词指代的是句子中的哪个。因此,如果在GLUE比赛中得分很高,则意味着该语言模型可以处理各种阅读理解任务。比赛满分为100分,平均得分约为87分。而如今百度的 ERNIE 成为了第一个超过90分的模型。

GLUE 的公开排行榜在持续不断地变化,也许很快就会出现另一支队伍超越百度。然而,百度的成功表明 AI 研究能够集百家之长。在构建 ERNIE 之际,百度的研究人员不得不研发一种专门的技术来处理中文。ERNIE(Enhanced Representation through kNowledge IntEgration)代表“知识增强的语义表示模型”。然而,很凑巧的是,这项技术也可以让模型更好地理解英语。

说起 ERNIE,它的灵感来源于 Google BERT。

BERT 问世于2018年末,在这之前的自然语言模型都不是很理想。这些模型擅长预测句子中的下一个单词(因此它们非常适合自动补齐等应用程序),但是它们无法理解整段话的含义,哪怕是很小一段。这是因为它们不理解句子的含义,例如它们无法理解“it”一词指代的是什么。

但是 BERT 改变了这一点。之前的模型在预测和理解单词的含义时,只能考虑单词之前或之后的上下文,却无法同时兼顾两者。换句话说,它们是单向的。

相比之下,BERT 能够同时考虑单词前后的上下文,所以是双向的。它使用一种名叫“覆盖”(masking)的技术来完成双向的操作。BERT 会在一段给定的文本段落中,随机覆盖15%的单词,然后尝试根据剩余的单词进行预测。由于它拥有双倍的线索,因此可以做出更准确的预测。举个例子,“他去__购买牛奶”,这个句子开头和结尾部分都能给出有关缺失词语的提示:__是一个你可以去的地方,也是一个可以买到牛奶的地方。

“覆盖”技术的出现是自然语言处理工作得到极大提升背后的核心创新之一,而且也是诸如 OpenAI GPT-2 等模型能够撰写出极具说服力的散文而又不偏离核心论题的原因之一。

当初百度的研究人员刚开始开发自家的语言模型时,他们希望以“覆盖”技术为基础构建模型。但是他们意识到他们需要对这项技术进行调整,才能处理中文。

在英语中,单词是语义单元,即便完全脱离上下文含义仍然不会丢失。但是,中文里的单个字并不能表达完整的含义。尽管某些字确实有含义,例如火、水或木等,但是大多数字只有与其他字组词之后才具有完整的含义。组词不同意思也不同,举个例子,“灵”这个字,在“机灵”中表示聪明,但在“神灵”中就指神仙了。而专有名词中的字一旦拆开来后,就完全不是一个意思了,比如“波士顿”,“美国”(其含义并不是“美丽的国家”)。

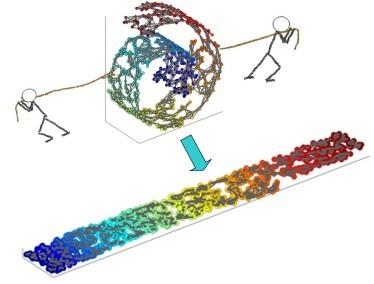

因此,百度的研究人员在训练 ERNIE 的时候,研发了新一版的“覆盖”技术,它可以覆盖词而不仅仅是一个字。他们还训练 ERNIE 区分有意义的词和随机的词,教会它相应地覆盖正确的词。结果,ERNIE 对于如何解读中文信息有了更深入的了解,而且在预测缺失的字和词方面也更加准确。事实证明,这对于翻译和检索文本文档的信息应用程序非常有帮助。

研究人员很快发现,实际上这种方法对于英文理解也很有好处。尽管没有中文那么频繁,但英语也具有类似的现象,即一组单词表示的意思与每个单词单独的含义不同。比如“Harry Potter”(哈利·波特)之类的专有名词,以及短语“chip off the old block” (孩子酷似双亲,字面意思为“切去旧块”),你不能通过拆分解析这些短语的含义。

对于如下这句话:

Harry Potter is a series of fantasy novels written by J. K. Rowling.(哈利·波特是J·K·罗琳所著的一系列魔幻小说。)

BERT 的覆盖方式为:

__ Potter is a series __ fantasy novels __ by J. __ Rowling.

但是 ERNIE 的覆盖方式为:

Harry Potter is __ __ __ fantasy novels by __ __ __.

可见,ERNIE 能够根据含义来学习更可靠的预测,而不仅仅是统计单词的使用模式。

最新版的 ERNIE 还使用了其他几种训练技巧。它考虑了句子的顺序及句子之间的距离,例如了解段落合理的进展。但是,最重要的是,它通过一种名叫连续训练的方法,在新数据集上针对新任务开展训练,同时还不会忘记以前学习的内容。这样一来,随着时间的推移,这个模型就可以越来越好地执行越来越多的任务,而人类的干预也会降到最低。

百度积极地使用 ERNIE 来为用户提供更多有效的搜索结果,删除新闻源中的重复报道,并提高其AI助手小度准确响应请求的能力。百度还在一篇论文中描述了 ERNIE 的最新架构,该论文将在明年人工智能发展协会大会上发表。百度的研究人员曾经借鉴了 Google BERT,所以如今他们希望其他团队也能从 ERNIE 中受益。

百度研究的首席架构师Hao Tian说:“在刚着手这项工作的时候,我们首先考虑了中文的某些特征,但是很快我们就发现它的应用不仅限于中文。”

原文:https://www.technologyreview.com/s/614996/ai-baidu-ernie-google-bert-natural-language-glue/

本文为 CSDN 翻译,转载请注明来源出处。

热 文 推 荐

☞在以太坊上开发 Dapp 的瓶颈和门槛有哪些?| 博文精选