微软机器阅读理解超越人类水平,CoQA数据集得分刷新记录

选自 microsoft

机器之心编译

机器之心编辑部

今日,微软博客发文公布他们在 CoQA 数据集上取得的最新成绩。在此次挑战赛中,微软亚洲研究院 NLP 组与 SDRG(微软雷德蒙德语音对话研究组)组成的团队成为首个模型表现超越人类的参赛团队。

图源:https://stanfordnlp.github.io/coqa/

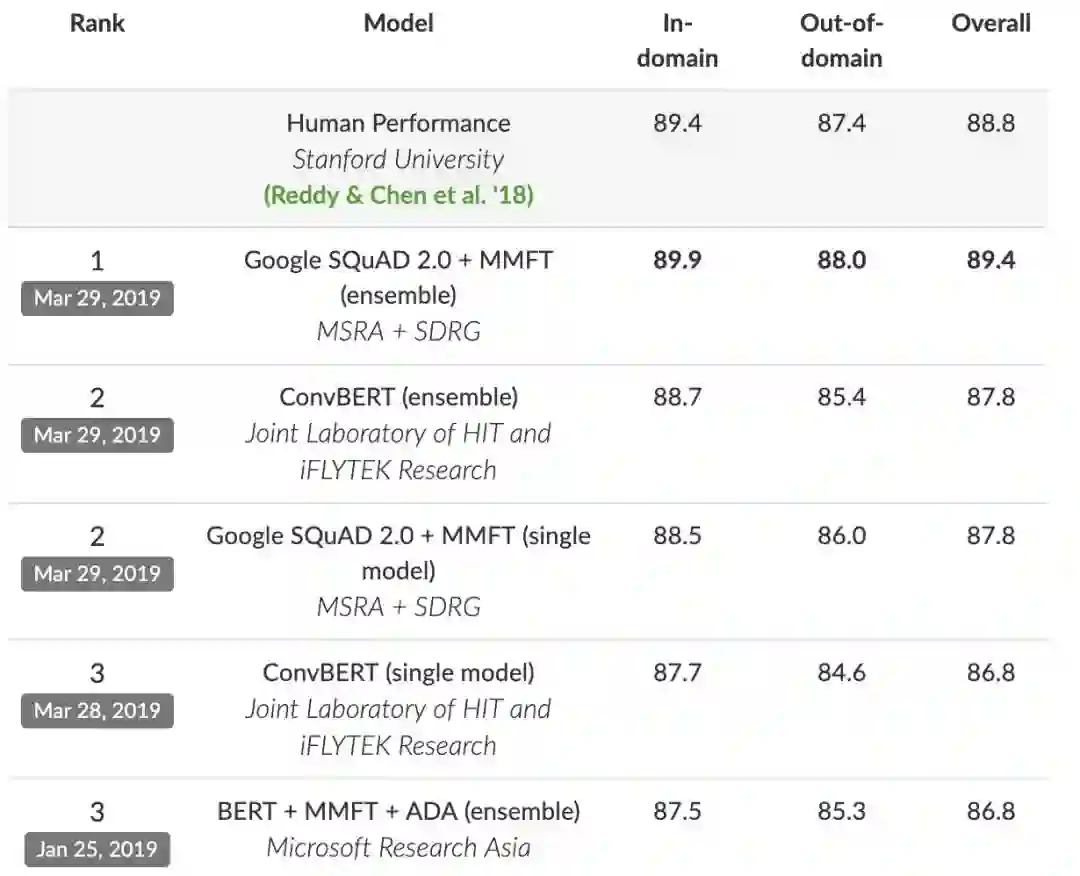

在斯坦福大学举办的 CoQA(Conversational Question Answering)挑战赛中,由微软亚洲研究院(MSRA)NLP 组和微软雷德蒙德语音对话研究组组成的团队排名第一。

此挑战赛衡量了机器理解文本、在对话中回答一系列相互联系的问题的能力。

CoQA 是一个大型对话问答数据集,由来自不同领域一系列文章中的对话问题组成。在此之前,MSRA NLP 团队利用斯坦福问答数据集(SQuAD)在单轮问答中达到了人类水平,树立了一个新的里程碑。与 SQuAD 相比,CoQA 中的问题对话性质更为明显,答案形式自由,以确保对话中的答案更加自然。

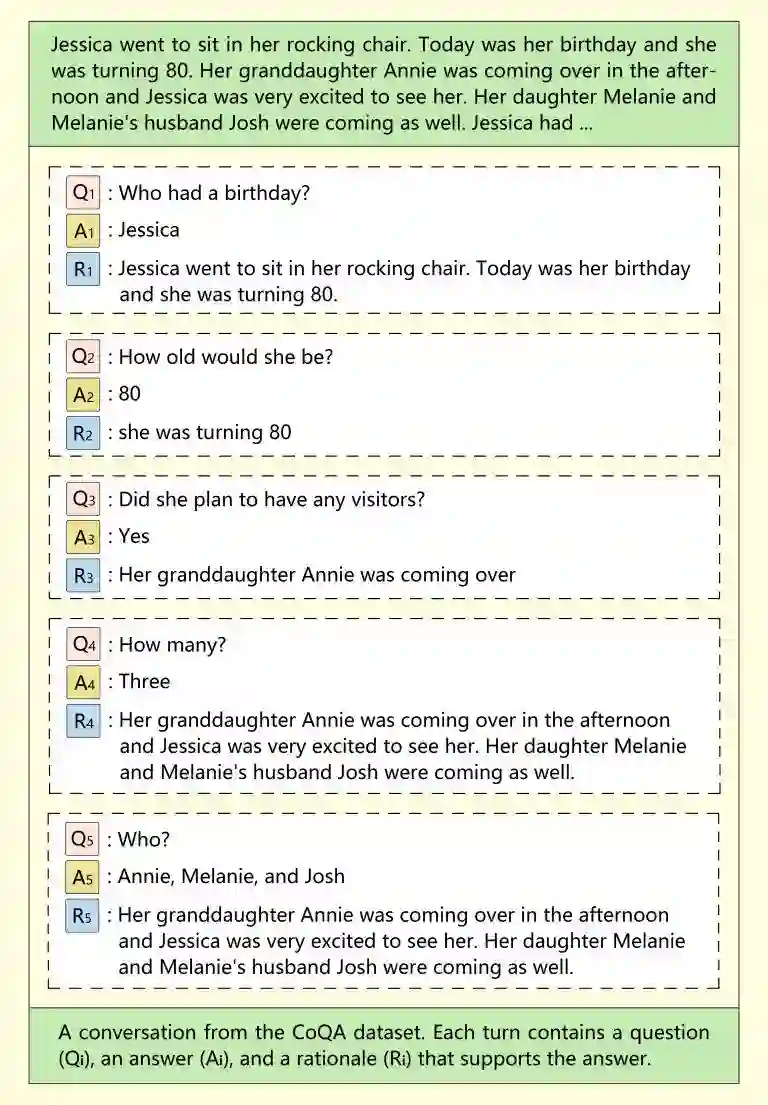

CoQA 中的问题非常简短,以模仿人类对话。除此之外,第一个问题之后的每一个问题都基于对话历史,这加大了机器解析那些短问题的难度。

例如,假设你问系统,「微软的创始人是谁?」,那么在问下一个问题(「他的生日是什么时候?」)的时候,你需要让机器知道,这两个问题中的对象是同一个人。

图注:来自 CoQA 数据集的一段对话,来自论文《CoQA: A Conversational Question Answering Challenge》

为了更好地测试已有模型的泛化能力,CoQA 数据集从 7 个不同领域收集数据:童话故事、文学作品、初中高中英语测试、新闻、Wikipedia、Reddit 和科学。前五个领域的数据用作训练、开发和测试集,后面两个只用作测试集。

CoQA 使用 F1 得分来评估模型表现。F1 得分衡量了预测与真实答案之间的单词重合度。领域内 F1 得分是在与训练集为同一领域的测试集上测试得到的,领域外 F1 得分是在不同领域的测试集上得到的。整体 F1 是在所有测试集上的最终得分。

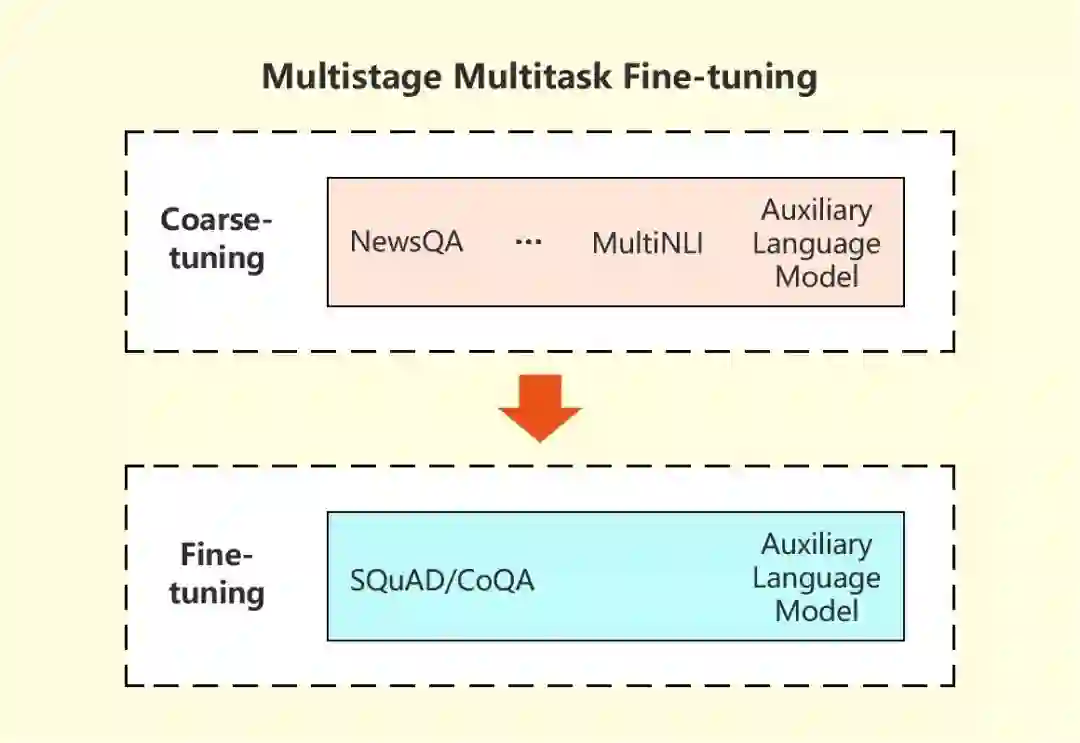

据介绍,微软研究团队的方法使用了特殊的策略,也就是多个相关任务学习到的信息被用于改进最终的机器阅读理解任务。在此多阶段、多任务精调方法中,研究人员首先在多任务环境下从相关任务中学习 MRC 关联背景信息,然后在目标任务上精调模型。在两个阶段,都使用语言建模作为辅助任务,帮助降低对话问答模型的过拟合。

实验证明了这种方法的有效性,在 CoQA 挑战赛上的结果也进一步证明了该方法的强大之处。

图注:多阶段、多任务精调模型图示

据 CoQA 榜单显示,微软研究团队提交的集成系统分布取得了 89.9 的领域内得分、88.0 的领域外得分、89.4 的整体 F1 得分,而在此数据集上人类的表现分别为 89.4/87.4/88.8。

这一成就标志着搜索引擎(如必应)和智能助手(如 Cortana)在与人互动和以更自然的方式(类似人与人之间的交流)提供信息方面取得了重大进展。然而,一般的机器阅读理解和问答仍是自然语言处理中没能解决的难题。为了进一步提高机器理解和生成自然语言的能力,该团队将继续努力开发更强大的预训练模型。

原文链接:https://www.microsoft.com/en-us/research/blog/machine-reading-systems-are-becoming-more-conversational/

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com