![]()

©PaperWeekly 原创 · 作者|苏剑林

单位|追一科技

研究方向|NLP、神经网络

L2 正则是机器学习常用的一种防止过拟合的方法(应该也是一道经常遇到的面试题)。简单来说,它就是希望权重的模长尽可能小一点,从而能抵御的扰动多一点,最终提高模型的泛化性能。但是读者可能也会发现,L2 正则的表现通常没有理论上说的那么好,很多时候加了可能还有负作用。

最近的一篇文章 Improve Generalization and Robustness of Neural Networks via Weight Scale Shifting Invariant Regularizations 从“权重尺度偏移”这个角度分析了 L2 正则的弊端,并提出了新的 WEISSI 正则项。整个分析过程颇有意思,在这里与大家分享一下。

论文标题:Improve Generalization and Robustness of Neural Networks via Weight Scale Shifting Invariant Regularizations

论文链接:https://arxiv.org/abs/2008.02965

![]()

这一节中我们先简单回顾一下 L2 正则,然后介绍它与权重衰减的联系以及与之相关的 AdamW 优化器

[1]

。

为什么要添加 L2 正则?这个问题可能有多个答案。有从 Ridge 回归角度回答的,有从贝叶斯推断角度回答的,这里给出从扰动敏感性的角度的理解。

对于两个(列)向量

,我们有柯西不等式

。根据这个结果,我们就可以证明:

![]()

这里的

等于矩阵

的所有元素的平方和。证明并不困难,有兴趣的读者自行完成。

这个结果告诉我们:

的变化量,可以被

和

控制住,因此如果我们希望

很小时

的变化量也尽可能小,那么我们可以降低

,这时候就可以加入正则项

。

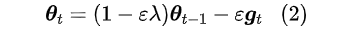

在使用 SGD 进行优化时,假设原来的迭代为

,那么不难证明加入 L2 正则

后变成了:

![]()

由于

,所以这会使得整个优化过程中参数

有“收缩”到 0 的倾向,这样的改动称为“权重衰减(Weight Decay)”。

不过,L2 正则与权重衰减的等价性仅仅是在 SGD 优化器下成立,如果用了自适应学习率优化器如 Adagrad、Adam 等,那么两者不等价。在自适应学习率优化器中,L2 正则的作用约等于往优化过程里边加入

而不是

。

也就是说每个元素的惩罚都很均匀,而不是绝对值更大的元素惩罚更大,这部分抵消了 L2 正则的作用。论文 Decoupled Weight Decay Regularization

[1]

首次强调了这个问题,并且提出了改进的 AdamW 优化器。

![]()

新的正则

在这一节中,我们将指出常见的深度学习模型中往往存在“权重尺度偏移(Weight Scale Shif)”现象,这个现象可能会导致了 L2 正则的作用没那么明显。进一步地,我们可以构建一个新的正则项,它具有跟 L2 类似的作用,但是与权重尺度偏移现象更加协调,理论上来说会更加有效。

2.1 权重尺度偏移

我们知道深度学习模型的基本结构就是“线性变换+非线性激活函数”,而现在最常用的激活函数之一是

。有意思的是,这两者都满足“正齐次性”,也就是对于

,我们有

恒成立。

对于其他的激活函数如 SoftPlus、GELU、Swish 等,其实它们都是

的光滑近似,因此可以认为它们是近似满足“正齐次性”。

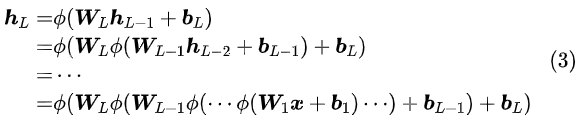

“正齐次性”使得深度学习模型对于权重尺度偏移具有一定的不变性。具体来说,假设一个L层的模型:

![]()

如果

,那么参数为

就跟参数为

的模型完全等价了。

换句话说,模型对于

的权重尺度偏移具有不变性(WEIght-Scale-Shift-Invariance,WEISSI)。

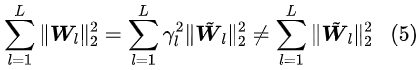

2.2 与L2正则不协调

刚才我们说只要尺度偏移满足

,那么两组参数对应的模型就等价了,但问题是它们对应的 L2 正则却不等价:

![]()

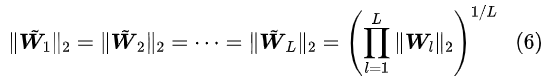

并且可以证明,如果固定

,并且保持约束

,那么

的最小值在:

![]()

事实上,这就体现了 L2 正则的低效性。试想一下,假如我们已经训练得到一组参数

,这组参数泛化性能可能不大好,于是我们希望 L2 正则能帮助优化器找到一组更好参数(牺牲一点

,降低一点

)。

但是,上述结果告诉我们,由于权重尺度偏移不变性的存在,模型完全可以找到一组新的参数

,它跟原来参数的模型完全等价(没有提升泛化性能),但是 L2 正则还更小(L2 正则起作用了)。说白了,就是 L2 正则确实起作用了,但没有提升模型泛化性能,没有达到使用 L2 正则的初衷。

2.3 WEISSI正则

上述问题的根源在于,模型对权重尺度偏移具有不变性,但是 L2 正则对权重尺度偏移没有不变性。如果我们能找到一个新的正则项,它有类似的作用,同时还对权重尺度偏移不变,那么就能解决这个问题了。个人感觉原论文对这部分的讲解并不够清晰,下面的推导以笔者的个人理解为主。

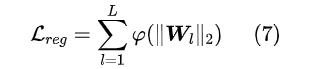

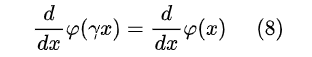

对于 L2 正则来说,

,只要

是关于 x 在

上的单调递增函数,那么就能保证优化但目标是缩小。要注意我们希望正则项具有尺度偏移不变性,并不需要

,而只需要:

![]()

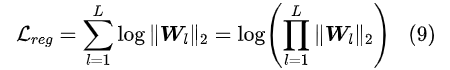

因为优化过程只需要用到它的梯度。可能有的读者都能直接看出它的一个解了,其实就是对数函数

。所以新提出来的正则项就是:

![]()

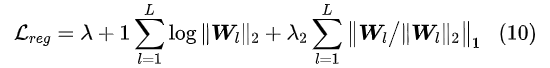

除此之外,原论文可能担心上述正则项惩罚力度还不够,还对参数方向加了个 L1 的惩罚,总的形式为:

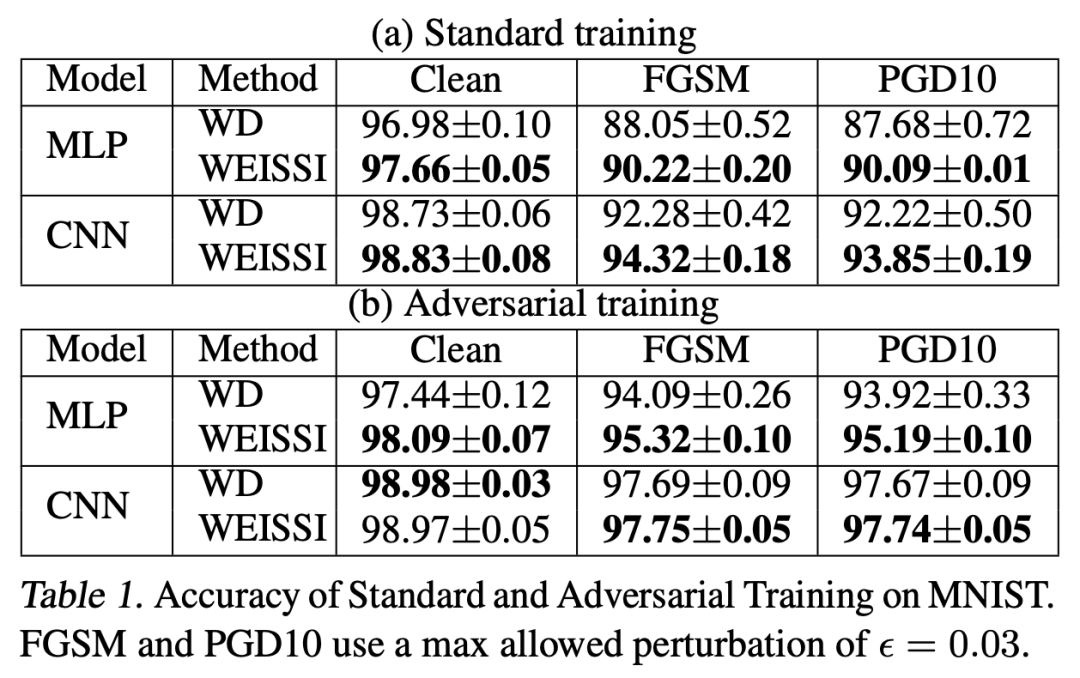

2.4 实验效果简述

按惯例展示一下原论文的是实验结果,当然既然作者都整理成文了,显然说明是有正面结果的:

![]() 对于我们来说,无非就是知道有这么个新的选择,炼丹的时候多一种尝试罢了。毕竟正则项这种东西,没有什么理论能保证它一定能起作用,还是用了才能知道结果,别人说得再漂亮也没用。

对于我们来说,无非就是知道有这么个新的选择,炼丹的时候多一种尝试罢了。毕竟正则项这种东西,没有什么理论能保证它一定能起作用,还是用了才能知道结果,别人说得再漂亮也没用。

![]()

文章小结

本文介绍了神经网络模型中的权重尺度偏移不变性的现象,并指出它与 L2 正则的不协调性,继而提出了作用类似但能够解决不协调性的正则项。

[1] https://arxiv.org/abs/1711.05101

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

![]()

![]()