论文题目

一致收敛可能无法解释深度学习中的泛化现象,Uniform convergence may be unable to explain generalization in deep learning

论文摘要

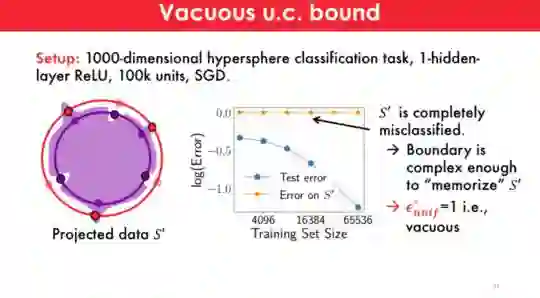

我们对基于一致收敛的泛化界的能力表示怀疑,以提供一个完整的图像,说明为什么过度参数化的深网络泛化良好。虽然众所周知,许多现有的边界是数值大的,通过各种实验,我们首先揭示了这些界限的另一个关键和更关注的方面:在实践中,这些界限可以{EM增加与数据集的大小。在我们的观察结果的指导下,我们给出了随机梯度下降(SGD)训练的超参数线性分类器和神经网络的例子,在这些例子中,即使我们尽可能充分地考虑隐式正则化{\em},一致收敛也无法“解释泛化”。更准确地说,即使我们只考虑SGD输出的一组测试误差小于某个小ϵ的分类器,对这组分类器应用(双边)一致收敛也会得到一个大于1ϵ的泛化保证,因此几乎是空的

论文亮点

本文提出了一个反对使用基于一致收敛的泛化界来解释超参数深网络泛化良好的理由。它们是通过破坏最紧的(算法,分布相关的)一致收敛界来实现的。

论文结构

- 作者首先回顾了基于标准一致收敛的边界是如何工作的

- 经典的基于一致收敛的方法通过测试误差来约束测试误差<=训练误差+O(某些复杂项)/SRT(训练集大小),由于过度的超调,在过参数化设置中失败。

- 在现代方法中,我们试图找到在实际数据上训练时隐式正则化的权值,然后对它们(更简单的,范数有界的函数类)应用一致收敛来产生更好的界

论文作者

Vaishnavh Nagarajan, J. Zico Kolte。

成为VIP会员查看完整内容

相关内容

专知会员服务

32+阅读 · 2020年2月1日

专知会员服务

148+阅读 · 2019年12月28日