虚拟对抗训练:一种新颖的半监督学习正则化方法

本文介绍一种名叫Virtual Adversarial Training (VAT) [1]的方法,是一种对于给定条件标签分布 的数据度量该分布局部光滑性的一种方法。其实就是对于每一个数据点,它的条件标签分布对于局部的扰动鲁棒性怎么样,是否数据的一点小变化,就会导致预测的其标签的大变化。这种情况在研究对抗样本的时候很常见,比如本来一张猫的图片,稍微加了一点扰动,神经网络就将其判为梨这种完全不一样的类别,这显然不是我们想要的。

一

动机

为什么会想到用光滑性smooth来做正则化呢?正则化从贝叶斯的角度来看,是加了先验信息到模型里面。而自然界的很多物理系统,都是可以用基于微分方程光滑模型描述。所以作者就想到了把条件标签概率约束成光滑的,在输入

优点:VAT在对抗训练的时候,不需要标签信息,所以可以应用于无监督学习。此外,VAT的计算代价也是很低的。

与Goodfellow提出的监督学习对抗方法adversarial training[2]不同的是,VAT找的方向是能使预测的输出分布偏离现状的方向,而adversarial training找的是使模型预测最大地偏离正确label的方向。我们可以称目前模型预测的label是虚拟label(virtual),那么该方法不需要真实的label存在,可以用于无label的无监督学习。

二

方法

一些符号定义

对抗训练

要讲VAT,首先要从Goodfellow的adversarial training开始,其损失函数为:

其中,

或者:

对于神经网络来说,

虚拟对抗训练:VAT

那么如果训练样本没有标签,或者有一部分数据没有标签怎么办呢?VAT就是要解决这样一个问题。

我们把

之前的

于是,给整个目标函数加上LDS:

其中,

整个正则化过程,只有两个超参数

具体计算

注意到之前算

如果一阶导数为0,则

其中,

那么计算

其中

为了计算特征向量,作者使用一种能量迭代方法[3],令

那么就可以计算:

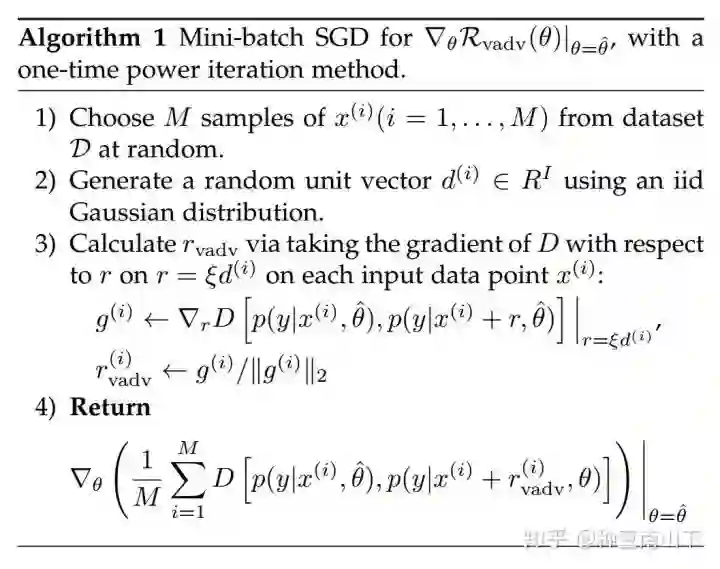

原文算法描述如下:

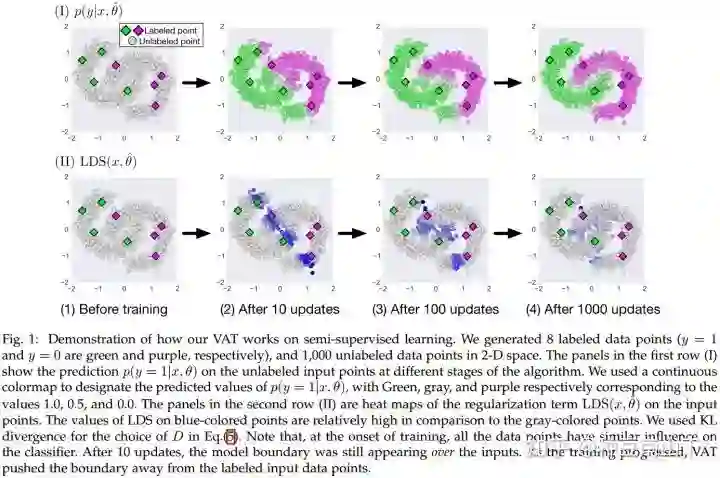

作者对算例描述:

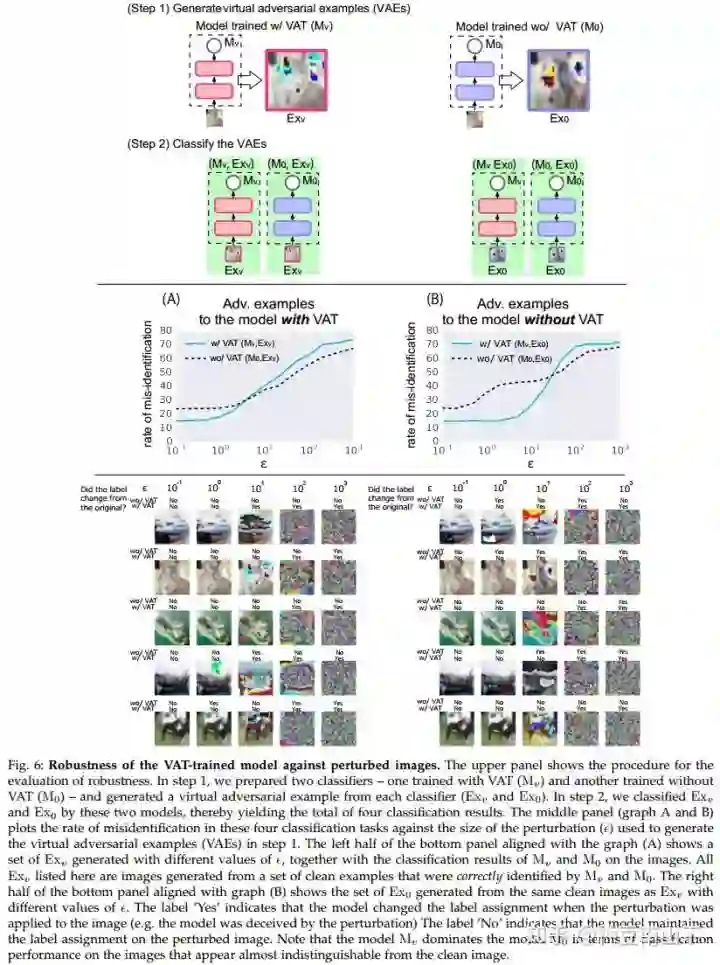

实验部分:

参考文献:

[1]. Takeru Miyato, Andrew M Dai, and Ian Goodfellow. Virtual adversarial training for semi-supervised text classification. stat, 1050:25, 2016.

[2]. Ian Goodfellow, Jonathon Shlens, and Christian Szegedy. Explaining and harnessing adversarial examples. In ICLR, 2015.

[3]. Gene H Golub and Henk A van der Vorst. Eigenvalue computation in the 20th century. Journal of Computational and Applied Mathematics, 123(1):35–65, 2000.

-----END-----

作者 | 种豆南山下(https://www.zhihu.com/people/kai-75-94-98)

版权声明

本文版权归《种豆南山下》,转载请自行联系

点击文末阅读原文 或 扫描上方二维码报名

历史文章推荐

AI综述专栏 | 多模态机器学习综述

深度学习中不得不学的Graph Embedding方法

旷视研究院新出8000点人脸关键点,堪比电影级表情捕捉

何恺明团队最新研究:3D目标检测新框架VoteNet,直接处理点云数据,刷新最高精度

打开阿兹海默之门:华裔张复伦利用RNN成功解码脑电波,合成语音 | Nature

图嵌入(Graph embedding)综述

半天2k赞火爆推特!李飞飞高徒发布33条神经网络训练秘技

再也不用担心我的公式写不出来了:一款公式输入神器实测

【深度学习】一文看尽深度学习各领域最新突破

2019 年 12 个深度学习最佳书籍清单!值得收藏

你正在看吗?👇