ICML 2022 | 图神经网络的局部增强

©作者 | 刘祖龙

单位 | 南京邮电大学

来源 | MIND Laboratory

论文标题:

Local Augmentation for Graph Neural Networks

论文链接:

代码链接:

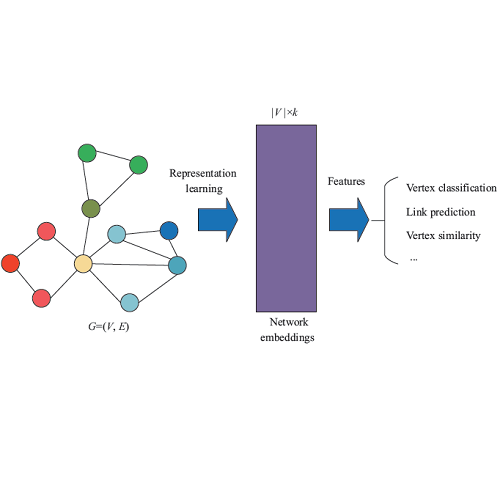

本文方法

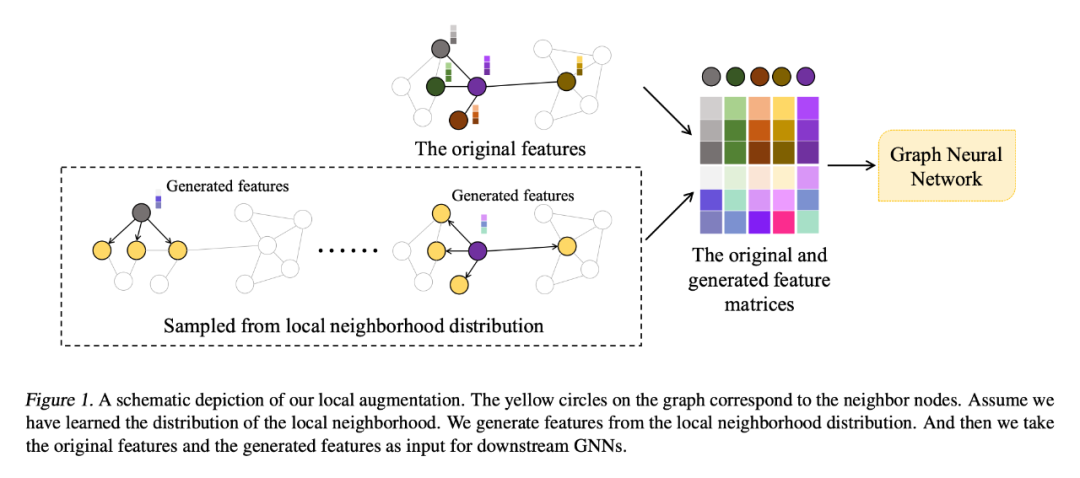

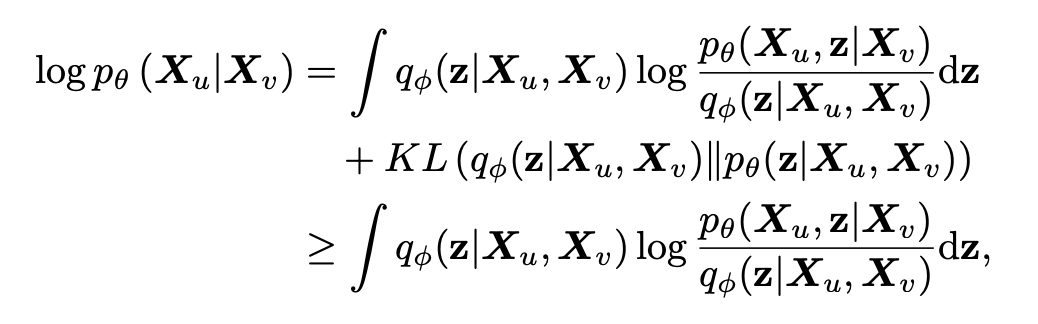

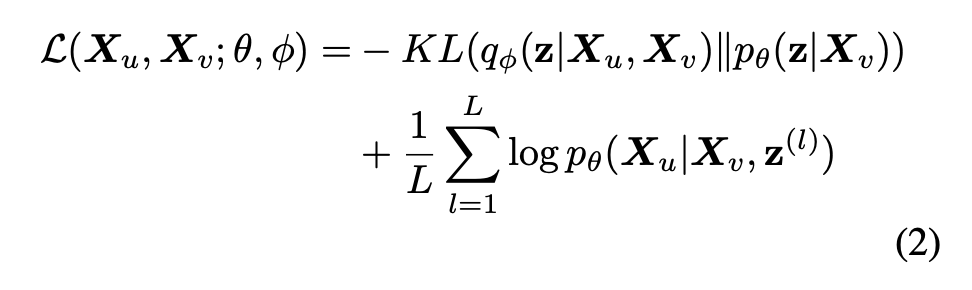

1.1 局部增强

优点:与针对每个节点训练生成模型相比,针对所有节点训练单一的生成模型有三个好处:1)通过生成模型学习图上所有节点的条件分布,降低了计算成本;2)在生成阶段,可以应用特定节点的特征向量作为输入(条件),生成与该节点相关的特征向量;3)具有较好的可扩展性和泛化性。对于添加到动态图中的新节点,可以直接生成特征向量,而不需要重新训练新的生成模型。

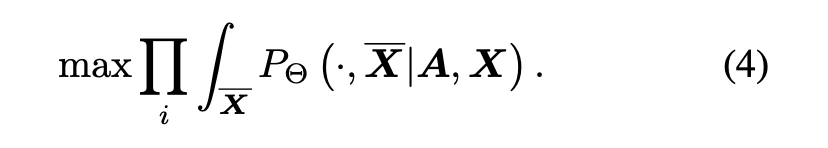

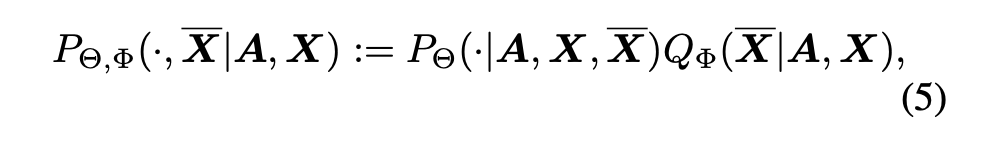

1.2 为下游任务解耦生成模型

1.3 架构

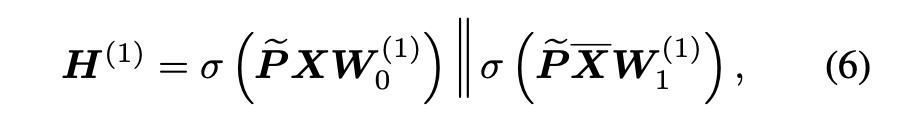

LAGCN:对于 GCN,本文只在第一层图卷积层上做了小的更改:

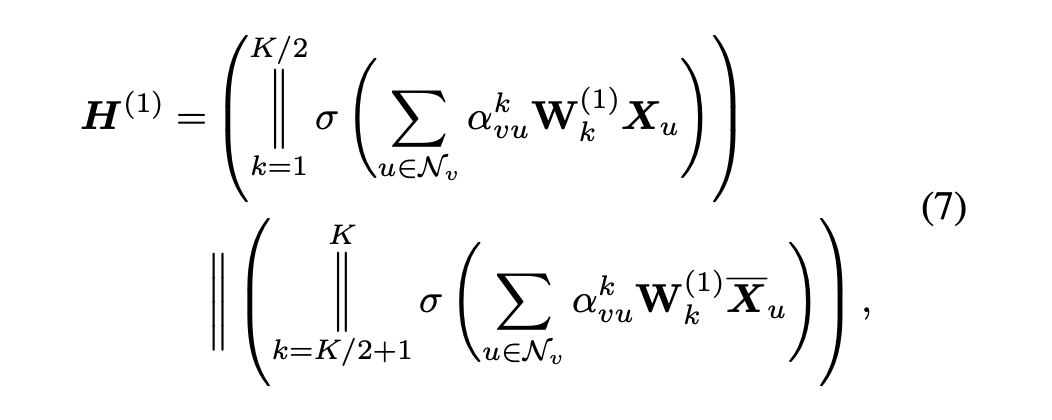

LAGAT:类似地,LAGAT 的第一层可表示为:

1.4 损失函数

1.4.1 监督损失

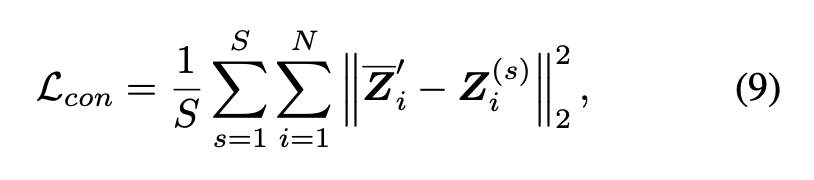

一致性正则化损失表示为:

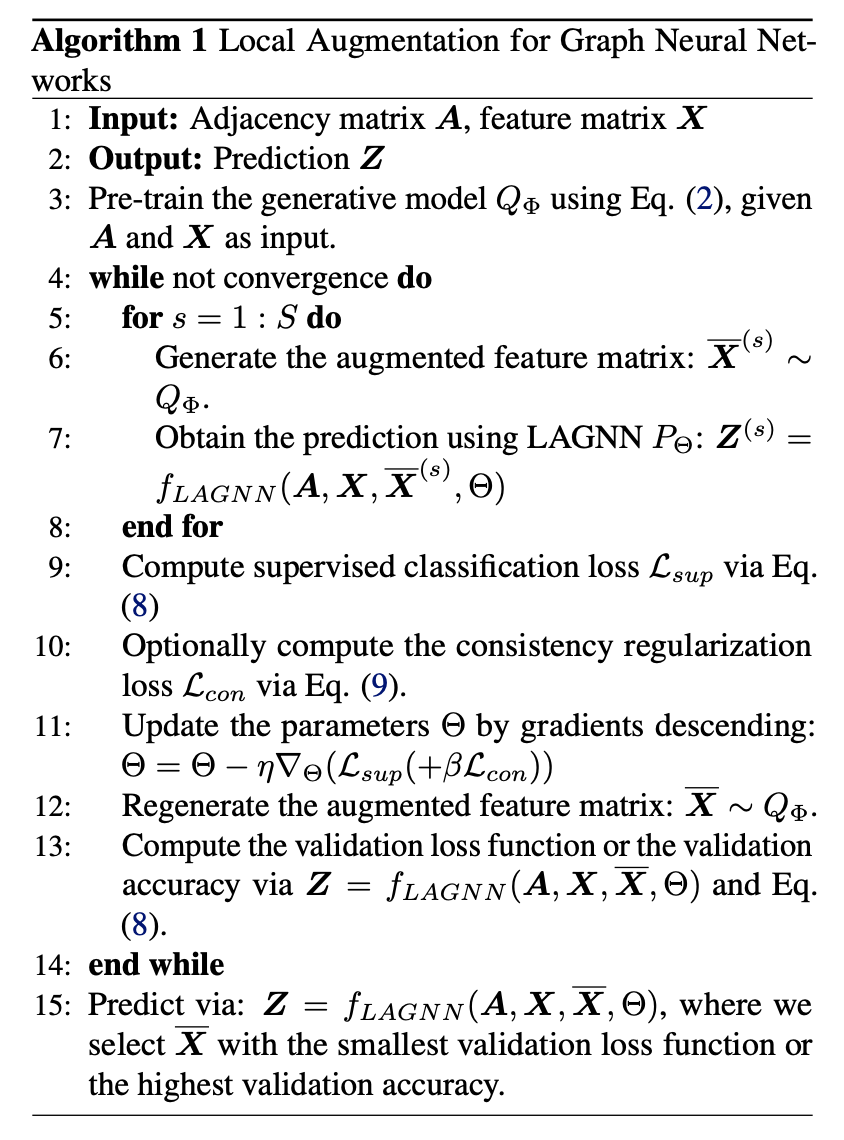

本文模型的算法框架如算法 1 所示:

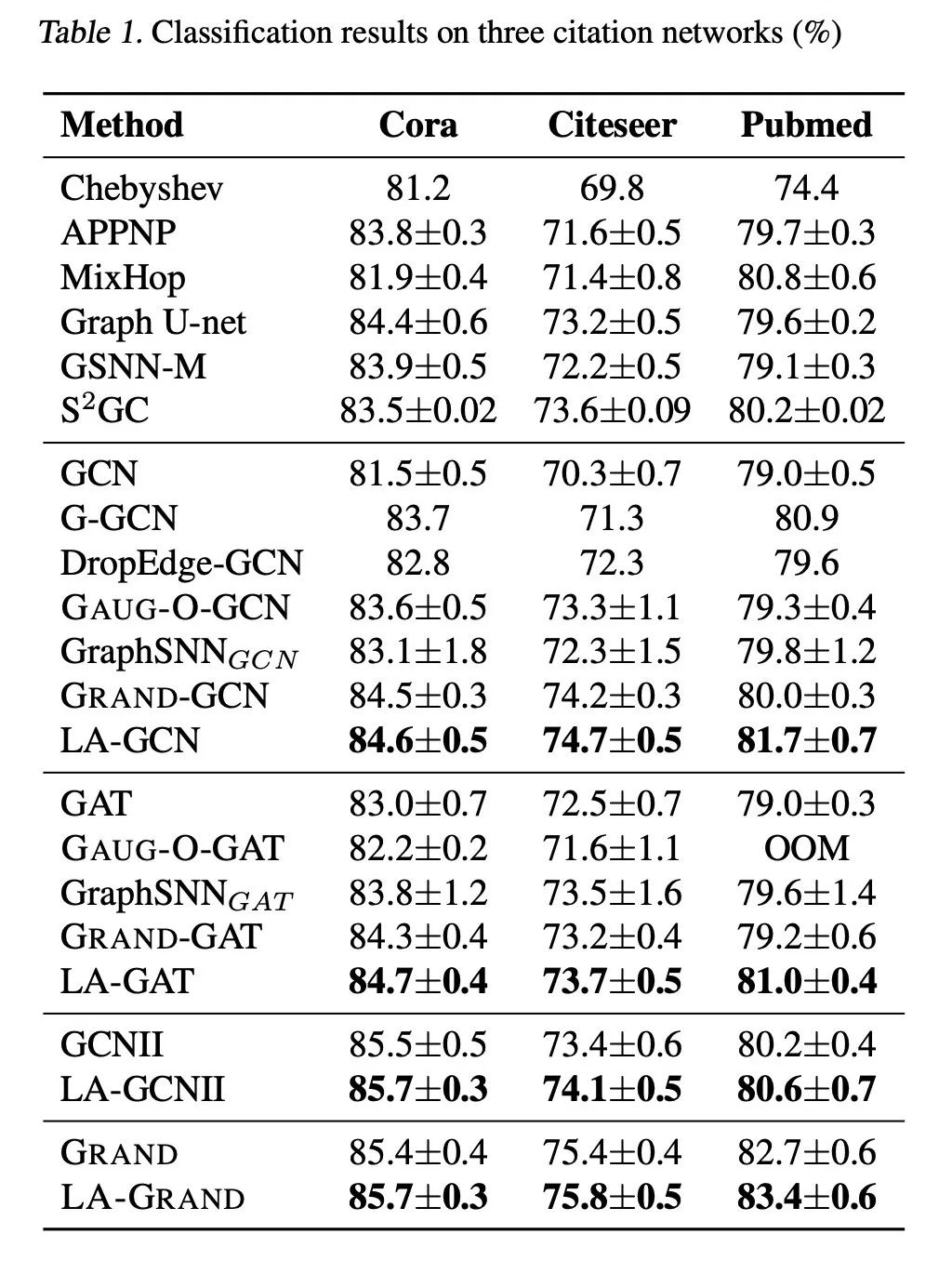

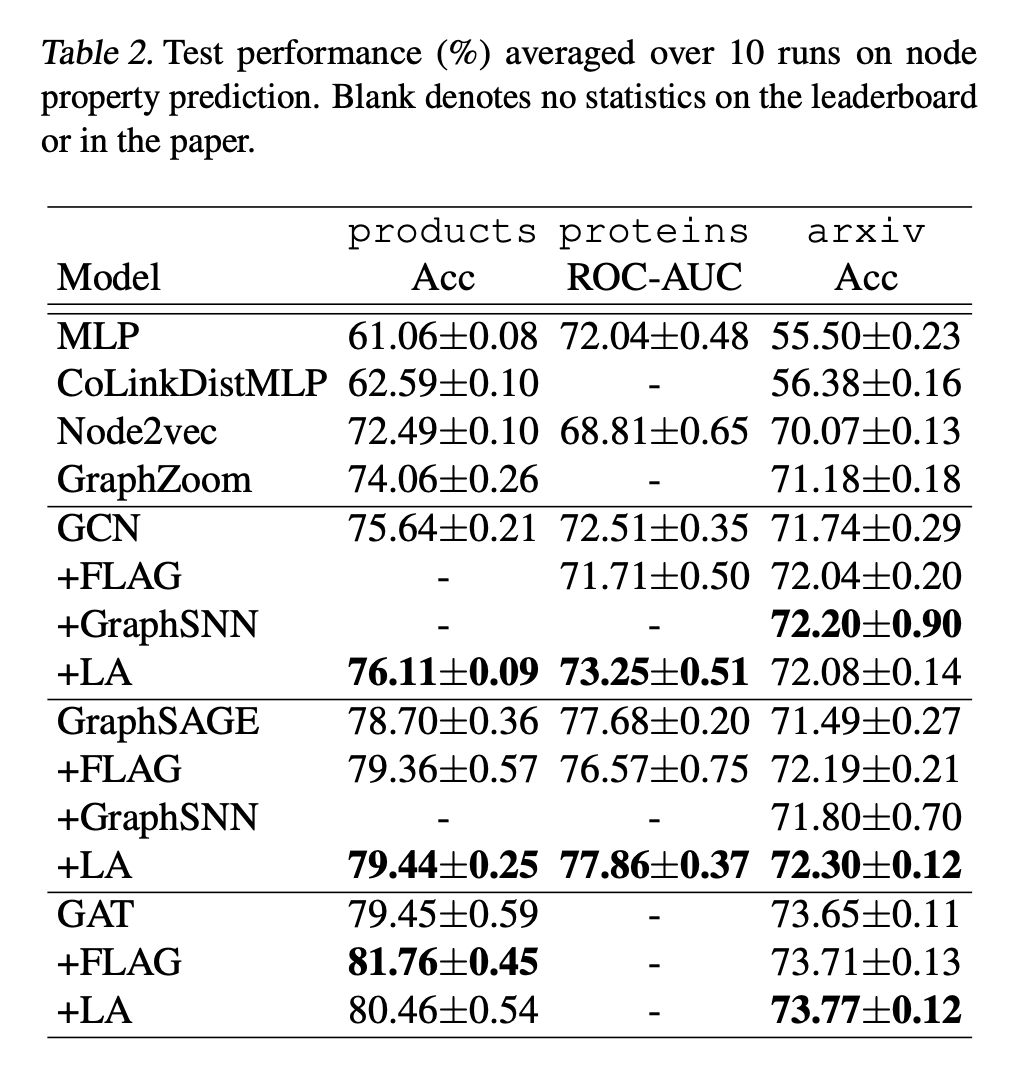

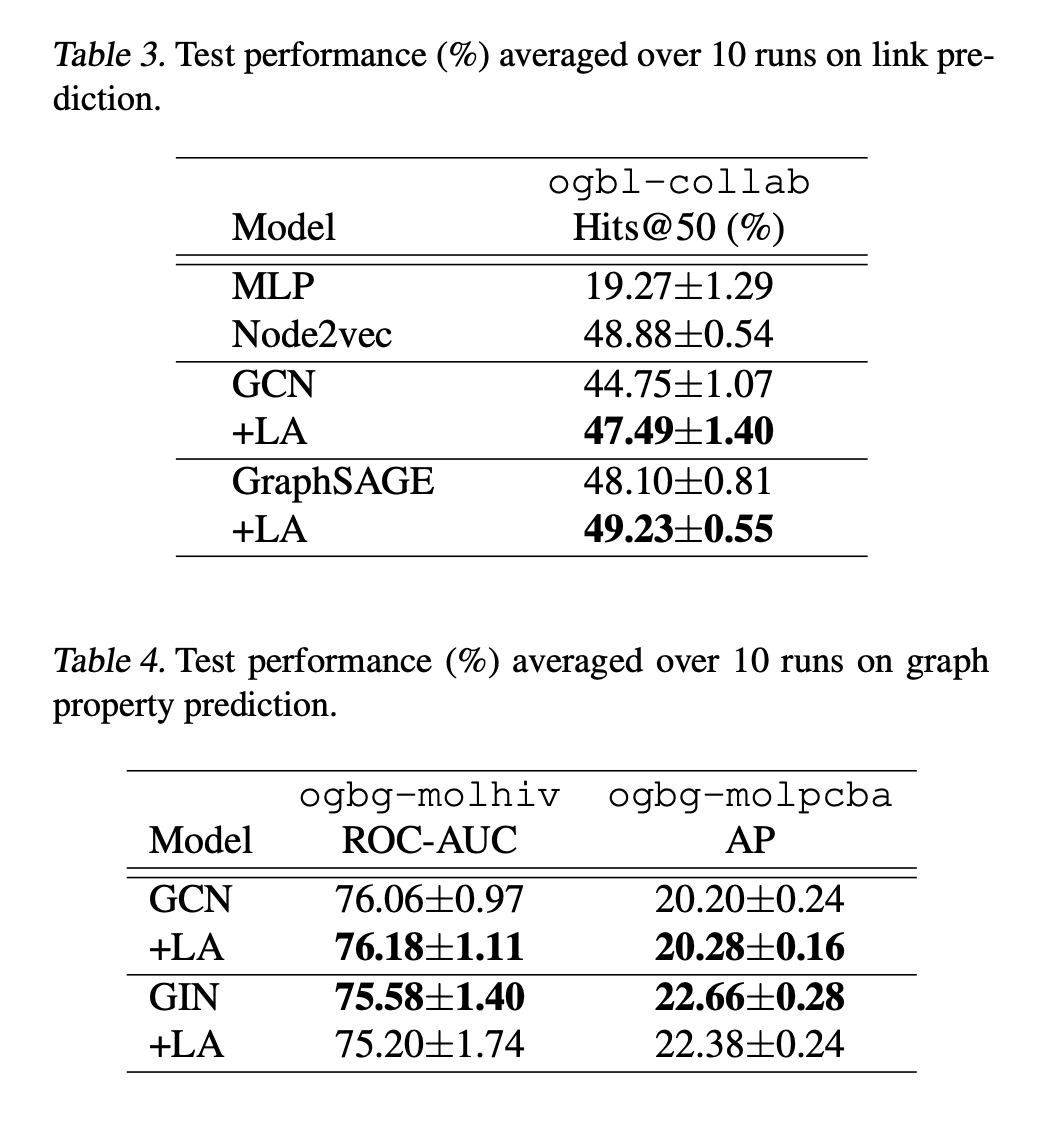

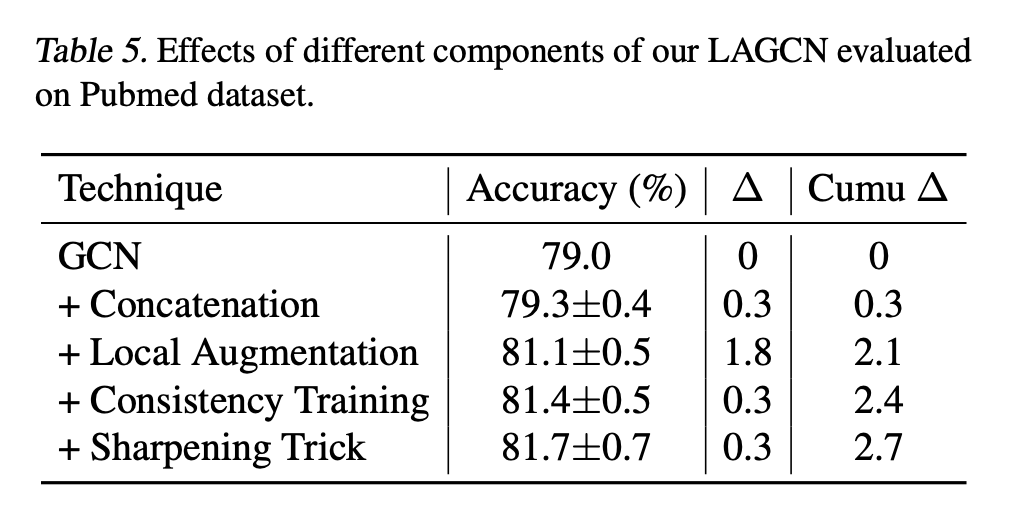

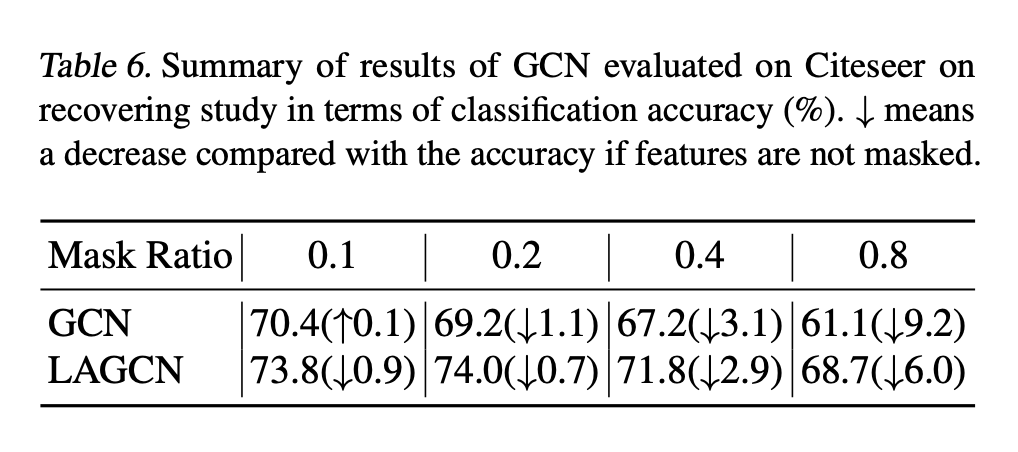

实验

总结

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧