推荐!【博士论文】《自主武器与稳定性》377页伦敦大学国王学院

概述和主要研究问题

简介

决策

比人类更好?

辩论

主题概述

-

“自主武器是否对稳定构成挑战,如果是的话,各国可以采取哪些可行的风险缓解措施?”

-

在非军事环境中涉及复杂的自动化或自主系统的事故,包括F-22国际日期线事件和法航447坠机事件。 -

在股票交易的竞争、高速对抗环境中涉及自动化的事故,包括2010年5月6日的闪电崩盘的原因和随后的风险缓解措施。 -

2003年爱国者自相残杀事件,在伊拉克战争的最初阶段,高度自动化的美国爱国者防空系统击落了两架友好飞机。 -

宙斯盾作战系统的性能,这是一个由美国海军操作的舰载防御性人类监督的自主武器系统。 -

当今最先进的机器学习系统的行为。

背景和现有文献

什么是自主武器?

为什么军队会想要自主武器?

自主武器的法律和伦理问题已被广泛探讨

安全和可控性

自主武器与稳定

-

[使用自主武器的]国家将在危机方程中引入一个他们无法直接控制的因素,但它仍然与人类对手的战略心理相互作用。实际上,在自主系统作战期间管理其行为的人工智能(AI)将成为参与危机的另一个行为者,尽管它受到一套算法和任务目标的严格限制。

-

显然,可召回性和失去控制是主要关切。虽然像X-47B UCAS[无人驾驶作战系统]这样的攻击系统最初可以在人类的密切监督下使用,但很难看出它们如何能在那些迄今为止提供最大附加值的情况下实现其全部潜力:情报、监视和侦察(ISR)以及深入防卫森严的领土内的攻击任务,在那里通信可能会被削弱,而让人类不断保持联系所产生的电子辐射可能是一个致命陷阱。

-

在防卫区内的这些时间里,[自主武器]可能无法完全召回或重新编程,即使政治局势发生变化,这带来了不受欢迎的升级风险,并可能破坏政治举措。

-

这可能包括,除其他外,将重要的资产转移到繁忙的城市环境或不允许的目标旁边,如水电大坝或核电站;改变武器和设施的外观以模拟非法目标,甚至可能改变非法目标以模拟合法目标;大规模使用假人和遮蔽物,以及全套电子欺骗措施。

-

如果人工智能误判了其人类委托人的意图,就有可能发生灾难性的和无端的暴力。......一个为满足预先指定的声誉和信誉标准而升级的人工智能可能无法及时反思其行动的后果,从而允许改变方向。

-

[各国应参与国际对话,明确界定自主武器的正确用途,商定核查各国是否正确使用这些武器的方法,并指定违规者的后果。

-

[Borrie认为:[自主武器]有一个安全层面,与我们对自主目标或攻击的伦理或合法性的看法无关。我的看法是,可能无法有效地控制或预测自主武器系统即使在最初的简单故障中会发生什么。这并不是因为故意滥用,也不是因为 "机器人正在接管",而只是因为很难像防止复杂、紧密耦合的系统出现灾难性故障那样,迅速诊断并有效地应对故障。

-

在这种情况下,系统故障--由故障、与环境的意外互动或网络攻击引起--会引发战场上大规模自相残杀的可怕前景。与2010年的闪电事故类似,从理论上讲,一大批自主系统发生故障可能会迅速失去控制。在最坏的情况下,其结果可能是自相残杀、平民伤亡或危机的意外升级--甚至可能是一场 "闪电战"。

-

竞争环境中的自然趋势是走向更高的速度,需要更多的自动化,进一步加快战斗的步伐。其结果可能是一个不稳定的局面。自主系统之间的意外互动或黑客攻击可能导致 "闪电战",在这种情况下,冲突会迅速脱离人类控制。

-

改变系统被用户使用的方式--尽可能找到减少人工智能的耦合性或不透明性的方法;限制系统在预定环境之外部署时的自主性(或速度)。......部署的人工智能架构和网络系统的异质性(以隔离系统的闪电式崩溃)......[以及]对 "可解释的 "人工智能和更广泛的人工智能安全的研究。Maas还建议进一步研究如何在不妨碍性能的情况下减轻风险因素,以及 "可能更好地促进优雅故障的组织和技术创新"。

-

一个这样的蜂群战斗情况可能是严重的政治危机,对手认为战争可能爆发。由于蜂群部署在彼此之间的距离很近,控制软件必须在瞬间的时间框架内对攻击的迹象做出反应--通过回避或可能在不使用它们就失去它们的情况下进行反击。即使是错误的攻击迹象--被解释为火箭火焰的太阳光、对手的突然和意外的举动,或一个简单的故障--也可能引发升级。 -

军事冲突的性质决定了这些类型的互动是无法事先测试或训练的。此外,从技术上讲,不可能事先考虑到所有可能的结果。显然,蜂群的互动,如果完全自主,将是不可预测的,并有可能导致从危机到战争的升级,或者在武装冲突中,升级到更高的暴力水平。

-

这与不可预见的算法互动产生不可预见的军事结果相结合,增加了危机的不稳定性,令人不快地想起冷战时期的意外战争情景。

-

在一个有利于进攻的国际环境中,反击使用武力进攻的最佳策略是依靠先发制人。因此,如果[致命的自主武器系统]被开发出来,先发制人的战略很可能成为常态。在被攻击之前先下手为强,将提供战略优势。

军备控制的前景

文献摘要

研究问题

-

自主性的本质是什么?什么是自主武器? -

自主性在历史上是如何被纳入武器的? -

自主武器与现有的保留人类对目标选择和交战的更直接控制的武器有何不同?

-

今天正在制造的下一代武器中包含了哪些类型的自主性? -

趋势表明,自主性可能会被用于未来的武器中? -

武器中的自主性如何与网络空间和网络武器交织在一起?

-

稳定性的概念是什么?什么是不同种类的稳定?哪些条件有助于或有损于稳定? -

自主武器可能在哪些方面影响稳定?自主武器如何影响危机稳定、升级控制或战争终止? -

自主武器,无论是单独还是与对手的自主武器相结合,是否会导致一种 "脆弱的稳定 "状况,即危机迅速升级,脱离人类指挥官的控制? -

自主武器能否通过增加危机中的可预测性来提高稳定性?

-

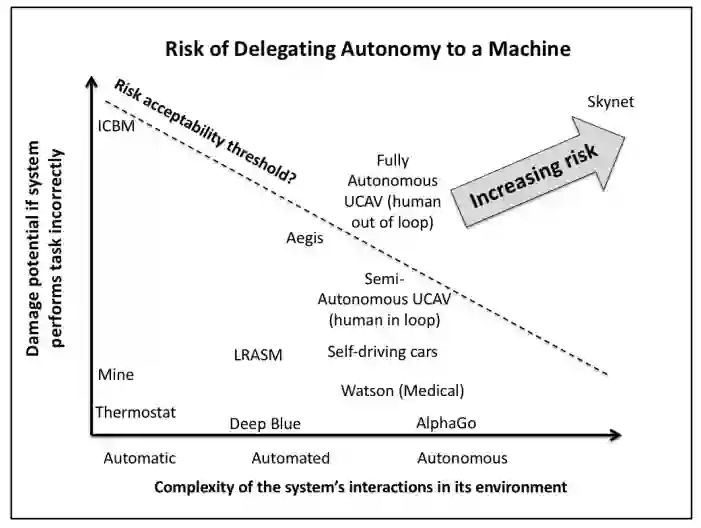

随着系统变得更加自主,风险、可预测性和危险如何变化? -

与现有的半自主武器相比,自主武器发生故障或事故的可能性和后果是什么? -

现有的半自主或受监督的自主武器,如爱国者防空系统和宙斯盾作战系统,其经验对自主武器的风险和控制有何启示? -

非军事自主系统在竞争或不受约束的环境中的经验对自主武器的控制有什么启示? -

军方如何确保在现实的操作条件下,包括在通信降级或被拒绝、敌方黑客攻击和欺骗的条件下,实现可预测和故障安全的操作? -

现有的复杂系统的安全理论--正常事故理论和高可靠性组织--如何适用于自主武器? -

危险技术的历史先例,如核武器,对军队有效管理这些风险的能力有何启示?

-

机器学习方面的最新进展如何改变这些风险? -

人工通用智能的发展将如何改变这些风险?

-

相对于保留人类 "参与 "的半自主武器,完全自主的武器可能有多大价值? -

在物理空间或网络空间,完全自主的武器发生事故可能会有什么后果?

-

各国可以使用哪些军备控制、透明度或建立信任的措施来减轻自主武器的潜在风险,单边或集体的?如果成功的话,这些措施在减少风险方面的效果如何? -

从过去被视为潜在破坏稳定的武器的历史经验中可以学到什么教训?今天的自主武器有哪些相似之处? -

历史上的例子对各种政策选择的可行性有何启示?

方法论

-

在其他武器,特别是核武器的背景下,稳定性和升级动态已经得到了彻底的探讨。这些文献非常广泛,可以追溯到几十年前的冷战时期。这一研究领域提供了一个强大的智力框架,可以在考虑自主武器时加以利用。 -

自动化在武器中的历史用途。在现有的武器中,自动化被广泛用于各种功能,包括跟踪和识别目标,确定目标的优先次序,决定何时开火,以及在发射后对目标进行定位。我们研究了27种不同的武器系统,以说明自动化的不同应用: -

宙斯盾武器系统(美国) -

AIM-120 AMRAAM导弹(美国) -

竞技场主动防护系统(俄罗斯) -

蝙蝠反舰滑翔炸弹(美国) -

BLU-108/B子弹药(美国) -

辉煌反坦克弹药(BAT)(美国) -

反火箭、火炮和迫击炮(C-RAM)系统(美国) -

G7es/T5 Zaunkönig (Wren)鱼雷(德国) -

G7e/T4 Falke(猎鹰)鱼雷(德国) -

手置大黄蜂(美国) -

Harop游荡弹药(以色列) -

哈比游荡弹药(以色列) -

高速反辐射导弹(HARM)(美国) -

低成本自主攻击系统(LOCAAS)(美国) -

M898感知和摧毁装甲弹药(SADARM)(美国) -

M93 "大黄蜂 "广域弹药(WAM)(美国) -

MANTIS防空系统(德国) -

Mk 60 CAPTOR封装鱼雷(美国) -

爱国者防空系统(美国) -

PMK-2封装式鱼雷(俄罗斯) -

传感器引信武器(SFW)(美国) -

SMArt 155弹药(德国) -

Tacit Rainbow(美国) -

战斧反舰导弹(TASM) (美国) -

战斧对地攻击导弹,Block IV (TLAM-E,或战术战斧)(美国) -

"战利品 "主动防护系统(以色列) -

XM1100 "蝎子"(美国) -

下一代军事系统的自主性。在全球范围内,军队正在推动发展中系统的自主性的界限。本报告对22个系统进行了研究,这些系统被选择来说明一系列的应用: -

自主航空货运/公用事业系统(AACUS)(美国) -

机器人船群(美国)。 -

反潜战连续跟踪无人船(ACTUV)(美国) -

武装地面机器人车辆(非国家团体) -

Aura无人机(印度) -

Brimstone导弹(英国) -

拒绝环境下的协作行动(CODE)计划(美国) -

B.A. E. ESGRUM无人水面舰艇(USV)(厄瓜多尔) -

Guardium无人地面车(以色列) -

Modified armed drones(非国家团体) -

nEUROn无人机(法国) -

Platform-M无人地面车(俄罗斯) -

Protector USV(以色列) -

RQ-170无人机(美国) -

SGR-A1哨兵炮(韩国) -

利剑无人机(中国) -

Skat无人机(俄罗斯) -

T-14 Armata坦克(俄罗斯) -

Taranis隐形作战无人机(英国) -

有争议环境下的目标识别和适应(TRACE)计划(美国) -

Uran-9无人地面车辆(俄罗斯) -

X-47B原型无人机(美国) -

网络系统。自动化长期以来一直被用于进攻性和防御性网络系统中。我们研究了四个典型的系统及其自动化程度: -

Conficker -

1988年的互联网蠕虫 -

Mayhem -

Stuxnet -

非军事自主权和人工智能(AI)。这包括自主权在自动驾驶汽车、商业航空自动驾驶仪以及国际象棋或围棋等游戏中的应用。例如,深度学习神经网络等人工智能计算的新方法的最新进展带来了新的机遇和挑战。具体例子包括: -

汽车 -

飞机自动驾驶仪 -

商业级四旋翼飞机(如DJI Spark) -

开源神经网络库(如Keras) -

IBM Watson Jeopardy挑战赛 -

人工智能在战略游戏(如国际象棋、围棋)中的表现 -

深度神经网络,包括用于物体识别的 -

复杂的高度自动化系统中的正常事故、可预测性和安全性。正常事故理论和高可靠性组织的竞争理论为分析复杂系统的安全性提供了基础。研究了13个事故或高可靠性的例子,以了解在一系列行业中引起事故或高可靠性的条件: -

阿波罗13号事件 -

挑战者号灾难 -

哥伦比亚灾难 -

SpaceX事故 -

三里岛事件 -

福岛第一核电站事故 -

F-22国际基准线事件 -

法航447航班坠毁 -

美国联邦航空局空中交通管制系统 -

海军航空母舰甲板操作 -

海军SUBSAFE计划 -

2016年特斯拉自动驾驶飞机坠毁事件 -

737 MAX坠机事件 -

自动化是军事环境中安全和风险的一个因素。在军事领域 场景中,自动化一直是事故和改善安全的一个因素,与其他行业类似。与其他行业类似。为了更好地理解正常事故理论和高可靠性的应用,我们研究了六个例子。为了更好地理解正常事故理论和高可靠性组织在军事环境中使用 自动化在军事环境中的应用: -

自动地面防撞系统(Auto-GCAS) -

基于软件的F-35飞行控制的限制 -

2007年南非的一门高射炮发生了故障 -

2010年美国海军火力侦察兵无人机失去控制 -

2011年美国空军一架RQ-170无人机失去控制并坠毁 -

2017年美国陆军一架 "阴影 "无人机失去控制并坠毁 -

在竞争环境中使用的自主系统带来了额外的挑战,有一些重要的非军事案例研究可供借鉴,特别是在金融领域。本文研究了五个案例: -

亚马逊自动图书定价算法价格战 -

2012年华尔街骑士事件 -

2010年股市闪崩 -

闪崩后的风险缓解措施(如断路器) -

随后的小型闪崩 -

受监督自主武器的操作经验。几十年来,全球各地的军队都在使用受监督的自主武器进行防空和导弹防御,提供了关于一种自主武器的深度操作经验。美国陆军在爱国者系统方面的经验和美国海军在宙斯盾系统方面的经验提供了一个理想的比较研究,因为这两个系统执行相同的任务(空中和导弹防御),由同一个国防承包商建造,但两个军种的使用方式不同。对它们的文化、操作经验和安全记录进行了研究,包括: -

1988年美国海军文森号事件(伊朗航空655航班被击落) -

2003年爱国者龙卷风被击落 -

2003年爱国者F-18被击落 -

2003年伊拉克入侵期间爱国者在弹道导弹防御方面的作战经验 -

1988年后的宙斯盾安全记录 -

核武器安全和风险是思考自主武器风险和安全的一个特别有用的试金石。尽管核武器有明显的危险性,但在整个核时代,出现了大量令人恐惧的险情事件。其中一些事件可能导致核武器失去控制或爆炸。可以想象,其他事件可能会导致超级大国之间的核交换。核武器安全一直是许多分析的主题,特别是斯科特-萨根的《安全的极限》。96 查塔姆大厦最近的一份报告详细介绍了过去60年中13起险些发生的核使用事件。 -

军备控制的尝试--有些成功,有些不成功--可以追溯到几千年前。一些古印度文献--《达摩经》、《摩诃婆罗多》和《摩奴律》--禁止带刺或有毒的箭和其他武器。随着技术的发展,它们因各种原因而被禁止、限制或允许。弩箭最初是在12世纪被教皇的两项法令禁止的(用于对付基督徒)。从17世纪到19世纪中叶,日本有效地禁止了大约250年的枪支,而英国在16世纪的类似尝试也失败了。二十世纪初,人们试图对潜艇进行监管,并禁止对城市进行空袭。化学武器被禁止,爆炸性、膨胀性或燃烧性弹丸也被禁止。今天,大量的法律、政策和规范性原则管理着广泛的武器及其使用。已有条约禁止化学和生物武器、集束弹药、地雷、致盲激光、太空或海底的大规模杀伤性武器、月球上的任何种类的武器,以及利用环境作为武器。各国已经探索了空间和网络空间的规范性框架或行为准则,特别是美国已经试图建立和巩固一个规范,反对产生空间碎片的动能反卫星攻击。总之,过去在规范武器方面成功和不成功的40多个例子提供了丰富的案例研究,以了解规范自主武器的可行性。 -

除了这些其他来源外,还使用了对各领域专家的采访。这些专家包括人机因素工程、机器学习、人类和机器认知、安全关键系统的自动化以及自动化系统的军事运作等方面的专家。这些访谈特别带来了关于复杂的军事自主武器系统运作的新信息:美国海军宙斯盾作战系统和美国陆军爱国者空中和导弹防御系统。对熟悉这些系统的海军和陆军的技术和操作专家的采访,提供了有关这些系统的操作、围绕其使用的文化、安全程序和先前事故的新信息。

原始贡献

-

探讨了对自主武器的四种可能的监管方法,并根据历史上禁止武器的尝试,对其成功的可能性进行了可测试的预测(第七部分)。

报告大纲和结论预览

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“AWAS” 就可以获取《推荐!【博士论文】《自主武器与稳定性》377页伦敦大学国王学院》 专知下载链接

登录查看更多

相关内容

Arxiv

26+阅读 · 2020年12月29日