【基础】集成学习 (Ensemble Learning)

点击上方,选择星标或置顶,每天给你送干货

阅读大概需要3分钟

跟随小博主,每天进步一丢丢

集成学习方法是结合多个模型算法,从而提高整体的准确性,进而得到更好的预测结果。

比如,我们熟知的随机森林就是一种集成学习的方法,它结合了多个决策树的预测结果,而每一个决策树又是用随机的不同的数据训练而成。所以,从这种意义上来讲,随机森林的预测表现一般比单个决策树的表现要好。

集成学习的概念应该不难理解,这个想法广泛的存在于我们的日常生活当中。

比如,当我们需要买一台新的笔记本的时候,我们往往是根据自己的需要来选择自己想要的配置,像多大的内存,多大的硬盘,以及什么样的处理器等等。

再比如,当我们决定买一辆新车的时候,我们也是根据自己的喜好和需要,选择不同的配置,是不是需要有GPS,有video的,什么样的发动机,...

集成学习因为结合了多种模型,从一定程度上来讲,集成模型减少了噪音,方差和偏差,而这正是机器学习模型预测过程中产生错误的主要原因。如果我们能降低减少这些产生误差的原因,自然就可以提高模型的整体预测水平,而这也正是集成方法的重点思想所在。

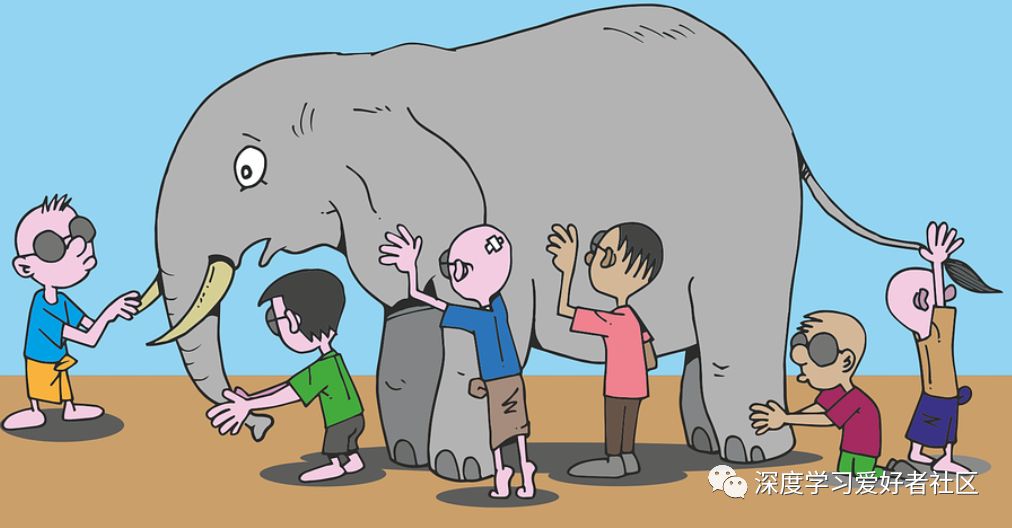

我们还依然记得盲人摸象的故事。故事中,每个人只是摸到了大象的某个局部位置,当然如果只根据所摸到的这个局部位置来预测这是什么物体的话,自然会有偏差,当然不能很好的真实的猜出来。而如果我们结合了所有盲人所得到的信息,把这些信息结合在一起,而进行猜测是什么物体的话,准确率自然会大大提升。

因此,我们再一次看到了集成学习方法的思想所在。它是一种降低方差,偏差和噪音的方法。基本上,每种模型都是在某些情况下表现很好,而在某些特定情况下表现的不好。这样,通过结合这几种单独的模型,那么集成的模型就会某种程度上克服这些缺点,从而整体上胜出任何一个单独的模型。

集成学习模型被广泛的应用于各个领域之中,像土地覆盖图,人脸识别,面部表情识别等等。而比较流行的集成方法有随机森林, XGBoost, 贝叶森模型...