调和级数的几个有趣应用及一个著名悬而未解的数学问题

[遇见数学翻译小组] 核心成员: 刘雄威

一个数学爱好者,希望为数学科普工作做更多贡献,欢迎纠错或讨论,微信号是Mr_LiuXW。

在不允许超车的单行道交通中,一辆慢车后面跟着一堆想超车但不能超车的汽车。如果 辆汽车行驶,将形成多少条车流?如同上一个例子,这就像在问将观察到多少低速记录一样,我们知道答案:

因为车流中后车速度一定会比前车慢,所以两车的间隔会更大。这解释了为什么在长隧道出口附近的汽车往往比隧道入口附近的汽车行驶得更快,并且车流较稀疏时车与车的间隔也会更大。

▌更好的检测方法

假设你有一百根类似的木梁,并希望找到他们产生断裂应变的力的最小值 。您制作了一个简单的机器,将逐渐增大的力施加到水平放置的木梁上。通过逐渐增加力的大小,直到木梁断裂,你可以找到每根木梁的断裂应力

。假设我们用

表示第

根木梁的断裂应力。

以这种方式进行的销毁测试有一个缺点。虽然最后你知道了 根木梁的断裂应力

,但在这个过程中你也毁坏了所有木梁。实际上我们想知道的并不是每根木梁断裂应力的精确值

,而是

的最小值,其中

。于是你改成以下实验。

测试第一根木梁使其产生断裂,并记录下第一根木梁的断裂应力()。然后,测试第二根木梁,不断增加作用在木梁中心的力

直至

的大小,但不要超过

。如果木梁没有断裂,说明这跟木梁的断裂应力大于

。如果木梁断裂了,则记录第二根木梁的断裂应力

。然后测试第三根木梁,使作用在木梁中心的力增加至

和

中的最小值。如果木梁断裂了,记录下断裂应力

,如果没有断裂,则继续做下一根木梁的测试。

这个实验不断地记录木梁断裂应力的最小值,只有那些断裂应力打破新低记录的木梁才会被毁坏,因此如果试验木梁的数目为 ,则有

根木梁会被毁坏,而如果试验木梁

根,则有

根被毁坏。

▌洗牌

我们知道,一开始置底的那张卡牌,在有另一张卡牌放置到它底下之前,这张卡牌(记为

如此一来,

▌穿越沙漠

问题是这样,现在要乘吉普车穿越沙漠,但中途并没有燃料补给,也不能在车里携带足以穿越沙漠的燃料。目前你没有时间建立中途的补给站,但好消息是,手头有的是吉普车。现在的问题是,如何使用最少的燃料穿越沙漠?

我们以一辆吉普车能行驶一箱油的距离所耗油量作计量单位。如果两辆吉普车一起出发,则先一起走

如果三辆吉普车出发,则先一起走

同样地推理,四辆吉普车,可以行驶的最长距离为

在这里,我们有一个新的级数,它也是调和级数(每一项都是等差级数的倒数),当然也发散的

事实上,这个级数的收敛性表明,通过使用这样转移油料大法,只要你有足够多的吉普车就可以穿过无穷大的沙漠(* ̄︶ ̄)。

▌其他级数

我们刚刚看到,即便删除了调和级数的偶数项,余下项组成的级数

级数依然发散。那么下面这个级数敛散性如何?

这个事实的证明有点复杂(虽然这只是大一水平的难度),因此你可以尝试着去证明下。当你证得这个级数发散的同时,你也可以推断出质数的个数是无穷的。

与其删掉分母为合数的项,不如让我们来删掉分母中含零的项。这看起来仅仅是在原有的调和级数中删掉了分母为十的倍数的项。于是我们合理地作出这个级数依然发散的猜测,然而事实或许会违背你的直觉并使你震惊,因为我们的这种猜测是错的。

我们首先看一下那些分母只有一位数的项,显然只有9个,而且它们都小于1。因此他们的总和小于9。

然后,我们看级数中分母有两位数的项。有

通常,级数中分母为

▌与对数的联系

早在14世纪,尼克尔·奥里斯姆已经证明调和级数发散,但知道的人不多。17世纪时, 皮耶特罗·曼戈里、约翰·伯努利和雅各布·伯努利完成了全部证明工作。

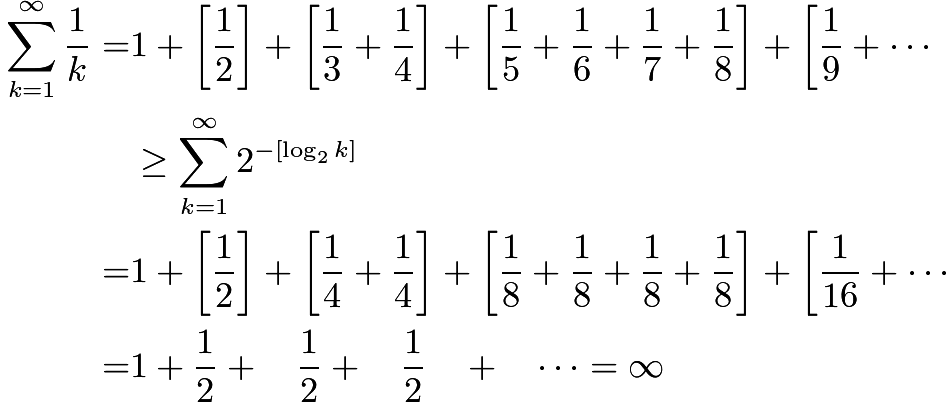

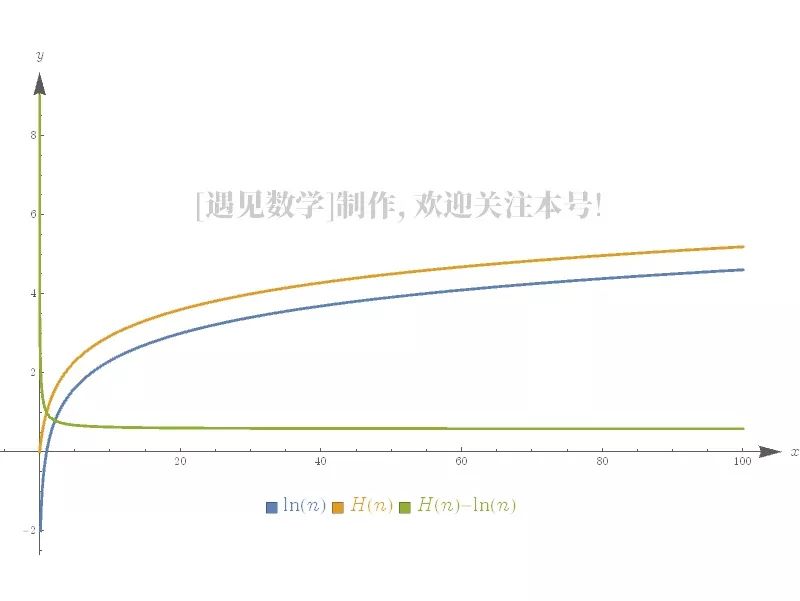

现在让我们回到奥里斯姆的证明,即调和级数的分散。这是通过

调和级数和对数之间的联系更加紧密。利用一点微积分知识更仔细地分析奥里斯姆的不等式,会发现

喜欢本篇内容请给我们点个在看