[有意思的数学] 参数估计

虽然我是统计专业研究生,本科还是数学专业,正常情况是,对统计的知识应该很熟悉才对。But,脑子总是不够用,学了忘,忘了在学,还是会忘。囧。所以今天和大家一起回顾一下之前的统计知识,加深理解。后续还有2-3次关于概率论,数理统计的知识总结。

首先为什么会有参数估计呢,参数估计可以做什么事情?参数估计来源于我们对问题的简化,对于比较复杂,或者人力无法实现,或者实现起来很困难的问题,我们都需要对他进行简化,为啥?因为不简化没法研究啊!假设这样一个简单的情况,某大学校长想知道学校学生中有多少学生谈恋爱了,或者说单身学生占总人数的比例是多少。总不能一个个的去问吧!所以学校的数学老师就提出了这样一个办法,我们在每一个学院随机找一个班级,好,这样一共找了20个班级。假设可以通过班长了解到每个班恋爱人数的真实情况,这样这20个班级的恋爱人数占人数的比例就知道了。别忘了我们的目的是调查全校单身学生的比例,那么我们就可以利用参数估计的方法,来推断全校恋爱人数的一个比例。

再举个栗子,比如我们都知道人的身高是服从正态分布的,那么我们想知道人的身高的均值和方差是多少,由于人口居多,无法遍历的去调查,所以要想知道均值和身高这两个参数,只能用估计的方法去做。为什么是估计,因为最后得到的结果不是一个准确的数字。还是身高的栗子,我们去描述人的身高,有2种方法,一种是把每个人的身高都说一遍,张三多高,李四多高,等等等等。另一种方法是,我们说全部人的身高的平均是180,方差是0.5。这样是不是比第一种方法少数1万字!然后就是说参数估计可以简化对总体分布的描述。还有要注意,我们这里假设事先知道身高是服从正态分布的,如果不知道怎么办?这个就是非参数估计要做的事情。

好,下面我们一步步学习一下参数估计相关的东西。尽量不写公式,用人话给大家解释清楚。囧。

1. 顺序统计量,Order Statistics

首先是顺序统计量,顺序统计量的概念比较简单,但是一般工科的本科教材,好像不讲这个。所以有人可能不知道这个。

顺序统计量首先它是个统计量,统计量的概念不知道是不是清楚。统计量是样本的函数,简单描述为:

统计量=f(样本)

既然是样本的函数,那就是说统计量的计算只能由样本得到,和总体无关。常见的统计量比如平均值,中位数,众数,极差都可以由顺序统计量计算得到。

理解了统计量,顺序统计量就简单了,我们把样本按照值的大小,由小到大排序,比如:

样本1,样本2,样本3,…,样本n

我们把样本1称为最小顺序统计量,样本n称为最大顺序统计量。样本k(k=2,…,n-1)称为第K个顺序统计量。

2.经验分布函数(样本分布函数),Empirical Distribution Functions

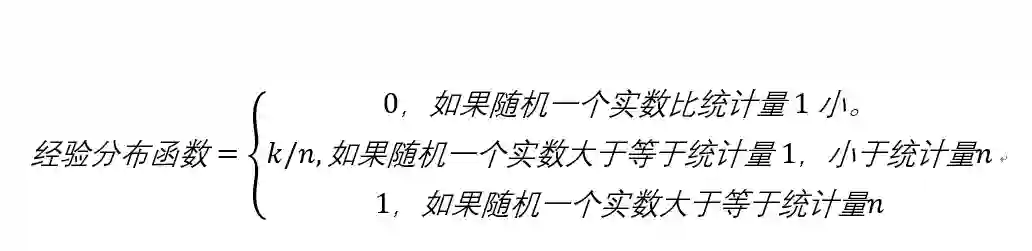

经验分布函数也叫样本分布函数,但是我觉得叫经验分布函数更合适,因为这个分布指的是总体的分布,它是有样本的分布推断,估计得到的。经验分布的计算很简单,比如我们有次序统计量:

统计量1,统计量2,…,统计量n

定义一个函数取个名字叫经验分布函数:

3.点估计,Point Estimation

参数估计的方法一般分为点估计和区间估计,他们都是对总体参数的不同估计方法。区别在于点估计的估计结果是一个点,表示为数轴上面的一个点,而区间估计的结果为数轴上一个区间。点估计的定义是用样本统计量估计总体的参数。所以就会有大家常听说的用样本均值估计总体均值,样本方差估计总体方差等。我们把样本均值叫做估计量,计算结果叫做估计值。依次类推。这里有一点区别,稍微注意一下。

这再说一下,要作为总体参数的估计量,需要满足3个条件,无偏性,有效性,一致性。简单解释一下,无偏性,我们取多个样本取估计总体参数时,每个样本去估计总体的偏差的平均数是0。比如我们对总体取10次样本,

样本1,样本2,…,样本10

那么用每个样本都估计一遍总体参数,每次估计的偏差:

偏差=样本值-总体值

10个样本就会有10个偏差:

偏差1,偏差2,…,偏差10

那么这10个偏差的平均数为0,因为有的偏差为正,有的偏差为负,那么就说这个样本统计量为总体参数的无偏估计量。

有效性,当对总体参数的样本估计量不止一个的时候,估计量的方差越小越有效。比如我们用样本均值,样本中位数这两个统计量去估计总体均值,很明显样本均值比样本中位数更有效,因为他的方差小。(不信自己去算算,反正我没算过,囧)。

一致性,当样本容量为10和100,1000的时候,对总体参数估计值的准确性,应该随着样本容量的增加而增加。前后要一致,这个比较好理解。想个极限的情况,当样本容量等于总体个数的时候,他俩的计算结果应该完全相同。

4. 区间估计, Interval Estimation

然后是区间估计,区间估计的结果是得到一个区间[a, b],表示总体参数落在这个区间的概率。和点估计的区别就很明显了,区间估计没有给出总体参数的具体数值,只是给出一个区间。区间估计有几个概念比较绕,这里主要解释一下几个概念。

置信区间:我们把b-a的值叫做置信区间,就是说我们相信总体参数应该在这个区间,注意这里是应该。人不能对太好,话不能说太满,就是这个道理。我们估计出来的这个区间,并不是总体参数就一定在这里面,也有可能不在,只是说大概率落在这个区间内;

临界值:我们把置信区间的端点a,b分别叫做临界值。

显著性水平:刚才说了,总体参数并不是一定在区间估计的结果中,(毕竟只是估计罢了),所以当总体参数在这个范围时,可能会是错的,那么我们把犯错误的概率就叫做显著性水平。一般用alpha表示。常用的显著性水平0.1,0.05, 0.01。

置信度:置信度也叫置信水平,用1减去显著性水平alpha就是置信度。常见的置信度90%,95%,99%,对应的显著性水平就是0.1, 0.05, 0.01。

小结一下区间估计,区间估计需要解决两个问题,一个置信区间的大小,一个是显著性水平,一般来说,在样本容量确定的时候,他俩是鱼与熊掌的关系,不可兼得。因为当减小置信区间的长度的时候,显著性水平必然提高(犯错误的概率增加),当增加区间长度的时候,犯错的概率是降低了,但是估计的准确性就会降低,也就是我们不容易知道总体参数的值到底是多少了。而区间估计的理论基础是刚才聊得经验分布函数,经验分布函数给出了总体中那些不在样本内的值的分布。经验分布中可以计算任意给定值出现的概率分布,那些我们抽样没有取到的总体,就可以推断出一个大致的可能取值,所以才会有区间估计。然后继续极大似然估计

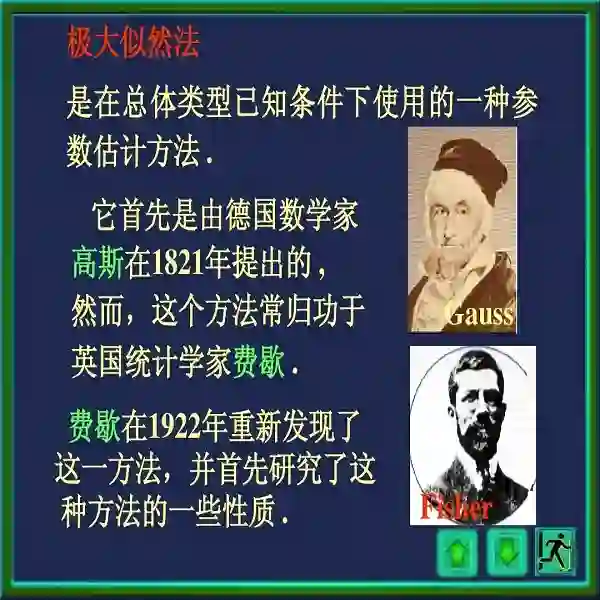

5.极大似然估计,Maximum Likehood Estimate,MLE

极大似然估计属于点估计的一种方法,点估计的另一种方法叫矩估计。矩估计的思想是用样本矩估计总体矩,然后就会有1阶矩,2阶矩,K阶矩等。

极大似然估计,假设我们需要估计的总体参数是,参数y,我们的任务是找个一个,参数x,使得当用参数x代替参数y时,样本出现的可能性是最大的。“似然”的意思就是样本出现的概率,极大“似然”就是样本出现的概率最大,那怎么能让概率最大呢,就是用极大似然估计的方法来找到参数x,这时,用参数x代替参数y,样本出现的概率就是最大的。极大似然估计考虑的是参数y是确定存在的,只是具体的值需要算一下,注意这个并不矛盾。

然后说一下极大似然估计的计算

假设我们有来自总体的样本:

样本1,样本2

(为了方便书写,只写2个样本)

那么事件

A = {总体1=样本1,总体2=样本2 }

发生的可能性,根据乘法法则:

概率(A)= 概率(总体1=样本1)*概率(总体2=样本2)

我们概率(A)就叫做似然函数,这里似然函数实际计算的是一个概率分布。不论是离散情况还是连续情况,都是一样的。我们的任务是:

概率(A| 参数y)=max概率(A | 参数x)

这样用参数x代替参数y,样本A出现的概率就是最大的。求参数x的过程就叫做极大似然估计。极大似然估计的输入是样本观察值,输出是总体参数的估计值。所以极大似然估计的缺点就是很依赖样本,如果样本量比较小,估计结果可能不准确。

对数似然函数:为什么会有对数似然函数?对数似然函数的出现主要是为了简化计算和提高精度。只是计算技巧和精度的考虑,不涉及极大似然估计的思想。

6. 贝叶斯估计, Bayes Estimation

接下来是贝叶斯估计,贝叶斯估计需要贝叶斯公式的知识,贝叶斯公式用到了两个条件概率,先看一个栗子,可能很多人都遇到这个题,

现分别有 A、B 两个容器,在容器 A 里分别有10个红球和 30个白球,在容器 B 里有20个红球和20个白球。现已知从这两个容器里任意抽出了一个球,且是红球。问这个红球是来自容器 A 的概率是多少?

这个问题涉及两个条件概率,一个是在抽到球的条件下,抽到红球的概率,记做P(A | B),另外一个是在红球的条件下,红球是容器A里的概率,记做P(B | A)。首先两个容器抽到红球的概率是3/8,选择容器A的概率是1/2。容器A中选择红球的概率是1/4,那么

P(B|A)=P(AB)/P(A)=[P(A|B)*P(B)]/P(A)

=(1/2*1/4)/(3/8)

这个就是贝叶斯公式。

我们之前聊得点估计和极大似然估计用到了样本信息和总体信息,这是经典统计学派,在统计推断问题中使用的信息,统计学派中还有一大流派叫贝叶斯学派,贝叶斯学派除了利用样本信息和总体信息外,还考虑先验信息。先验信息不属于推断问题本身,而是来源于问题之外。不管我们是否抽样,先验信息总是存在的。比如我们刚才从容器A,B抽红球的时候,不管我们是不是抽样,总可以知道在A里面抽到红球的概率,这就是一个先验。抽样之前就有的经验信息。再比如有人说我每次闭着眼睛都能找到回家的路,这是为什么?一般来说他找到找不到回家的概率各占0.5,那么他10次都能找到的回家的概率0.5**10,这个概率极低,但是他就真的能找到回家的路,这是因为他以前回家的经验帮助了他,就是先验信息。

好,继续聊贝叶斯估计。极大似然估计认为参数y是一个确定的常数,只需要通过样本估计一个参数x,就能得到参数y的值。而贝叶斯学派的贝叶斯估计认为参数y是一个随机变量,随着经验的不断增加,对参数y的估计的准确性应该会越来越高,那么应该充分利用先验信息。贝叶斯学派认为,总体的分布是在参数y确定的情况下的一个条件概率分布,

P(总体|参数y)

当一次抽样之后,得到的样本就包含了有关参数y的信息,这个信息是就是经典统计学派的样本信息。还是我们之前的栗子,假设我们有来自总体的样本:

样本1,样本2

概率(样本| 参数y) = 概率(总体1=样本1)*概率(总体2=样本2)

参数y是一个随机变量,它有一个概率分布,记为:

G(参数y)

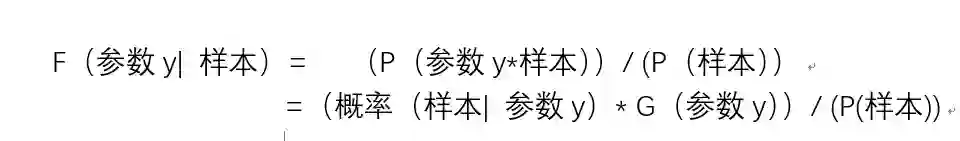

无论是极大似然估计还是贝叶斯估计,目的都是在给定样本的条件下,求总体参数y的概率分布。那么我们记:

F(参数y| 样本)

表示我们最终的估计结果。

这里用到了贝叶斯公式。

7.最大后验估计, Maximum aposteriori probability estimate, MAP

前面聊了极大似然估计和贝叶斯估计,他俩的一个最主要的区别在于贝叶斯估计利用了先验信息G(参数y)。极大似然估计的缺点是只能估计被估计参数y的一个值,无法知道在已有样本的情况下,参数y的分布情况。而贝叶斯估计可以得到所有参数y的分布,然后我们可以求使分布函数最大得参数y。而最大后验估计的思想是,不考虑参数y的其他情况,只求参数y的最大值。因为参数y的先验信息已经有了,所以最大后验估计可以表示为:

MAP=概率(A | 参数y)=max[概率(A | 参数x)* 概率(参数y)]

最大后验估计和极大似然估计的区别是多了一个参数y的先验信息,所以它也是属于贝叶斯估计,但是和贝叶斯估计又有区别。

参数估计的概念就爬到这里了,不知道大家理解了没有,深感自己理解不到位,自己明白和给被人讲明白完全不是一回事~

机器学习的路是非常漫长的,想有所突破不是短时间能完成的,希望大家一起努力!加油!

---End---