【速览】ECCV 2022 | 反倒摄抑制的终身学习

学会“成果速览”系列文章旨在将图像图形领域会议期刊重要成果进行传播,通过短篇文章让读者用母语快速了解相关学术动态,欢迎关注和投稿~

◆ ◆ ◆ ◆

ECCV 2022:反倒摄抑制的终身学习

*通讯作者:Baochang Zhang

◆ ◆ ◆ ◆

人类可以不断地学习新知识。然而,机器学习模型在学习新任务后对于先前任务表现会急剧下降。相似知识的竞争是导致遗忘的重要原因。在本文中,我们为终身学习设计了一种基于大脑的联想机制和的元学习的范式。它从提取知识和记忆知识这两个方面解决终身学习问题。首先,我们通过对背景攻击扰乱样本的背景分布,从而加强模型提取每个任务关键特征的能力。其次,根据增量知识和基础知识的相似性,我们设计了一个自适应的对增量知识的融合策略,这有助于模型将容量分配给不同困难程度的知识。我们从理论上分析了我们提出的学习范式可以使不同任务的模型收敛到同一个最优值。所提出的方法在MNIST、CIFAR100、CUB200和ImageNet100数据集进行了验证。

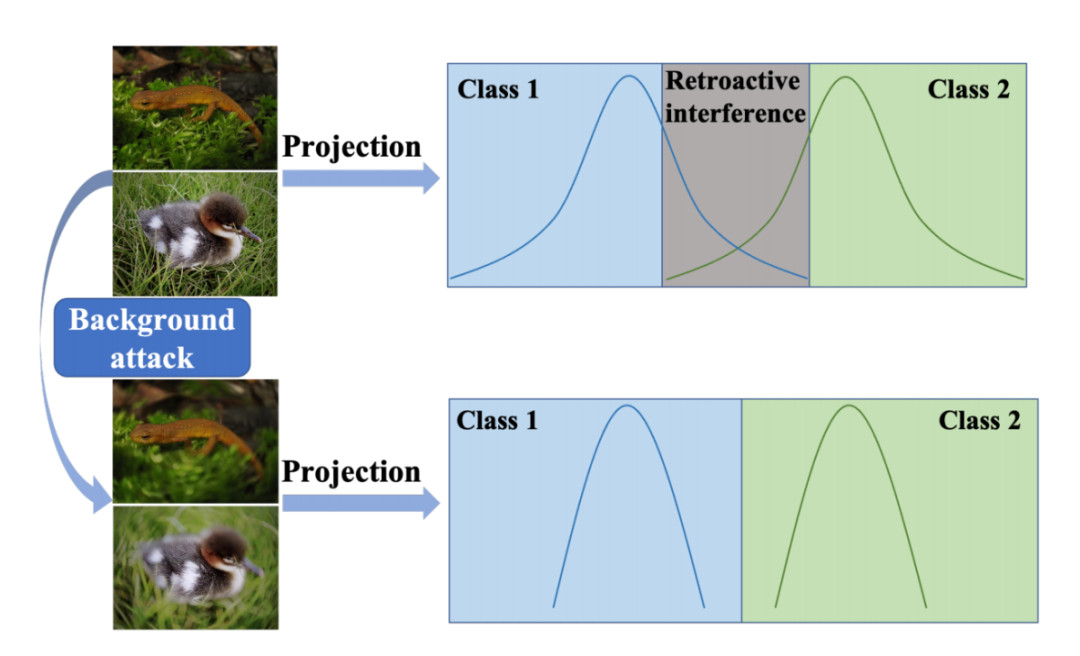

图 1 在终身学习中,现阶段的知识与以前的记忆竞争并造成干扰,尤其是当知识是相似的情况下。因此,我们在攻击两个任务中相似的内容以改变数据分布,避免倒摄抑制。

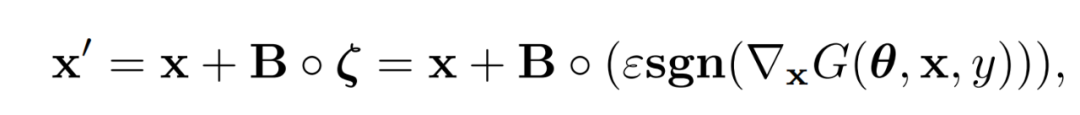

为了解决深度学习模型在学习新事物过程中的遗忘问题,我们提出了一种基于元学习和联想学习的终身学习的范式。我们将模型分为两个阶段:提取类内特征并融合类间特征。在第一阶段,我们希望通过减少旧知识和新知识之间的竞争来避免倒摄抑制。我们需要准确地抓住新任务的关键知识并专注于学习它,这可以有效地避免知识的混乱。为了实现这个想法,我们设计了一种基于联想学习的背景攻击方法。首先,模型会对干净图像进行学习,通过空间注意力机制,可以得到图像的重要性图。我们对非关键区域(即背景)进行对抗性攻击并扰动这些区域的数据分布。然后,模型会继续学习攻击后的图片,从而削弱对不重要信息的学习。背景攻击的公式如下所示,x表示干净图像,

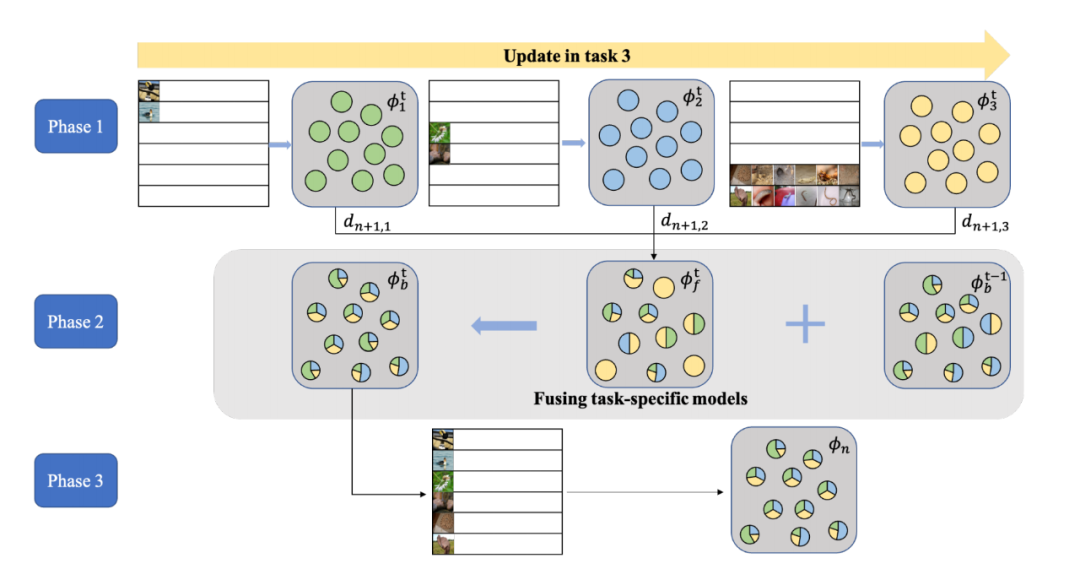

在第二阶段,我们将现有模型与刚刚的学到的模型结合起来。它不同于直接更新预训练模型的传统的增量学习方式,因为那样很容易造成遗忘。因此,我们将要学习的知识组织成不同的任务。每个任务都是单独学习的,并且各输出单独的模型。最后我们提出了一种针对任务的模型融合方法,能够保障不同任务所对应的模型能够收敛到一个公共的最优模型以减少信息损失。

图 2 模型融合过程(以任务3为例)。可以分为3个阶段,在第1阶段,基于保存的过去任务的少量样本以及当前任务的全体样本训练针对各个任务的模型。在第2阶段,进行模型的融合。在第3阶段,对融合的模型进行元训练,获得任务3的增量基模型。

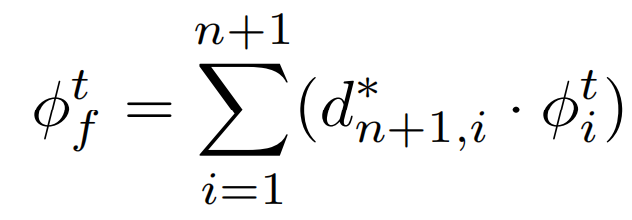

具体而言,模型融合的结果可以表示为

其中,

通过增加超参

我们在MNIST、CIFAR100、CUB200和ImageNet100数据集上验证了算法的性能。

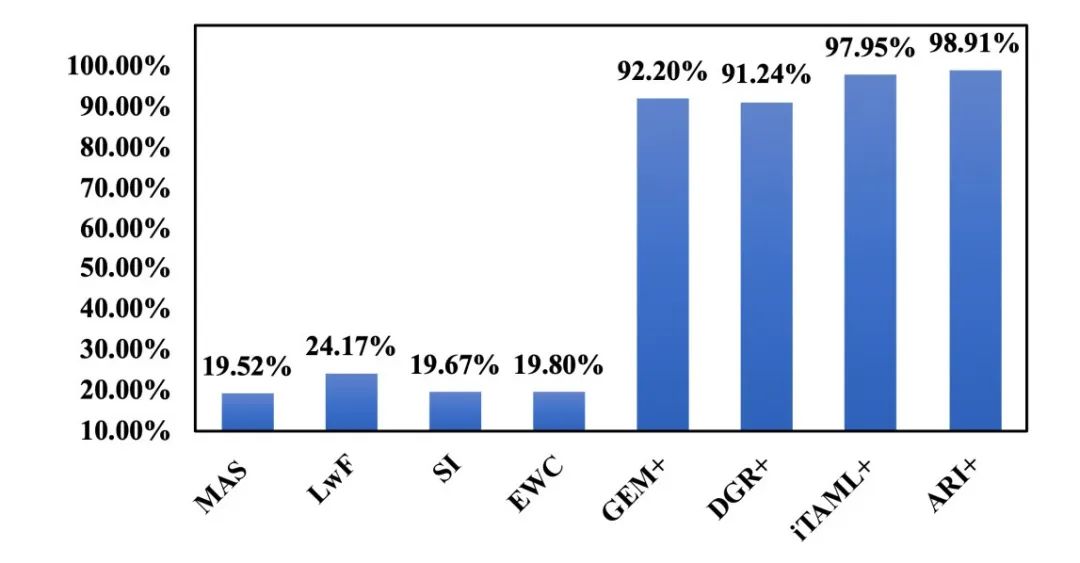

图 3 MNIST数据集平均分类准确率

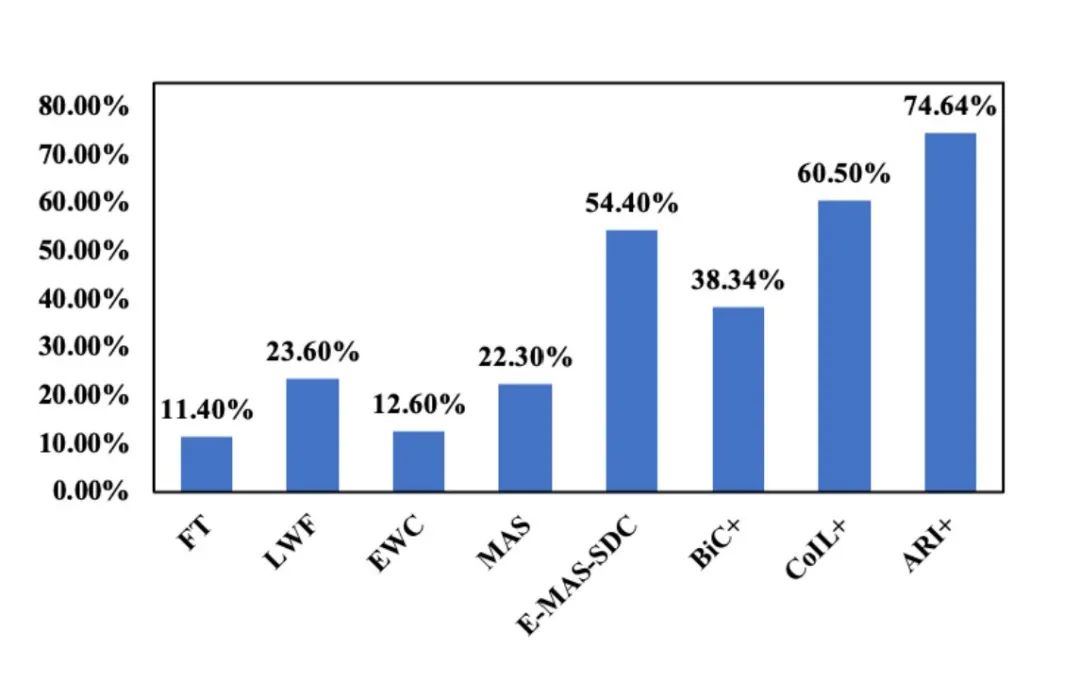

图 4 CUB200数据集平均分类准确率

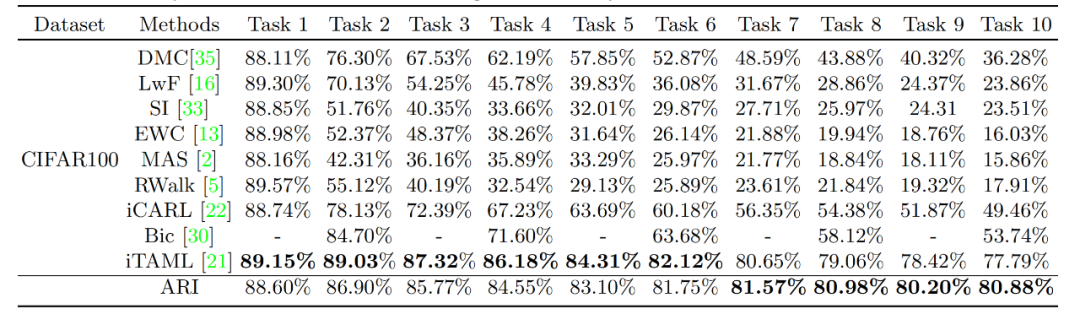

在CIFAR100数据集上,我们采用ResNet-18 (1 /3 )模型,设置保存图片的总数量为2000,分别比较了平均准确率,BWT以及FWT[1],结果如下表所示。

表 1 CIFAR100数据集上平均准确率的比较。任务t的准确率表示从任务1到t的平均准确率

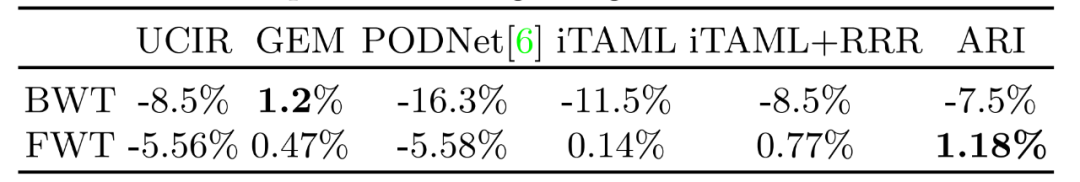

表 2 CIFAR100数据集上不同方法的BWT和FWT的比较

在平均准确率有着明显提升的情况下,ARI有着较低的BWT以及更高的FWT。

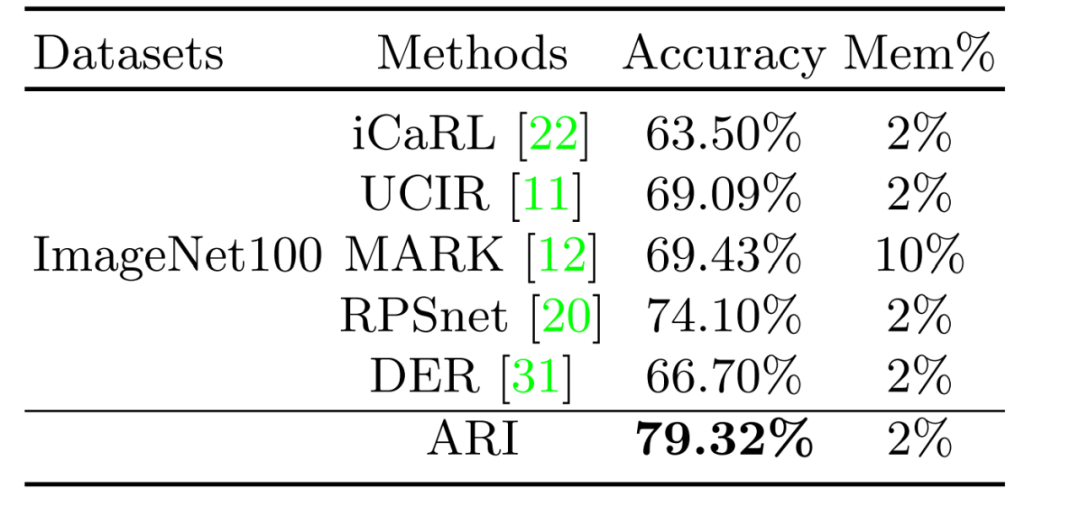

表 3 ImagNet100数据集上的结果比较

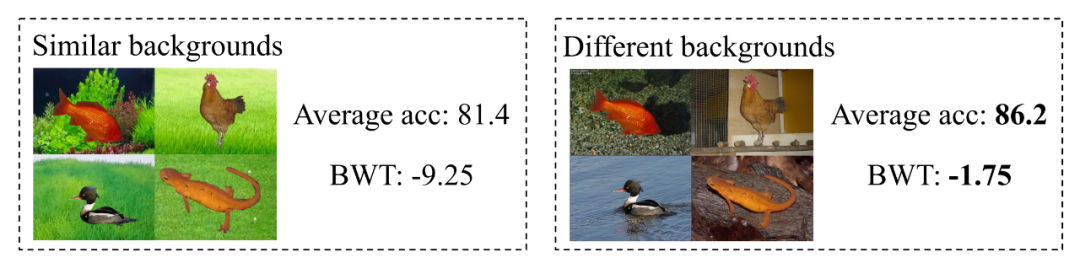

我们还进行了一系列消融实验验证我们的方法。为了证明相似的背景会导致遗忘,我们构建了一个仅有10个类别的数据集,每个类别含有100张训练和50张测试图片,在实验组中,我们更改训练图片成相近的的背景,测试图片不做修改,对照组采用未做修改的原始图片。我们构建了5个任务,每个任务2个类的增量学习任务。我们衡量了模型学习完全部任务后的平均准确率和BWT,发现相似的背景特征会导致遗忘。

图 5 相似的特征会导致遗忘

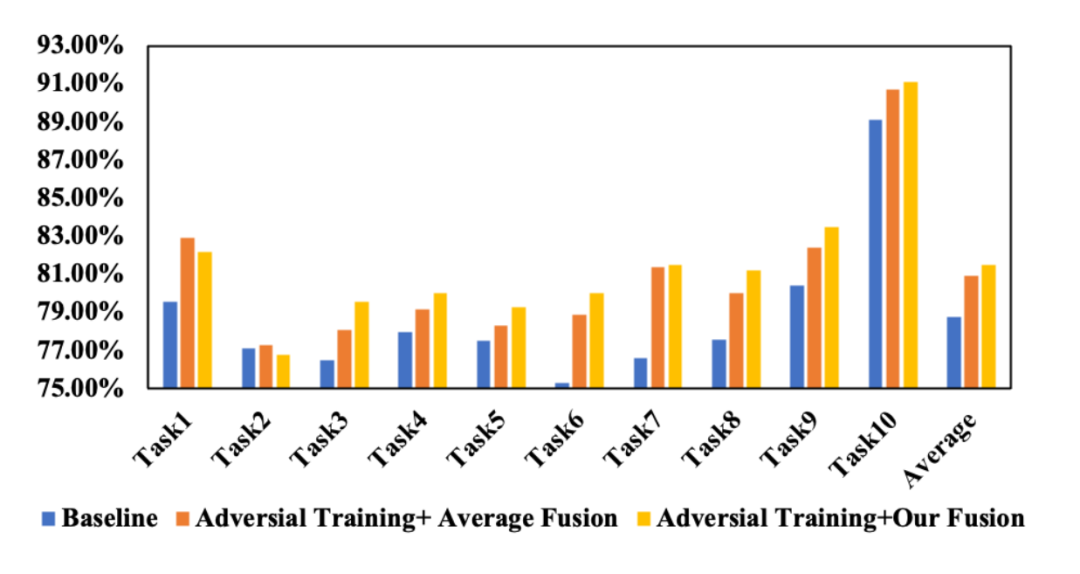

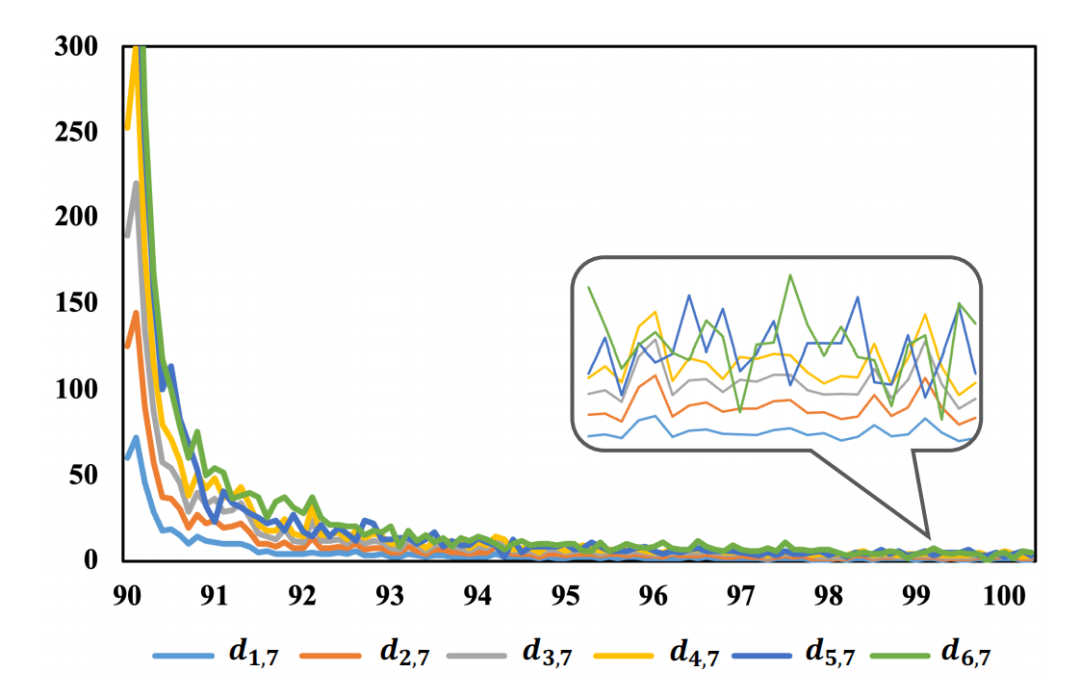

为了验证背景攻击以及模型自适应融合的有效性,我们在原始方法上依次增加背景攻击以及模型自适应融合,发现模型在学习完全部任务后对所有任务的准确率上都有着一定的提升。同时,我们绘制了模型自适应融合前针对不同任务的模型和基模型之间的距离,发现随着训练过程的进行,距离逐渐收敛到0。说明通过我们的融合策略,可以让针对不同任务的模型收敛到公共的最优点,从而缓解了模型融合过程中的信息损失。

图 6 在CIFAR100数据集上,模型在学习完全部任务后对所有任务进行测试的准确率。Baseline为相同的模型不进行背景攻击以及采用算数平均的融合方式。

图 7 在CUB200数据集上,针对不同任务的模型和基模型之间的距离。

[1] Lopez-Paz, D., Ranzato, M.: Gradient episodic memory for continual learning. In:NeurIPS (2017)