CVPR 2022 Oral|OGM-GE:基于动态梯度调节的平衡化多模态学习

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

作者:无影 | 已授权转载(源:知乎)编辑:CVer

https://zhuanlan.zhihu.com/p/507823626

在多模态模型中,差异较大的异质模态数据朝着统一优化目标被同时训练,那么各个模态间的关系是竞争还是合作?训练的更快更好的模态会对相对较弱的模态起到指导作用还是抑制作用?如何合理的调整不同模态训练进程使之能够取长补短,从而达到整体最优,是一个值得去探究的问题。

最近,本实验室针对这一问题提出了一种新的多模态优化方法,使得多模态模型能够针对自身模态间的训练差异做出自适应评估,并对梯度进行针对性调控以实现更平衡的优化进程。目前这一成果已被CVPR2022接收并选为Oral Presentation,相关代码已经开源。

标题:Balanced Multimodal Learning via On-the-fly Gradient Modulation

论文:https://arxiv.org/abs/2203.15332

项目地址(已开源):

https://github.com/GeWu-Lab/OGM-GE_CVPR2022

概述

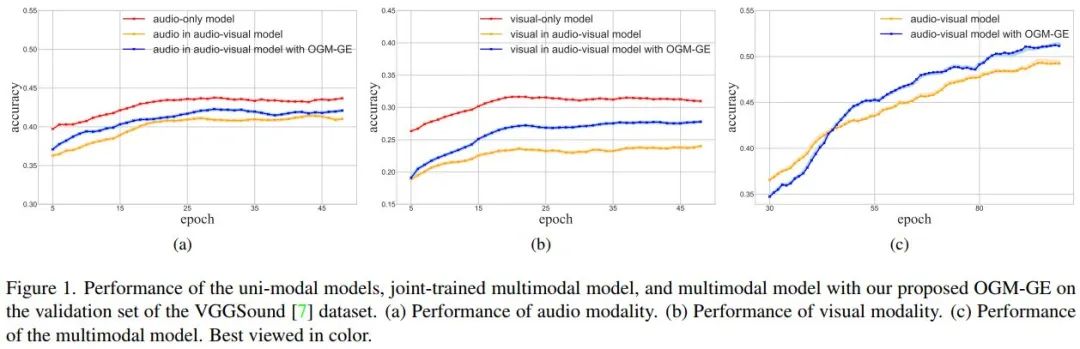

多模态学习的重点是对不同模态的信息进行有效的整合。通常情况下,更多的可利用模态对模型性能的提高是非常有益的。但在实际的训练过程中我们发现,即使多模态模型的性能优于单模态模型,这些不同模态的信息也可能没有得到充分利用(如图1所示,在多模态模型中特定模态编码器表征能力反而不如单模态模型,这说明现有的视听判别模型可能仍然存在欠优化的单模态特征表示)。

我们从优化的角度分析了模态间不平衡现象,认为原因可能是,在某些多模态模型的训练过程中,性能更好的模态(主导模态)会对其他模态的优化产生抑制作用。具体来说,对主导模态的优化更有助于降低联合判别损失,主导模态的梯度反传会优于其他模态,从而主导优化过程,但同时其余模态可能是欠优化的。为了解决这一问题,我们针对性地提出了泛化增强的动态梯度调制 (OGM-GE)算法,使得多模态模型可以被训练地更加平衡。

再举一个生动些的例子,在速度滑冰团体追逐比赛中,是以团队最后一名完成的队员记录团队成绩,我们把一个多模态任务里不同的模态比作一个团队中的不同队员:通常情况下优势模态队员与较慢的弱势模态队员缺乏联系与互助,即使率先到达终点(训练收敛)也不得不停下来等待弱势模态队员(如图2的上半部分所示);但是通过OGM-GE方法的调控,让优势队员慢下来带带弱势队员,其自身仍能优先到达终点不会受到影响。并且身后的弱势队员由于受到帮助(比如滑冰比赛中的借风等因素)速度有所提高,这样团队总体成绩便能提高(如图2的下半部分所示)。

问题分析

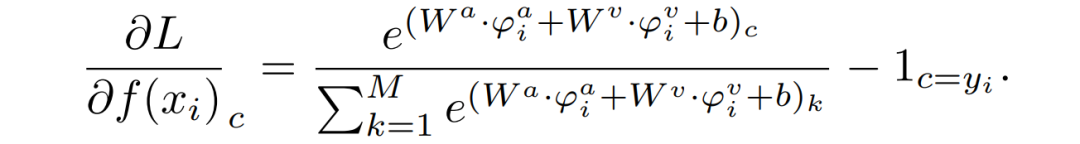

进一步地,我们可以观察到对于 Wa 和 θa 来说,它们在利用反向传播算法更新时,其中相关联的项只有损失函数 L 对于 f(xi) 的偏导,展开该项,我们可以发现当某个模态在线性分类层中对应的通道的输出值较高时,该模态对偏导的贡献较大。也就是说,该模态对模型的梯度反传会起到主导性的作用,随着该模态的收敛,损失函数也会逐渐降低,其他模态也会渐渐失去可优化的空间。

模型方法

为了解决上述优化不平衡问题,我们从调节不同模态对应模型的优化进程出发,根据模态间的效果差异自适应地调制梯度,并结合高斯噪声的泛化性增强能力,提出了具有较强适用性的OGM-GE优化方法,整个方法的算法框架如图3所示。

首先,针对上述分析中讨论的优化不平衡问题,我们提出通过监控它们对学习目标的贡献的差异来自适应地调节每种模态的梯度。为了有效地衡量多模态模型中单模态表征能力的差异,我们设计了模态间差异比率这一指标;在训练进程中,根据该模态间的差异比率,我们动态地赋予不同模态不同的梯度比例系数,这样在整个训练过程中,我们都可以自适应地调控模型的优化进程。

其次,通过分析,我们发现对梯度添加小于1的系数进行调控会削弱优化过程中随机梯度噪声的强度,进而可能潜在地影响模型的泛化能力。因此,我们在梯度调控的基础上增加了噪声补强策略,即在梯度上额外增加高斯噪声,以恢复(甚至在原有基础上增强)随机梯度噪声强度,从而提升模型的泛化性能。

实验结果

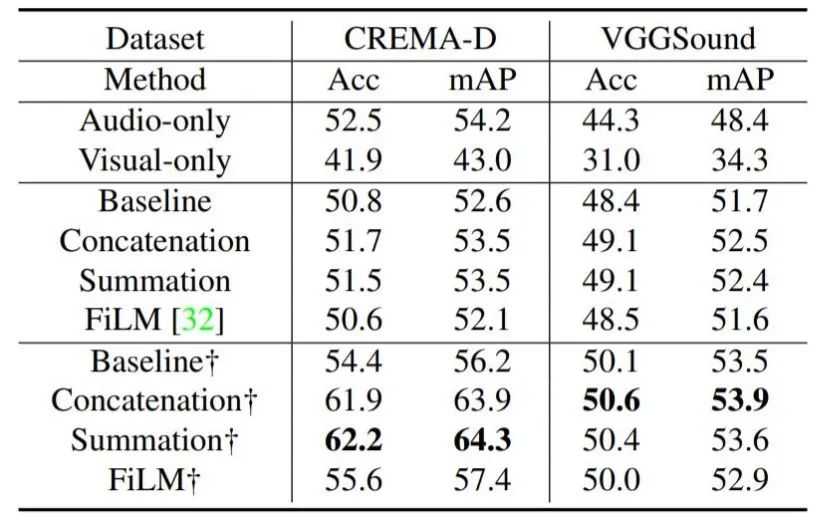

为了广泛验证该方法在不同的多模态任务里的效果,我们首先在CREMA-D, Kinetics-Sounds, 和VGGSound上进行了分类和识别任务的验证,OGM-GE应用于几种常用融合方法:Concatenation和Summation,以及专门设计的融合方法:Gated (baseline) 和FiLM,然后评估这些方法在各个数据集上的性能,结果如表1和表2所示(标记

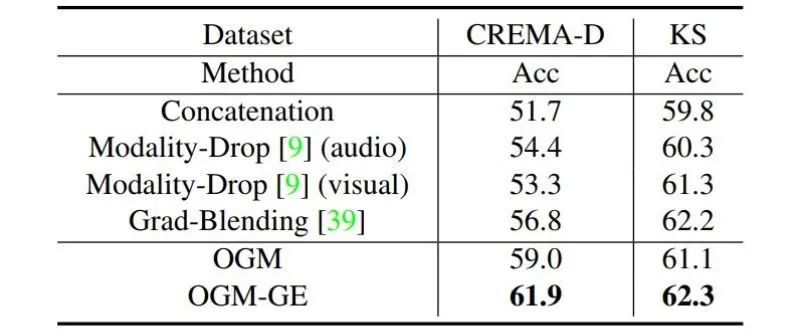

我们还在动作识别和情感识别两个任务上将提出的OGM-GE与几种主流的现有方法相结合,以进一步评估其灵活性。相关结果如表3,表4所示,经过OGM-GE的调控,现有的方法均取得了不同程度的提升。这说明了OGM-GE的有效性和通用性。

图4展示了OGM-GE调控过程,使用了OGM-GE训练的模型(蓝线),模态间的不平衡比例要显著小于直接训练的模型(黄线)。但由于不同模态间的信息量等存在天然差异等因素,该比例可能无法逼近1,只能在合理范围内减小。

总结

总体来说,我们针对多模态训练中存在的优化不平衡问题进行了理论分析,并提出了一种简单但有效的多模态学习策略,称为泛化增强的动态梯度调制 (OGM-GE),以缓解这种不平衡问题,促进多模态信息的有效利用。该方法在多个具有代表性的多模态任务上都可以取得明显的性能提升,并且可以灵活地嵌入现有的多模态模型和融合方法中。但同时,我们发现仅利用OGM-GE这类面向优化过程的调控的方法可能无法彻底解决不平衡问题,在未来,我们会尝试从不同的角度,继续对模态不平衡问题展开分析和研究。

本研究主要由实验室硕士生彭小康,博士生卫雅珂,访问学生邓安东完成,通讯作者为实验室胡迪助理教授。此外,实验室非常欢迎对多模态感知与学习的相关研究感兴趣的同学加入(本、硕、博和访问学生),详情请进一步查看实验室招生宣传(https://zhuanlan.zhihu.com/p/496452639)。

作者:彭小康 | 审校:侯文轩,胡迪

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer6666,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信: CVer6666,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号

整理不易,请点赞和在看