![]()

©PaperWeekly 原创 · 作者 | 小马

单位 | FightingCV公众号运营者

研究方向 | 计算机视觉

写在前面

近几年,随着抖音、快手等短视频平台,以及哔哩哔哩、优酷等视频平台的出现,网络中出现了大量的视频媒体。海量视频媒体给视频内容的准确检索带来了巨大挑战。在本文中,我们将介绍一些近几年视频文本检索的文章,让大家了解视频文本检索的最近工作进展。

![]()

2.1.1. 论文信息

![]()

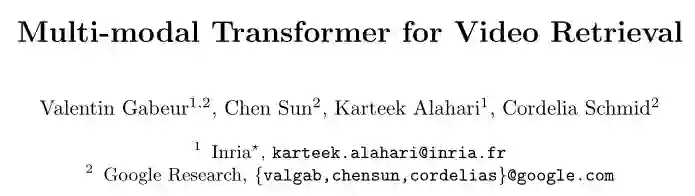

Multi-modal Transformer for Video Retrieval

论文地址:

https://arxiv.org/abs/2007.10639

代码地址:

https://github.com/gabeur/mmt

![]()

进行视频文本检索的关键是学习精确的视频-文本表示,并建立相似度估计。目前的方法主要存在两个方面的缺陷:1)没有充分利用好视频中动作、音频、语音等各个模态,从上图中可以看出,从所有组成模态中联合提取的线索比单独处理每个模态更具信息性;2)没有充分考虑视频的时间性,由于数据集中的视频时长不一样,目前的方法通常是通过聚合视频中不同时刻提取的描述,从而丢弃长期时间信息。

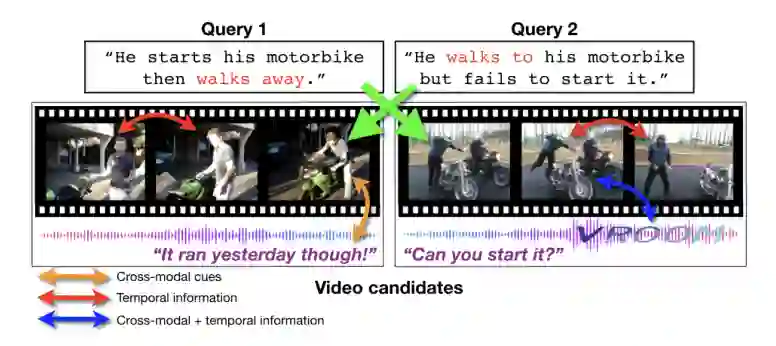

在本文中,作者提出了一个多模态 Transformer(MMT)来解决上面的挑战,首先提取不同时刻和不同模态的特征,将他们聚集在一个紧凑的表示中,并用 Transformer 进行不同时间和模态信息的交互,最终基于聚合特征来评估视觉和文本之间的相似性。

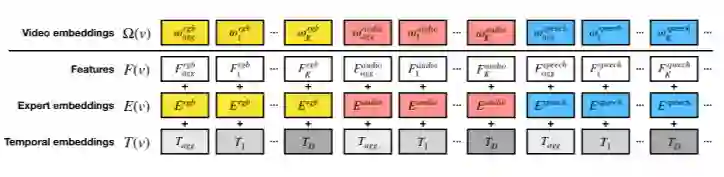

![]()

本文的结构如上图所示,本文的特征提取用的是预训练的 BERT,视频的特征用的是不同的预训练好的“专家”模型来提取不同模态的特征,每个模态采用 max-pooling获得一个聚合特征,然后将提取的特征和专家 embedding、时间 embedding 相加能到最终的视频特征(如下图所示)。

![]()

作者用一个多模态 Transformer(MMT)来建模这些特征的不同模态和时间的关系,最终获得具有代表性的聚合特征,然后用不同聚合特征和文本特征求相似度,并对其进行加权求和,得到最终的视频本文相似度。

论文标题:

T2VLAD: Global-Local Sequence Alignment for Text-Video Retrieval

https://arxiv.org/abs/2104.10054

未开源

![]()

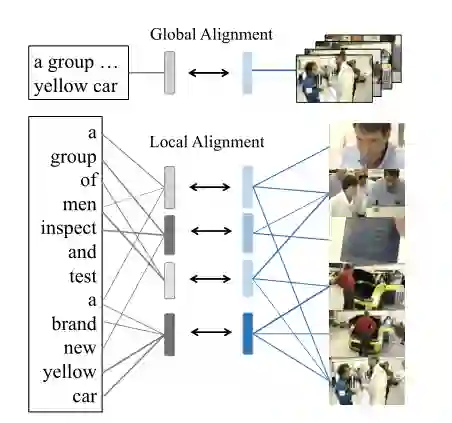

目前进行多模态匹配的方式有两种,一种是全局的粗粒度匹配,这种方式简单,但是忽略了细粒度的语义对齐;另一种是细粒度的语义对齐,目前通常是设置三个语义级别(事件、动作和实体),然后进行成对匹配,但是这种方法需要比较高的计算成本。

在本文中,作者提出了一个局部-全局的序列对齐方法。从局部角度,作者并没有进行一对一的成对匹配,而是设置了共享主题,这些主题在图像和文本中共享,然后最小化相同主题的图像和文本特征之间的距离,实现局部的对齐。从全局角度,只需要将全局的视频和文本特征进行相似度比较,作为局部对齐的一种补充度量和额外监督。

2.2.3. 论文方法

![]()

与上一篇文章一样,用预训练的 BERT 提取文本特征,用不同预训练的“专家”模型提取视频中不同模态的特征,不同模态的特征进一步用 Self-Attention 进行加强。

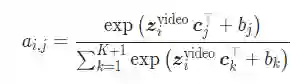

对于局部对齐,作者首先设置了 K+1 个共享聚类中心 c(由于视频和文本共享相同的聚类中心,因此有利于将视频和文本在相同的语义空间中进行对齐),然后根据计算每个聚类中心和每个特征之间的相似性,进行并更新特征,视频更新方式如下所示(文本特征更新方式类似):

然后利用余弦相似度来度量视频和文本特征之间的局部相似性。

对于全局对齐,在不同专家的时间维度上进行 max-pooling,得到全局视频聚合特征;用对齐后文本的 concat 结果来生成 N 个全局文本聚合特征,最后计算文本和视频的全局特征的相似度。

2.3. CLIP4Clip——arXiv 2021

![]()

论文标题:

CLIP4Clip: An Empirical Study of CLIP for End to End Video Clip Retrieval

https://arxiv.org/abs/2104.08860

https://github.com/ArrowLuo/CLIP4Clip

2.3.2. 论文动机

随着 CLIP 的爆火,作者在本文中希望将 CLIP 中图片文本预训练获得的知识转移到视频文本检索任务中,因此作者提出了 CLIP4Clip 模型,并设计了三种相似度计算方式进行相似度的计算。

2.3.3. 论文方法

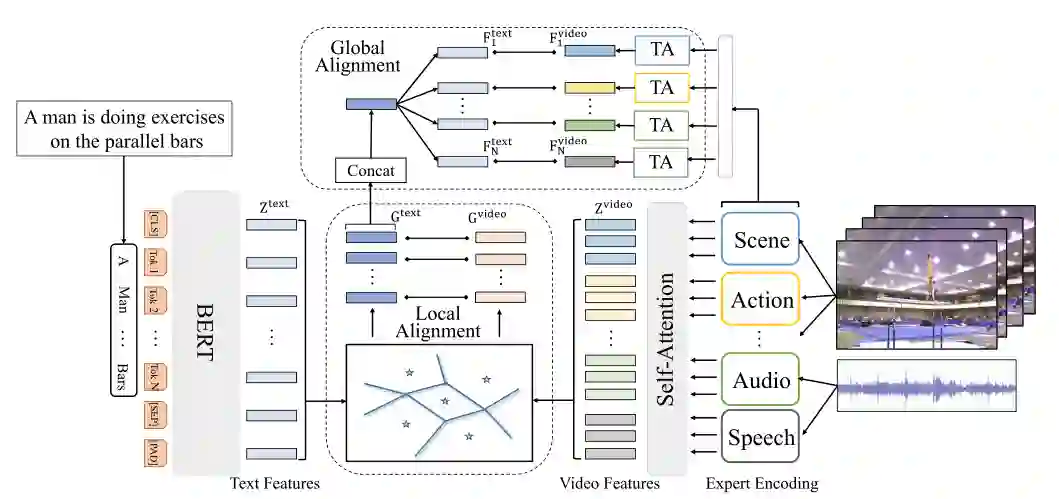

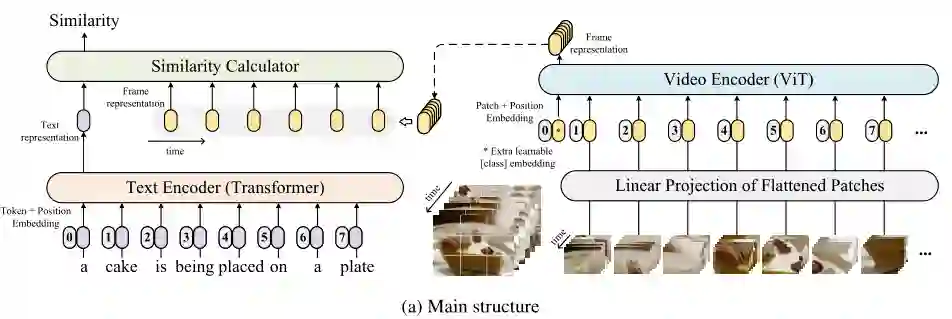

![]()

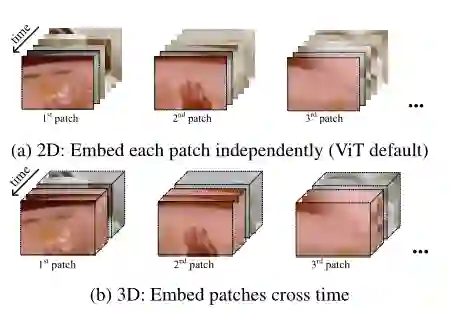

上图展示了本文的模型框架,作者将视频看做一系列图片的集合。对于视频编码,作者采用了 CLIP 中预训练的 ViT,Patch Embedding 的时候采用了以下两种方式(2D:不考虑时间的信息,对每一张图像分别 embedding;3D:考虑时间信息,相邻的帧一起 embedding):

![]()

对于文本编码,作者采用了 CLIP 中预训练的 Transformer 进行文本表示。

![]()

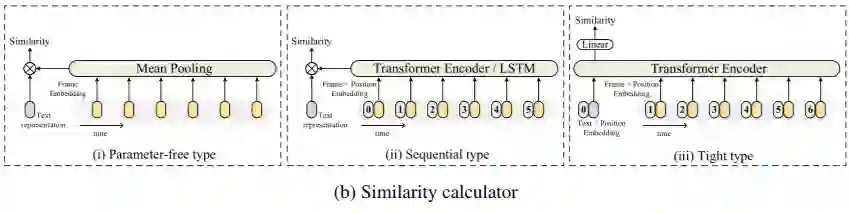

这样,我们就获得了带时间序列信息的视频表示和文本表示,然后作者采用了三种方式进行了视频和文本的相似度计算,如上图所示,总的来说前两种的方法的性能要由于第三种方法,可能是因为第三种方法引入了太多随机初始化的参数,从而破坏了原来 CLIP 已经学好的信息。

2.4. CLIP2Video——arXiv 2021

![]()

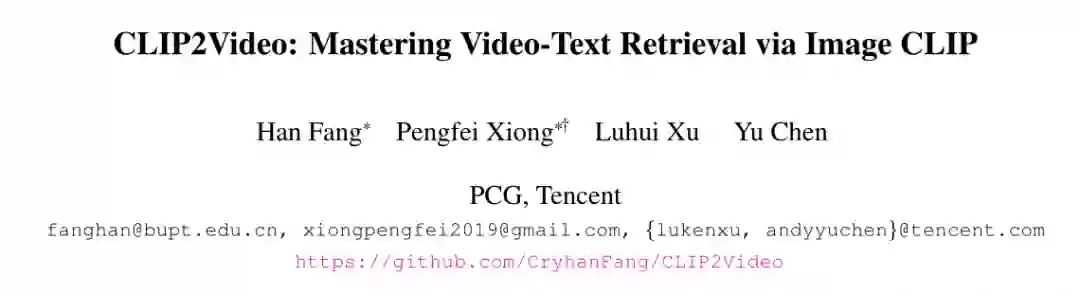

论文标题:

CLIP2Video: Mastering Video-Text Retrieval via Image CLIP

https://arxiv.org/abs/2106.11097

https://github.com/CryhanFang/CLIP2Video

目前的视频文本检索主要在解决两个问题,分别为是视频域中的视觉特征表示和视频和语言之间的多模态交互。为了解决这两个问题,作者将视频看做是一系列顺序帧的表示,然后将视频和语言理解的问题转换成了两个独立的问题:图像文本训练的空间表示和视频帧与视频语言的时间关系。

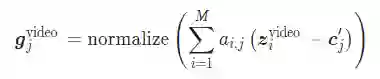

对于多模态图像文本表示,作者选用了 CLIP 模型;然后作者提出了两个模块来进行视频帧和视频语言关系的时间建模,即时间差分块(Temporal Difference Block,TDB)和时间对齐块(Temporal Alignment Block,TAB)。TDB 能够用视频帧的差分来模拟运动变化,TAB 能够将视频序列和文本序列对齐到相同的空间中。

对于视频和文本的编码,作者采用了 CLIP 中预训练的 Transformer 编码器来进行信息的编码。然后作者将相邻的帧进行相减,得到差分的特征,并将其输入到时间 Transformer 中进行时间交互,获得最终的差分特征

![]()

然后作者将这些视觉帧特征和差分帧特征进行 concat,输入到 TAB 中和文本特征进行对齐,这部分的操作和《T2VLAD: Global-Local Sequence Alignment for Text-Video Retrieval》中的对齐操作相似,都是将视频和文本特征对齐到共享的聚类中心。最后基于局部对齐的特征和全局的特征进行相似度计算,得到最终文本和视频的相似度。

![]()

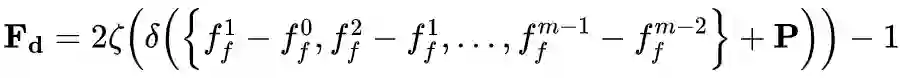

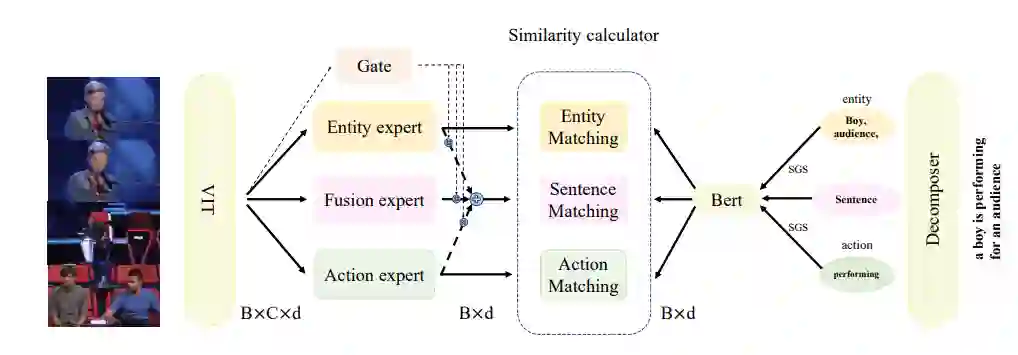

Improving Video-Text Retrieval by Multi-Stream Corpus Alignment and Dual Softmax Loss

https://arxiv.org/abs/2109.04290

https://github.com/starmemda/CAMoE

原始的检索中用到的单向 softmax 方法,忽略了视频和文本之间的潜在信息交互,因此作者提出了 Dual Softmax 来进行优化,方法简单,涨点明显。

![]()

上图展示了本文的 overview,视频(帧)和文本的特征分别通过 CLIP 中预训练的 ViT 和 BERT 进行提取,注意,这里作者将视频和文本的特征分成了三个部分,三个部分分别计算相似度。

![]()

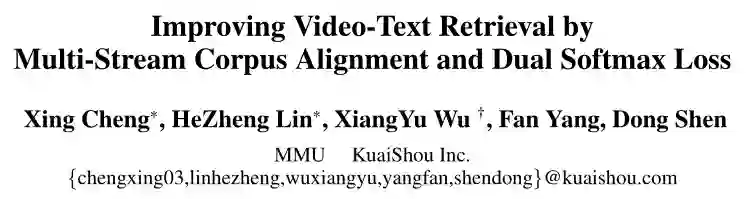

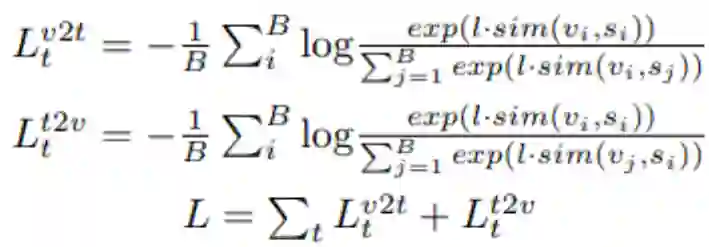

个人认为,本文的重点应该是在损失函数的部分,以往的损失函数如下所示:

![]()

就是按列取 softmax,再按行取 softmax,最后将对角线上的概率求和。

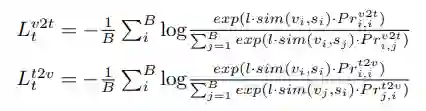

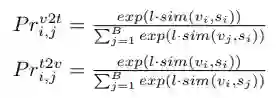

而本文不是这么做的,它的计算方式如下所示(也可以参考上图中红线所示):

![]()

![]()

它在计算“行”方向的概率之前,先进行“列”方向的 Softmax,然后将结果乘到原来的结果上,最后再这个乘积的结果上进行“行”方向的 Softmax,这样一来在进行 Softmax 的时候,就同时考虑了是图像对文本的相似度和文本对图像的相似度。反之亦然。从实验结果上看,这一操作简单,但是涨点明显。

2.6.1. 论文信息

![]()

论文标题:

VALUE: A Multi-Task Benchmark for Video-and-Language Understanding Evaluation

https://arxiv.org/abs/2106.04632

https://github.com/VALUE-Leaderboard/StarterCode

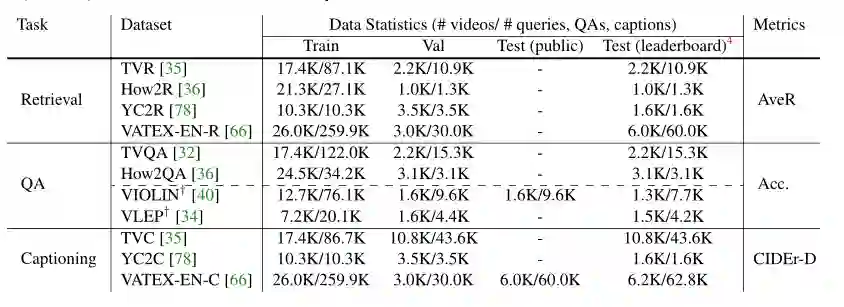

目前视频和语言的理解任务大多是在不同的数据集上进行评估的,很难衡量一个视频语言模型的综合性能。为此,作者提出了一个 VALUE 基准,这个基准包括了 11 个视频语言数据集,涵盖不同的视频类型、视频长度和数据量。

![]()

本文的主要贡献就是提出了一个 benchmark,上表展示了本文提出的 VALUE 基准的数据来源和任务类型。

![]()

论文标题:

HERO: Hierarchical Encoder for Video+Language Omni-representation Pre-training

https://arxiv.org/abs/2005.00200

https://github.com/linjieli222/HERO

2.7.2. 论文动机

目前的视频预训练模型大多数直接借鉴BERT的思想,将文本和视频帧的 concat 结果作为输入,失去了时间上的对齐,没有考虑视频帧的顺序信息,并且与目前的数据集达到是烹饪或者教学视频,不包括动态场景和复杂社会互动的视频。

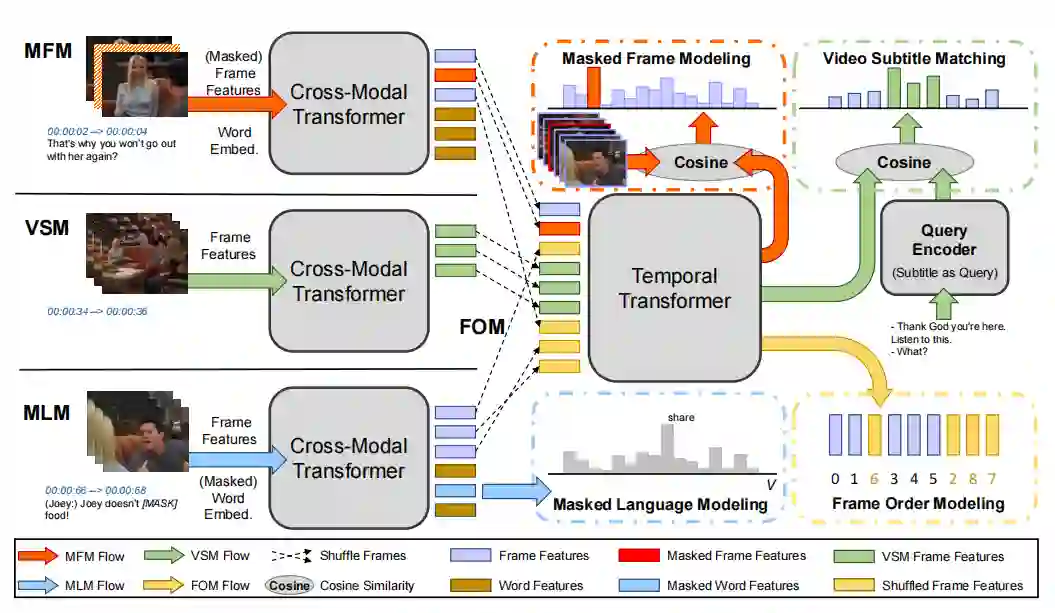

在本文中,作者没有采用 BERT 形式的编码器,而是以一种分层的形式对多模态信息进行编码:首先用跨模态 Transformer 来融合字幕句子及其相应的局部视频帧;然后时间 Transformer 使用所有周围的帧作为全局上下文,来获取每个视频帧的顺序上下文嵌入。然后作者基于四个预训练任务,对模型进了预训练。

2.7.3. 论文方法

![]()

本文的框架如上图所示,首先用跨模态 Transformer 来对每个视频帧和对应的字幕进行编码,然后再用时间 Transformer,对视频帧之间的时间信息进行建模。最后基于Masked Language Modeling、Masked Frame Modeling、Video-Subtitle Matching 和 Frame Order Modeling 四个预训练任务进行训练,以获得视频和文本表示。

2.8.1. 论文信息

![]()

HiT: Hierarchical Transformer with Momentum Contrast for Video-Text Retrieval

论文地址:

https://arxiv.org/abs/2103.15049

代码地址:

2.8.2. 论文动机

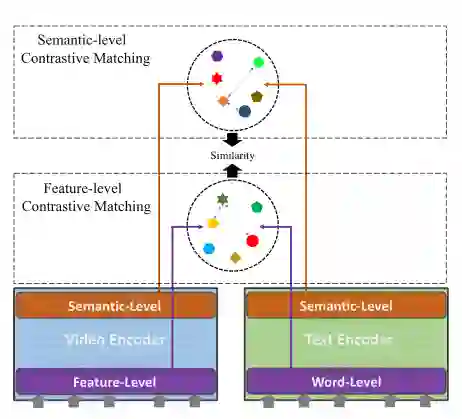

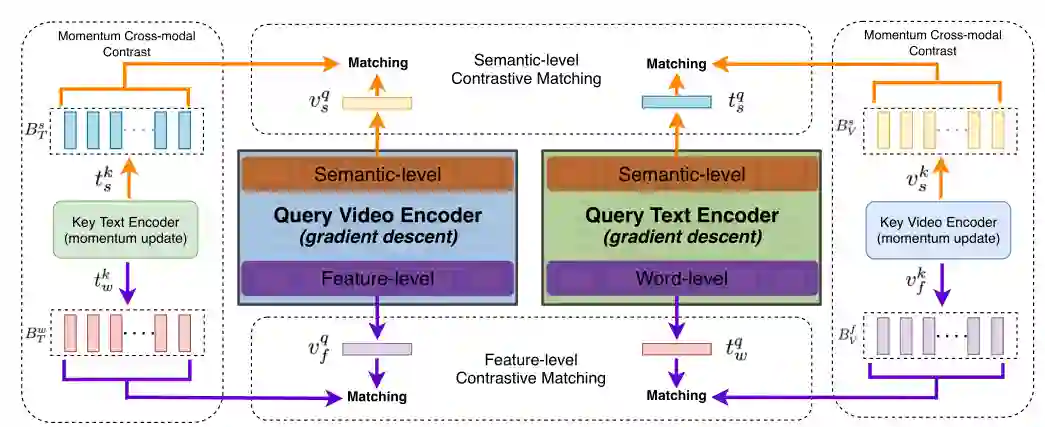

目前的跨模态 Transformer 存在两个方面的局限性:第一,Transformer 中不同层的特征没有得到充分的挖掘;第二,端到端的训练机制限制了负样本的数量,从而影响了最终的性能。因此,在本文中,作者用了对比学习的思想,将底层和高层的视觉-文本特征进行对比,为了获得更多的对比样本,作者也创建了四个内存库,分别存储用于 key 和 query 的文本,视频负样本列表。

本文的模型结构如上图所示,对于视频,作者用不同预训练的“专家”提取特征后将其送入到 Query Video Encoder 中,对于文本,作者用预训练的 BERT 提取特征后将其送入到 Query Text Encoder。Key Video Encoder 和 Key Text Encoder 都采用动量的方式更新,以保持特征的稳定。然后作者对比了 Key 和 Query 中视频-文本相似度,为了获得更多的负样本,作者维护了四个内存库,分别用于维护 key 和 query 的文本,视频负样本列表。

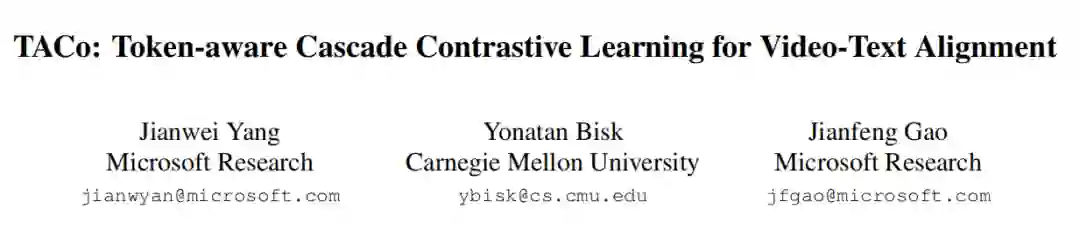

论文标题:

TACo: Token-aware Cascade Contrastive Learning for Video-Text Alignment

https://arxiv.org/abs/2108.09980

未开源

2.9.2. 论文动机

在这篇文章中,作者提出了 token 感知级联对比学习用于视频文本检索,顾名思义,这篇文章的意思就是贡献点主要是两个:“token 感知”和“级联采样”。以前的对比方法通常是基于句子-视频级别的对比,这样的对比太粗粒度了,因此作者就将提出了 token 级别的感知,进行细粒度的对比;第二点是多模态融合层如果对所有的负样本进行融合会导致计算效率低下的问题,因此作者提出了一种方法,能够在不增加额外计算量的情况下,采样负样本。

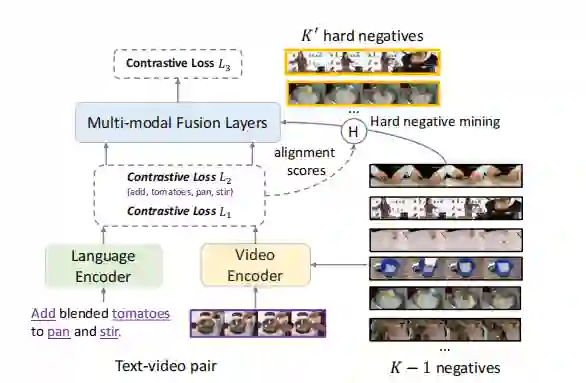

2.9.3. 实现方法

如上图所示,本文的方法有三个损失函数:L1 是句子级别的对比损失,L2 是 token 级别的对比损失,L3 是融合之后的对比损失。对于 token 级别的损失函数,作者采用了名词和动态和所有帧进行对比,因为作者通过实验发现,这样的效果最好。另外,如果对所有负样本在多模态融合层进行融合的话,就会导致太大的计算量。因此,作者提出了使用 L1 和 L2 中计算的相似度来进行负样本的级联采样。

总结

目前,关于视频方面的研究正在非常火热的进行着,也取得了一定的成功。然而相较于图片数据,视频数据的标注更加困难和昂贵,传统的基于下游数据集进行训练的模型局限性很大。

也正因此,目前有一些研究者将 CLIP 这个图文预训练模型迁移到视频-文本检索任务中,并且也取得了非常好的实验结果(秒杀之前的方法)。因此,在将来的研究,如何将预训练的知识迁移到视频任务中,或者如何基于未标注的视频数据进行训练,将会是一个非常有意义同时也非常具有挑战性的方向!

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

![]()

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()