【学界】谷歌推出“流体标注”AI辅助工具,图像标注速度提升3倍!(附论文)

来源:Google AI blog

来源:Google AI blog

编译:大明

【导读】谷歌在其AI博客上介绍了一款基于AI和深度学习的图像标注方式“流体标注”,可作为人工标注者的有力辅助工具,将标记数据集的生成速度提升至现在的3倍,有望缓解目前机器学习研究中,高质量的训练数据获取难的瓶颈。

基于深度学习的现代计算机视觉模型(比如由TensorFlow对象检测API实现的模型)的性能取决于是否可以使用规模越来越大的标记训练数据集(如公开的图像)进行训练。

然而,如何获得高质量的训练数据,正迅速成为计算机视觉领域的主要瓶颈。这对于自动驾驶、机器人和图像搜索等应用中使用的语义分段的像素预测任务而言尤其如此。

实际上,传统的手动数据标记工具,需要标记者仔细点击图象边界,来划定图像中的每个对象,这很乏味:在COCO + Stuff数据集中,标记一个图像需要19分钟,而标记整个数据集需要53000小时!

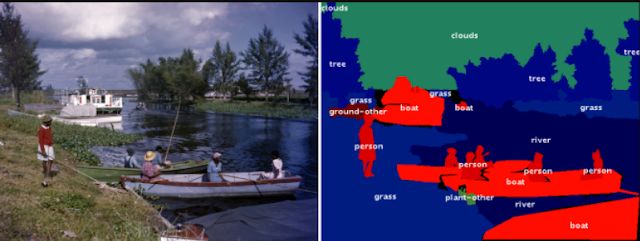

COCO数据集中的图像示例(左)及其逐像素语义标记(右)。图片来源:Florida Memory

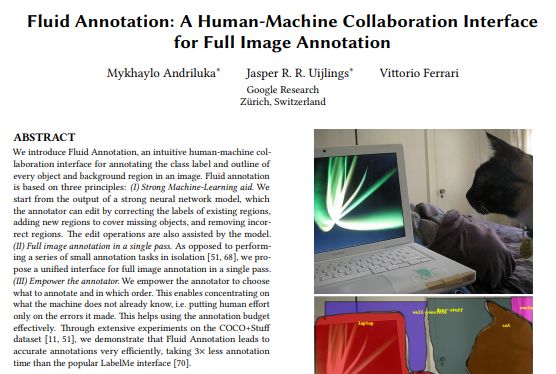

本文中的内容将在2018年ACM多媒体会议“勇敢新理念”环节中展示,谷歌的研究人员研究了一种机器学习驱动的界面,可用于标注分类数据,划定图像中每个目标的轮廓和背景,让标记数据集的生成速度提高至原来的3倍。

该工具名为流体标注(Fluid Annotation),从强语义分割模型的输出开始,人工标记者可以使用自然用户界面,通过机器辅助编辑操作进行修改。谷歌此次开发的界面可以让标记者选择要修改的内容和顺序,使他们能够高效地将精力集中在机器尚不了解的内容上。

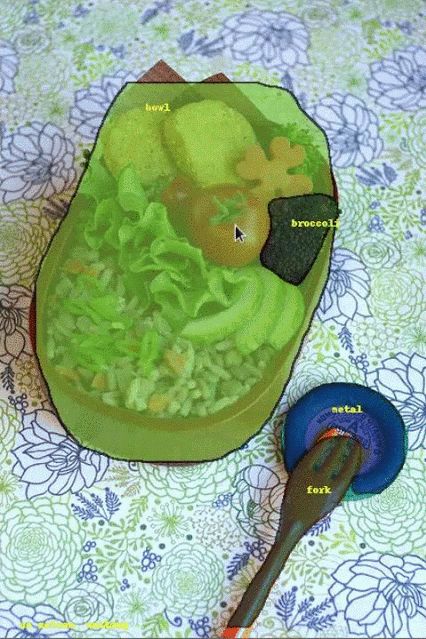

对COCO数据集中图像使用流体标注界面的可视化。图片来源:gamene

更确切地说,为了对图像进行标记,我们首先通过预训练的语义分割模型(Mask-RCNN)来处理图像。这会生成约1000个图像片段及其分类标签和置信度分数。置信度分数最高的片段用于对标签的初始化,呈现给标记者。

然后,标记者就可以:(1)从机器生成的候选标签中为当前片段选择标签。(2)对机器未覆盖到的对象添加分割段。机器会识别出最可能的预生成段,标记者可以从中选择质量最高的一个。(3)删除现有段。(4)改变重叠段的深度顺序。(Demo链接在此:https://fluidann.appspot.com/,仅限桌面平台)

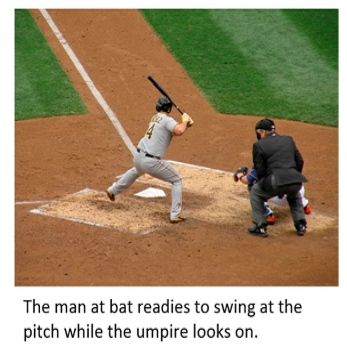

使用传统手动标记(中列)和流体标注(右)在COCO数据集的三张图像上进行标记的比较。虽然使用手动标记工具时,目标的边界一般更准确,但标记差异的最大原因是人类标记者通常对某一确切的对象分类有不同意见。来源:sneaka(上),Dan Hurt(中),Melodie Mesiano(下)。

流体标注是让图像标注变得更快、更容易的第一步探索。未来的目标是改进对目标边界的标记,进一步利用机器智能提升界面的速度,最终实现对界面的扩展,能够处理以前无法识别的分类,实现最高效、需求最大的数据收集。

而实际上,关于这款工具的论文的预印本早在近一个月前就发在了arxiv上。

论文地址:

https://arxiv.org/pdf/1806.07527

参考链接:

https://ai.googleblog.com/2018/10/fluid-annotation-exploratory-machine.html

☞ OpenPV平台发布在线的ParallelEye视觉任务挑战赛

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【学界】Ian Goodfellow等人提出对抗重编程,让神经网络执行其他任务

☞【学界】六种GAN评估指标的综合评估实验,迈向定量评估GAN的重要一步

☞【资源】T2T:利用StackGAN和ProGAN从文本生成人脸

☞【学界】 CVPR 2018最佳论文作者亲笔解读:研究视觉任务关联性的Taskonomy