参考文献

[1] Chen M, Beutel A, Covington P, et al. Top-k off-policy correction for a REINFORCE recommender system[C]//Proceedings of the Twelfth ACM International Conference on Web Search and Data Mining. 2019: 456-464.

[2] Chen X, Li S, Li H, et al. Generative adversarial user model for reinforcement learning based recommendation system[C]//International Conference on Machine Learning. PMLR, 2019: 1052-1061.

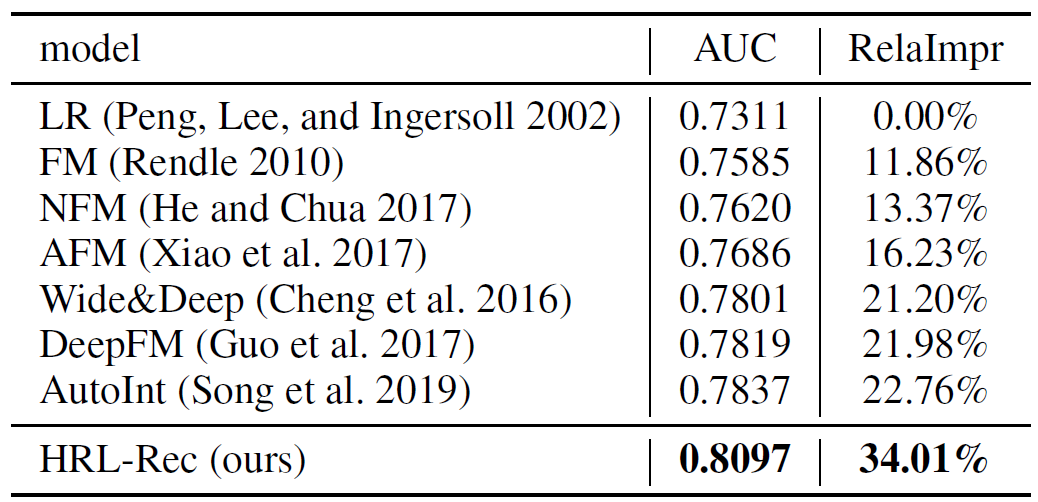

[3] Cheng H T, Koc L, Harmsen J, et al. Wide & deep learning for recommender systems[C]//Proceedings of the 1st workshop on deep learning for recommender systems. 2016: 7-10.

[4] Guo H, Tang R, Ye Y, et al. DeepFM: a factorization-machine based neural network for CTR prediction[J]. arXiv preprint arXiv:1703.04247, 2017.

[5] Hidasi B, Karatzoglou A, Baltrunas L, et al. Session-based recommendations with recurrent neural networks[J]. arXiv preprint arXiv:1511.06939, 2015.

[6] Ie E, Jain V, Wang J, et al. Reinforcement learning for slate-based recommender systems: A tractable decomposition and practical methodology[J]. arXiv preprint arXiv:1905.12767, 2019.

[7] Lillicrap T P, Hunt J J, Pritzel A, et al. Continuous control with deep reinforcement learning[J]. arXiv preprint arXiv:1509.02971, 2015.

[8] Mnih V, Badia A P, Mirza M, et al. Asynchronous methods for deep reinforcement learning[C]//International conference on machine learning. PMLR, 2016: 1928-1937.

[9] Song W, Shi C, Xiao Z, et al. Autoint: Automatic feature interaction learning via self-attentive neural networks[C]//Proceedings of the 28th ACM International Conference on Information and Knowledge Management. 2019: 1161-1170.

[10] Zhang J, Hao B, Chen B, et al. Hierarchical reinforcement learning for course recommendation in MOOCs[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2019, 33(01): 435-442.

[11] Zhao D, Zhang L, Zhang B, et al. MaHRL: Multi-goals Abstraction Based Deep Hierarchical Reinforcement Learning for Recommendations[C]//Proceedings of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. 2020: 871-880.

[12] Zhao X, Xia L, Zhang L, et al. Deep reinforcement learning for page-wise recommendations[C]//Proceedings of the 12th ACM Conference on Recommender Systems. 2018: 95-103.