厦大最新《强化学习推荐系统》综述论文

推荐系统如何使用强化学习一直是个难题。最近,来自厦门大学的研究人员发布了《基于强化学习的推荐系统》综述论文,详细阐述了强化学习推荐系统的问题、方法、挑战等。

引言

个性化推荐系统能够提供符合用户喜好的有趣信息,从而有助于缓解信息过载问题。在过去的二十年中,人们对推荐系统进行了广泛的研究,开发了许多推荐方法。这些方法通常根据用户的喜好、商品特征和用户与商品的交互来进行个性化的推荐。一些推荐方法还利用其他附加信息,如用户之间的社会关系(例如,社会推荐)、时间数据(例如,顺序推荐)和位置感知信息(例如,POI(“兴趣点”的缩写)推荐。

推荐技术通常利用各种信息为用户提供潜在的项目。在现实场景中,推荐系统根据用户与商品的交互历史进行商品推荐,然后接收用户反馈进行进一步推荐。也就是说,推荐系统的目的是通过交互获取用户的偏好,并推荐用户可能感兴趣的项目。为此,早期的推荐研究主要集中在开发基于内容和基于协同过滤的方法。矩阵分解是传统推荐方法中最具代表性的方法之一。近年来,由于深度学习的快速发展,各种神经推荐方法被开发出来。然而,现有的推荐方法往往忽略了用户与推荐模型之间的交互。它们不能有效地捕捉到用户的及时反馈来更新推荐模型,往往导致推荐结果不理想。

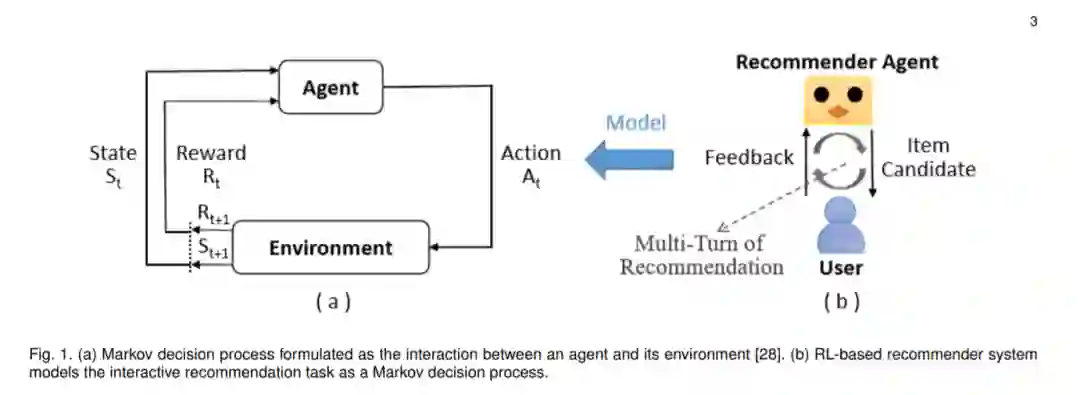

一般来说,推荐任务可以建模为这样一个交互过程——用户被推荐一个商品,然后为推荐模型提供反馈(例如,跳过、点击或购买)。在下一次交互中,推荐模型从用户的显式/隐式反馈中学习,并向用户推荐一个新项目。从用户的角度来看,高效的交互意味着帮助用户尽快找到准确的商品。从模型的角度看,有必要在推荐的多轮中平衡新颖性、相关性和多样性。交互式推荐方法已成功应用于现实世界的推荐任务中。然而,该方法经常遇到一些问题,如冷启动和数据稀疏,以及挑战,如可解释性和安全性。

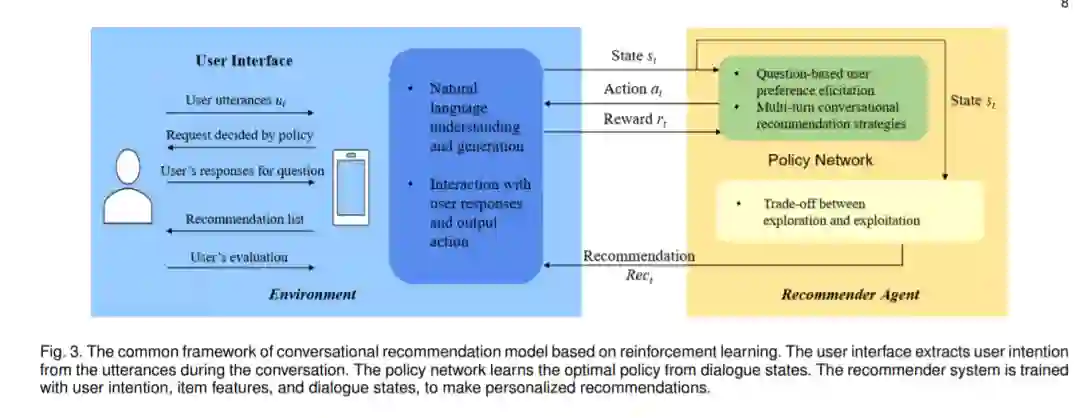

作为一个机器学习领域,强化学习(RL)专注于智能代理如何与环境交互,提供了潜在的解决方案来模拟用户和代理之间的交互。最近RL的成功推动了人工智能,的研究。特别是,深度强化学习(DRL)具有强大的表示学习和函数逼近特性,可以解决人工智能的挑战。它已被应用于各个领域,如游戏,机器人,网络。近年来,应用RL解决推荐问题已成为推荐研究的一个新趋势。具体来说,RL使推荐代理能够不断地与环境(例如,用户和/或记录的数据)交互,以学习最佳推荐策略。在实践中,基于RL的推荐系统已经被应用到许多特定的场景中,如电子商务、电子学习、电影推荐、音乐推荐、新闻推荐、工作技能推荐、医疗保健、能量优化等。

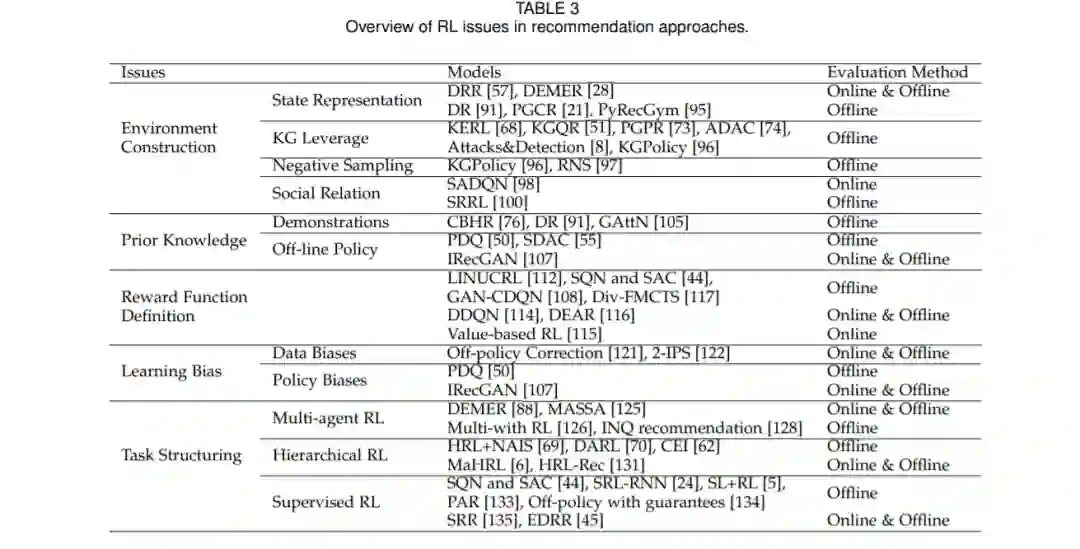

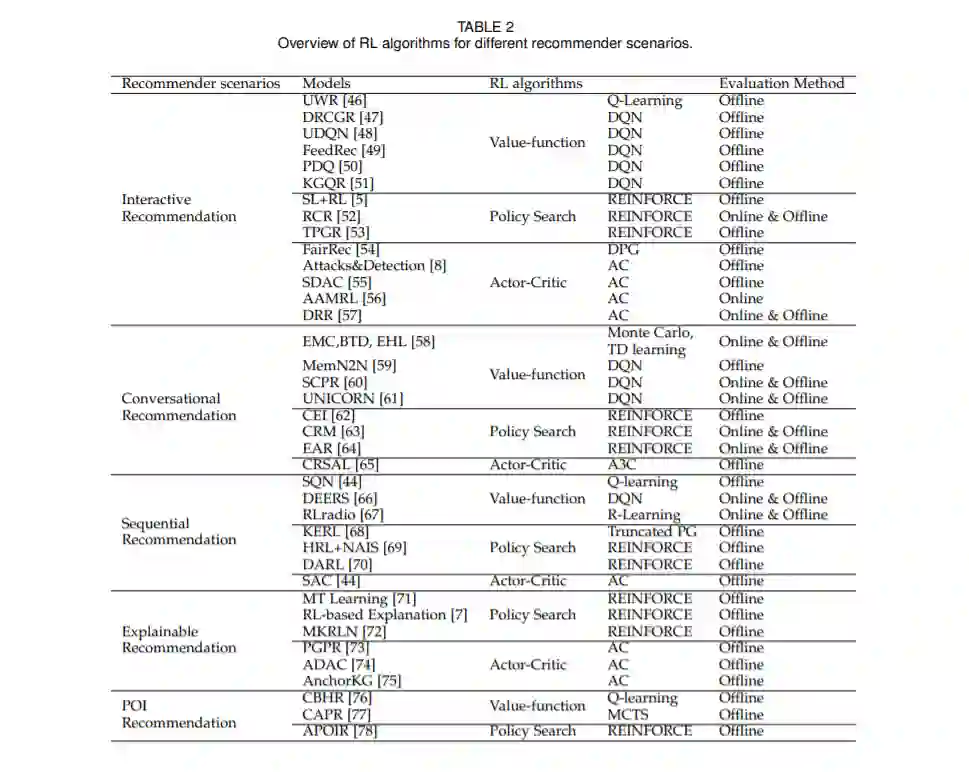

为促进基于RL的推荐系统的研究,本文总结了现有的推荐问题的相关解决方案,系统分析了在推荐方法中应用RL所面临的挑战,并探讨了未来潜在的研究方向。本文从理论研究的角度,回顾了已有的研究工作,包括环境构建、先验知识、奖励函数定义、学习偏差和任务构建。环境建设可以缓解勘探开发的取舍。先验知识和奖励定义是进行推荐决策的关键。此外,任务结构化可以很好地解决维度的诅咒。从应用的角度,我们还提供了基于RL的推荐系统的全面调研,分别遵循价值函数、策略搜索和演员评论。值得注意的是文献还提供了对基于RL和DRL的推荐算法的回顾,并在推荐列表、架构、可解释性和评估方面提出了几个研究方向。文献主要从基于模型的方法和无模型的算法两方面对基于drl的推荐系统进行了概述,并重点介绍了基于drl的推荐中一些有待解决的问题和新兴的课题。与现有文献不同的是,我们根据其他分类算法(即价值函数、策略搜索和角色-评论)概述了现有的(D)RL推荐方法,并分析了在推荐系统中应用(D)RL的挑战。

本工作的主要贡献如下:

-

我们全面回顾了为五种典型推荐方案开发的RL方法。对于每个推荐场景,我们提供了有代表性的模型的详细描述,总结了文献中使用的具体RL算法,并进行了必要的比较。 我们系统地分析了在推荐系统中应用RL所面临的挑战,包括环境构建、先验知识、奖励函数定义、学习偏差和任务构建。

我们还讨论了RL的开放问题,分析了该领域的实际挑战,并提出了未来可能的研究和应用方向。

本文的其余部分结构如下。第2节介绍了RL的背景,定义了相关的概念,列出了常用的方法。第三节给出了基于RL的推荐方法的标准定义。第4节全面回顾了为推荐系统开发的RL算法。第五部分讨论了在推荐系统中应用RL所面临的挑战和相应的解决方案。接下来,第6节讨论了基于RL的推荐系统的各种限制和潜在的研究方向。最后,第7节总结了本研究。