谷歌的AI将乌龟认成步枪,这为何是个大问题

硅谷Live / 实地探访 / 热点探秘 / 深度探讨

AI眼睛还可不可信?

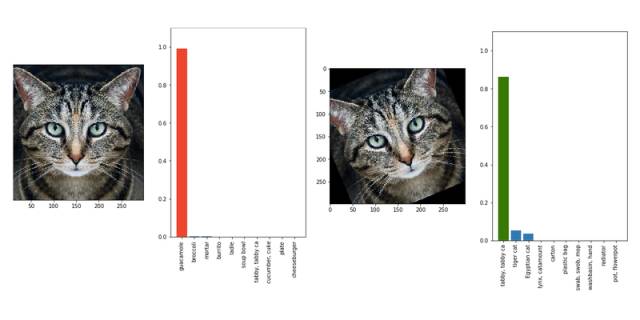

从无人车到智能监视器,社会正在缓慢地相信AI或许真的可以代替人眼。但是虽然我们的机器眼看起来永不疲倦,他们也绝不是完美的。看看下图,你看见的是不是一只乌龟?但是,谷歌训练出来的一个神经网络却不是这么想的。对它来说,这张图里是一只来复枪。

这个 3D 打印出来的乌龟是一个“对抗性图像。”在 AI 的世界,这些图形是被精心设计来欺骗机器视觉软件的,它们都含有特定的特征使得 AI 系统无法正常识别。你可以将他们想成是计算机的视觉幻象。你可以制作一个“对抗性眼镜”,从而使得脸部识别系统将你认成其他人,又或者将一层几乎不可见的对抗性图案附加到被识别图形上。人们无法分出这些图形的区别,但是对 AI 来说,这意味着一只熊猫瞬间变成了大货车。

生成和抵抗这种对抗性攻击是在蓬勃发展的研究领域。要声明的是,虽然这些攻击看起来极其有效,但是并不是毫无弱点。这意味着如果你将对抗性图像旋转角度或是将某个部分放大,计算机就可以看出“对抗性图案”的蹊跷并且准确识别图形。为什么这个 3D 打印的乌龟很重要呢?是因为它表明对抗性攻击可以在 3D 世界中进行,成功骗过从不同角度监视的电脑。

“具体来说,这意味着某些人可以制作出在人类看来完全正常的公告牌,但对于无人车来说它们就变成了突然出现在街边的行人。” Labsix,发表此项研究的 MIT 团队的学生之一。“这些例子在神经网络应用越来越广泛的今天足以引起人们的忧虑。”

Labsix 将他们的新方法称为“转变预期 Expectation Over Transformation 。”除了制作出这个看起来像来福手枪的乌龟,他们还制作出了一个被认成咖啡的棒球。这个团队在谷歌开发的图像分类器 Inception-v3 上进行了测试。这个分类器对开发者们免费开放,供其测试。虽然他们还没有在其他机器视觉软件上进行测试,但是我们至今还没有有效地对抗这一攻击的万灵药。而虽然谷歌官方并未对这篇论文发表任何意见,一位发言人则向我们介绍了一些最近由其研究员发表的一系列讨论如何抵御组织对抗性攻击的论文。

当然,这一研究也受到了一些质疑。首先,这个团队自己承认他们所说的对抗性攻击可以在任意角度生效这个论点并不严谨。事实上,他们的展示录像显示,虽然他们可以在大多数角度欺骗计算机,但是不是所有角度都能成功。其次,Labsix 需要了解谷歌视觉的算法来发现其弱点并欺骗它。而对于大多数算法处于保密状态的系统来说攻击难度大大增加。但是,已经有一些其他的对抗性攻击在完全不知道算法的情况下成功,据可靠消息,Labsix 的团队接下来也将向这一方向进行进一步的研究。

对抗性攻击还不会对公众形成巨大的影响。他们是很有效,但是是在相对局限的情况下。虽然机器视觉在现实世界中越来越普遍,可我们还未完全依赖它们。而我们应该从这一试验中得到的经验是,一些 AI 系统可以有多么的脆弱。如果我们现在不去解决这些问题,他们就会在未来导致更大的问题。

本文编译自 The Verge。

在2018年1月9日18:30(PST),腾讯将在美国拉斯维加斯凯撒宫酒店,举办“对话 探索与众创合作——腾讯众创空间+腾讯AI加速器CES之夜晚宴”。诚挚邀请您参加!详情请点击"阅读原文"

推荐阅读