神经网络反向传播的数学原理

本文原作者李飞腾,本文整理自知乎专栏——数字编程。AI 研习社已获得转载授权。

如果能二秒内在脑袋里解出下面的问题,本文便结束了。

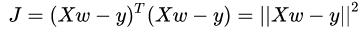

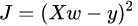

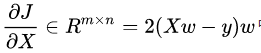

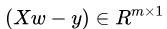

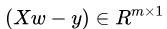

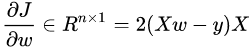

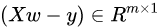

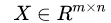

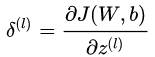

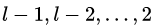

已知:

,其中

。

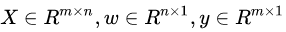

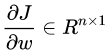

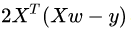

求:

。

到这里,请耐心看完下面的公式推导,无需长久心里建设。

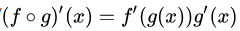

首先,反向传播的数学原理是 “求导的链式法则” :

设

接下来介绍

矩阵、向量求导的维数相容原则

利用维数相容原则快速推导反向传播

编程实现前向传播、反向传播

卷积神经网络的反向传播

快速矩阵、向量求导

这一节展示如何使用链式法则、转置、组合等技巧来快速完成对矩阵、向量的求导

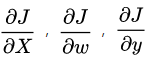

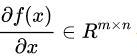

一个原则维数相容,实质是多元微分基本知识,没有在课本中找到下列内容,维数相容原则是我个人总结:

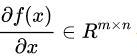

维数相容原则:通过前后换序、转置 使求导结果满足矩阵乘法且结果维数满足下式:

如果

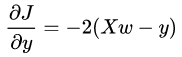

利用维数相容原则解上例:

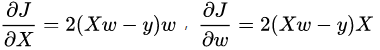

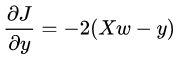

step1:把所有参数当做实数来求导,

依据链式法则有

可以看出除了

step2:根据 step1 的求导结果,依据维数相容原则做调整:前后换序、转置

依据维数相容原则

同理:

对于矩阵、向量求导:

“当做一维实数使用链式法则求导,然后做维数相容调整,使之符合矩阵乘法原则且维数相容” 是快速准确的策略;

“对单个元素求导、再整理成矩阵形式” 这种方式整理是困难的、过程是缓慢的,结果是易出错的(不信你试试)。

如何证明经过维数相容原则调整后的结果是正确的呢?直觉!简单就是美...

快速反向传播

神经网络的反向传播求得 “各层” 参数

接下来,展示不使用下标的记法(

这里的标号,参考 UFLDL 教程 - Ufldl(http://t.cn/zTOSOPP)

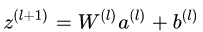

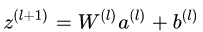

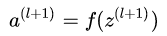

前向传播:

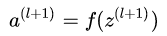

设神经网络的损失函数为

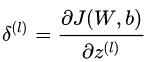

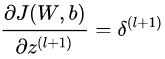

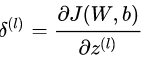

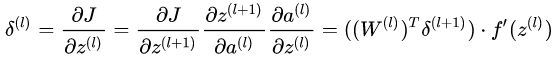

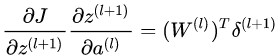

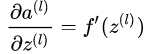

这里记

如何求

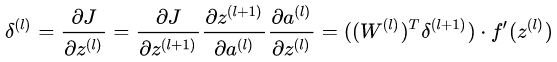

那么我们可以从最顶层逐层往下,便可以递推求得每一层的

注意:

反向传播整个流程如下:

1) 进行前向传播计算,利用前向传播公式,得到隐藏层和输出层 的激活值。

2) 对输出层 (第

3) 对于

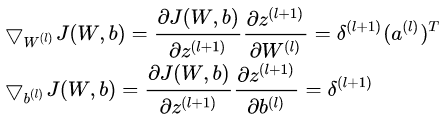

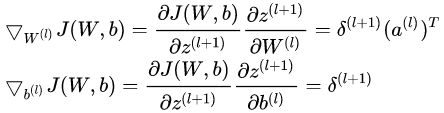

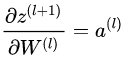

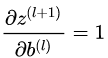

4) 计算各层参数

编程实现

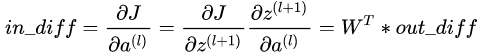

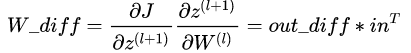

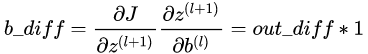

大部分开源 library(如:caffe,Kaldi/src/{nnet1,nnet2})的实现通常把

反向传播时分清楚该层的输入、输出即能正确编程实现, 如:

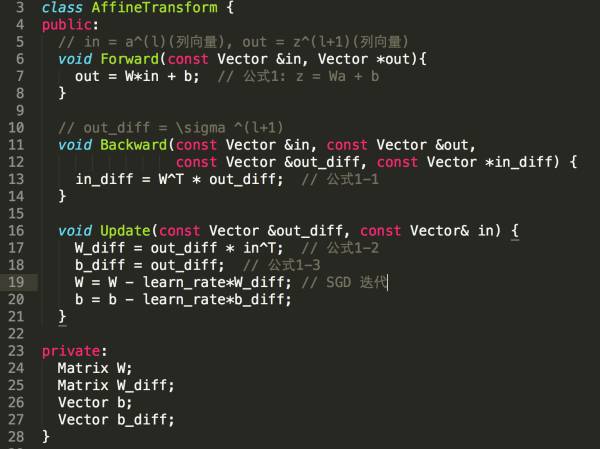

(1) 式 AffineTransform/FullConnected 层,以下是伪代码:

注: out_diff =

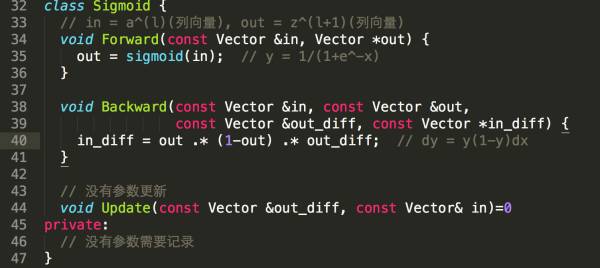

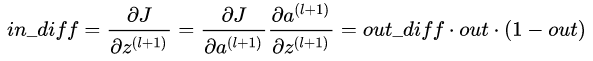

(2) 式激活函数层(以 Sigmoid 为例)

注:out_diff =

如果熟悉 SVD 分解的过程,通过 SVD 逆过程就可以轻松理解这种通过乘积来做加和的技巧。

丢掉那些下标记法吧!

卷积层求导

卷积怎么求导呢?实际上卷积可以通过矩阵乘法来实现(是否旋转无所谓的,对称处理,caffe 里面是不是有 image2col),当然也可以使用 FFT 在频率域做加法。

那么既然通过矩阵乘法,维数相容原则仍然可以运用,CNN 求导比 DNN 复杂一些,要做些累加的操作。具体怎么做还要看编程时选择怎样的策略、数据结构。

快速矩阵、向量求导之维数相容大法已成。

新人福利

关注 AI 研习社(okweiwu),回复 1 领取

【超过 1000G 神经网络 / AI / 大数据,教程,论文】

深度学习要另起炉灶,彻底抛弃反向传播?

▼▼▼