超越bounding box的代表性点集:视觉物体表示的新方法

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。点击文末“阅读原文”立刻申请入群~

作者 | Ze Yang、Shaohui Liu、Han Hu、Liwei Wang、Stephen Lin

转自 | 机器之心

目前,Bounding Box(即包含物体的一个紧致矩形框)几乎主导了计算机视觉中对于物体的表示,其广泛流行得益于它简便且方便物体特征提取的特点,但另一方面也限制了对物体更精细的定位和特征提取。

近日,来自北大、清华和微软亚研的研究者们提出了一种新的视觉物体表示方法,称作 RepPoints(representative points,代表性点集),这种方法能更精细地描述物体的几何位置和进行图像特征的提取,同时也兼有简便和方便特征提取的特点。利用这种表示,很自然能得到一个 anchor-free 的物体检测框架,取得了和目前 anchor-based 方法可比的性能。

论文:RepPoints: Point Set Representation for Object Detection

论文地址:https://arxiv.org/abs/1904.11490

目前,与物体相关的视觉研究几乎占了半壁江山,在工业界更是如此,大部分应用都依赖于提取物体位置后的进一步分析。在这些应用和研究中,如何表示物体尤其重要。一直以来,bounding box 是表示视觉物体最常用的方法,它的流行得益于简便的形式,便于提取物体特征(RoIAlign 方法)的特点,以及与物体检测任务的标注和评测一致。

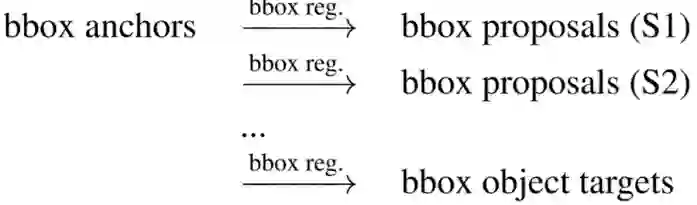

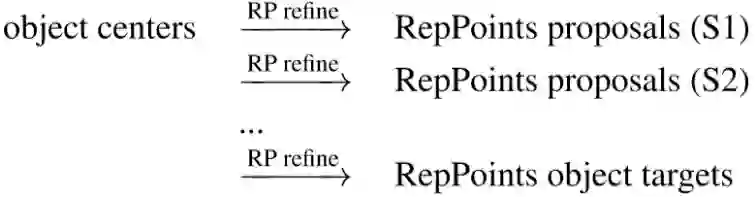

具体到在物体检测中的应用,举目前表现最好的多阶段物体检测算法为例,基于 bounding box 的物体表示出现在多个阶段,从初始阶段的锚点(anchors),到中间的候选框(proposals),再到最终的定位框,都是基于 bounding box,可以说无处不在:

总的来说,基于 bounding box(bbox)的多阶段物体检测是一个定位越精确,进而特征提取越精确,而这又反过来帮助更精确定位的迭代过程。尽管如此,bbox 总的来说受限于矩形框的形式其始终是一个比较粗糙的表示,基于 bbox 的物体特征提取也无法很精细。

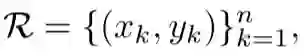

这篇论文提出了一种新的物体表示方法,用一个代表性点集来表示物体,称作 RepPoints (representative points):

这种新的表示方法能更自由地刻画物体丰富的姿态视角等的形态,利于更精细的几何定位和更精细地物体特征提取,如下图所示。

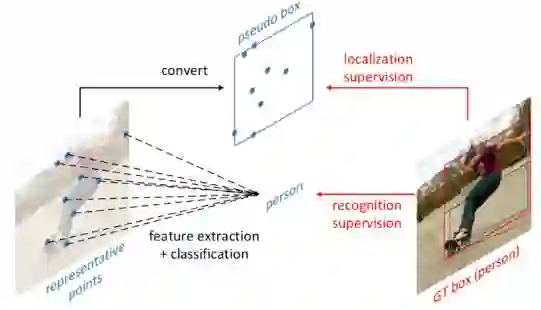

当替换物体检测框架中所有的 bounding box 表示时,我们得到如下的物体表示变化过程:

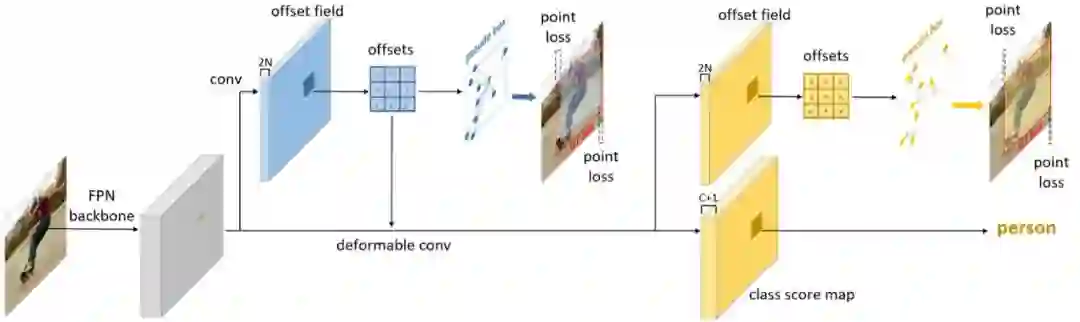

遵循这一过程的物体检测器很自然是一个 anchor-free 的检测框架(object centers 是一种特殊的 RepPoints):

这一 anchor-free 的检测器设计还与同期的一些基于 anchor-free 的检测方法不谋而合,例如 FCOS,FoveaBox,FSAF,CenterNet 等等,他们都发现 anchor-free 方法相比 anchor-based 方法也能取得不错的效果了。

这篇论文对 anchor-free 方法的优点作了一些解释,它认为 anchor-free 方法和 anchor-based 方法的本质区别在于表示物体的维度不一样,anchor-free 方法把物体看作二维的点,而 anchor-based 方法把物体看做四维的矩形框,从这个角度看,anchor-free 方法和 single anchor 方法都是有区别的。

由于 anchor-free 方法将物体看做二维的点,从而使得搜索空间大大降低,在初始表示的时候很容易基本覆盖所有的真实物体,而 anchor-based 方法将物体看做四维的矩形框,从而通常需要很多个锚点才能大致覆盖所有真实物体。这篇论文还认为 FPN 是促成 anchor-free 方法重新取得成功的重要关键,另外,RepPoints 这种灵活的表示方法也起到了部分帮助。

如下是论文的一些主要结果:

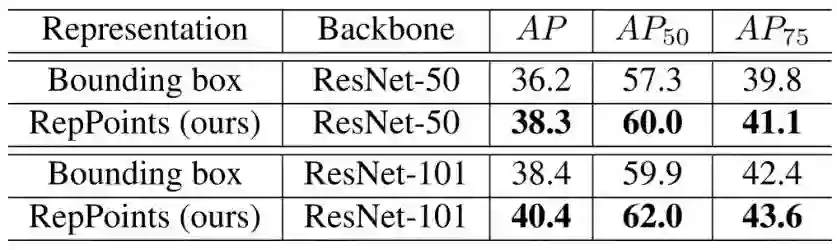

a) 和 bbox 表示方法的比较

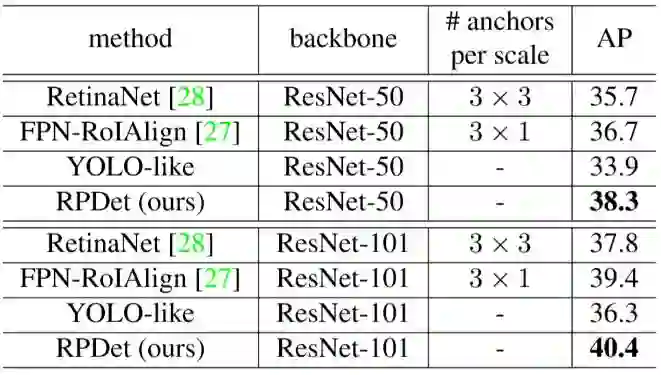

b) 和其他 anchor-free 和 anchor-based 方法的比较(相同 backbone)

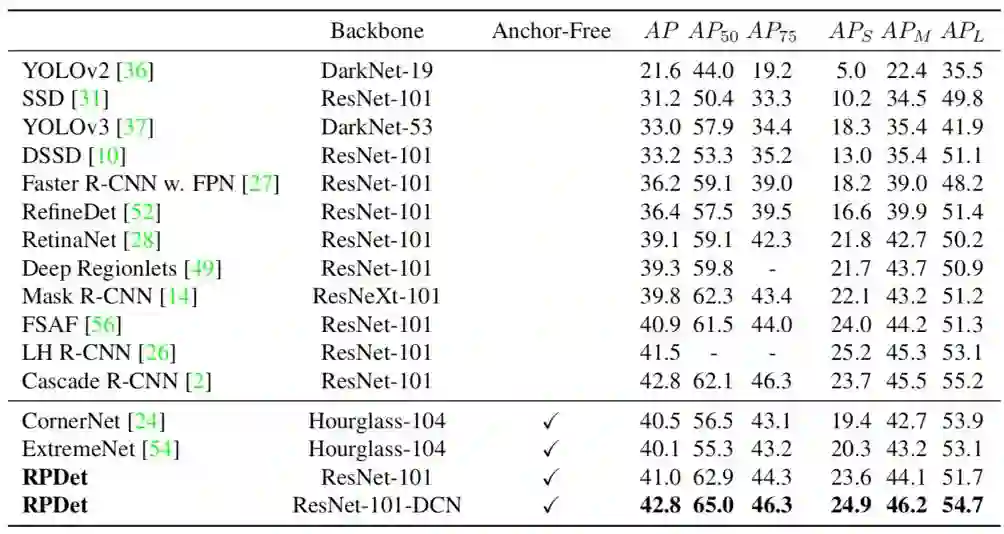

c) 系统级比较(RPDet 没有多尺度训练和测试,AP50 上表现尤其好)

d) 可视化学到的 RepPoints,主要位于物体的极值点(extreme points)和有语义的点

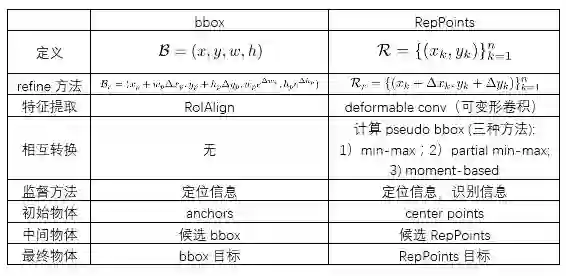

最后用下表总结 bounding box 和 RepPoints 在物体表示上的联系和区别:

*延伸阅读

点击左下角“阅读原文”,即可申请加入极市目标跟踪、目标检测、工业检测、人脸方向、视觉竞赛等技术交流群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

觉得有用麻烦给个好看啦~