【泡泡一分钟】基于点和体积融合的动态场景实时三维重建

每天一分钟,带你读遍机器人顶级会议文章

标题:A Maximum Likelihood Approach to Extract Polylines

from 2-D Laser Range Scans

作者:Alexander Schaefer, Daniel Büscher, Lukas Luft, Wolfram Burgard

来源:2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

编译:王丹

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

使用Kinect或Xtion等低成本商品传感器进行实时3D重建已成功应用于增强现实,机器人遥操作和医疗诊断等广泛领域。由于静态场景的假设,诸如KinectFusion、KinFu等流行的3D重建技术,发现用快速运动摄像机进行真实重建或分割运动物体是一个挑战。在本文中,我们提出了一个加权迭代最近点(ICP)算法,该算法使用深度和RGB信息来提高相机跟踪的稳定性。另外,结合深度、法线和强度等级相似性标准的基于GPU的区域生长方法也被应用于准确地分割前景移动对象。为了实现实时处理和GPU的存储效率,我们设计了基于点的表示和体表示的组合来分别重建运动对象和静态场景。定性和定量结果均表明,本文提出的方法提高了摄像机跟踪和运动目标分割的实时性,降低了计算复杂度。

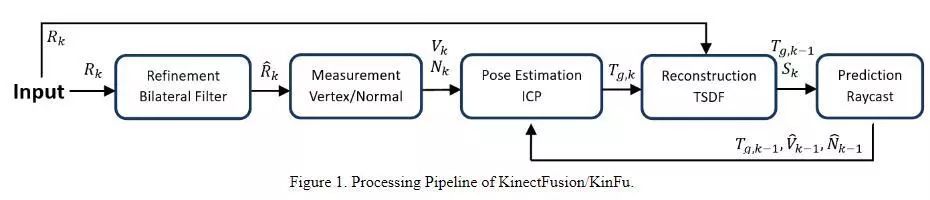

KinectFusion能够仅使用深度信息实时地对静态室内环境进行三维重建,具有五个主要的处理步骤,如图1所示,1)使用双边滤波器进行深度图细化。2)基于固有传感器矩阵的数据测量。3)ICP算法优化姿态估计。4)使用TSDF方法的表面重建。5)用于表面预测的光线投射。

图1 KinectFusion/KinFu的处理步骤

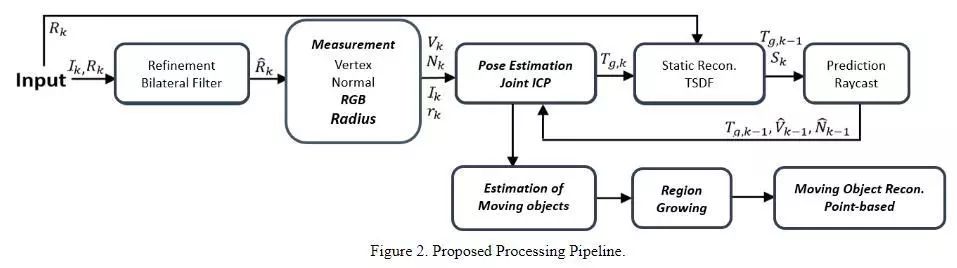

为了补偿深度测量中的系统误差,我们在几何姿态估计中为每个深度值分配一个权重指示器。考虑到相机运动较快时姿态估计的误差增大,用L1范数距离代替L2范数距离,降低了光度量优化的权重比。为了解决基于点的融合问题,我们将半径图和置信度计数器扩展到三维,并结合基于点的融合和体积表示来维持重建质量水平,同时减少处理时间和内存使用。我们还包括法线和强度贴图以及深度贴图作为相似属性,以提高区域生长方法的准确性,并在GPU上实现它以保持其处理速度。然后将基于点的动态部分重建与基于体素的静态背景重建相结合。将前景移动对象同时重建并逐帧地添加到全局模型中。

图2 所提方法的处理步骤

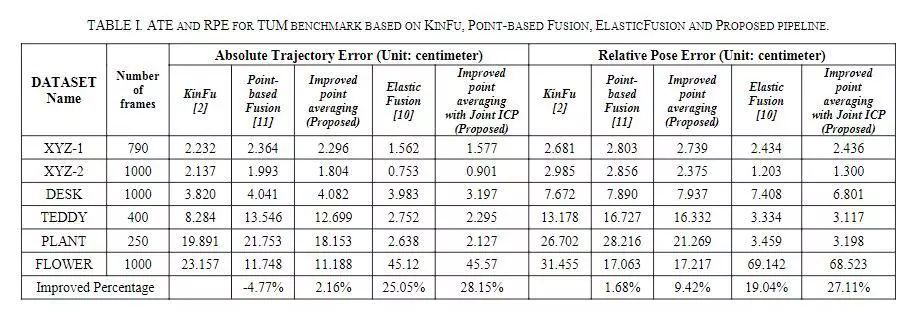

表1 KINFU,Point-based Fusion,ElasticFusion,本文方法在TUM数据集上的ATE,RPE比较

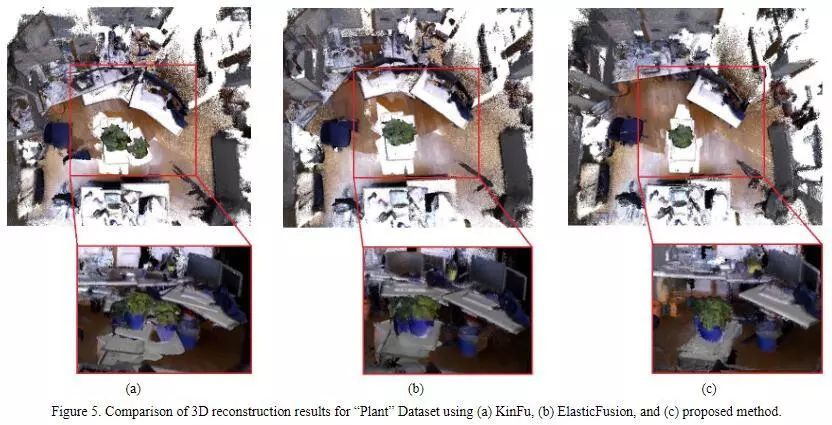

图3 (a)KinFu, (b) ElasticFusion和(c)本文方法在“Plant”数据集上的三维重建结果比较

Abstract

Real-time 3D reconstruction using low-cost commodity sensors like Kinect or Xtion has been successfully appliedin a wide rangeof fields like augmented reality, robotic teleoperation,and medical diagnosis. Due to the assumption of staticscene, popular 3D reconstruction technologies such as KinectFusion and KinFu, find truthful reconstruction with fast motion camera or segmenting a moving object to be a challenge. In this paper, we propose a weighted iterative closest point (ICP)algorithm that uses both depth and RGB informationto enhance the stability of camera tracking. Additionally,aGPU-based region growing methodthat combinesdepth, normaland intensity levelas similarity criteria, is also applied to segment foreground moving objectsaccurately. For real-time processing and GPU memory efficiency, we also designa combination of point-based and volumetric representation to reconstruct moving objectsand static scene, respectively. Both qualitative and quantitative results showthat our proposed method improves real-time 3D reconstruction on the performance of camera tracking and segmentation ofmoving objectswith reduced computational complexity.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com