最新《知识蒸馏》2020综述论文,30页pdf,悉尼大学

【导读】知识蒸馏是一种典型的模型压缩和加速方法,在很多应用场景对此有需求。来自悉尼大学的学者发布了《知识蒸馏》的综述论文,值的关注。

https://arxiv.org/abs/2006.05525

近年来,深度神经网络在工业和学术界取得了巨大的成功,特别是在视觉识别和神经语言处理方面的应用。深度学习的巨大成功,主要归功于其巨大的可扩展性,既有大规模的数据样本,也有数十亿的模型参数。然而,在资源有限的设备如移动电话和嵌入式设备上部署这些笨重的深模型也带来了巨大的挑战,不仅因为计算量大,而且存储空间大。为此,开发了各种模型压缩和加速技术,如剪枝、量化和神经结构搜索。知识蒸馏是一种典型的模型压缩和加速方法,旨在从大教师模型中学习小学生模型,越来越受到社会的关注。本文从知识分类、训练方案、知识提取算法以及应用等方面对知识提取进行了综述。此外,我们简要回顾了知识提炼的挑战,并对未来的研究课题提供了一些见解。

概述

在过去的几年里,深度学习在人工智能领域取得了巨大的成功,包括计算机视觉(Krizhevsky et al., 2012)、强化学习(Silver et al., 2016)和神经语言处理(Devlin et al., 2018)的各种应用。借助最近许多技术,包括残差连接(He et al., 2016)和批处理归一化(Ioffe and Szegedy, 2015),我们可以轻松地在强大的GPU或TPU集群上训练具有数千层的深度模型。例如,只需不到10分钟就可以在数百万张图像的数据集上训练ResNet模型(Deng et al. , 2009 ; Sun et al. , 2019); 训练一个强大的BERT模型进行语言理解只需要不到一个半小时 (Devlin et al., 2018; You et al., 2019).。虽然大规模的深度模型带来了令人难以置信的性能,但其庞大的计算复杂度和海量的存储需求给实时应用的部署带来了巨大的挑战,特别是对于那些资源有限的设备,比如嵌入式人脸识别系统和自动驾驶汽车。

为了开发高效的深度模型,最近的工作通常集中在1)基于深度可分离卷积的高效基本块,如MobileNets (Howard et al. , 2017 ; Sandler et al. , 2018) 和ShuffleNets (Zhang et al. , 2018a ; Ma et al. , 2018); (2)模型压缩和加速技术,主要包括以下类别(Cheng et al., 2018)。

参数修剪和共享: 这些方法主要是去除深层神经网络中不重要的参数,去除的参数对性能影响不大。该类别又分为模型量化(Wu et al., 2016)和二值化(Courbariaux et al., 2015)、参数共享(Han et al., 2015)和结构矩阵(Sindhwani et al., 2015)。

低秩分解: 这些方法通过矩阵/张量分解来探索深度神经网络参数的冗余性(Denton et al., 2014)。

传输/压缩卷积滤波器: 这些方法通过传输/压缩卷积滤波器来减少不必要的参数(Zhai et al., 2016)。

知识蒸馏(KD): 这些方法通常将知识从一个较大的深度神经网络提取到一个较小的网络中(Hinton et al., 2015)。

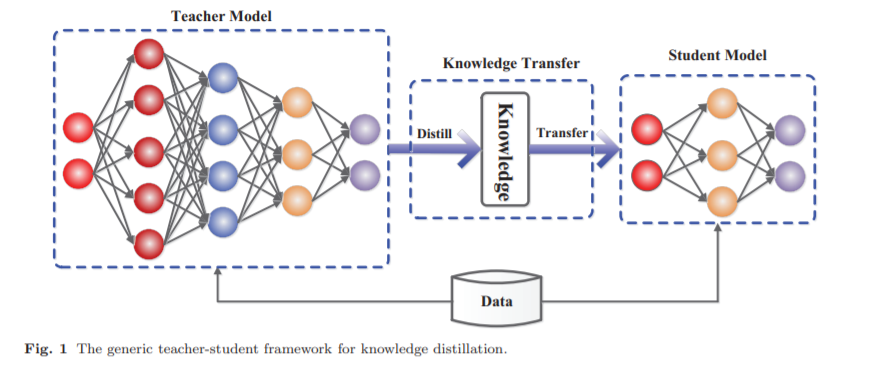

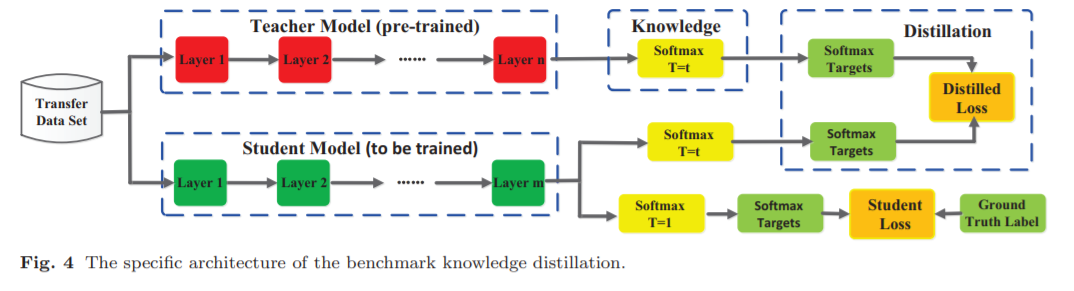

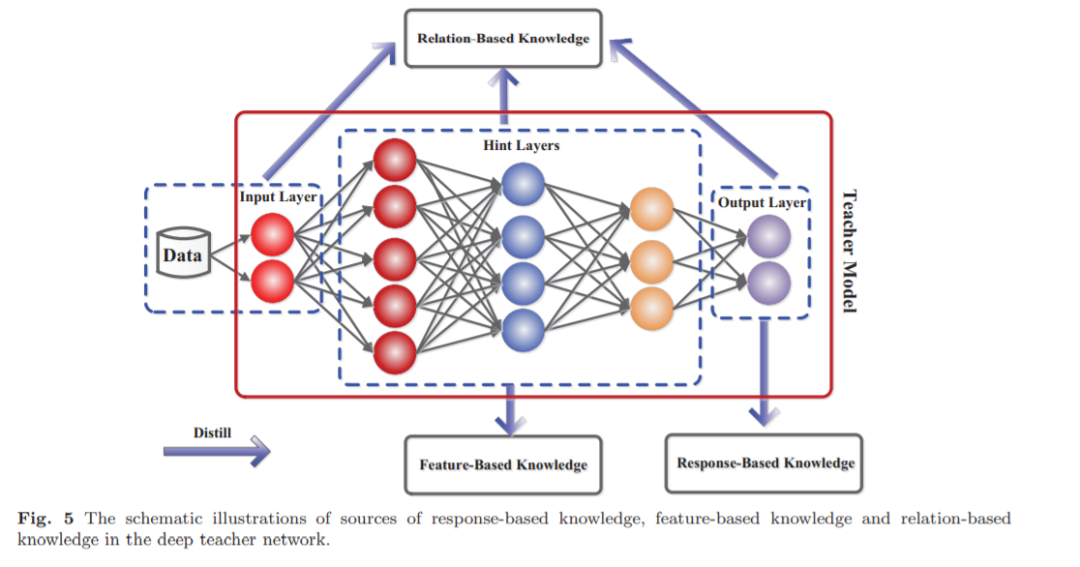

对模型压缩和加速的全面回顾超出了本文涵盖的范围,而我们关注的是知识蒸馏,这已经得到越来越多的研究社区关注。在实践中,大型深度模型往往会取得非常好的性能,因为过参数化提高了泛化性能 (Brutzkus and Globerson, 2019; Allen-Zhu et al., 2019; Arora et al., 2018)。知识蒸馏通过在大教师模型的监督下学习小学生模型,从而探究深度模型中参数的冗余性,用于推理(Bucilua et al., 2006; Ba and Caruana, 2014; Hinton et al., 2015; Urban et al., 2016),而知识蒸馏的关键问题是如何将知识从大教师模型转移到小学生模型。一般情况下,知识蒸馏的师生框架如图1所示。虽然在实践中取得了巨大的成功,但在理论或经验上理解知识提炼方法的工作并不多(Cheng et al., 2020; Phuong and Lampert, 2019; Cho and Hariharan, 2019)。具体来说,为了理解知识蒸馏的工作机制,Phuong和Lampert在深度线性分类器的情况下,从理论上证明了学习精馏学生网络快速收敛的泛化边界(Phuong和Lampert, 2019)。这一解释理论上回答了学生学习的内容和速度,并揭示了决定蒸馏成功的因素。蒸馏的成功依赖于数据几何、蒸馏目标的优化偏差和学生分类器的强单调性。Cheng等人量化了来自深度神经网络中间层的视觉概念知识,以解释知识蒸馏(Cheng et al., 2020)。Cho和Hariharan对知识蒸馏的有效性进行了详细的实证分析(Cho和Hariharan, 2019)。实证分析发现,由于模型容量的差距,较大的模型不一定是更好的老师(Mirzadeh et al., 2019),而精馏会对学生的学习产生不利影响。据我们所知,(Cho and Hariharan, 2019)忽略了对教师和学生之间不同知识、不同蒸馏和相互感情的经验评价。此外,通过实证分析,从标签平滑、教师和先验对最优输出层几何形状的预测置信度等角度探讨了对知识蒸馏的理解(Tang et al., 2020)。

模型压缩的知识蒸馏思想与人类的学习方案非常相似。为此,近年来的知识蒸馏方法不仅扩展到了师生学习(Hinton et al., 2015),还扩展到了相互学习(Zhang et al., 2018b)、自学(Yuan et al., 2019)、辅助教学(Mirzadeh et al., 2019)和终身学习(Zhai et al., 2019)。知识蒸馏的大部分扩展集中于压缩深度神经网络,因此轻量级的学生网络可以很容易地部署在诸如视觉识别、语音识别和自然语言处理(NLP)等应用程序中。此外,知识蒸馏中从一个模型到另一个模型的知识转移符号也可以扩展到其他任务,如对抗攻击(Papernot et al., 2016b)、数据增强(Lee et al., 2019a;Gordon和Duh, 2019),数据隐私和安全(Wang等,2019a)。

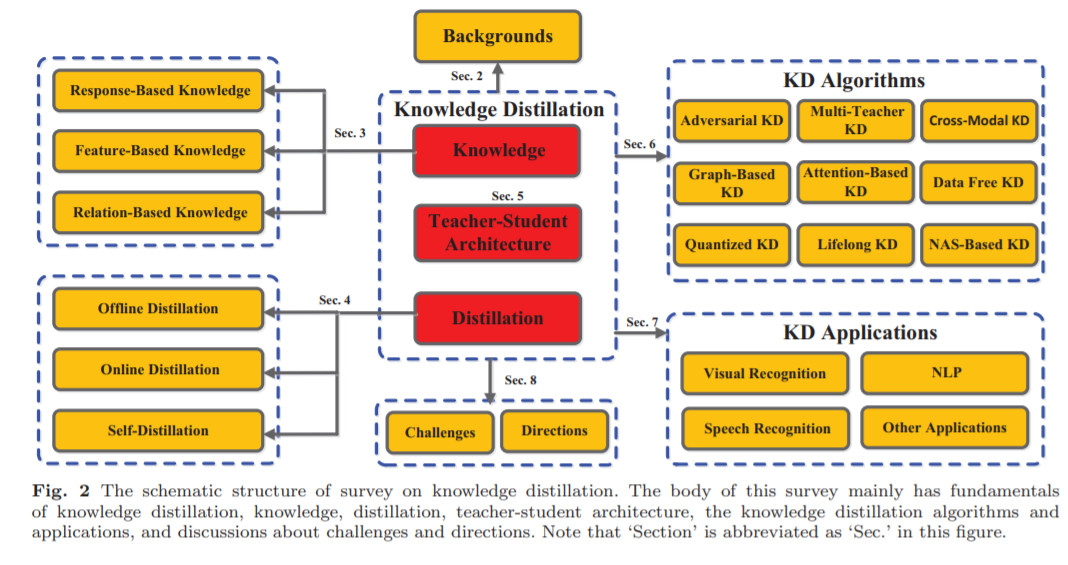

本文对知识蒸馏的研究进行了综述。本综述的主要目的是1) 全面概述知识蒸馏,包括动机的背景,基本符号和公式,以及几种典型知识,蒸馏和算法; 2) 全面回顾知识蒸馏的最新进展,包括理论、应用和在不同现实场景下的扩展; 3) 从知识迁移的不同角度,包括不同类型的知识、训练方案、知识提炼算法/结构和应用,阐述知识蒸馏的一些挑战和见解。本文组织概况如图2所示。具体地说,本文的其余部分结构如下。第二节给出了知识蒸馏的重要概念和常规模型。知识和蒸馏的种类分别在第3节和第4节中进行了总结。现有的关于知识提炼中的师生结构的研究在第5部分进行了说明。第6节对许多最新的知识蒸馏方法进行了全面的总结和介绍。知识蒸馏的广泛应用将在第7节的不同方面加以说明。第8节讨论了知识蒸馏中具有挑战性的问题和未来的方向。最后,在第9节给出结论。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“KD30” 可以获取《最新《知识蒸馏》2020综述论文,30页pdf,悉尼大学》专知下载链接索引