【VALSE前沿选介2018-01期】传统不死:在CNN中学习和构建空间传播模块

随着deep learning的飞速发展,近几年间各种dense correspondence(例如segmentation)问题都得到了飞速的发展。绝大多数工作都是关于设计更好网络结构(FCN,DeepLab,PSPNet,DUC等)和改进基础卷积操作(如Dilation Conv,Deformable Conv等)。往往由于计算量限制,直接使用这些网络并不能在一些小物体和细致的边缘上得到一个令人满意的结果,所以在这些网络输出之后,常用的手段是还需要使用CRF来进行一波refine。早期一个经典的工作CRF as RNN试图把传统的dense CRF推断过程使用一个RNN网络近似,后续也有一些跟进工作。然而这些工作都是直接使用了如raw RGB pixel这些非常弱的feature去建立pairwise similarity,今天给大家介绍的一系列的工作就是试图在CNN网络结构中显式地构建这样一个可微分的propagation的模块,同时根据image feature去学习一个特定的pairwise similarity(即affinity)。

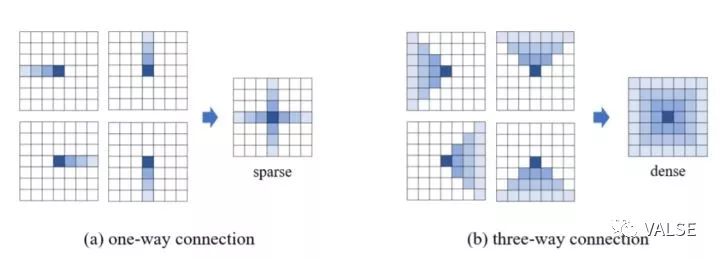

在Spatial Propagation Network(SPN) [1]中,作者首先通过训练一个CNN,对于输入图片的特征显式学习每一个位置在空间关系上四个近邻的affinity(相连性),然后根据这些affinity去将已有segmentation的结果进行refine。不同于dense CRF中每个像素都和其他所有相连接,考虑到实际计算的复杂度和实现效率,作者提出了两种连接方式,即one way connection和three way connection,如下图所示:

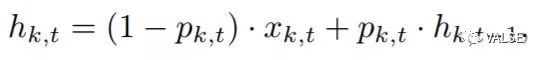

具体来说,作者通过多次在四个方向上进行linear propagation来将spatial context的信息融合到最终的结果中去,以从左向右propagate的公式举例如下:

其中h_{k, t}为第t个column第k个pixel propagate后的结果,x_{k, t}为这个位置原始网络的输出结果,p_{k, t}为这个位置从左向右propagate的affinity。类似地,three way connection的方式也是类似:

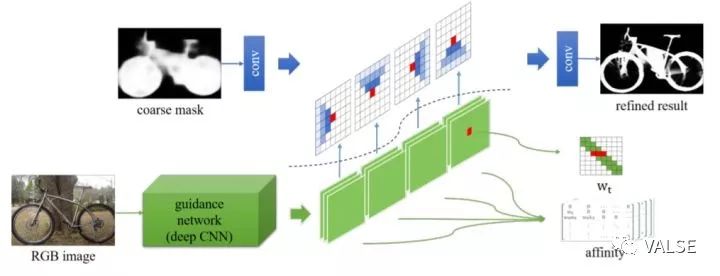

除此之外,作者在文章证明了上述propagation过程是一个有效的diffusion process和其diffusion的稳定性。具体证明在此不再赘述,有兴趣的读者可以查阅原始的论文。一个整体的框架如下图所示,值得一提的是这样一个spatial propagation的网络是可以叠加在任何基础网络之上的。这也就大大拓展了其使用场景。用CRF中的语言来说,也就是这样一个基础网络提供了unary term,SPN提供了一种data driven pairwise term。

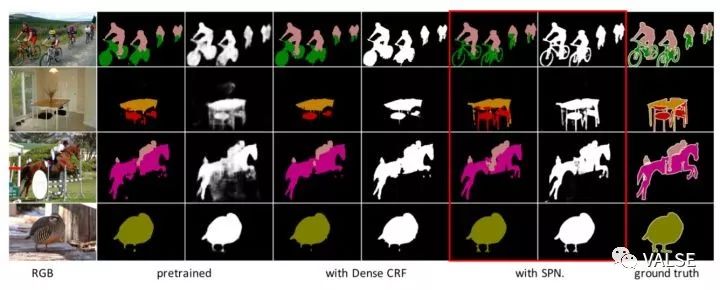

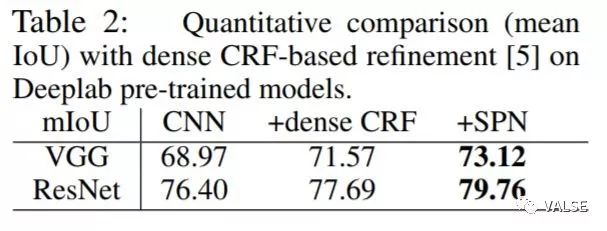

在实验中,作者在face parsing和semantic segmentation中对SPN进行了测试,如下图和下表所示,可以看到无论是定性还是定量上,配合不同的基础网络都可以得到相当不错的性能提升。

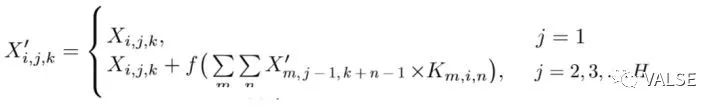

[2]和[1]其实有异曲同工之妙,除了在propagation过程中没有约束weight求和等于1之外,(不过这也导致无法证明出[1]中diffu在sion的稳定性)其余模块的配置基本一致。具体propagation的公式如下:

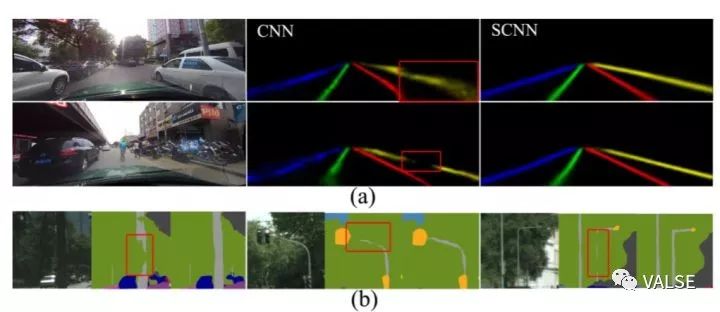

这样的一个模块也被证明在车道线检测、小物体segmentation这些需要强spatial context中能显著提升性能。

综上,这种显式构建的spatial propagation的模块被多次验证可以显著提升性能,相信这样的一个想法也会在更多应用中展现价值。另外一个值得关注的趋势是,在deep模块中显式构建一些可微分的传统vision任务中的模块,插入到现有deep的pipeline中来增强我们对某些问题的先验知识。比较著名的例子有Spatial Transformer Network,去对常见的affine transformation进行了构建;warp module,将在optical flow中常用warp操作引入了deep pipeline中,从而启发了一大批相关工作。个人相信这样的思路以后仍然会是研究的一个热点。传统方法并不会死,而是改头换面以更好的形式在deep learning中重生。

[1] Liu, S., De Mello, S., Gu, J., Zhong, G., Yang, M. H., & Kautz, J. (2017). Learning affinity via spatial propagation networks. In NIPS2017.

[2] Pan, X., Shi, J., Luo, P., Wang, X., & Tang, X. (2017). Spatial As Deep: Spatial CNN for Traffic Scene Understanding. In AAAI2018.