最新开源 RGBD+IMU数据集:FMDataset

点击上方“计算机视觉life”,选择“星标”

快速获得最新干货

杭电-清华联合培养博士生朱尊杰等人开源了他们论文“Real-time Indoor Scene Reconstruction with RGBD and Inertia Input”中的数据集。该论文获得了2019 IEEE International Conference on Multimedia and Expo (ICME,CCF B类会议)的最佳学生论文奖。

重点来了,目前作者开源了他们的RGBD+IMU数据集:数据集传送门:

https://github.com/zhuzunjie17/FastFusion

背景介绍

相机运动估计是三维场景重建中的关键技术。之前的工作均假设相机是缓慢运动的,从而局限了它们在真实场景下的应用。我们提出了一个端到端的三维重建系统,主要利用彩色图像,深度图像以及惯性测量单元的信息实现快速相机运动下的鲁棒重建。我们以扩展卡尔曼滤波为框架来融合这三类输入,并引入迭代的方法来联合优化特征配准,相机姿态估计以及场景几何。我们也提出来一个新颖的考虑几何信息的区块变形技术,从而适应图像层的特征表面变化,实现了快速相机运动下更加准确的特征匹配。实验结果表明我们的区块变形技术提高了特征跟踪的精度,我们的三维重建系统在快速相机运动下优于现有技术。

下面是论文demo:

朱博士之前在计算机视觉life做的关于上述工作的公开课回放视频见:

公开课视频回放 | 基于RGBD和IMU的实时室内SLAM及三维重建

数据集介绍

欢迎大家对论文和数据集批评指正,数据集传送门:

https://github.com/zhuzunjie17/FastFusion

由于现有的数据集少有考虑快速相机运动且同时包含Color,Depth,IMU输入的。于是他们在论文中使用了自己采集的快速相机运动的数据集Fast Sensor Motion Dataset(FMDataset)。该数据集使用Intel Realsense ZR300传感器采集快速相机运动下的彩色图像,深度图像以及IMU数据,其目的是为了验证slam系统的在不同相机运动速度下的鲁棒性。

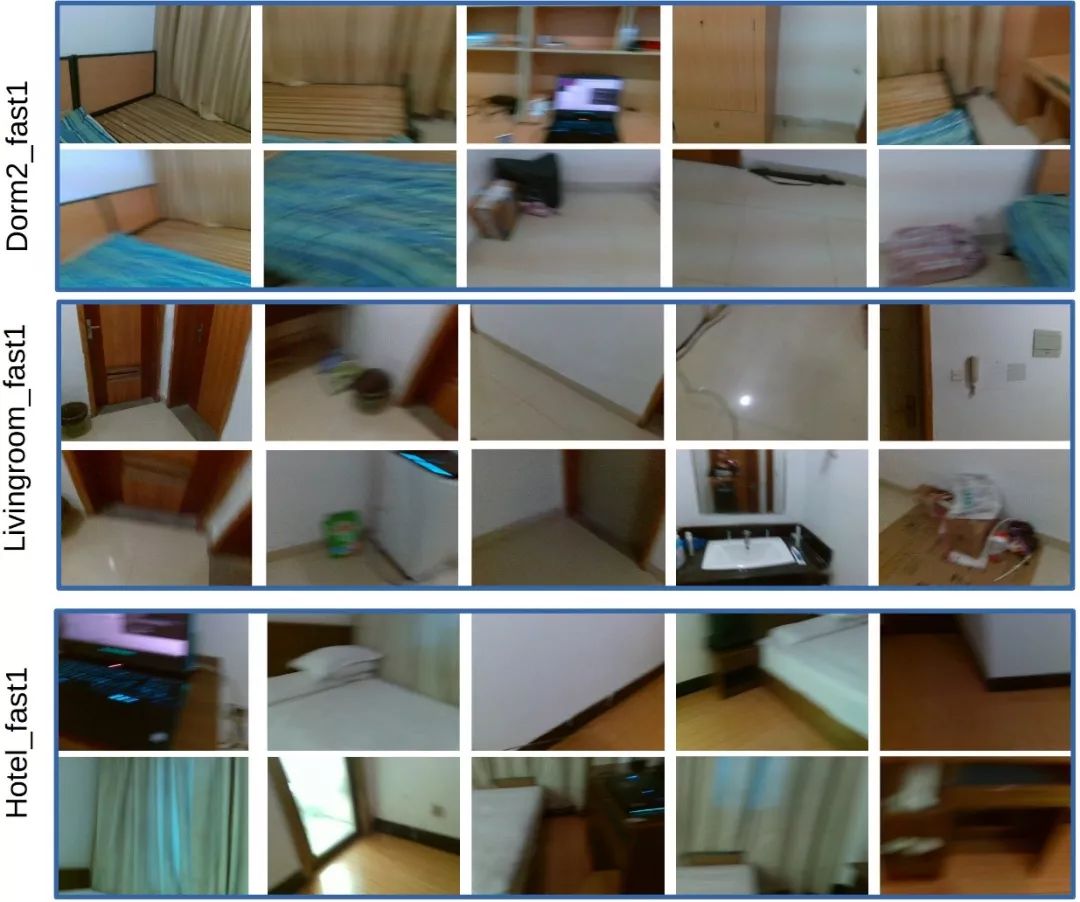

数据集共有从6个不同场景中采集的14个视频序列.所有序列依据相机运动速度及彩色图像的模糊程度被区分为慢速,中速和快速。以下是数据集中部分场景的图片:

后续更新计划

论文作者使用Intel Realsense ZR300传感器采集数据集的原因是当时该传感器是最先进的能够同时采集彩色深度图像以及imu数据的传感器。现在微软出了Azure Kinect, 于是在这里我们简略的比较一下两个传感器。Intel Realsense ZR300传感器的优势在于体积小质量轻,一个接口能同时供电传数据;但缺点也很明显,其depth相机的成像质量及测量范围不如Azure Kinect。因此FMDataset在后续也将添加由Azure Kinect采集的数据。

从零开始学习三维视觉核心技术SLAM,扫描查看介绍,3天内无条件退款

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、算法竞赛、图像检测分割、人脸人体、医学影像、自动驾驶、综合等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

推荐阅读

从零开始一起学习SLAM | 不推公式,如何真正理解对极约束?

从零开始一起学习SLAM | 理解图优化,一步步带你看懂g2o代码

从零开始一起学习SLAM | 用四元数插值来对齐IMU和图像帧

最新AI干货,我在看