YOLO v4它来了:接棒者出现,速度效果双提升

机器之心报道

机器之心编辑部

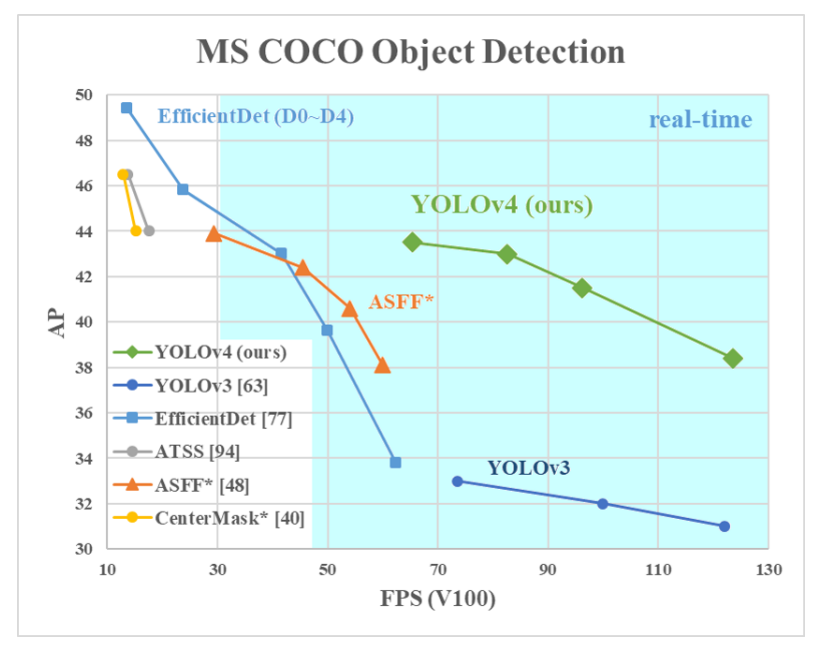

YOLO v4 真的来了,带给我们的除了惊喜,还是惊喜。

YOLO v4 论文:https://arxiv.org/abs/2004.10934

YOLO v4 开源代码:https://github.com/AlexeyAB/darknet

加权残差连接(WRC)

Cross-Stage-Partial-connection,CSP

Cross mini-Batch Normalization,CmBN

自对抗训练(Self-adversarial-training,SAT)

Mish 激活(Mish-activation)

Mosaic 数据增强

DropBlock 正则化

CIoU 损失

-

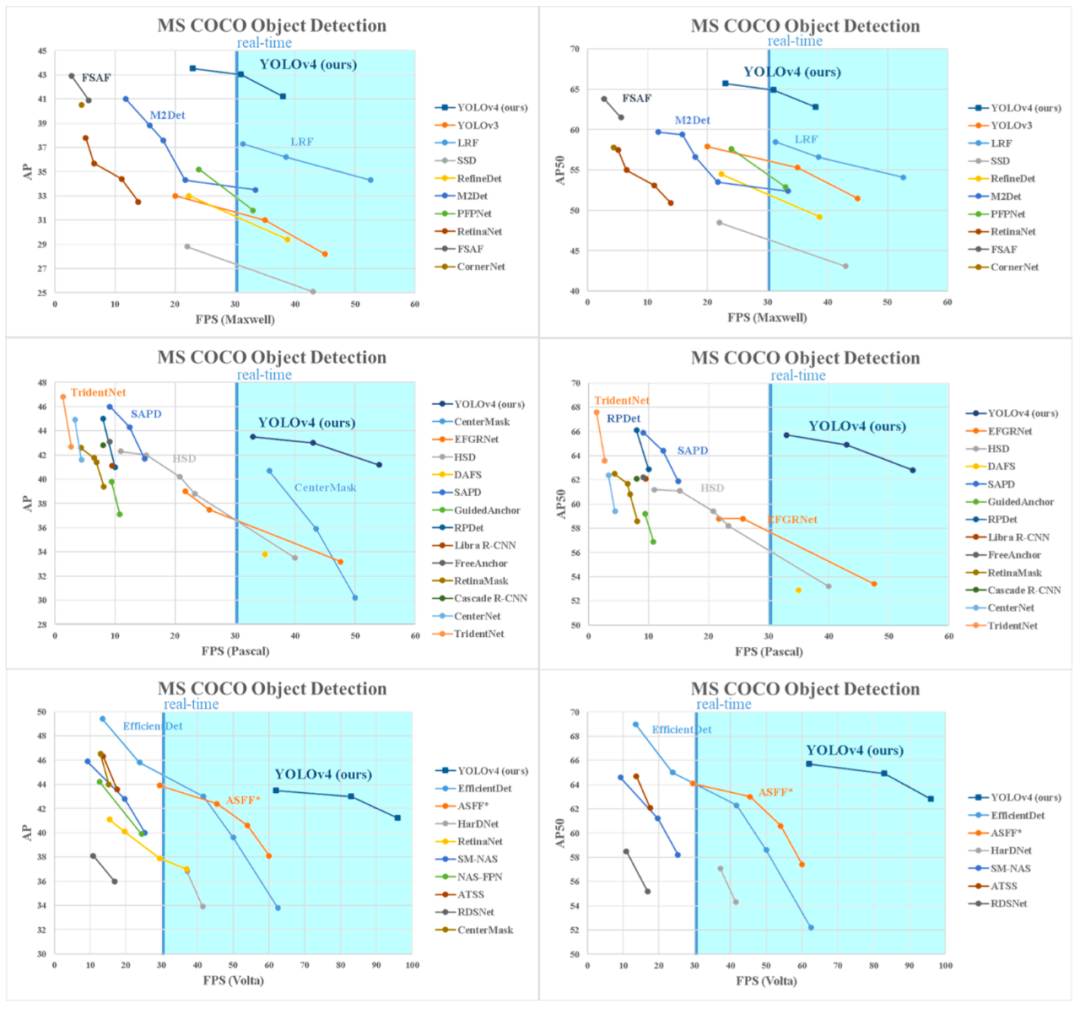

建立了一个高效强大的目标检测模型。它使得每个人都可以使用 1080Ti 或 2080Ti 的 GPU 来训练一个快速准确的目标检测器。 -

验证了当前最优 Bag-of-Freebies 和 Bag-of-Specials 目标检测方法在检测器训练过程中的影响。 -

修改了 SOTA 方法,使之更加高效,更适合单 GPU 训练。这些方法包括 CBN、PAN、SAM 等。

对于 GPU,研究者在卷积层中使用少量组(1-8 组):CSPResNeXt50 / CSPDarknet53;

对于 VPU,研究者使用了分组卷积(grouped-convolution),但避免使用 Squeeze-and-excitement(SE)块。具体而言,它包括以下模型:EfficientNet-lite / MixNet / GhostNet / MobileNetV3。

-

骨干网络:CSPDarknet53 -

Neck:SPP、PAN -

Head:YOLOv3

用于骨干网络的 Bag of Freebies(BoF):CutMix 和 Mosaic 数据增强、DropBlock 正则化和类标签平滑;

用于骨干网络的 Bag of Specials(BoS):Mish 激活、CSP 和多输入加权残差连接(MiWRC);

用于检测器的 Bag of Freebies(BoF):CIoU-loss、CmBN、DropBlock 正则化、Mosaic 数据增强、自对抗训练、消除网格敏感性(Eliminate grid sensitivity)、针对一个真值使用多个锚、余弦退火调度器、优化超参数和随机训练形状;

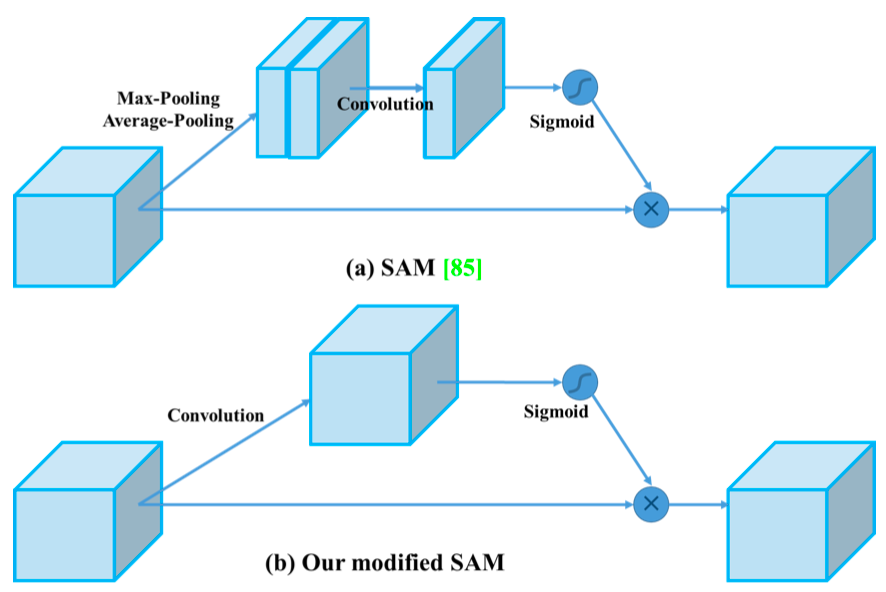

用于检测器的 Bag of Specials(BoS):Mish 激活、SPP 块、SAM 块、PAN 路径聚合块和 DIoU-NMS。

激活函数:ReLU、 leaky-ReLU、parametric-ReLU、ReLU6、SELU、Swish、Mish;

边界框回归损失(Bounding box regression loss):MSE、IoU、GIoU、CIoU、DIoU;

数据增强:CutOut、MixUp、CutMix;

正则化方法:DropOut,、DropPath、Spatial DropOut、DropBlock;

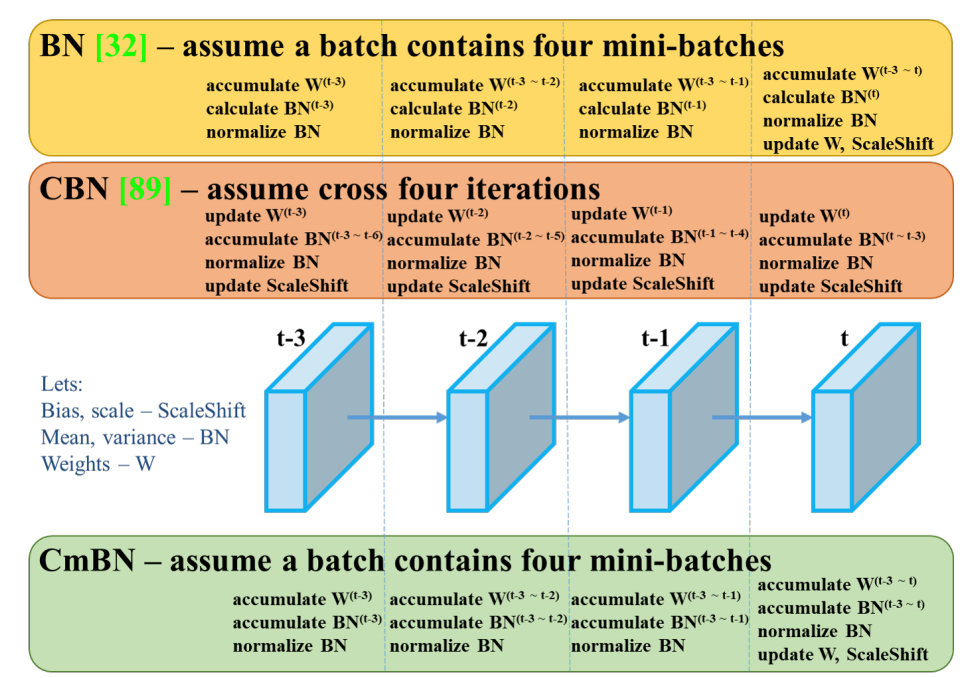

通过均值和方差的归一化网络激活函数:批归一化(BN)、跨 GPU 批归一化 (CGBN 或 SyncBN)、滤波器响应归一化(FRN)、交叉迭代批归一化(CBN);

跳跃连接方式:残差连接、加权残差连接、多输入加权残差连接、Cross stage 局部连接(CSP)。

提出新型数据增强方法 Mosaic 和自对抗训练(SAT);

在应用遗传算法时选择最优超参数;

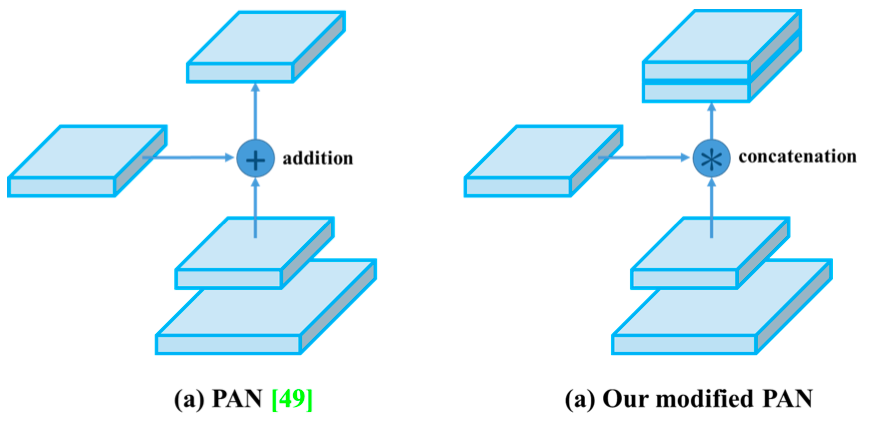

修改现有方法,使新方法实现高效训练和检测——modified SAM、modified PAN 和 Cross mini-Batch Normalization (CmBN)。

机器之心 CVPR 2020 线上分享第二期,我们邀请到旷视研究院基础模型组实习生、北京大学软件工程系硕士楚选耕为我们分享 Oral 论文《Detection in Crowded Scenes: One Proposal, Multiple Predictions》,欢迎读者们参与报名。