“快到没朋友”的目标检测模型YOLO v3问世,之后arXiv垮掉了…

安妮 编译整理

量子位 出品 | 公众号 QbitAI

今天有三件事挺有意思。

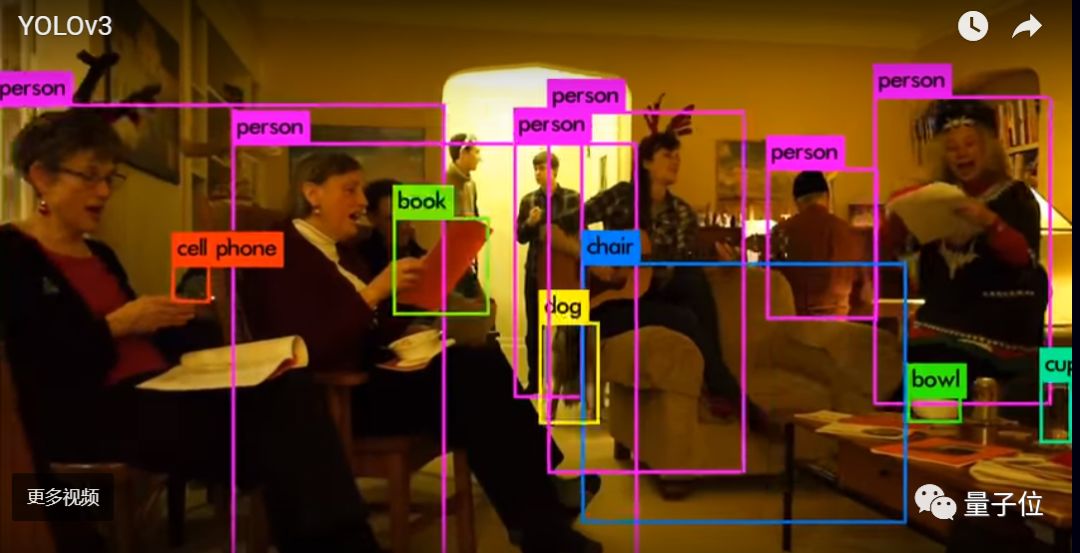

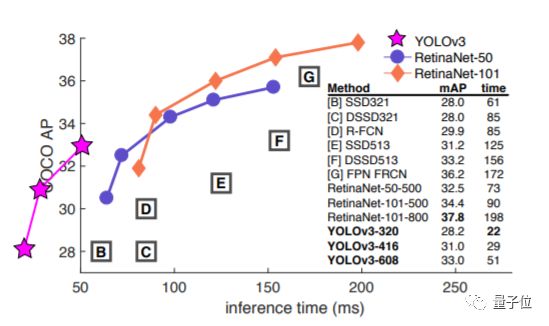

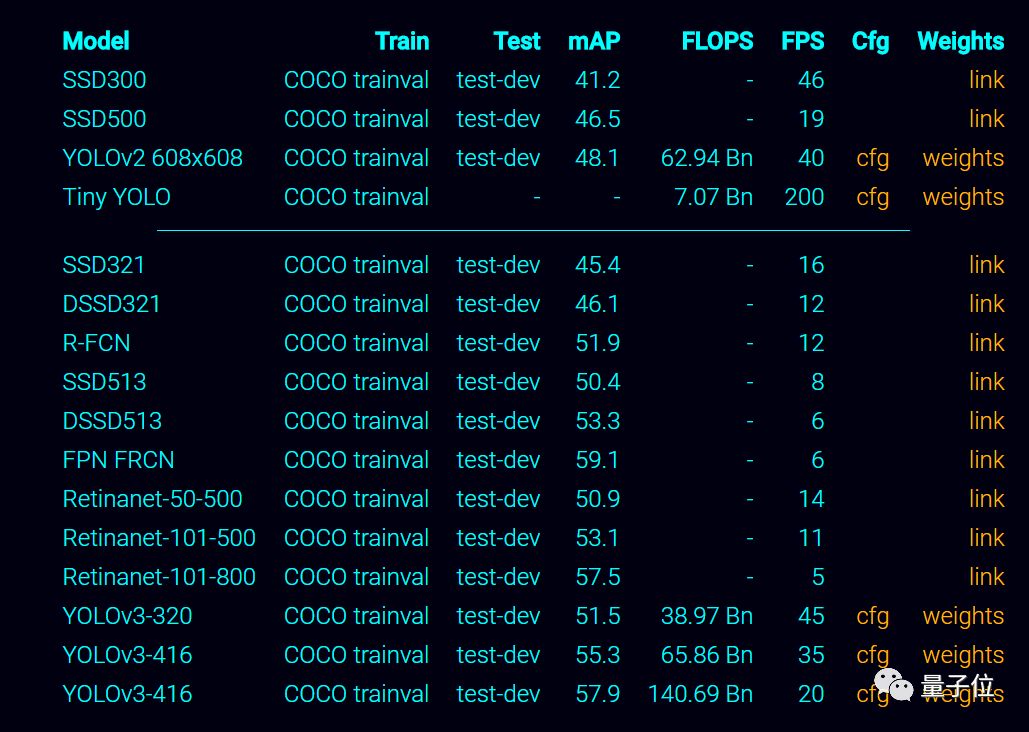

一是以“快到没朋友”著称的流行目标检测模型YOLO推出全新v3版,新版本又双叒叕提升了精度和速度。在实现相近性能时,YOLOv3比SSD速度提高3倍,比RetinaNet速度提高近4倍。

二是有细心网友发现,模型一作在arXiv上发布研究论文时,脑回路清奇地将自己这篇论文自引自用了一下。

三是……在小哥自引自用后没多久,arXiv官方账号宣布服务器由于不明原因挂掉了……

更快更强

先说更新这件正经事~

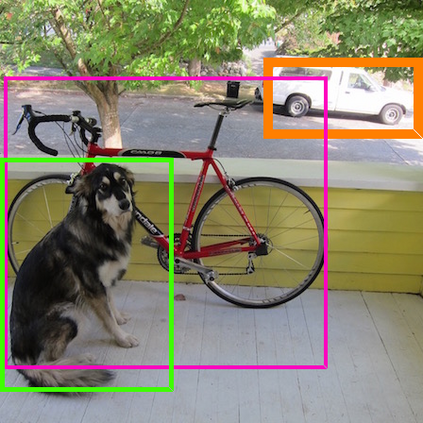

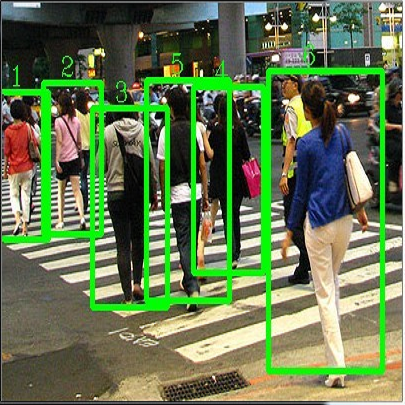

通过调整YOLO模型中的一些细节,v3模型增大了一些准确率也有所提升,速度依旧非常快。客官不妨先看一下介绍视频——

对于320x320的图像,YOLOv3的检测速度可达22ms,mAP值可达28.2,与SSD的准确率相当但速度快3倍。

当用旧版.5 IOU mAP检测指标时,YOLOv3在英伟达TitanX显卡上51ms达到57.9AP50的性能。相比之下,RetinaNet则用198ms达到57.5AP50的性能,两者性能相近但速度相差近4倍。

作者,和他的少女心

YOLOv3出自华盛顿大学的Joseph Redmon和Ali Farhadi之手。

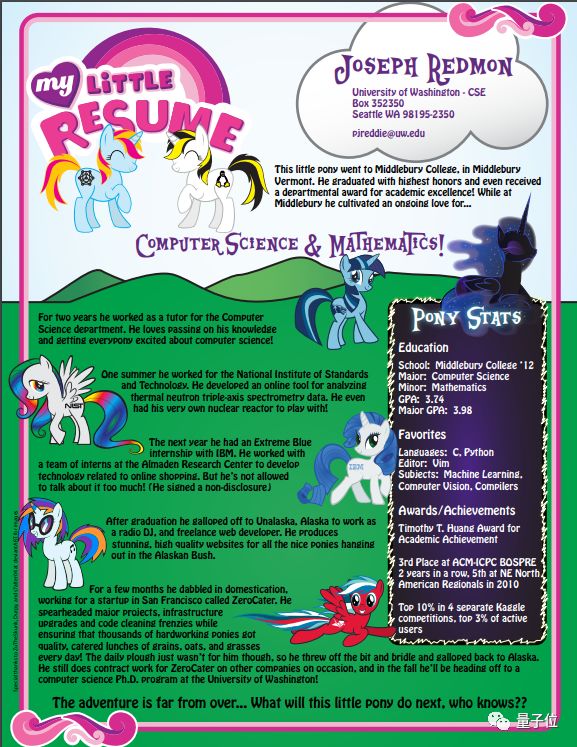

Ali Farhadi是华盛顿大学的副教授,一作Joseph Redmon是他的博士生,曾在IBM实习,其实还当过电台DJ。Redmon是一个少女心有点爆棚的程序员,这里有一份他的简历,可以自行感受下。

处于不知名的原因,小哥有一些“小马情结”,可以再次感受下个人网站的画风——

“论文就该实在点”

如果单单是YOLOv3发布新版本,可能在Reddit上还达不到热度200的水平。有意思在,论文从头到尾都透露着“不太正经”的气息,比如作者自引自用论文,比如这个Introduction的开头——

自己今年没怎么做研究,花了很多时间在Twitter上,捣鼓了一下GAN。

没错,这真的是一篇arXiv上的论文。Redmon还在论文中写了写自己尝试但失败了的方法。结尾,也不忘调侃一下热点。

“还有一个更好地问题:‘我们如何使用检测器?’Facebook和Google的很多研究员也在做相关研究啊。我认为,我们至少能知道技术被应用在了有利的方面,并且不会被恶意利用并将它们卖给…等一下,你说这就是它的用途??Oh!”

Reddit上网友的称赞每篇论文都应该这样实在,小哥在Reddit已收获大批粉丝……

相关资料

对了,对论文有疑问还是不要去@作者了,反正对方也不会回,论文中都说了~

你可以选择冒险再回看研读一下论文和代码。

论文下载地址:

https://pjreddie.com/media/files/papers/YOLOv3.pdf

项目地址:

https://pjreddie.com/darknet/yolo/

相关代码:

https://github.com/pjreddie/darknet

不过你得小心。

毕竟……YOLO模型的全称可是You Only Look Once(只能看一眼),再看可能会被吃掉!

— 完 —

活动推荐

△ 点击图片或阅读原文

即可获取更多详情

联想高校AI精英挑战赛,覆盖全国28个省份、8大赛区和260所高校,经过在中科大、华中科技大学、清华大学、上海交通大学等8所AI领域具有顶尖优势的理工科高校的半决赛路演,产生最终入围总决赛的十支参赛队伍,并将于3月29日在北京中国科学院计算技术研究所迎来全国总决赛。

加入社群

量子位AI社群15群开始招募啦,欢迎对AI感兴趣的同学,加小助手微信qbitbot6入群;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进群请加小助手微信号qbitbot6,并务必备注相应群的关键词~通过审核后我们将邀请进群。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态