了解对比学习中的视角选择,获得更稳健的数据表征!

文 / 学生研究员 Yonglong Tian 和研究员 Chen Sun,Google Research

如果从不同的角度去观察一个物体,大多数人都会认为自己能够认出这是同一个物体,例如某个物体从正面观察时是一只狗,那么从侧面观察时,我们同样会认为这个物体是一只狗。人类可以自然而然地做到这一点,但对于机器来说,仍需要计算机科学家明确需要其学习视角不变的表征 (View-Invariant),以寻求稳健的数据表征,保留了对下游任务有用的信息。

学习

https://arxiv.org/abs/1206.5538

我们当然可以使用带有手动注释的训练数据来学习这些表征。然而,在许多情况下,我们无法得到这些注释,由此诞生了一系列自监督和跨模态监督方法,而这些方法并不需要使用人工注释的训练数据。

目前,用于训练这类数据的热门范例是对比多视角学习 (Contrastive Multiview Learning)。经过学习后,相同场景的两个视角(如:不同的图像通道、对相同图像作出效果增强以及视频和文本对)会在表征空间中趋于收敛,而不同场景的两个视角则会发散。尽管我们已通过这些方法取得成功,但仍然存在一个很重要的问题:“如果没有现成的带注释标签,那么我们应该如何选择表征不变的视角?”换句话说,如何使用图像中本身存在的信息来识别物体,同时在从完全不同的视角观看该图像时,仍能保证识别结果准确?

在“良好的对比学习视角由哪些因素组成”(What makes for good views for contrastive learning) 这篇论文中,我们使用理论和经验分析来更好地理解选择视角的重要性,并认为应在保持完整任务相关信息的同时,减少视角之间的互信息 (Mutual Information)。

良好的对比学习视角由哪些因素组成

https://arxiv.org/abs/2005.10243

为验证这一假设,我们设计了无监督和半监督式框架:通过减少互信息来训练学习有效视角。我们将数据增强作为减少互信息的一种方式,并证明了提升数据增强效果的确会减少互信息,同时还会提升下游分类工作的准确率。为鼓励大家在这个领域进一步深入研究,我们已开放源代码和预训练模型。

开放源代码和预训练模型

https://github.com/HobbitLong/PyContrast/tree/master/pycontrast

InfoMin 假设

对比多视角学习的目标是训练学习参数编码器,而其输出的表征可用来区分带有相同标识的视角对,以及具有不同标识的视角对。视角间共享信息的数量和类型可以决定我们所训练出来的模型在下游任务上的表现。我们假设为让视角得到最佳结果,应在输入中尽可能舍弃与任务无关的信息(如对象标签),这即是我们所说的 InfoMin 原则。

思考下面的示例,其中同一图像中的两个区块分别代表不同的 “视角”。此训练的目标是识别出这两个视角属于同一图像。如果视角之间共享的信息过多,其结果会不理想,例如,在识别图像时,将低级的颜色和纹理线索用作“快捷方式”(如左图),而如果视角之间共享的信息过少,则会导致无法识别出是否属于同一图像(如右图)。相反,处于“最有效点”的视角之间会共享与下游任务相关的信息,例如在物体分类任务中,这样的视角便是熊猫身上不同地方对应的区块(如中图)。

在对比多视角学习过程中捕获的三种信息状态:视角间共享的信息不应过多(左图)或过少(右图),而是应找到一个最优组合(即中图的“最有效点”),以使下游充分发挥性能

对比学习的统一视角

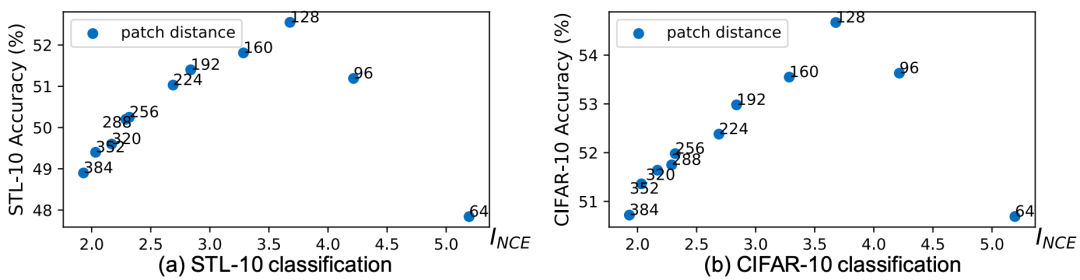

由于我们现在可以利用简单的方法,在无需任何监督的情况下控制视角间共享的互信息,所以我们设计了几组实验来验证 InfoMin 假设。例如,我们可以对相同图像中的不同区块进行采样,通过增加区块间的距离来减少两者间的互信息。在这一过程中,我们使用 InfoNCE ( INCE) 来估算互信息量,其为互信息下限的定量度量。我们观察到了一条反向的 U 型曲线:随着互信息的减少,下游任务的准确率会先升高,然后再降低。

InfoNCE

https://arxiv.org/abs/1807.03748

在使用线性分类器对通过对比学习得出的表征进行分类的情况下,对模型使用 STL-10(左图)和 CIFAR-10(右图)数据集所得到的下游分类准确率。与之前的图示相同,我们会对相同图像中的不同区块进行采样,并将其作为视角。增加区块间的欧氏距离可以减少两者间的互信息。图中是我们在分类准确率和 INCE (区块距离)间观察到的反向 U 型曲线

此外,我们会从选择视角的角度来证明几种最先进的对比学习方法(InstDis、MoCo、CMC、PIRL、SimCLR 和 CPC)都大同小异:尽管各个方法在架构、目标和工程开发详情中存在差异,但所有近期推出的对比学习方法,都暗暗遵循了 InfoMin 假设来创建两个视角:在视角间通过信息增强强度来控制共享信息。

因此,我们提出了一组新的数据增强方案,相比现有的 SOTA 方法 (SimCLR),其可在 ImageNet 的线性读取基准上实现近 4% 的性能提升。我们还发现,在将无监督预训练模型转而用于物体检测和实例分割时,其表现要始终优于 ImageNet 的预训练模型。

通过学习生成视角

在我们的研究中,通过遵循 InfoMin 假设,我们设计出可合成新型视角的无监督和半监督方法:通过学习可将自然色彩空间转换成新型色彩空间的基于流的模型,并从中分离通道以获取视角。

基于流的模型

https://arxiv.org/abs/1505.05770

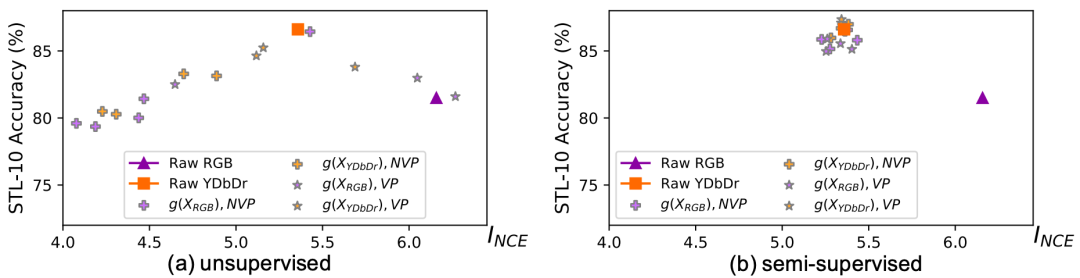

在无监督设置中,我们通过优化视角生成器,将视角间的 InfoNCE 边界降至最低。如下面的结果所示,在将 InfoNCE 边界降至最低时,我们会观察到与之前类似的反向 U 型趋势。

通过无监督(左图)和半监督(右图)目标训练学习得到的视角生成器结果

为在不过度减少互信息的情况下达到最佳效果,我们可以使用半监督式设置,并引导视角生成器保留标签信息。无论输入的色彩空间如何,所有经训练学习的视角现在都会集中在最有效点附近,这一点与预期相同。

代码和预训练模型

为加速推进自监督对比学习的研究,我们乐于与学术社区分享 InfoMin 的代码和预训练模型。您可在 GitHub 查看这些内容。

GitHub

https://github.com/HobbitLong/PyContrast/tree/master/pycontrast

致谢

核心团队成员包括 Yonglong Tian、Chen Sun、Ben Poole、Dilip Krishnan、Cordelia Schmid 和 Phillip Isola。我们要感谢 Kevin Murphy 与我们进行的深刻探讨;感谢 Lucas Beyer 对原稿提供的反馈;以及感谢 Google Cloud 团队在计算方面提供的支持。

如果您想详细了解 本文 的相关内容,请参阅以下文档。这些文档深入探讨了这篇文章中提及的许多主题:

InstDis

https://openaccess.thecvf.com/content_cvpr_2018/html/Wu_Unsupervised_Feature_Learning_CVPR_2018_paper.htmlMoCo

https://arxiv.org/abs/1911.05722CMC

https://arxiv.org/abs/1906.05849PIRL

https://arxiv.org/abs/1912.01991SimCLR

https://arxiv.org/abs/2002.05709CPC

https://arxiv.org/abs/1807.03748

更多 AI 相关阅读: