学界 | 斯坦福大学&DeepMind联合提出机器人控制新方法,RL+IL端到端地学习视觉运动策略

选自arXiv

作者:朱玉可等

机器之心编译

参与:路雪、思源

近日,来自斯坦福大学&DeepMind 的研究者提出一种学习机器人深度视觉运动策略的新方法,它结合强化学习和模仿学习来实现高效的强化学习智能体,该方法可解决大量视觉运动任务。实验证明该智能体性能显著优于仅使用强化学习或模仿学习训练出的智能体。

近期深度强化学习在多个领域取得了很好的表现,如视频游戏 [29] 和围棋 [46]。对于机器人,RL 结合强大的函数逼近器(如神经网络)可提供设计复杂控制器的通用框架,而这种控制器很难靠人力搭建。基于强化学习的方法在机器人控制领域历史很久,但通常与低维动作表示结合使用 [4, 20]。近年来,使用 model-based 和 model-free 技术的深度强化学习在机器人控制方面取得了大量成功案例,包括模拟和在硬件上运行两方面。然而,使用 model-free 技术端到端地学习视觉运动控制器来执行长跨度、多阶段控制任务仍然存在很大难度。

开发 RL 机器人智能体需要克服多项挑战。机器人策略必须将从带噪传感器中得到的多模态、部分观测数据改变为具备一定自由度的协作活动。同时,现实任务通常具备富接触动态,并且随着多个维度发生变化(视觉外观、位置、形状等),给泛化带来了很大挑战。

本论文中,研究者提出一种 model-free 的深度 RL 方法,直接从像素输入入手解决大量机器人控制任务。本论文关键洞察有:1)利用少量人类演示数据减少在连续域执行探索(exploration)的难度;2)在训练过程中使用多种新技术(这些技术利用(exploit)了私有和任务特定的信息),以加速和稳定视觉运动策略在多阶段任务中的学习;3)通过增加训练条件的多样性来改善泛化性能。因此,这些策略在系统动态、目标外观、任务长度等发生显著变化的情况下仍然运行良好。

此外,研究者还展示了该方法在两项任务上的初步结果,仿真训练出的策略达到了向真实机器人的 zero-shot 迁移。

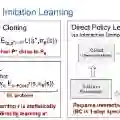

为了解决这些挑战,本论文研究者提出的方法将模仿学习和强化学习结合起来,构建一个统一训练框架。该方法以两种方式利用演示数据:使用混合奖励,基于生成对抗模仿学习将任务奖励与模仿奖励结合起来;使用演示轨迹构建状态的课程(curriculum),以在训练中初始化 episode。因此,该方法解决了全部六个任务,这些任务单凭强化学习或模仿学习都无法解决。

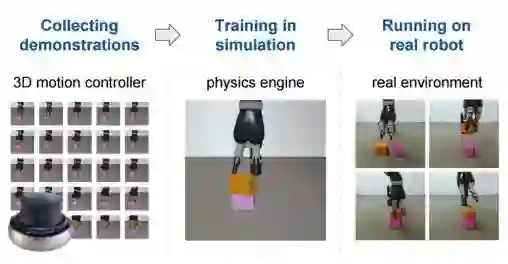

图 1. 研究者提出的机器人学习流程。研究者使用 3D 运动控制器收集某项任务的人类演示。本论文提出的强化学习和模仿学习模型利用这些演示促使模拟物理引擎的学习。然后执行 sim2real 迁移,将习得的视觉运动策略迁移至真正的机器人。

3. 模型

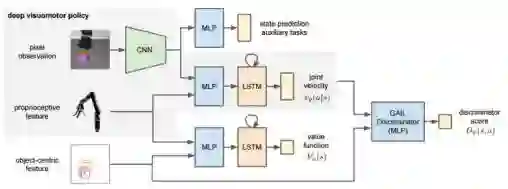

本研究旨在为机器人控制任务学习深度视觉运动策略。该策略使用 RGB 摄像头观测结果和本体特征(proprioceptive feature)向量描述关节位置和角速度。这两种感官模态在真实机器人上同样可用,因此研究者进行仿真训练,并将习得的策略在不修改的情况下迁移至机器人。图 2 是模型概览。深度视觉运动策略使用卷积神经网络编码观测像素,使用多层感知机编码本体特征。这两种模块中的特征被级联并传输至循环 LSTM 层,然后输出关节速度(控制)。整个网络以端到端的方式进行训练。研究者首先简要介绍了生成对抗模仿学习(GAIL)和近端策略优化(PPO)的基础知识。该模型基于这两种方法扩展而来,提升视觉运动技能。

图 2. 模型概览。模型核心是深度视觉运动策略,其采用摄像头观测结果和本体特征作为输入,并输出下一个关节速度。

4. 实验

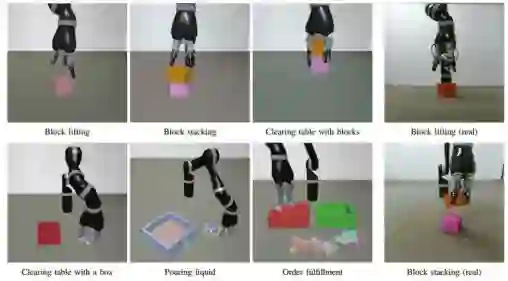

本节展示了该方法可向视觉运动策略学习提供灵活的框架。研究者在六个控制任务中对该方法的性能进行了评估(详见图 3)。视频包含了定性结果。

图 3. 实验中六项控制任务的可视化。左边三列展示了六项任务在仿真环境中的 RGB 图像。这些图像对应输入视觉运动策略的实际像素观测。右侧一列展示了真实机器人执行两项色块任务的表现。

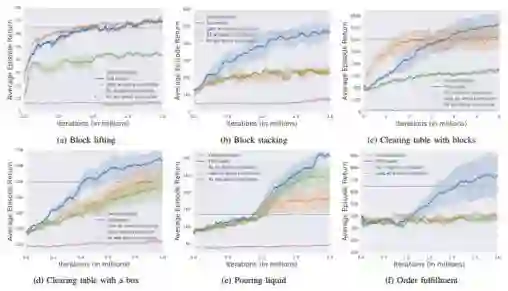

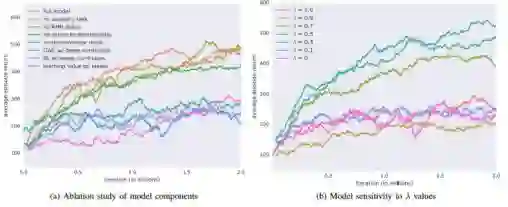

研究者将 episode 平均返回值表示为训练迭代次数的函数,如图 4 所示。完整模型在六项任务中达到了最高的返回值。

图 4. 论文提出的强化与模仿学习模型和基线学习效率的对比。该图展示的是 5 次不同随机种子运行的平均值。所有策略使用同样的网络架构和超参数(λ 除外)。

在图 5a 中,研究者用多种配置训练智能体,从单个修改到修改整个模型。研究者发现这些缺失可分为两类:学习堆叠的智能体(平均返回值大于 400)和仅学会提升的智能体(平均返回值在 200 和 300 之间)。结果表明从状态中学习价值函数的混合 RL/IL 奖励和以目标为中心的鉴别器特征在学习优良策略的过程中发挥了重要作用。

图 5b 展示了该模型在 λ 值在 0.3 到 0.7 之间的运行效果,λ 值的大幅变化提供了 RL 和 GAIL 奖励的平衡混合。

图 5. 堆叠任务中的模型分析。左图展示了从完整模型中移除每个单独组件对性能的影响。右图展示了模型对超参数 λ 的敏感度,λ 调节强化学习和模仿学习的贡献。

论文:Reinforcement and Imitation Learning for Diverse Visuomotor Skills

论文地址:https://arxiv.org/pdf/1802.09564.pdf

摘要:我们提出了一种 model-free 的深度强化学习方法,该方法利用少量人类演示数据帮助实现强化学习智能体。我们将该方法应用于机器人控制任务中,并训练端到端的视觉运动策略,使 RGB 摄像头输入可直接映射至关节速度。我们展示了该方法可解决大量视觉运动任务,而工程实现一个脚本控制器非常耗时费力。我们的实验表明强化学习和模仿学习智能体性能显著优于仅使用强化学习或模仿学习训练出的智能体。我们还介绍了这些策略,它们在视觉和动态条件变动较大的情况下进行训练,在 sim2real 迁移中取得了初步成功。本研究相关视频介绍:https://www.youtube.com/watch?v=EDl8SQUNjj0&feature=youtu.be。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:editor@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com