【简介】随着深度表示学习的发展,强化学习(RL)已经成为了一个强大的学习框架,其可以在高维度空间中学习复杂的规则。这篇综述总结了深度强化学习(DRL)算法,提供了采用强化学习的自动驾驶任务的分类方法,重点介绍了算法上的关键挑战和在现实世界中将强化学习部署在自动驾驶方面的作用,以及最终评估,测试和加强强化学习和模仿学习健壮性的现有解决方案。

论文链接: https://arxiv.org/abs/2002.00444

介绍:

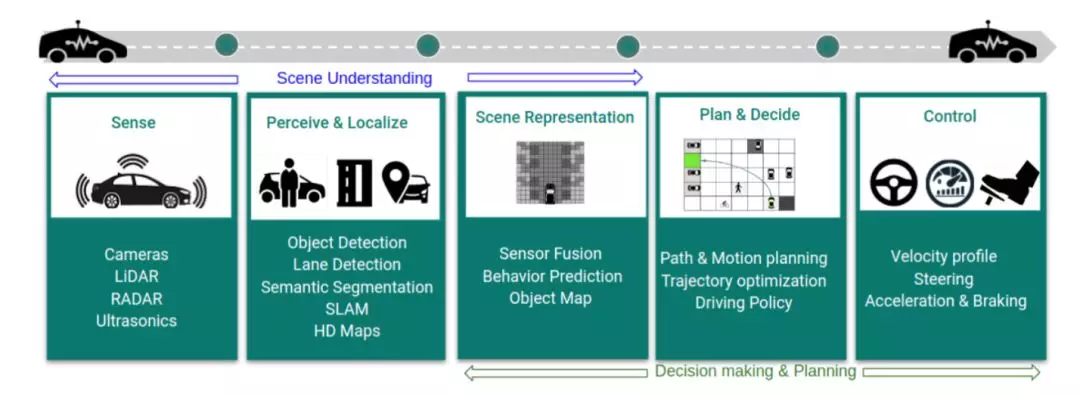

自动驾驶(AD)系统由多个感知级任务组成,由于采用了深度学习架构,这些任务现在已经达到了很高的精度。除了感知任务之外,自主驾驶系统还包含多个其他任务,传统的监督学习方法已经不再适用。首先,当对agent行为的预测发生变化时,从自动驾驶agent所处的环境中接收到的未来传感器观察到的结果,例如获取市区最佳驾驶速度的任务。其次,监督信号(如碰撞时间(TTC),相对于agent最佳轨迹的侧向误差)表示agent的动态变化以及环境中的不确定性。这些问题都需要定义随机损失函数来使其最大化。最后,agent需要学习当前环境新的配置参数,预测其所处的环境中每一时刻的最优决策。这表明在观察agent和其所处环境的情况下,一个高维度的空间能够给出大量唯一的配置参数。在这些场景中,我们的目标是解决一个连续决策的问题。在这篇综述中,我们将介绍强化学习的概念,强化学习是一种很有前景的解决方案和任务分类方法,特别是在驱动策略、预测感知、路径规划以及低层控制器设计等领域。我们还重点回顾了强化学习在自动驾驶领域当中各种现实的应用。最后,我们通过阐述应用当前诸如模仿学习和Q学习等强化学习算法时所面临的算力挑战和风险来激励使用者对强化学习作出改进。

章节目录:

section2: 介绍一个典型的自动驾驶系统及其各个组件。

section3: 对深度强化学习进行介绍,并简要讨论关键概念。

section4: 探讨在强化学习基本框架上对其进行更深层次,更加复杂的扩展。

section5: 对强化学习用于自动驾驶领域的所面临的问题提供一个概述。

section6: 介绍将强化学习部署到真实世界自动驾驶系统中所面临的挑战。

section7: 总结