【笔记】双线性池化(Bilinear Pooling)详解、改进及应用

点击上方,选择星标或置顶,每天给你送干货

阅读大概需要16分钟

跟随小博主,每天进步一丢丢

来自 | 知乎

作者丨林小北

来源丨https://zhuanlan.zhihu.com/p/62532887

本文仅供交流,如有侵权,请联系删除。

一、简介

对bilinear pooling进行详细介绍,便于读者理解原文;

建立bilinear pooling到bilinear model的联系,便于读者理解以MLB为核心的bilinear model相关文章。

快速介绍对bilinear pooling的各种改进形式。

二、bilinear pooling详解

三、Second-order Pooling

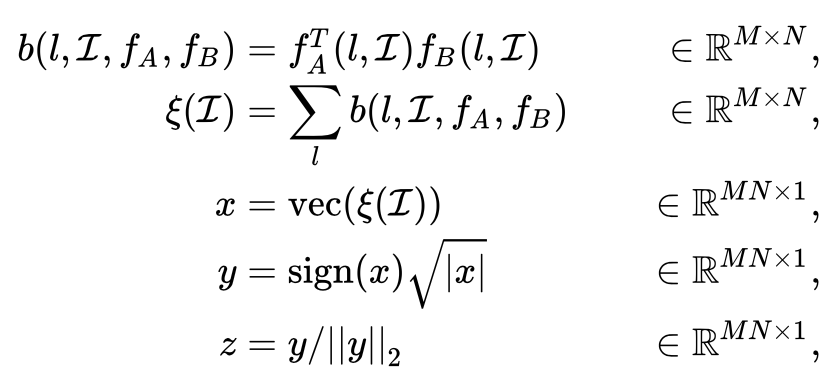

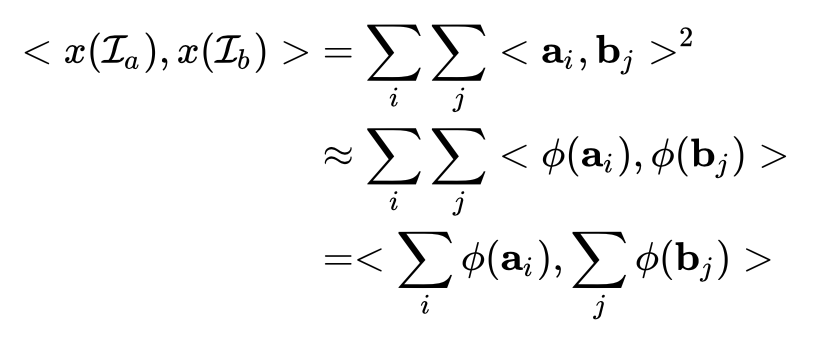

四、CBP: Compact Bilinear Pooling

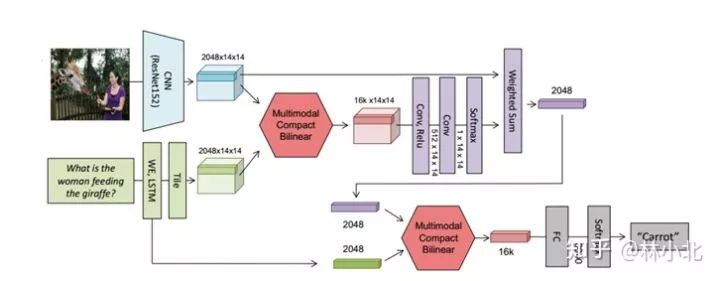

五、MCBP: Multimodal Compact Bilinear Pooling

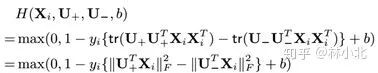

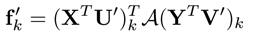

六、LRBP:Low-rank Bilinear Pooling

七、Grassmann Pooling

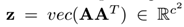

八、从bilinear pooling到billinear model

九、MLB:Multimodal Low-rank Bilinear Pooling

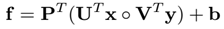

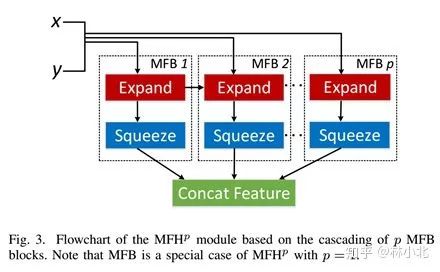

十、MFB:Multi-modal factorized bilinear pooling

十一、应用于VQA领域的《Bilinear attention networks》

-

应用于分类领域的《Hierarchical Bilinear Pooling for Fine-Grained Visual Recognition》

-

应用于ReID领域的《Part-Aligned Bilinear Representations for Person Re-Identification》

-

应用于三维物品识别领域的《Multi-View Harmonized Bilinear Network for 3D Object Recognition》

-

应用于动作识别领域的《Deep Bilinear Learning for RGB-D Action Recognition》

方便交流学习,备注:

昵称-学校(公司)-方向,进入DL&NLP交流群。

方向有很多:

机器学习、深度学习,python,情感分析、意见挖掘、句法分析、机器翻译、人机对话、知识图谱、语音识别等。

![]()

记得备注呦

推荐阅读:

【ACL 2019】腾讯AI Lab解读三大前沿方向及20篇入选论文

【一分钟论文】IJCAI2019 | Self-attentive Biaffine Dependency Parsing

【一分钟论文】 NAACL2019-使用感知句法词表示的句法增强神经机器翻译

【一分钟论文】Semi-supervised Sequence Learning半监督序列学习

【一分钟论文】Deep Biaffine Attention for Neural Dependency Parsing

详解Transition-based Dependency parser基于转移的依存句法解析器

经验 | 初入NLP领域的一些小建议

学术 | 如何写一篇合格的NLP论文

干货 | 那些高产的学者都是怎样工作的?

一个简单有效的联合模型

近年来NLP在法律领域的相关研究工作

![]()

让更多的人知道你“在看”

![]()

登录查看更多

相关内容

Arxiv

4+阅读 · 2018年12月28日