BAT机器学习面试1000题(496~500题)

点击上方 ⬆ 蓝字关注七月在线实验室

BAT机器学习面试1000题(496~500题)

496题

下面哪个/些超参数的增加可能会造成随机森林数据过拟合?

A、树的数量

B、树的深度

C、学习速率

点击下方空白区域查看答案

▼

497题

下列哪个不属于常用的文本分类的特征选择算法?

A、卡方检验值

B、互信息

C、信息增益

D、主成分分析

点击下方空白区域查看答案

▼

498题

机器学习中做特征选择时,可能用到的方法有?

A、卡方

B、信息增益

C、平均互信息

D、期望交叉熵

E、以上都有

点击下方空白区域查看答案

▼

499题

下列方法中,不可以用于特征降维的方法包括

A、主成分分析PCA

B、线性判别分析LDA

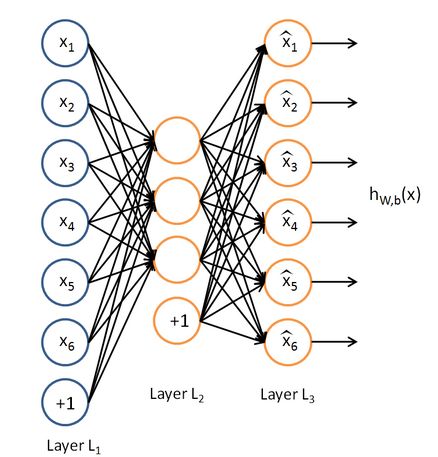

C、深度学习SparseAutoEncoder

D、矩阵奇异值分解SVD

点击下方空白区域查看答案

▼

500题

下列哪些不特别适合用来对高维数据进行降维

A、LASSO

B、主成分分析法

C、聚类分析

D、小波分析法

E、线性判别法

F、拉普拉斯特征映射

点击下方空白区域查看答案

▼

题目来源:七月在线官网(https://www.julyedu.com/)——面试题库——笔试练习——机器学习

今日推荐

我们的【深度学习集训营第二期】火热报名中。从TensorFlow起步实战BAT工业项目。11月13日起正式上课,为期一个多月,努力5周,挑战年薪40万,甚至更多薪!

今天最后一天优惠价,明天10.1将涨价500元!有意的亲们抓紧时间喽,报名即送三门课程,《机器学习工程师 第八期》、《深度学习 第三期》、《TensorFlow框架案例实战》,更好的助力您学习深度学习集训营课程。且2人及2人以上组团报名,可各减500元,想组团者请加微信客服:julyedukefu_02

挑战高薪,从现在开始~

更多资讯

请戳一戳

往期推荐

拼团,咨询,查看课程,请点击下方 【阅读原文】