![]()

编译 | 蒋宝尚

关于AI是什么,学界和业界已经给出了非常多的定义,但是对于AI理解,探讨尚不足。换句话说,计算机科学家解释深度神经网络(DNNs)的能力大大落后于我们利用其取得有用结果的能力。

当前理解深度神经网络的常见做法是在单个神经元特性上“折腾”。

例如,激活识别猫图像的神经元,而关闭其他神经元的“控制变量法”。这种方法的学术术语叫做“类选择性”。

由于直观和易理解,“类选择性”在学界广泛应用。诚然,在训练过程中,这类可解释的神经元确实会“选择性地”出现在各种不同任务网络中。例如,预测产品评论的神经网络,选择性地含有识别积极或消极情绪的神经元。

那么,问题来了!

这些易于解释的神经元是深度神经网络发挥作用所必须的么?

这就像研究汽车尾气和理解汽车速度推动力一样,毕竟汽车尾气和速度有关,但并不是汽车的动力。显然,在此例子中,“类选择”应该是发动机还是尾气?这是个疑问句。

因此,在最新一篇论文中“SELECTIVITY CONSIDERED HARMFUL: EVALUATING THE CAUSAL IMPACT OF CLASS SELECTIVITY IN DNNS”,Facebook AI 的研究人员经过研究,用证据断言:

即使神经元没有“类选择性”,深度神经网络也能发挥作用。事实上,易于解释的神经元会损害深度神经网络的功能,甚至使网络更容易受到随机失真输入的影响。

FB AI论文:类选择性的因果影响。地址:https://arxiv.org/pdf/2003.01262.pdf

具体而言,研究人员开发了一种新的技术,在能够直接控制DNN神经元的类别选择性的情况下,得出了上述结论。

这个结论有助于证明,如果这些方法没有经过严格的测试和验证的话,

用过度依赖基于直觉的方法来理解深度神经网络会被误导。

因此,为了充分理解人工智能系统,必须努力寻找不仅是直观的,而且是以经验为基础的方法。

类选择虽然做为一种工具已经广泛应用于深度神经网络的可解释性,但是易于解释的神经元对于深度神经网络的重要性的研究尚少。近期,虽然也有相关研究,但不同的研究报告得出了相互矛盾的结果,例如上述论文。

Facebook AI 的研究员用一种操纵“类选择性”的新方法解决了这个问题:当训练网络对图像进行分类时,我们不仅指示网络提高其分类图像的能力,还增加了减少(或增加)其神经元中类选择性数量的约束。

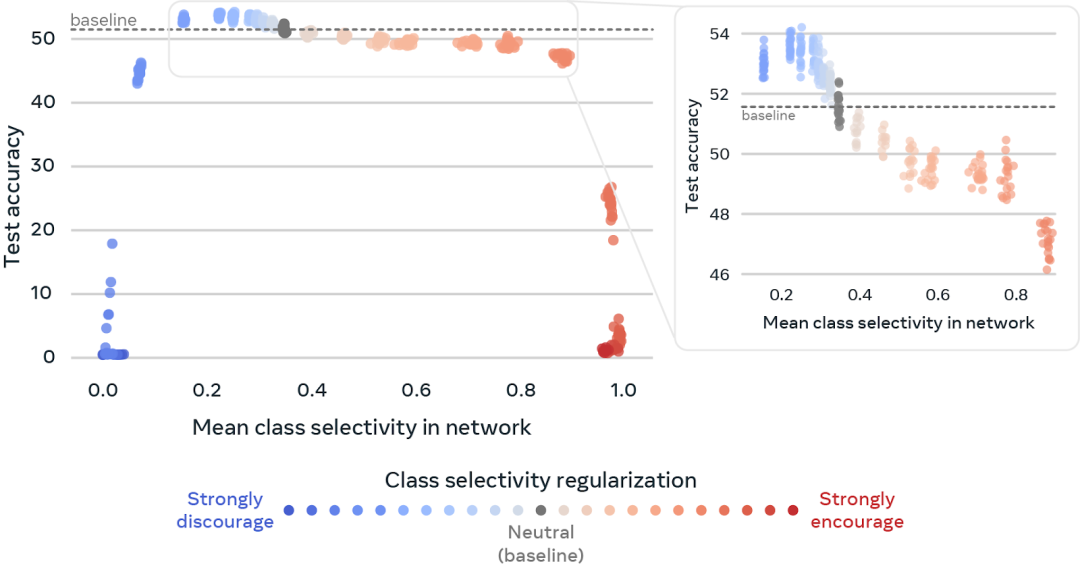

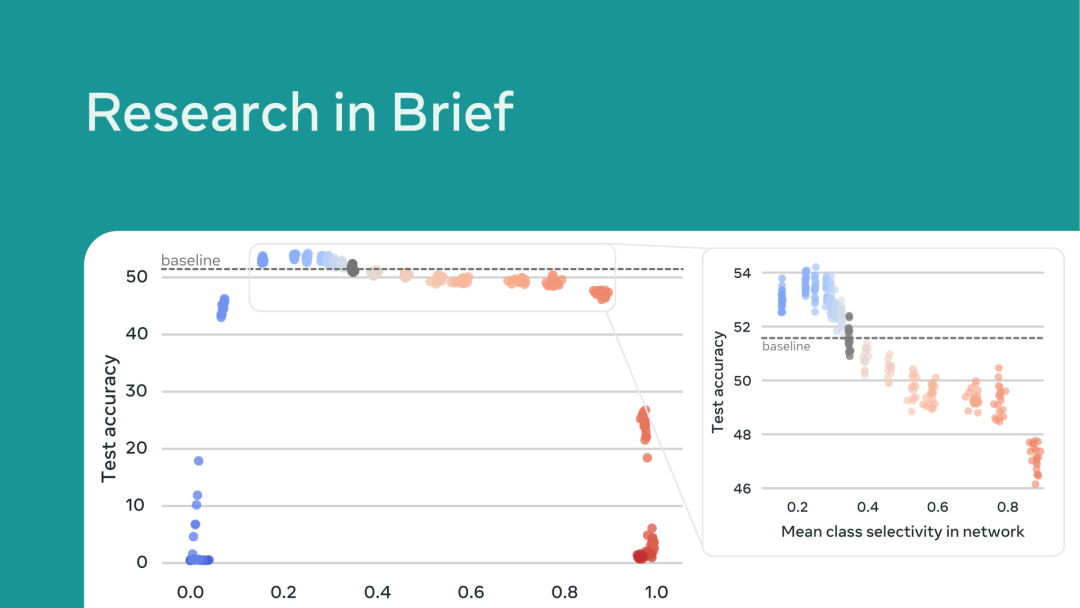

如上图所示,研究员展示了在深度神经网络中操纵神经元的类选择性如何影响DNN正确分类图像的能力(特别是对于在小规模ImageNet上训练的ResNet18)。上图中的每个点代表一个DNN。圆点的颜色代表了阻止或者鼓励DNN神经元中类选择性的程度。X轴表示DNN中神经元的平均类别选择性,y轴表示DNN对图像分类的精确度。

灰色点意味着中性,代表此类型中DNN中自然出现的类选择性水平,将其用作比较分类精度的基线。

研究发现,

通过不鼓励类选择性(蓝点),可以将测试准确率提高2%以上。相反,鼓励类选择性(红点)会对DNN的图像分类能力产生迅速的负面影响。

此外,研究员还放大了数据的一个子集,更好地说明了减少和增加类选择性的效果。

综上,研究员使用一个单一参数控制研究类选择性对网络的重要性。改变这个参数可以改变鼓励激活还是阻止激活容易解释的神经元,以及改变到什么程度。这提供了一个单一的旋钮( single knob ),可以用它来操纵网络中所有神经元的类选择性。用这个旋钮做了实验,发现:

1、当阻止激活DNNs的类选择性时,对性能的影响很小,在某些情况下甚至提高了性能。这些结果表明,尽管DNN在任务和模型中无处不在,但类选择性并不是DNN功能的重要组成部分,有时甚至会对DNN功能产生负面影响。

2、当我们增加DNNs中的类选择性时,我们发现对网络性能有显著的负面影响。这表明,类选择性的存在并不能保证DNN将正常工作。

3、与研究环境相比,部署在现实世界中的DNN通常处理更多噪声和更多失真的数据。例如,DNN在训练过程中,可能会从维基百科上看到非常清晰的猫的图像,而在现实世界中,DNN需要处理一张黑暗的、模糊的猫逃跑的图像。此外,

类选择性的降低使得DNN对诸如模糊和噪声之类的自然扭曲具有更强的鲁棒性。

有趣的是,降低类选择性也使DNN更容易受到有针对性的攻击,在这些攻击中,图像被有目的地篡改从而欺骗DNN。

这些结论之所以出人意料,有两个原因:一是类选择性已被广泛用于理解DNN的功能,二是类选择性在大多数DNN中是自然存在的。

研究人员的发现还表明,在没有类选择性操作的情况下,DNN自然会学习尽可能多的类选择性,而不会对性能产生负面影响。

这引出了一个更深层次的问题,研究人员希望在未来的工作中回答这个问题:

如果对于良好的性能不是必需的,为什么网络要学习类选择性?

https://ai.facebook.com/blog/easy-to-interpret-neurons-may-hinder-learning-in-deep-neural-networks/

AI科技评论联合【机械工业出版社华章公司】为大家带来15本“新版蜥蜴书”正版新书。

在10月24号头条文章《1024快乐!最受欢迎的AI好书《蜥蜴书第2版》送给大家!》留言区留言,谈一谈你对本书内容相关的看法和期待,或你对机器学习/深度学习的理解。

AI 科技评论将会在留言区选出 15名读者,每人送出《机器学习实战:基于Scikit-Learn、Keras和TensorFlow(原书第2版)》一本(在其他公号已获赠本书者重复参加无效)。

活动规则:

1. 在留言区留言,留言点赞最高的前 15 位读者将获得赠书。获得赠书的读者请联系 AI 科技评论客服(aitechreview)。

2. 留言内容会有筛选,例如“选我上去”等内容将不会被筛选,亦不会中奖。

3. 本活动时间为2020年10月24日 - 2020年10月31日(23:00),活动推送内仅允许中奖一次。

![]()

点击阅读原文,直达NeurIPS小组~