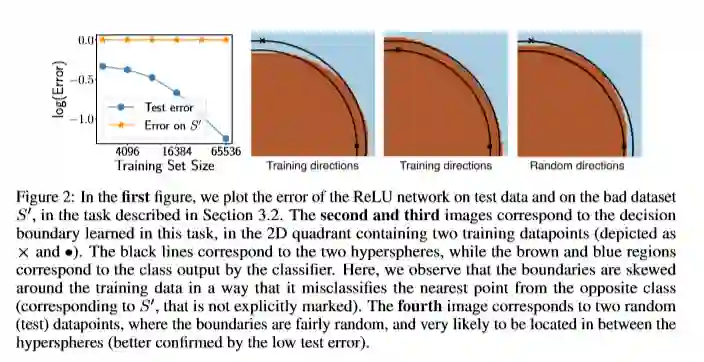

简介: 为了解释超参数化深度网络令人惊讶的良好泛化行为,最近的工作开发了各种泛化边界学习方法,这些方法都是基于统一收敛的基础学习理论技术。尽管众所周知,存在多个边界的数值很大,但通过大量实验,我们发现了这些边界的更多相关方面:在实践中,这些边界会随着训练数据集的大小而增加。然后,以我们的观察为指导,我们提供了由梯度下降(GD)训练的过参数化线性分类器和神经网络的示例,其中即使证明了最大程度地考虑了GD的隐性偏差,也证明均匀收敛不能“解释泛化”。更准确地说,即使我们仅考虑GD输出的分类器集,其测试误差小于我们的设置中的一些误差,我们仍然表明,在这组分类器上应用(双面)均匀收敛只会产生虚无泛化保证大于1−ε。通过这些发现,我们对基于统一收敛的泛化边界的威力提出了疑问,以提供为什么超参数化的深层网络能够很好地泛化的完整情况。

本文提出了本质上是负面的结果,表明许多现有的(基于规范的)深度学习算法的性能边界无法达到他们要求的结果。作者进一步说,当其他研究者继续依靠双边一致收敛的机制时,他们将无法达到自己宣称的结果。虽然本文没有解决(也不假装解决)深层神经网络中的泛化问题,但是将该算法“钉死在十字架上”(培根原话“An Instance of the Fingerpost”),指出机器学习领域应该关注另一个不同的地方。

作者介绍: Vaishnavh Nagarajan,卡内基梅隆大学(CMU)计算机科学系五年级的博士生。他的兴趣在于机器学习和人工智能的算法和基础方面。目前,他正在研究如何在有监督和无监督的学习环境中从理论上理解深度学习中的泛化。在过去,他从事过更传统的学习理论、多智能体系统和强化学习。

Zico Kolter,卡内基梅隆大学计算机科学学院计算机科学系的副教授。 除了在CMU的全职工作之外,还任博世AI中心(BCAI)的AI研究首席科学家,工作重点是机器学习,优化和控制。 具体来说,就是使深度学习算法更安全,更可靠,更易于解释。个人主页:https://www.csd.cs.cmu.edu/people/faculty/zico-kolter