牛津大学YARIN GAL《贝叶斯深度学习》入门教程,336页ppt

【导读】机器学习暑期班(MLSS)是一门关于统计机器学习和推理的现代方法的课程。近日,MLSS 2019莫斯科进行多项关于机器学习的教程讲授。其中,牛津大学Yarin Gal教授带来《贝叶斯深度学习》的教程报告,详细讲解了概率建模推断、不确定性度量、深度贝叶斯推断等,是很好的学习资料。

贝叶斯深度学习

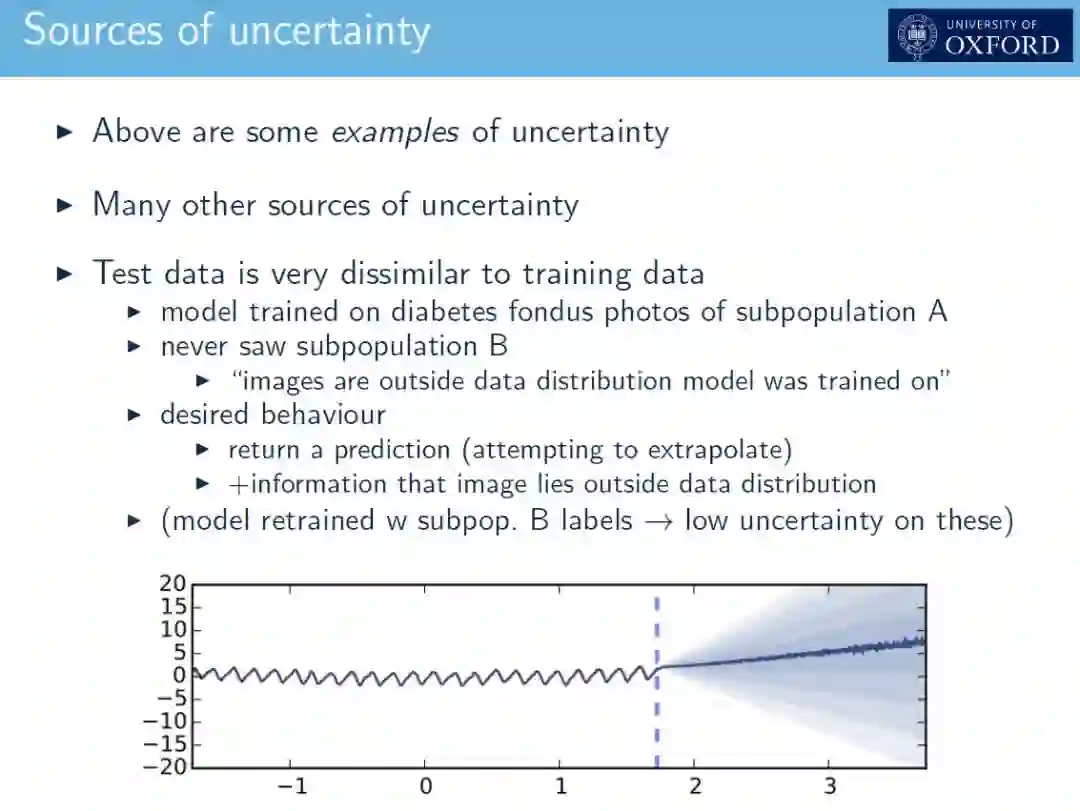

虽然深度学习对于机器学习来说是革命性的,但是大多数现代的深度学习模型既不能表示它们的不确定性,也不能利用概率论中研究得很好的工具。随着最近将贝叶斯方法与深度学习相结合的工具和技术的发展,这种情况开始发生变化。过去几年,随着利用贝叶斯技术的新型深度学习模型的引入,以及包含深度学习元素的贝叶斯模型的引入,这两个领域的交集受到了社会各界的极大关注[1-11]。事实上,贝叶斯方法在深度学习中的应用可以追溯到20世纪90年代,由Radford Neal[12]、David MacKay[13]和Dayan等人的开创性著作。这些给了我们工具来推断深层模型的信心,并在许多任务上实现了最先进的性能。然而,当新的需求出现时(如大数据的可伸缩性),早期的工具没有适应,因此被遗忘了。鉴于该领域的新进展,目前正在重新考虑这些想法,产生了许多令人兴奋的新结果。

贝叶斯模型植根于贝叶斯统计,并且很容易从该领域的大量文献中获益。相比之下,深度学习缺乏扎实的数学基础。相反,深层学习的经验发展往往是通过隐喻来证明的,从而避开了无法解释的原理。这两个领域在各自的社区中被认为是相当对立的。也许令人惊讶的是,大多数现代的深度学习模型都可以转换为在贝叶斯设置下执行近似推理。其意义是深远的:我们可以使用丰富的贝叶斯统计文献和深度学习模型,用这种技术解释许多稀奇古怪的东西,将深度学习的结果结合到贝叶斯模型中,等等。

在这次演讲中,我将回顾一个新的理论,它将贝叶斯建模和深度学习联系起来,并通过一系列的实际应用来展示框架的实际影响。我还将探索未来研究的开放性问题——站在这一令人兴奋的新领域前沿的问题。

http://bdl101.ml/

更多请下载查看

更多内容,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BDL2019”就可以获取完整版PPT下载链接~

参考文献

Kingma, DP and Welling, M, ‘’Auto-encoding variational bayes’’, 2013.

Rezende, D, Mohamed, S, and Wierstra, D, ‘’Stochastic backpropagation and approximate inference in deep generative models’’, 2014.

Blundell, C, Cornebise, J, Kavukcuoglu, K, and Wierstra, D, ‘’Weight uncertainty in neural network’’, 2015.

Hernandez-Lobato, JM and Adams, R, ’’Probabilistic backpropagation for scalable learning of Bayesian neural networks’’, 2015.

Gal, Y and Ghahramani, Z, ‘’Dropout as a Bayesian approximation: Representing model uncertainty in deep learning’’, 2015.

Gal, Y and Ghahramani, G, ‘’Bayesian convolutional neural networks with Bernoulli approximate variational inference’’, 2015.

Kingma, D, Salimans, T, and Welling, M. ‘’Variational dropout and the local reparameterization trick’’, 2015.

Balan, AK, Rathod, V, Murphy, KP, and Welling, M, ‘’Bayesian dark knowledge’’, 2015.

Louizos, C and Welling, M, “Structured and Efficient Variational Deep Learning with Matrix Gaussian Posteriors”, 2016.

Lawrence, ND and Quinonero-Candela, J, “Local distance preservation in the GP-LVM through back constraints”, 2006.

Tran, D, Ranganath, R, and Blei, DM, “Variational Gaussian Process”, 2015.

Neal, R, ‘’Bayesian Learning for Neural Networks’’, 1996.

MacKay, D, ‘’A practical Bayesian framework for backpropagation networks‘’, 1992.

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!560+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程