【学界】英伟达MIT黑科技 :用AI生成模型快速构建虚拟世界

来源:Venturebeat

编辑:大明

【导读】英伟达与MIT合作推出视频合成AI新技术,直接用现实视频生成逼真的虚拟世界。未来或许只需一段手机视频,你就可以真正进入心仪的游戏中去当英雄了!

最近英伟达的黑科技有点多。

英伟达的研究人员打造出一个新的AI生成模型,可以使用来自YouTube等来源的真实视频创建虚拟环境,这可能影响游戏开发和人工智能的未来。

“这是一种新的渲染技术,基本上只需使用草绘图作为输入,可以处理对象的高级表示以及它们在虚拟环境中的交互方式。由模型实际上处理细节、细化纹理和照明环境等等,最后输出完全渲染的图像。“英伟达应用深度学习副总裁Bryan Catanzaro在接受采访时表示。

Bryan Catanzaro,看扮相就像是搞黑科技的

这一系统使用百度的自动驾驶项目的Apolloscape采集的视频进行训练。系统将这些视频的草绘图,比如树木、建筑物、汽车和行人等都输入到模型中。

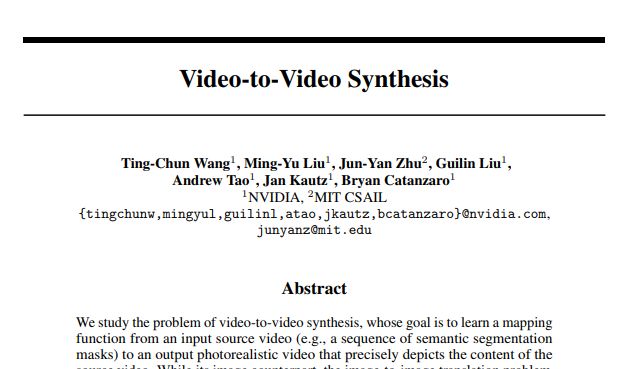

Catanzaro和其他英伟达的研究人员与MIT CSAIL的学生们合作,撰写了题为"Video-to-Video Synthesis"的论文,文中对这一技术做了详细阐述。

论文地址:

Video-to-Video Synthesis

https://arxiv.org/pdf/1808.06601.pdf

该模型可以实现快速生成合成环境,可用于训练强化学习的智能体,或让游戏中的玩家产生身临其境之感。

由输入分割映射视频生成的逼真输出视频。左上为输入,其余为不同模型的输出,右下为英伟达和MIT最新模型vid2vid的输出

“想象一下,如果你能在电子游戏中扮演自己的角色。而且,只需要一段自己手机中的视频,就能让你进入虚拟环境,穿上闪亮的盔甲,像骑士一样去做伟大的事情。

“英伟达长期以来一直致力于图形处理技术,因此我们非常高兴能够将图形技术带入AI时代,并使用AI技术生成图形,我们可以从现实世界的视频中了解事物的运作方式,然后根据学到的知识,合成出逼真的、基于实际内容的虚拟图像。”

系统能够考虑诸如对象位置,对象之间的关系以及用于定义对象边缘的映射之类的要素。

英伟达将于NeurIPS 2018大会上演示视频并分享该技术的其他细节。

左侧为样例面部图像输入,中间为草绘图,右侧为输出

Nvidia团队最初的灵感来自于Alexei Efros和加州大学伯克利分校的其他研究人员的Pix2Pix系统的成果。英伟达在此基础上与加州大学伯克利分校的AI研究人员合作,打造了Pix2PixHD系统作为回应。

今年早些时候,加州大学伯克利分校的研究人员还制作了能够跳舞、翻转以及其他20种复杂动作的模型。

样例舞蹈动作——动作提取——输出

“这是我们第一次实现交互式的人工智能场景渲染,我们为此感到自豪。但这项技术目前还处于早期阶段,未来的目标是提供更高质量、通用性更好的输出,以便能够处理更多种类的场景。我对这一技术未来的发展方向感到非常兴奋。”Catanzaro说。

论文链接:

https://arxiv.org/pdf/1808.06601.pdf

☞ OpenPV平台发布在线的ParallelEye视觉任务挑战赛

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【学界】Ian Goodfellow等人提出对抗重编程,让神经网络执行其他任务

☞【学界】六种GAN评估指标的综合评估实验,迈向定量评估GAN的重要一步

☞【资源】T2T:利用StackGAN和ProGAN从文本生成人脸

☞【学界】 CVPR 2018最佳论文作者亲笔解读:研究视觉任务关联性的Taskonomy

☞【业界】英特尔OpenVINO™工具包为创新智能视觉提供更多可能

☞【学界】ECCV 2018: 对抗深度学习: 鱼 (模型准确性) 与熊掌 (模型鲁棒性) 能否兼得