仅训练996个剧本,迪士尼用AI自动生成动画

源 / 智东西精选

近日,迪士尼研究所和罗格斯大学的科学家共同发表了关于AI文本生成动画模型的论文。

研究人员表示,这种算法只要在输入的文本中描述某些活动即可,不需要注释数据和进行大量训练就能产生动画。

这篇论文中,研究人员进一步提出了端到端模型,这种模型可以创建一个粗略的故事版和电影剧本的视频,用来描绘电影剧本中的文字。此外,这个系统还可用于生成训练端到端神经系统的训练数据。

迪士尼罗格斯大学关于AI文本生成动画模型的论文

迪士尼一直十分关注AI领域的进展,多年来一直尝试将AI技术融入自己的各项产业当中,也曾多次与大学或其他研究机构合作,开发了一系列训练模型。这次,迪士尼又将文本转换视频的技术进一步加强,使模型自动生成动画。

一、更复杂的文本如何转换成动画?

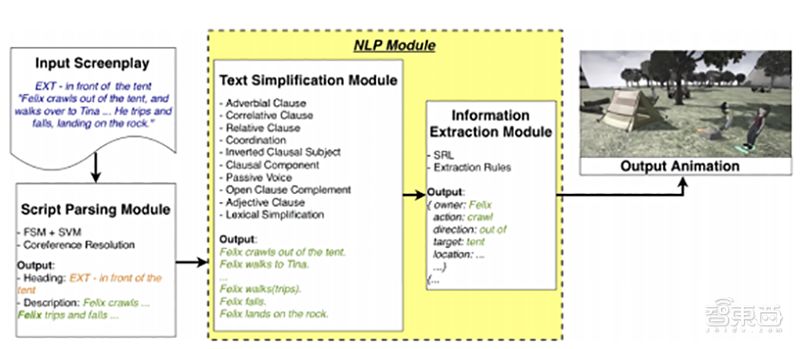

迪士尼的文字转换为动画AI系统图解

将文本转换为动画并不是一项简单的任务,大多数将文本转换为视频的工具不能处理复杂句子,因为输入的句子和输出的动画都没有固定的结构。为了克服这种问题,两位论文作者共同构建了一个包含多个组件模块的神经网络。

这个网络由几个部分组成: 一个可以自动将文本与剧本场景描述隔离开的脚本解析模块、一个自然语言处理模块(使用一套语言规则简化复杂句子,并从简化句子中提取信息,转化为预定义的动作表示),以及一个将所述表示转换为动画序列的生成模型。

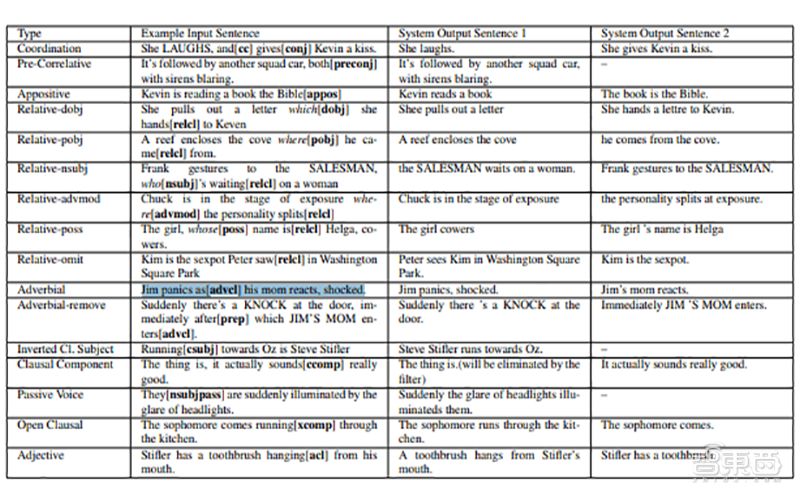

迪士尼AI系统的文本简化阶段

简化后的方法能更容易的提取脚本中的关键信息,新研发的系统能够自主地将复杂句子拆分,并组装成更简单的句子,对其进行递归处理,直到不可能进一步简化。

接下来,系统将“协调”句法关系相同、功能相同的句子。最后,词汇简化器将简化后句子中的动作,与预定义库中的52个动画匹配(通过同义词词典扩展到92个)。

然后,在一个名为Cardinal的管道中将动作输入,并在一个流行的视频游戏引擎Unreal中创建预可视化。利用预定义的动画库、预加载的对象以及可用于创建角色的模型,最终,这个系统可以生成一个3D动画视频。

为了训练这个系统,研究人员从IMSDb、SimplyScripts和ScriptORama5等可自由获取资源的电影剧本数据库中,搜集了超过1000个剧本,从中选取了996个,编写了场景描述语料库。这个语料库由525,708个描述组成,包含1,402,864个句子,其中920,817个(超过40%)至少有一个动作动词。

二、动画合理性达68%,研究人员将进一步优化系统

在一项定性测试中,22名参与者以5分制标准,来评估系统生成的20个动画(例如,如果所显示的视频对文本来说是合理的动画,则视频中描绘了多少文本信息,以及视频中有多少信息存在于文本中),68%的参与者认为系统通过输入剧本生成了“合理”的动画。

研究人员认为,除了系统本身的局限性之外,生成动画的“不合理”成分也与文本中关于行动的模糊性有关。他们承认这个系统并不完美,它的动作和对象列表并不是详尽无遗的。有时候,词汇简化不能将动词(如“watch”)映射到相似的动画(“look”)中,或者只能为原句中有很多主语的动词创建几个简化的句子。

内部评价和外部评价显示了该系统性能的合理性。研究人员计划在今后的工作中,重点关注如何能使系统更充分的利用文本中描述的话语信息,来解决文本中关于行动模糊性的问题。

三、迪士尼的AI研究历程

从技术的角度来看,迪士尼似乎很重视在AI方面的研究,也有过诸多尝试。

2017年8月,迪士尼与苏黎世联邦理工学院合作,开发了将画面与声音连接起来的机器学习系统,这种系统可以将语音与画面结合起来,使视频内容看起来更加连贯。

研究人员将一系列含有杂音和背景音不纯的视频输入系统,用来训练模型。训练后的系统能够把画面信息和声音信息做出关联。比如,随着关门的动作进行,人们会“想象”特定的关门声音。本质上,其实是人们把关门相关的视觉信息跟声音信息做了连接。

这项研究想要做的,就是培养AI系统的这种关联性,他们训练的AI系统成功的将关门、杯子碰撞和汽车在马路上行驶画面于声音进行了配对。这也将帮助视频剪辑师更好地工作。

迪士尼发布AR形象与实际物体互动图片

2018年1月,迪士尼的研究人员发布了一项可以使动画AR角色与实际的物体互动的黑科技。

比如,当一个3D卡通角色映射在家里的客厅地板上时,这个虚拟的形象会跳过台阶或绕开障碍物行走,甚至当宠物狗冲过来的时候还可能一下把它撞到。

这项研究做到了AR体验与现实的互动,给动画带来了更多乐趣。说不定以后我们自己也可以和动画里的人物进行互动了。

2018年9月,迪士尼AI研究中心还尝试了让机器人完成像超级英雄一样的特技动作。迪士尼的特技实验包括训练机器人的神经网络来控制机器人,以此完成上天入地、爬行、划船等动作,人类能做的它可以,人类不能做的,它也可以。

四、文本转换视频技术早已应用

其实,从文本片段创建原始剪辑的AI并不是最新的研究发现。

2016年4月,台湾创企GliaCloud就利用AI技术,将文本信息的主要内容以视频的形式展示了出来。这家AI视频制作公司在2015年,由全球48位Google云技术专家之一David Chen和在广告领域有着20年业务拓展经历的Dominique Tu在台湾共同创建。GliaStudio对指定文本的内容进行分析和总结之后,根据所提取的内容从自有资料库或是公共资源中寻找相关的照片、视频片段甚至画外音来生成影片。

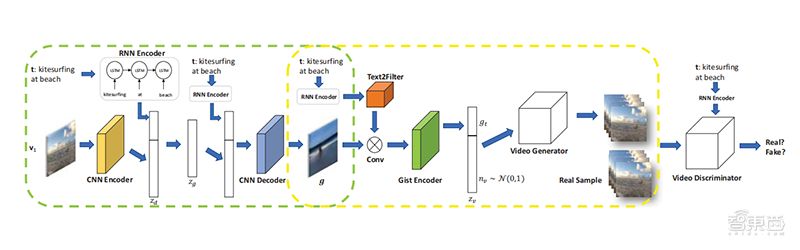

去年,也有研究人员详细介绍了一个利用神经网络模仿生物神经元的系统,这种系统能够生成32帧长、6464像素的视频。研究人员表示,这种系统生成视频分两个阶段进行,第一阶段使用文本创建视频的要点,一般是背景颜色和对象布局的模糊图像。第二阶段同时考虑到要点和文本的其他内容,然后要点与文本内容结合,生成一段视频。

比如,将“在草地上打高尔夫球”这句话,生成一个人们在草地上打高尔夫球的视频。

从自然语言文本自动生成动画在很多领域都有应用,比如电影脚本编写、教学视频和公共安全等内容。

这些AI算法系统,可以为内容创作者提供更快的迭代、原型设计和概念验证,有助于提高剧本编写效率。

结语:AI生成动画或有更广阔的市场

研究人员表示,迪士尼进行AI自动生成动画的研究不是为了取代编剧和艺术家的工作,而是为了提高繁琐工作程序的效率。

虽然目前研究结果还不完善,生成动画的系统还不能百分之百将文本内容转换成动画,但是这项研究对于文本转换视频技术也是一次有意义的尝试。

迪士尼动画在全世界都有十分广泛的影响,塑造了一个又一个经典的动画形象。如今,他们在AI自动生成动画方面的研究也很可能影响整个动画电影制作市场,AI生成的方式也许将成为未来动画电影制作的新方向。

论文链接:https://arxiv.org/pdf/1904.05440.pdf

推荐阅读

12岁上中科大,17岁哈佛读博,面对质疑,31岁成为哈佛最年轻华人教授