可以估计不确定性的神经网络:SDE-Net

极市导读

SDE-Net具有预测概率分布以及度量预测结果的不确定性。本文通过介绍概念,分析模型构造,阐述理论以及实验论文等方式解详细分析了SDE-Net模型。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

不确定性

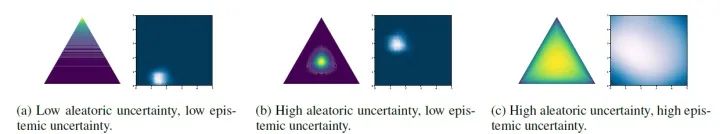

-

aleatoric uncertainty:来自于任务本身所固有的自然随机性(比如说label噪声等) -

epistemic uncertainty:由于缺乏训练数据所导致的,模型对于训练数据分布之外的样本是无知的

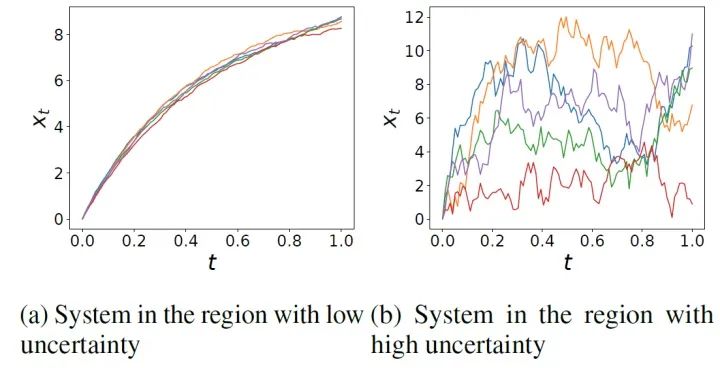

SDE量化不确定性

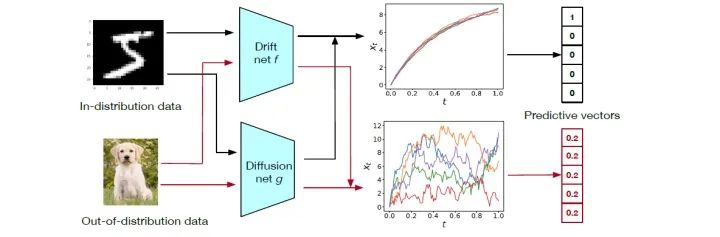

模型构造

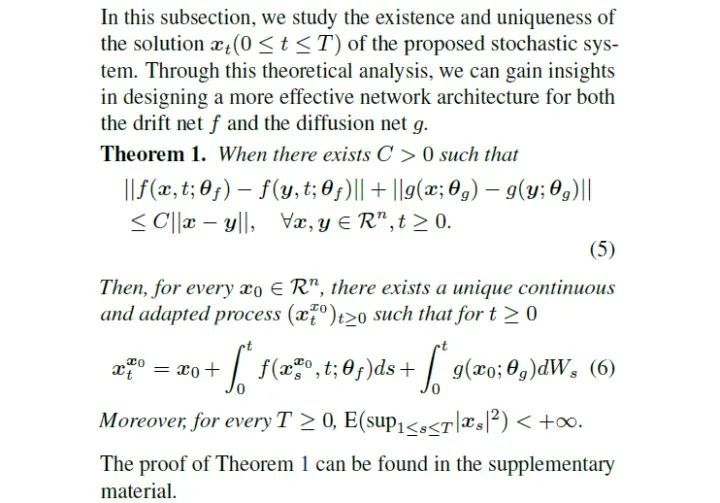

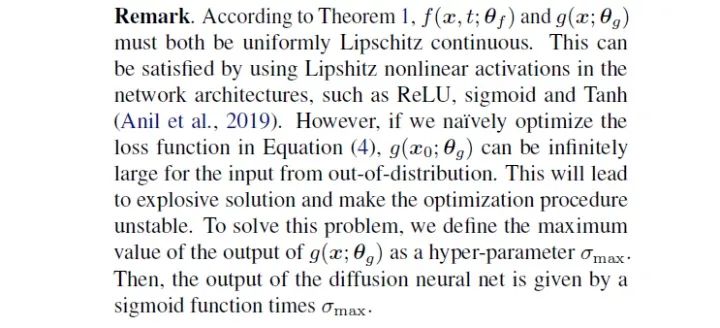

理论分析

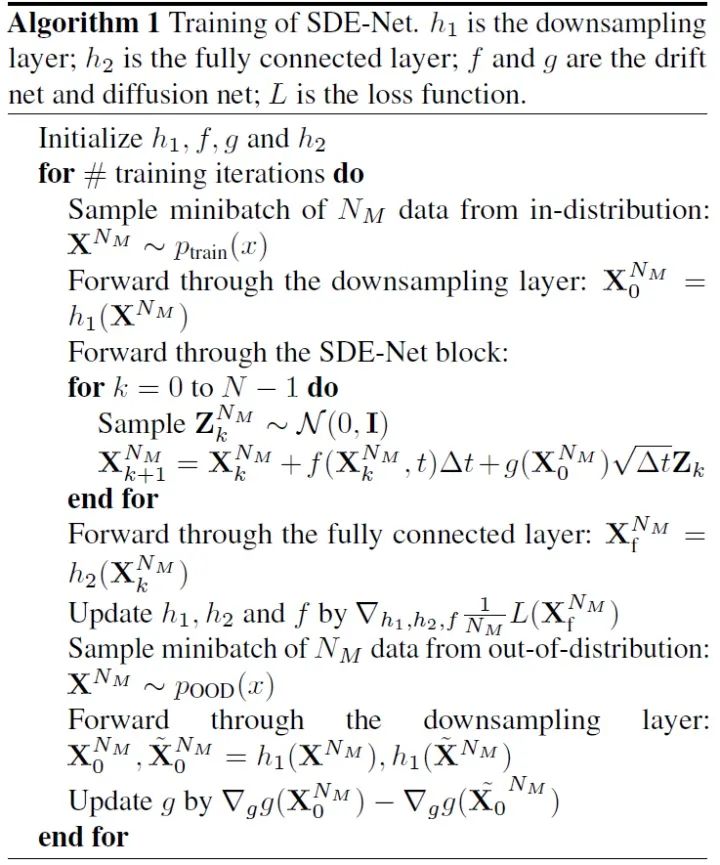

模型训练

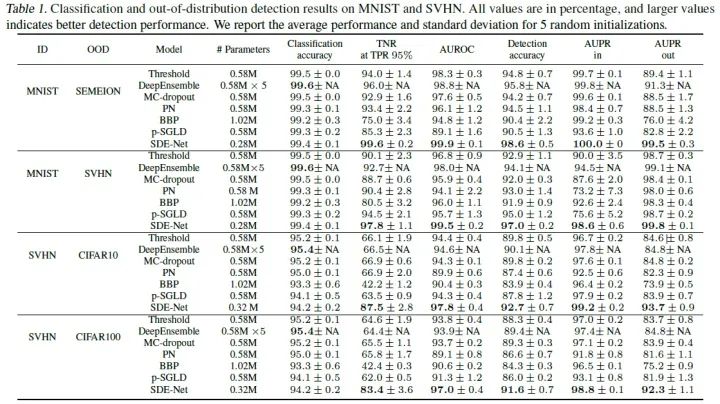

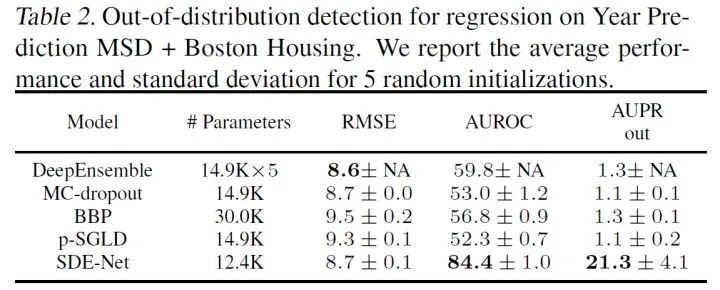

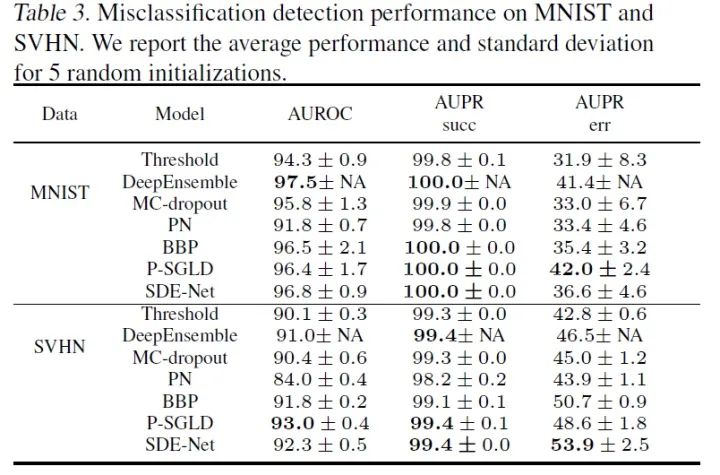

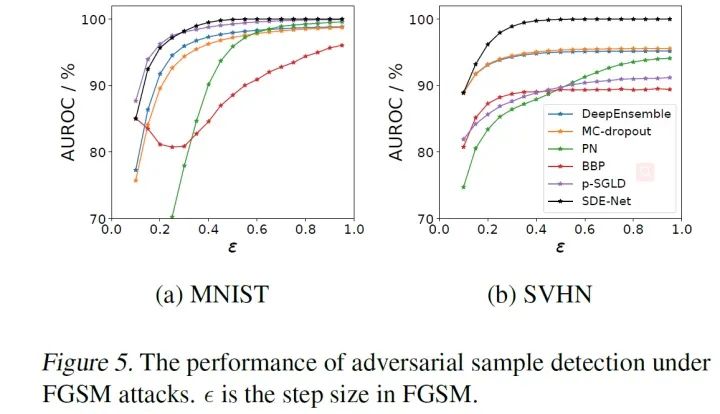

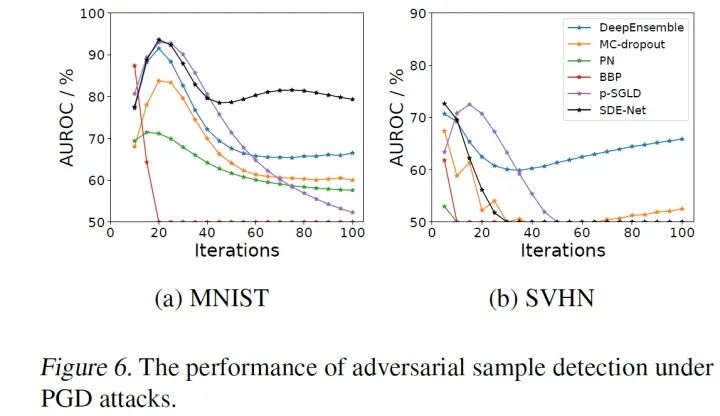

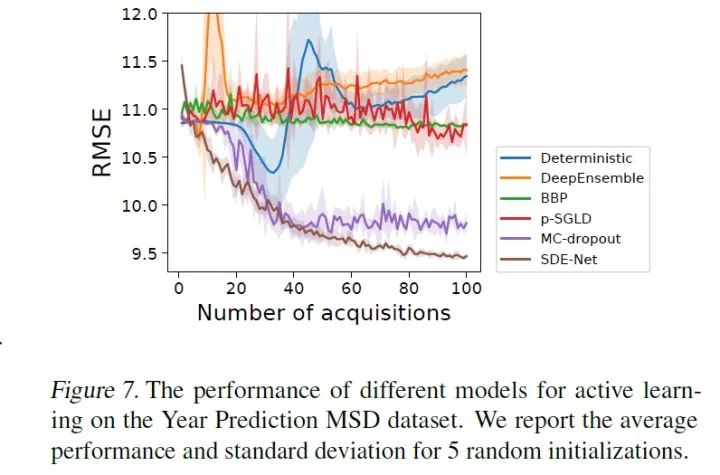

实验

-

True negative rate (TNR) at 95% true positive rate (TPR) -

Area under the receiver operating characteristic curve (AUROC) -

Area under the precision-recall curve (AUPR) -

Detection accuracy

总结

参考文献

推荐阅读

登录查看更多

相关内容

专知会员服务

54+阅读 · 2020年3月5日