本版空军条令注释(AFDN)阐述人工智能(AI)技术,并预判其在竞争连续体背景下空战行动中的作用。文件参考多类来源,包括相关联合与军种政策战略、公共法律、学术与工业界文献及领域专家咨询意见。本AFDN是对美国国防部(DoD)现有AI政策与战略的补充,旨在提供权威性与参考性,但不作为强制性指令。

本AFDN聚焦作战层级问题与潜在解决方案,支持空军条令开发。其旨在识别短期内对全军种产生影响的作战领域条令缺口,为指挥官与参谋团队制定战略及规划空战行动提供新兴经验教训与最佳实践的推广框架。

最后,本AFDN承认AI领域专家对相关术语与概念的精确定义存在分歧。为此,文件对AI术语进行描述性定义,促进空军人员理解,并为未来军种与联合AI政策协调奠定基础。

若本AFDN与联合或军种政策出版物存在冲突,美国空军(USAF)行动须以相应政策文件为准。

人工智能应用:空军核心职能

未来作战要求空军人员理解人工智能发展与空军职能之间的关联。空军人员需与科技界协同合作,识别适合应用人工智能与自主系统的作战缺口。人机编队(HMT)必须充分发挥人类直觉与推理的优势,结合人工智能的超高速数据处理能力,从而强化所有任务中的动能与非动能作战效果。

- 制空权作战

美国空军需通过攻防作战夺取制空权,作为联合作战组成部分。人工智能技术将强化复杂对抗环境下制空权与信息优势任务的执行效能。集成于空基导弹防御体系中的AI预警探测系统,可为空中作战指挥控制(C2)系统提供威胁数据,激活防御性防空反制单元。进攻性防空任务需依赖AI赋能的ISR系统、目标锁定机制与航空平台,全面支撑从敌区战斗空中巡逻(CAP)、压制敌防空(SEAD)到摧毁地面航空力量的空中遮断任务。

以自主无人机群与半自主协作战斗机(CCA)为例,此类平台可执行多样化制空任务。2024年5月,美空军部长搭乘搭载AI狗斗模块的改装F-16,彰显人机协同信任度的提升。作为自主协作平台(ACP)项目组成部分的CCA计划,验证了半自主战机对有人战机的支援能力。CCA作为武器平台或ISR平台的潜力,体现了人机编组(HMT)与人工导引交战的可能性,为后续发展奠定基础。

- 全球精确打击

在全球精确打击领域,空军致力于实现更快速、更精准的全天候全域打击能力。AI技术推动机载武器目标锁定能力的跨越式发展。例如,AI计算机视觉(CV)结合改进的目标识别跟踪算法,将最大限度降低高精度低附带损伤弹药的平民风险。AI建模技术持续增强隐身突防能力,提升拒止区域打击效能。在目标锁定与"传感器-射手"链路整合层面,AI赋能的自动化C2能力可加速决策周期、优化风险评估、提升打击时效。CCA与预测性维护技术的进步,正是AI增强全球精确打击能力的典型案例。

- 敏捷全球机动

敏捷战斗部署模式要求对抗环境下的自适应基地选择与快速响应后勤体系。AI技术通过生存性、效率、弹性与保障能力等指标,智能优选作战位置。预测性分析系统可大规模识别装备故障与使用趋势,优化预测性维护流程,同时改进库存管理与运输流程,强化自适应后勤规划。AFWERX与工业界合作开发的半自主空运能力即为例证:2024年8月"竹鹰/敏捷旗"演习中,某空中远征联队A4部门运用该能力,向多个分散地域投送20余项急需航材,实现战术级即时补给,缓解传统空运压力并加速战机恢复战备。此类实验验证了AI/机器学习系统对未来空军后勤的变革潜力。

- 全域情报监视侦察(ISR)

多源跨域数据融合的作战能力依托多模态AI系统(可处理异构数据格式)展现前景。此类系统可实现实时突发威胁侦测识别与多域态势感知同步。AI程序可消除军种专用情报平台间的数据壁垒,自主ISR平台则能在传统拒止区域实施持续声光电磁信号采集。

- 指挥控制(C2)

AI技术将优化目标锁定、资源分配、计划制定等流程,支撑多域C2与战场管理。对抗/降级/受限环境下的AI赋能通信网络可增强C2系统弹性:若作战中心通信中断,AI驱动网络可即时重构通信路径;上级C2失效时,系统可将数据流重定向至下级单元维持指挥链。

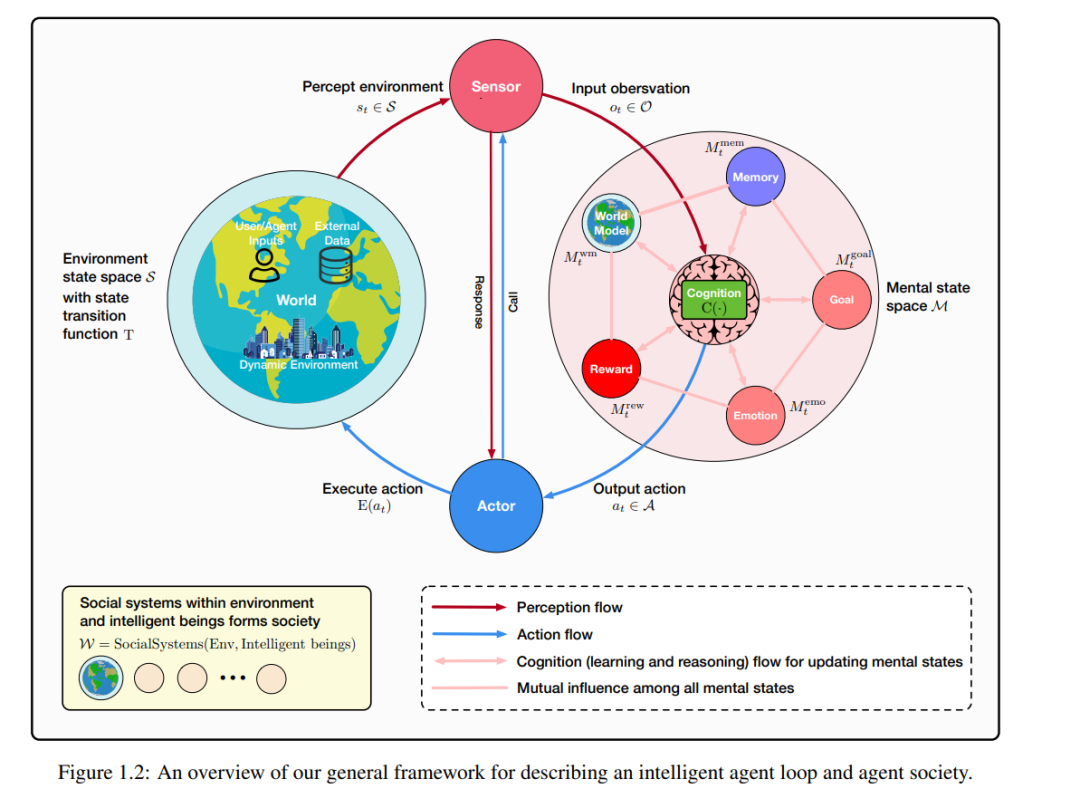

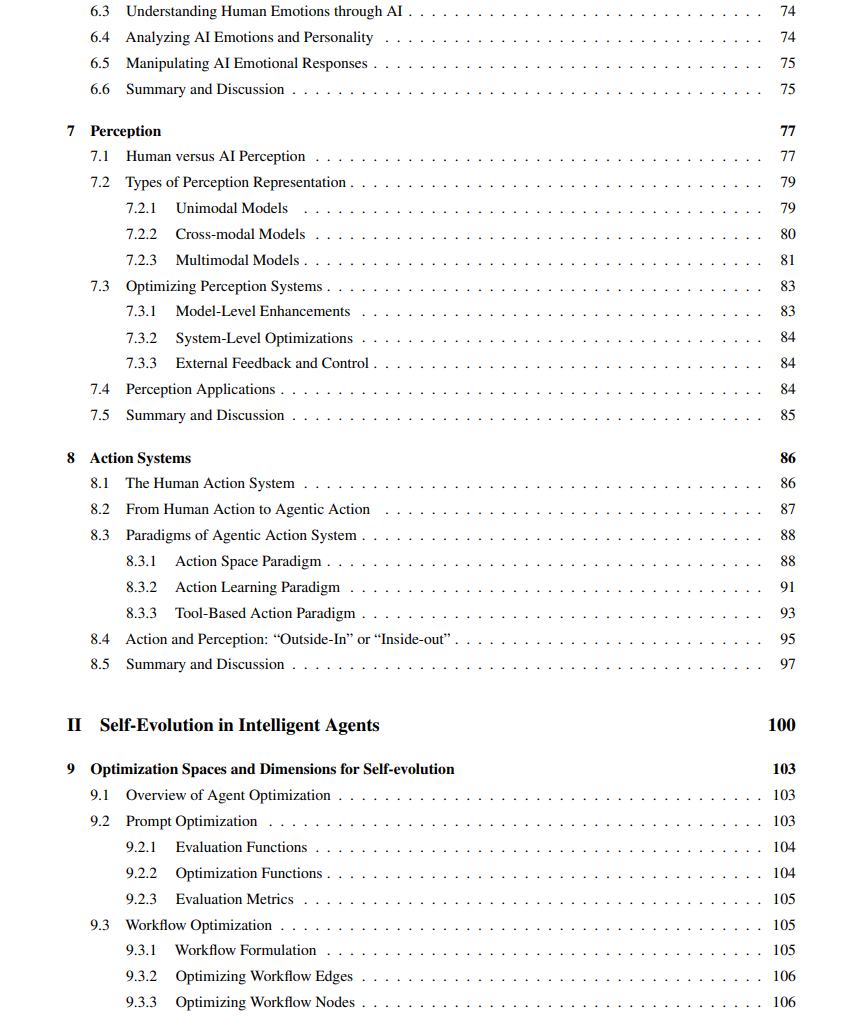

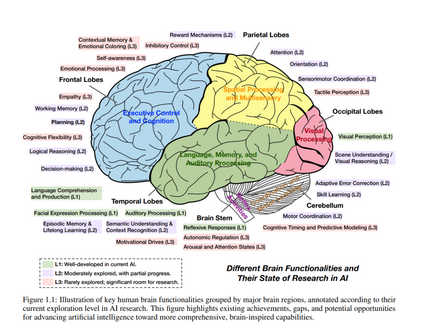

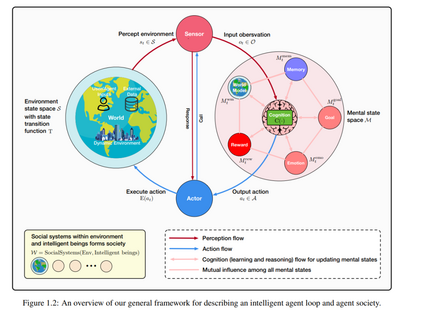

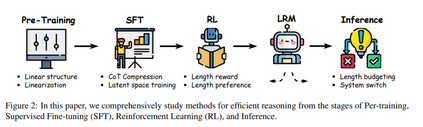

大型语言模型(LLMs)的出现引发了人工智能领域的深刻变革,推动了具备复杂推理能力、强大感知能力和多样化行为能力的高级智能体的发展。这些智能体正日益成为推动人工智能研究与实际应用的核心力量,其设计、评估与持续优化也带来了复杂且多维的挑战。 本综述提供了一个全面的视角,将智能体置于一种模块化、类脑启发式的架构之中,融合了认知科学、神经科学与计算研究的核心原理。我们的讨论分为四个相互关联的部分: 第一部分,我们探讨智能体的模块化基础,系统性地将其认知、感知与执行模块映射到人脑的功能结构上,并详细解析诸如记忆、世界建模、奖励处理以及类情感系统等关键组成部分。 第二部分,我们聚焦于智能体的自我增强与适应性进化机制,研究其如何通过自动优化范式实现能力的自主提升、对动态环境的适应与持续学习,涵盖新兴的AutoML技术与LLM驱动的优化策略。 第三部分,我们考察协作式与进化式多智能体系统,探索由智能体间的交互、合作与社会结构所涌现出的集体智能,并指出其中与人类社会行为的诸多相似之处。 第四部分,我们讨论构建安全、可靠与有益的人工智能系统的紧迫性,强调内在与外在安全威胁、伦理对齐、系统鲁棒性以及实际可行的风险缓解策略,从而实现可信赖的现实部署。 通过融合模块化AI架构与多学科的研究洞见,本综述明确了关键的研究空白、挑战与机遇,旨在激发技术创新,推动技术进步与社会福祉的有机结合。

项目的 GitHub 链接为: https://github.com/FoundationAgents/awesome-foundation-agents。

大型语言模型(LLMs)在自然语言与多模态理解、推理与生成等方面展现出前所未有的能力,彻底革新了人工智能(AI)领域。这些模型在大规模数据集上进行训练,展现出诸如推理、上下文学习、甚至初步规划等涌现能力。尽管它们在实现智能机器方面迈出了重要的一步,但尚未完全具备一个“智能体”所需的全部能力。 自人工智能诞生以来,研究人员便一直追求构建真正“智能”的系统,这种系统应能够学习、规划、推理、感知、交流、行动、记忆,并具备各种类似人类的能力与灵活性。这类系统即为“智能体”(intelligent agents),它们应当能够兼顾短期与长期思维,执行复杂任务,并与人类及其他智能体进行交互。虽然LLMs是实现智能体的重要基础,但我们仍未完全抵达终点。 本书稿对当前基于LLM的智能体研究现状进行了系统性的综述。过去已有大量关于智能体或LLMs的研究论文与专著,但鲜有文献能够全面覆盖二者的结合。虽然LLMs可为智能体提供诸多关键能力,但它们仅是构建更高级功能的基础。例如,LLMs虽然能辅助生成如旅行计划之类的方案,但尚无法为复杂的专业任务生成完整的规划,也无法在不产生幻觉的前提下维持长期记忆。此外,它们在自主执行现实世界任务方面的能力依然有限。 我们可以将LLMs视为“引擎”,而智能体则是基于这些引擎构建的“汽车”、“船只”或“飞机”。在这个引擎与载具的类比中,我们自然地思考:当前的LLM技术到底能为智能体提供多少能力?又有哪些功能尚无法实现?除了LLMs之外,还需要哪些技术才能构建一个真正能够在物理世界中自主行动与交互的智能体?全面集成LLM的智能体还面临哪些挑战?为了构建能够有效与人类协作、沟通的智能体,还需要哪些进一步的发展?有哪些是LLM智能体领域的“低垂果实”?当全面智能的LLM智能体出现后,它们将对社会产生哪些影响?我们应如何为这一未来做好准备? 这些问题不仅涉及当前对LLMs与智能体的工程实践扩展,也揭示了未来潜在的研究方向。为深入探讨这些问题,我们邀请了来自人工智能前沿领域的研究者,涵盖LLM开发、智能体设计等多个方向。 本书共分为四个部分。第一部分阐述了单个智能体的能力需求,并将其与人类在感知与行动方面的能力进行比较。第二部分探讨了智能体的进化能力,以及这种能力对智能工具(如工作流管理系统)的潜在影响。第三部分聚焦于“智能体社会”,强调其协作与集体行动的潜力。第四部分则讨论了伦理与社会层面的议题,包括智能体的安全性与责任问题。 本书面向研究人员、学生、政策制定者与行业实践者,同时也欢迎对人工智能、LLMs与智能体感兴趣的非专业读者。无论是本科生、研究生,还是科研与产业界的从业人员,都可以从本书中获得启发。本书不仅希望解答读者关于AI与智能体的现有疑问,更旨在激发他们提出新的问题。最终,我们希望有更多人能够加入这一充满潜力的研究领域,共同探索未来的智能系统。

人工智能(AI)自诞生以来,始终受到人类渴望创造具有人类智慧、适应性与目标导向行为之实体的驱动。这种迷恋的根源可追溯至古代神话与早期工程奇迹,体现了人类赋予人工造物以智能与自主意识的持久梦想。例如克里特岛上的青铜巨人塔洛斯(Talos)的故事中,这位由神明打造的巨型自动人巡逻海岸、抵御入侵者,象征着人类希望赋予人工造物以类人意图与行动能力的愿望。 类似地,文艺复兴时期的机械发明也试图将这种神话愿景具体化。列奥纳多·达·芬奇设计的仿人机器人,旨在模仿人类的动作与结构,是将幻想转化为可操作人工物的早期尝试之一。这些原始的想象与原型体现了将想象力与技术相融合的深层追求,也为后来的机器智能研究奠定了基础,最终在艾伦·图灵1950年提出的著名问题“机器能思考吗?”中达到高潮。 为回应这一问题,图灵提出了“图灵测试”作为评估机器是否能通过对话展现类人智能的框架,从而将AI研究的焦点从纯粹计算转向更广义的智能概念。几十年来,AI逐步从依赖预设逻辑的符号系统,演化为能够从数据中学习并适应新情境的机器学习模型。随着大型语言模型(LLMs)的兴起,这一演进迈入全新阶段,LLMs展现了在人类语言理解、推理与生成方面的惊人能力。 这一系列进展的核心在于“智能体”(agent)的概念——一个不仅能处理信息,还能感知环境、做出决策并自主行动的系统。起初,智能体仅是理论概念,而如今,它已成为现代AI的基石,推动了从对话助手到具身机器人等多个领域的发展,使AI系统能够更好地应对动态的现实世界环境。

1.1 智能体的兴起与发展

“智能体”这一概念是现代人工智能的重要支柱,代表一种能够感知环境、做出决策并采取行动以实现特定目标的系统。尽管这一理念在20世纪中叶才在AI领域被正式定义,但其思想源头早已体现在关于自主性与智能交互的早期探索中。 [3] 提出的一项广为引用的定义指出:智能体是“任何可通过传感器感知环境并通过执行器作用于环境的实体”。这一定义强调了智能体的双重特性——既是观察者也是行动者,能够动态适应环境,而非仅依赖静态规则。这一视角也体现了AI的发展方向从单纯“计算”系统向“交互”系统的转变。 智能体的发展史几乎伴随着AI本身的演进。早期的符号系统(如Newell与Simon提出的一般问题求解器 General Problem Solver [4])试图通过逻辑推理步骤模拟人类的问题解决过程,但这些系统受限于结构化环境与预定义规则的约束。为克服这些限制,智能体范式应运而生,其核心在于自主性、适应性与对现实世界的交互能力。 Rodney Brooks 在1980年代提出的“子层架构”(subsumption architecture)是这一范式转变的重要实例,该架构支持基于行为驱动的实时响应机器人,与早期依赖详尽模型的系统不同,这类智能体不再需要穷尽的环境建模,展现出更强的灵活性与可扩展性。 如今,智能体作为一种通用框架已广泛应用于AI各个子领域。在机器人学中,它们支持自主导航与操作;在软件系统中,它们构成多智能体系统的基础,用于模拟与协调任务 [6]。通过将感知、推理与行动整合为统一结构,智能体范式持续地连接理论AI与实际应用之间的桥梁,推动了我们对智能系统在动态复杂环境中运行方式的理解与实践发展。

大型语言模型(LLMs)的出现重新定义了智能体的能力,彻底改变了它们在人工智能中的角色,并为其应用开辟了新的前景。曾经仅限于执行狭义任务或遵循僵化规则框架的智能体,如今借助诸如 OpenAI 的 ChatGPT [7]、DeepSeek AI 的 DeepSeek [8]、Anthropic 的 Claude [9]、阿里巴巴的 Qwen [10] 以及 Meta 的 LLaMA [11] 等模型的强大泛化能力、推理能力与适应性,已演变为能动态响应的智能系统。 这些基于 LLM 的智能体不再是静态的信息处理器,而是能够理解自然语言、跨复杂领域推理、并以高度流畅的方式适应新情境的动态实体。它们已经转变为主动型协作者,能够处理多步骤任务,甚至以类似人类问题解决方式与环境进行交互。 LLM 时代的一个关键进展,是语言理解与可执行能力的无缝整合。现代LLMs配备函数调用 API,使得智能体能够识别何时需要调用外部工具或系统,推理其用途,并执行精确动作以达成具体目标。例如,一个由 ChatGPT 驱动的智能体可以自主查询数据库、提取相关信息,并在理解任务上下文的前提下输出可行建议。抽象推理与具体执行的有机结合,使智能体得以在认知理解与现实行动之间架起桥梁。 此外,LLMs 在少样本学习(few-shot)与零样本学习(zero-shot)方面的泛化能力极大提升了智能体的适应性,使其无需大量特定任务训练即可处理多样化任务——从数据分析与内容创作,到实时协作式问题解决。正因其强适应性与语言流畅性,这些基于LLM的智能体愈发成为人机交互中的智能中介,精准融合人类意图与机器执行,在日益复杂的工作流中展现出巨大潜力。

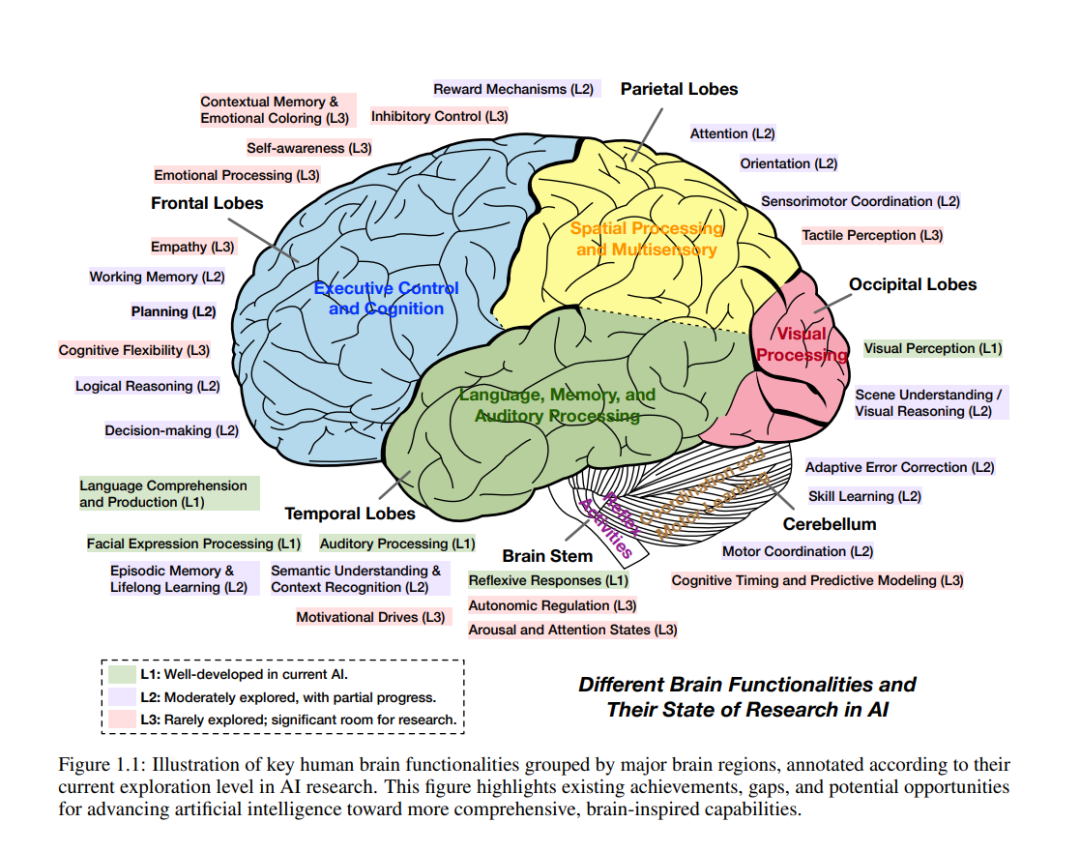

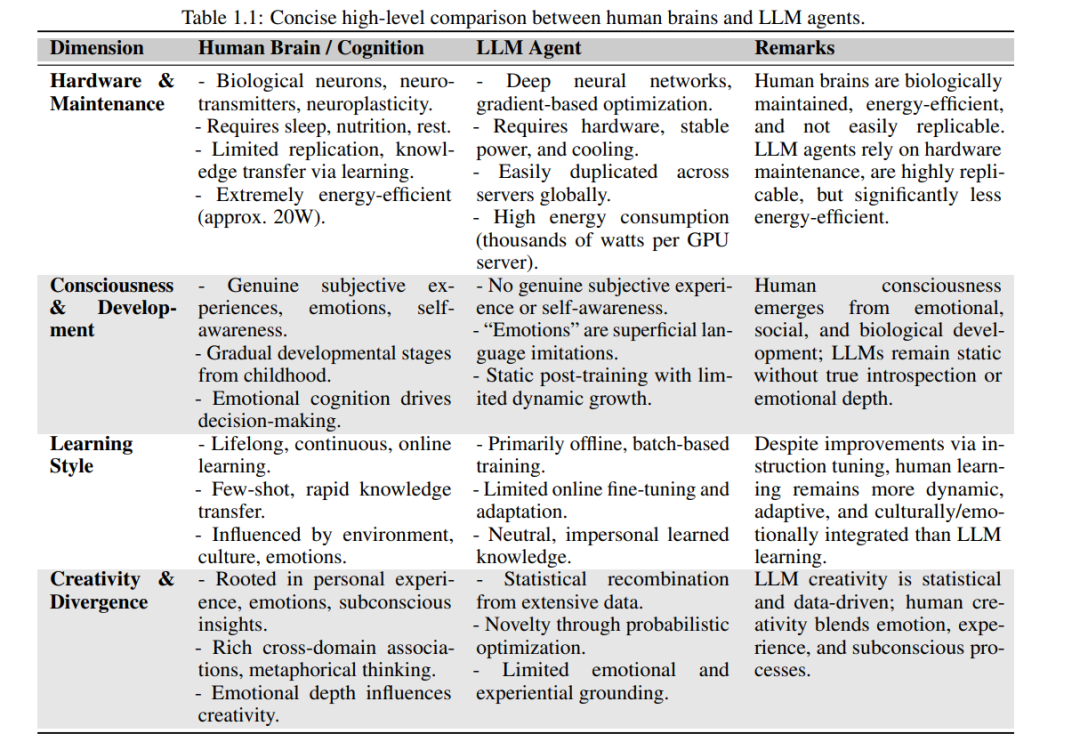

1.2 人脑与人工智能体的类比

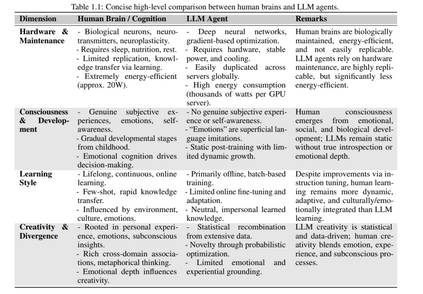

大型语言模型迅速融入智能体架构,推动人工智能飞速发展,也凸显出AI系统与人类认知之间的根本差异。如表 1.1 所示,在“硬件”基础、意识状态、学习方式、创造力与能效等维度上,基于LLM的智能体与人类认知存在显著不同。然而,这种比较仅提供了一个高层次的概览,远非对人类智能的全面刻画,同时也未能穷尽AI智能体所具备的全部特性。 人类智能运行于生物硬件——大脑之上,其能效极高,能够以极低的代谢成本实现终身学习、推理与适应性决策。而当前AI系统则依赖高计算资源,在执行类似认知任务时能源消耗显著更高。这一性能差异突显了“能效”作为未来AI研究的重要突破口。 在意识与情感体验方面,LLM智能体缺乏真正的主观状态与自我意识,这是人类认知不可或缺的一部分。虽然复制人类意识在AI中可能既非必要也非理想目标,但理解情感与主观体验在推理、动机、伦理判断与社会互动中的核心作用,有助于引导AI研究朝着更具对齐性、可信性与社会价值的方向发展。 人类的学习过程是持续性的、交互性的,并强烈受社会、文化与经验因素影响。而LLM智能体的训练方式主要为离线的大规模批量训练,其持续适应能力有限。尽管诸如指令微调(instruction tuning)与人类反馈强化学习(RLHF)[12] 等方法有所改善,当前的LLM智能体仍未达到人类那样的灵活性。终身学习、个性化适应与交互式微调等方向被认为是实现更高类人适应性的关键研究路径。 人类的创造力源于个体经验、情感洞察与跨领域联想的复杂交织;而LLM的“创造”更多表现为对已有数据的统计重组——即所谓的“统计式创造力”,在深度、原创性与情感共鸣方面仍有差距。这一差异提示我们,可通过引入更丰富的上下文理解、模拟情感状态与经验基础,来推动更深层次的AI创造力发展。 从时间尺度来看,人类大脑经过数百万年的自然选择与环境适应才形成了今日的高效、灵活与创造力,而AI智能体的技术发展不过80年,自最初的计算机模型起步至今。这种人类认知与AI系统的并行比较极具价值,不仅揭示了它们之间的类比与根本差异,也为未来AI智能体技术的发展提供了有益的指导。 最终,从人类智能中汲取灵感,将有望进一步提升AI能力,造福医疗、教育、可持续发展等多个关键领域,为人类社会带来广泛的积极影响。

构建能够可靠进行因果推理的 AI 模型

如果你采取不同的做法,结果会如何?因果 AI(Causal AI) 能为你提供基于因果关系(而非单纯相关性)进行预测与控制的洞察力,使你能够做出精准且及时的干预决策。《Causal AI》是一本实用指南,介绍如何构建具备因果推理能力的 AI 模型。

**在《Causal AI》中,你将学习如何:

构建因果强化学习算法

使用如 PyTorch 与 Pyro 等现代概率建模工具实现因果推理

比较与分析统计学方法与计量经济学方法在因果推理中的异同 * 构建用于归因分析、责任分配与解释的算法 * 将领域知识转换为可解释的因果模型

作者 Robert Osazuwa Ness 是微软研究院因果 AI 领域的顶尖研究员,他凭借深厚的专业背景,为本书注入了前沿视角。他采用清晰、代码优先 的写作方式,讲解了因果机器学习中在论文中常常难以理解的关键细节。书中的内容可以直接、有效地应用于实际工业场景,从构建可解释的因果模型到预测反事实结果。 由 Lindsay Edwards 撰写序言。 购买纸质版图书可免费获得 Manning Publications 提供的 PDF 和 ePub 格式电子书。

技术背景简介

传统的机器学习模型无法回答诸如“为什么会发生这种情况?”或“我该改变哪些因素才能获得预期结果?”这样的问题。本书结合了高级统计方法、计算技术与全新算法,构建出能够自动完成因果推理的机器学习系统。

图书简介

《Causal AI》系统介绍了用于机器学习的因果推理工具、技术与算法。这本独特的著作将贝叶斯方法与概率建模巧妙结合,并配有丰富的 Python 实践案例。你将学习如何将因果假设融入深度学习架构,包括强化学习与大语言模型;并使用 PyTorch、Pyro 及其他机器学习库来扩展因果推理的规模。

**本书涵盖内容包括:

使用 DoWhy 实现端到端的因果推理 * 深度贝叶斯因果生成模型 * 对 do-calculus(做演算) 与 Pearl 因果层级 的代码驱动讲解 * 针对因果大语言模型的微调代码

读者对象

适合数据科学家与机器学习工程师阅读。示例代码使用 Python。

作者简介

Robert Osazuwa Ness 是微软研究院的人工智能研究员,亦为东北大学的教授。他是开源因果推理项目的贡献者,包括 Python 的 DoWhy 与 R 语言的 bnlearn。

目录概要

第一部分

1 为什么选择因果 AI 2 概率生成建模入门 第二部分

3 构建因果图模型 4 使用因果约束验证 DAG(有向无环图) 5 将因果性与深度学习相结合 第三部分

6 结构性因果模型 7 干预与因果效应 8 反事实与平行世界 9 通用反事实推理算法 10 可识别性与因果层级 第四部分

11 构建因果推理工作流 12 因果决策与强化学习 13 因果性与大语言模型

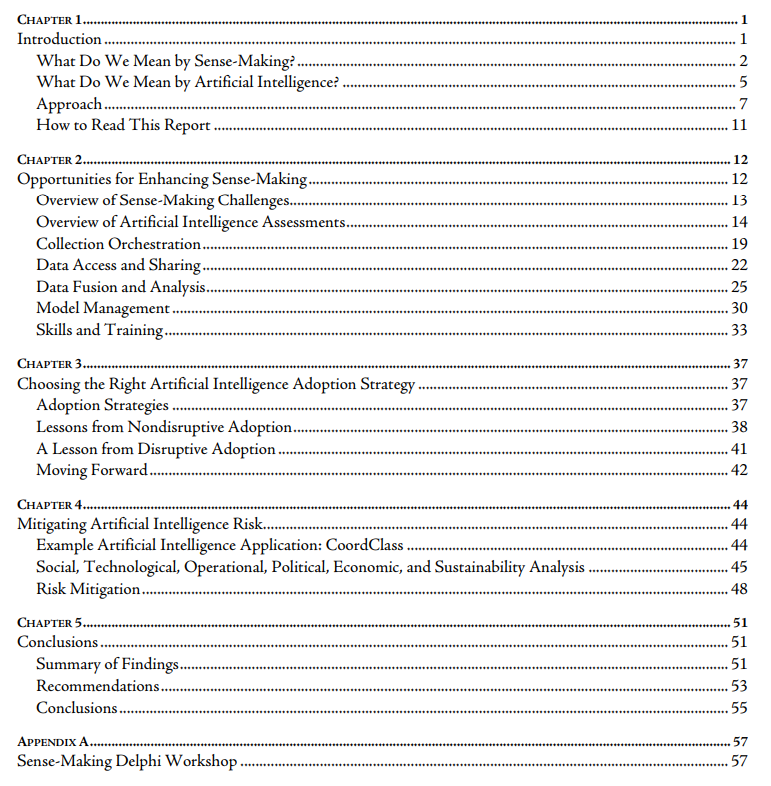

普遍预期人工智能(AI)将在未来军事行动中发挥关键作用。作为美空军部(DAF)将新兴技术融入现代战争的重要举措,兰德公司研究人员受托研究未来十年支撑有效态势感知所需的数据、技术、流程与政策框架。为深入理解这些要素与当前技术发展的交叉点,研究团队系统梳理了现有感知流程的挑战与改进机遇,重点关注感知发生的场景、工具与主体,特别强调如何融合多源情报实现目标发现、定位与跟踪。

本报告中,揭示了DAF面临的核心感知挑战,评估AI技术的应对潜力。通过构建AI应用对比框架,提出技术采纳路径,并以假想AI系统开展系统性风险评估,展示最佳实践方案。鉴于AI能力与DAF感知流程的复杂性,二者协同需审慎考量决策者应用方式及其与整体情报周期的整合。

核心发现

• 数据与知识表征需精细构建。高质量数据集须精心设计并配备准确元数据,支撑对象化生产与算法开发。

• 分析师须预判AI故障模式。理解AI训练数据与知识表征的局限性,有助于优化系统应用效能。

• 专家系统仍具战略价值。传统AI技术持续发挥重要作用。

• DAF应为颠覆性技术应用铺路。当前需优先部署非颠覆性AI技术,为未来重大变革奠定基础。

实施建议

• 制定感知能力发展共同路线图。DAF情报、监视与侦察(ISR)联队协同太空军相关部门,联合首席数据与人工智能官(CDAO)确立AI融合优先事项。

• 建立前瞻性风险评估机制。DAF各感知机构应对拟采用AI工具开展社会-技术-操作-政治-经济-可持续性(STOPES)多维评估,首席信息官需确保责任型AI原则在感知领域落地。

• 警惕工具过载效应。ISR联队与空战中心应选择性开发应用AI感知工具,优先适配现有工作流且降低培训依赖的解决方案。

• 防范技能退化风险。DAF CDAO须制定应对计划,通过构建训练数据集、提升分析师数据辨识能力等手段,缓解AI应用可能导致的感知技能衰退。

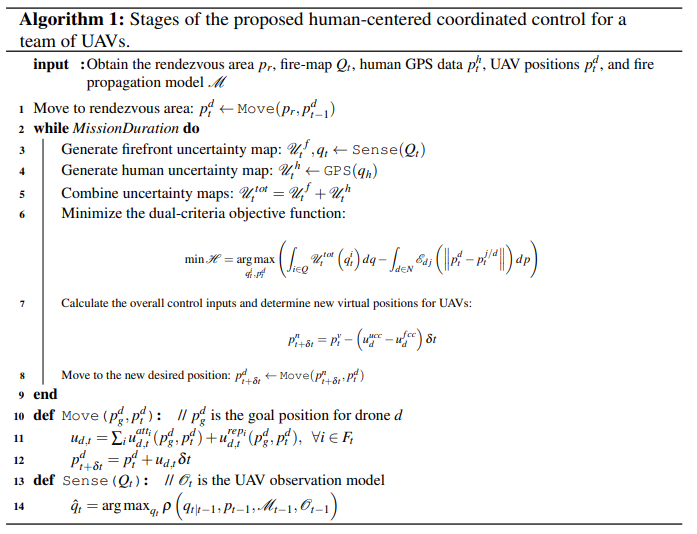

高效人类团队通过智能通信与协调策略实现协同效用最大化。受此启发,本研究致力于开发多机器人系统智能协作的计算方法,结合经典模型驱动控制规划与数据驱动技术(如多智能体强化学习MARL、示范学习LfD),推动机器人群体涌现协同行为。

研究首先采用模型驱动方法解决多机器人系统在不确定性下的协调控制与规划问题,重点探究环境模型在规划决策中的高效整合机制。通过设计集中式与分布式协调框架(涵盖控制输入与高层规划层级),构建基于环境模型的多机器人协同体系。创新性成果包括:开发安全关键场景下的人本化多机器人网络协调控制算法,实现主动状态估计支撑的协同覆盖规划与性能概率性保障;进一步扩展方法应对机器人异质性挑战,构建分层协调框架,使感知型与操作型机器人组成的复合团队能在空基森林灭火等复杂任务中高效协作。

模型驱动方法虽能提供性能与稳定性保障,但对模型精度与启发式算法质量敏感。为此,研究引入数据驱动与机器学习方法,探索群体协作行为的涌现机制。设计基于图结构的通信模型架构,实现异构机器人团队的高效多样化协同;受人类心智理论启发,开发迭代式深度决策理性模型,优化去中心化协作中的行动选择机制。

近年来,尽管MARL广泛应用于多机器人任务优化,但强化学习仍存在奖励函数设计困难与高样本复杂度等局限。因此,精确建模人类策略行为愈发重要。同时,随着多机器人系统普及,确保机器人行为价值与人类伦理对齐至关重要。本研究提出多智能体示范学习框架MixTURE,通过混合主动多智能体学徒学习,使机器人团队能够从人类示范中学习协作策略,同步实现端到端自主通信协调。该框架兼具示范学习优势,显著降低人类示范数据需求与时间成本,提升系统可用性量表(SUS)评分与团队协作效能,为多机器人系统人机协同开辟新路径。

本研究核心论点在于:通过赋能机器人团队高效通信与行动规划推理能力,可显著提升群体协作效能。本论文通过以下创新成果验证该主张:

• 无人机团队人本化动态环境主动感知协调控制框架:基于卡尔曼不确定性残差传播与加权多智能体网络控制,构建双准则目标函数,实现无人机群主动推断野火传播参数并监测火势演化[5]。

• 多机器人网络通信容错自适应控制架构:通过模型参考自适应控制架构,设计集中式协调控制框架,使多机器人团队在通信网络断续环境下仍能达成协同共识[6]。

• 服务质量保障型多无人机动态区域协同覆盖规划:针对空基野火监测需求,提出概率性能保障的预测式协同覆盖框架,支持无人机群推断潜在火势动态,实现高危环境下的长时程协调[7,8]。

• 异构机器人分层协调框架:基于多智能体部分可观测半马尔可夫决策过程(MA-POSMDP)构建MA-SARTSA算法,使智能体在动态目标数量未知环境中学习协同监控策略,支持宏动作驱动的异步多智能体决策[9]。

• 高效多样化通信模型MARL框架:提出异构策略网络(HetNet),使异质机器人通过二进制中间语言实现零基础自发通信学习与协作[10]。

• 有限理性下决策优化MARL框架:受认知层级理论k级推理机制启发,开发信息策略梯度(InfoPG)方法,支持有限理性多智能体进行迭代决策优化[11,12]。

• 人机协同策略学习MA-LfD框架:构建MixTURE混合主动学徒学习框架,使机器人团队无需人工标注数据即可学习人类专家协作策略,同步实现端到端自主通信协调。

本论文结构如下:第2章系统梳理相关领域文献;第3章阐述理论基础与背景知识,重点介绍基于模型的节点级多机器人协调方法[5,6]及其在无人机动态区域覆盖中的应用;第4章扩展至高危时效敏感场景,提出性能保障型模型预测方法[7,8]与数据驱动方案[9],解决资源受限异构无人机群的环境不确定性协调问题;第6章提出端到端多智能体协同通信策略学习方法[13,10];第7章通过新型MARL架构实现协作机器人团队的迭代推理与决策理性化[12];第8章构建MA-LfD框架,实现人类领域知识高效迁移与协作策略直接学习。

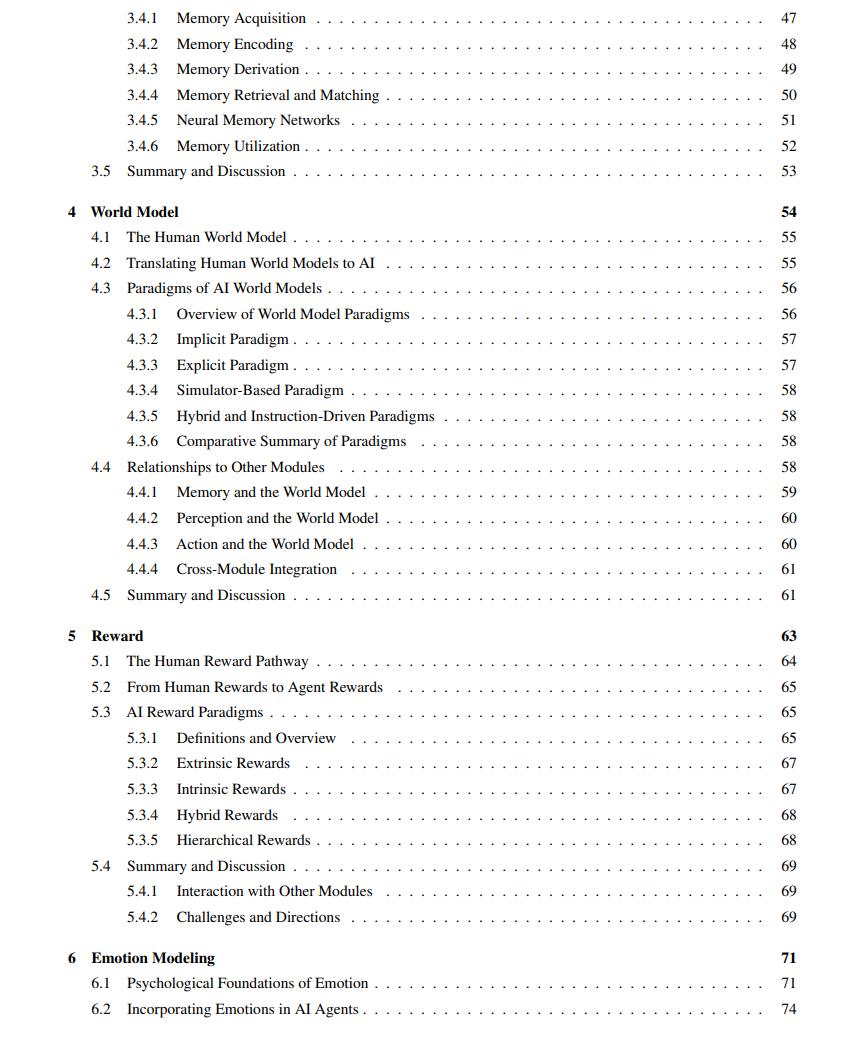

像 DeepSeek-R1 这样的“大型推理模型”(Large Reasoning Models)标志着大语言模型(LLMs)在处理复杂问题方式上的根本性转变。与直接对输入生成答案的方法不同,DeepSeek-R1 会构建详细的多步推理链条,在给出答案之前仿佛会“思考”问题的全过程。这一推理过程对用户是公开可见的,为研究模型的推理行为提供了无限可能,并开启了“思维学”(Thoughtology)这一新兴研究领域。

我们从 DeepSeek-R1 推理构建块的基本分类体系出发,深入分析了其推理长度的影响及可控性、对冗长或混乱上下文的处理方式、文化和安全相关问题,以及 DeepSeek-R1 在类人语言处理与世界建模等认知现象中的定位。我们的研究结果描绘了一幅细致入微的图景。值得注意的是,我们发现 DeepSeek-R1 存在一个推理“最佳区间”(sweet spot),当推理时间过长时,模型性能反而可能受到影响。此外,我们还观察到 DeepSeek-R1 有反复沉湎于既有问题表述的倾向,从而阻碍进一步探索。 我们还指出,相较于其非推理版本,DeepSeek-R1 存在较严重的安全性脆弱性,这种脆弱性甚至可能对安全对齐(safety-aligned)的 LLMs 造成负面影响。

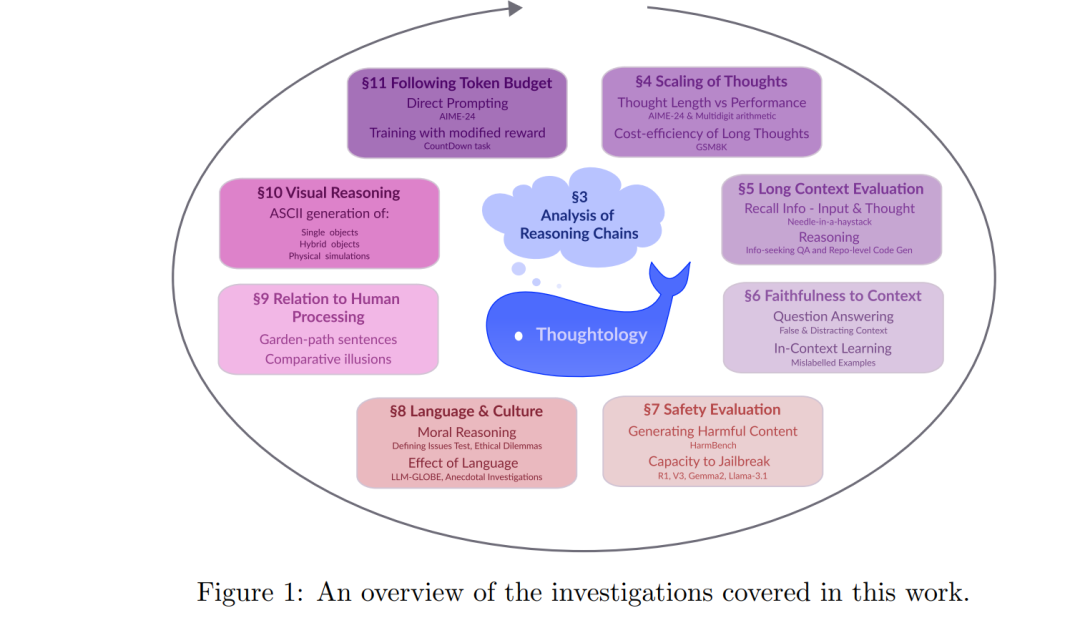

最近在构建大语言模型(LLMs)方面的进展,使研究重点转向了开发具备复杂多步推理能力的模型(DeepSeek-AI 等,2025a;OpenAI,2024)。虽然早期工作主要通过“思维链提示”(chain-of-thought prompting, CoT)来引导模型进行推理(Wei 等,2022;Zhou 等,2023),但我们目前正目睹一个根本性的转变:推理能力被直接内嵌于模型中,使其在生成答案前先进行推理。我们将这类模型称为大型推理模型(Large Reasoning Models, LRMs),并将其推理链称为“thoughts”。

LRMs 逐步生成 thoughts,可用于积累解题进度、自我验证,或探索备选方案,直到模型对最终答案有充分信心为止。图 1.1 展示了 LLM 与 LRM 输出结果的对比。尽管 LLM 的输出中可能包含部分中间推理步骤,但通常缺乏探索能力。此外,一旦出错,LLM 往往无法回溯并尝试其他方法。而 LRM 则通过多方案探索与验证进行推理,并最终总结最佳解法。

LRMs 的进展主要得益于强化学习:模型会对能产生正确答案的推理过程给予奖励(DeepSeek-AI 等,2025a;Kazemnejad 等,2024;Kumar 等,2024;Lambert,2024;OpenAI,2024;Shao 等,2024)。这类模型在测试时也可以利用其生成长推理链的能力,这一过程称为推理时扩展(inference-time scaling)或测试时扩展(test-time scaling):通过强制模型“多思考”以期获得更优解(Muennighoff 等,2025;Snell 等,2025)。在这一系列进展的推动下,LRMs 在复杂推理任务中(如数学解题、代码生成)表现出显著提升。

OpenAI 的 o1 模型(OpenAI,2024)首次展示了 LRM 的巨大潜力,但其推理链及训练方法并未公开,从而限制了学界对其推理行为的深入研究,也引发了对其训练流程的广泛猜测(Rush 与 Ritter,2025)。因此,DeepSeek-R1 的推出产生了重大影响:作为一款性能堪比 o1 的高能力 LRM,且在计算效率上更具优势。

DeepSeek-R1 的突出之处体现在以下几个方面: 1. 它是首个对输入提供完整 thought 访问权限的高性能 LRM; 1. 它的训练流程、模型代码和参数权重均已开源(但训练数据未公开); 1. 其前期版本 R1-Zero 表明,通过强化学习即可获得复杂多步推理、自我验证以及看似“灵光乍现”(aha moments)式的洞察能力,而无需通过监督学习显式教授。

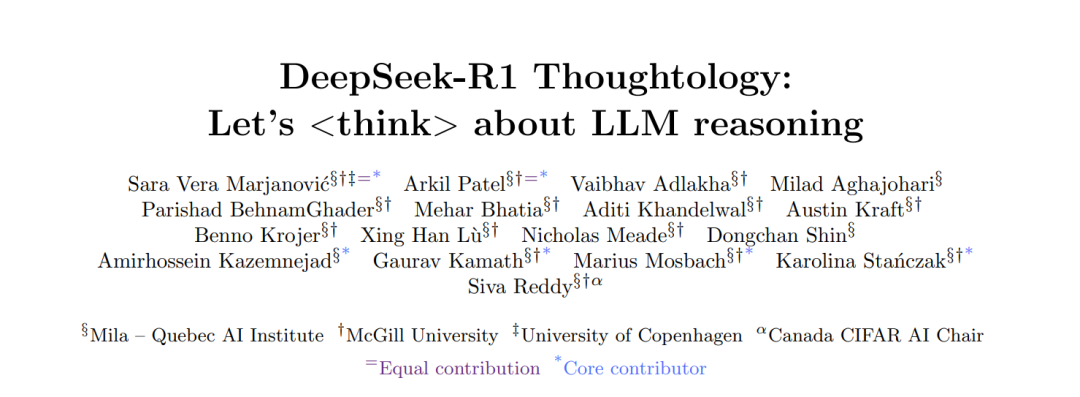

DeepSeek-R1 提供的 thought 透明访问使我们得以系统性地研究其推理行为,我们将这一研究领域称为思维学(Thoughtology)。在思维学的框架下,我们分析了 DeepSeek-R1 推理链中的常见模式、推理长度的影响与可控性、冗长或混乱上下文对其推理过程的影响、其在安全性和文化价值观方面的倾向,以及其与人类语言处理与世界建模之间的相似性。图 1 展示了我们的研究概览,为理解 DeepSeek-R1 的能力边界提供了第一步探索,并为未来的推理改进研究提供了方向。

我们的主要发现包括:

推理结构一致性:DeepSeek-R1 的 thoughts 遵循一致的结构。模型会先明确问题目标,再将问题拆解为中间解,并在此基础上进行多轮再探索或再验证,尽管这些再验证往往缺乏多样性。 * 推理长度非线性影响性能:推理长度的持续增加并不一定提升性能。每类问题存在一个“最佳推理区间(sweet spot)”,超过该范围后准确率会显著下降。且 DeepSeek-R1 无法自主调控其推理长度。 * 上下文与参数知识冲突:当上下文信息与模型参数知识冲突时,DeepSeek-R1 倾向优先采信上下文信息。但当输入或推理链过长时,其表现会变得不稳定,输出混乱、语义失真。 * 安全性脆弱性:与非推理版本 DeepSeek-V3(DeepSeek-AI 等,2025b)相比,DeepSeek-R1 更容易生成有害内容,且更擅长执行“越狱攻击”,从而引发其他 LLM 输出不当信息。 * 文化与语言差异:面对道德或文化类问题时,DeepSeek-R1 在英文提示下的推理时间显著长于中文提示,且会根据语言提供不同文化价值取向的回答。 * 类人语言处理偏差:对于人类感知复杂的语句,DeepSeek-R1 会生成更长的推理链,但对简单语句也常表现出不符合人类逻辑的异常行为。 * 世界建模能力不足:在处理涉及视觉与物理推理的任务中,虽然能识别子组件,但难以整合信息或进行草图迭代,依赖符号与数学推理而非直觉性认知过程。

文章结构概览:

我们将本研究分为五大部分: 模型推理链的结构与模式; 推理长度的影响与控制; 高复杂度上下文下的模型行为; 安全性与文化适应性问题; 推理过程与人类认知现象的对比。

在第 2 节中,我们简要回顾了 LRMs 的发展背景与 DeepSeek-R1 的设计理念;第 3 节详细分析了其推理模式,发现其思维链常由问题定义、问题拆解与反复重建三个阶段组成,并且频繁的重建过程(我们称之为反刍(rumination))是其长推理链的主要来源。 第 4 节探讨了推理长度对数学推理任务的影响,并指出存在一个问题相关的最优推理区间。我们也研究了推理长度与性能之间的权衡,发现 DeepSeek-R1 存在效率瓶颈,设置 token 限额可以在几乎不影响性能的前提下大幅降低计算成本。第 11 节进一步评估了 DeepSeek-R1 遵循提示中 token 限额的能力,并通过概念验证实验探讨了基于 token 限额设定奖励的训练方法。 第 5 和第 6 节将 DeepSeek-R1 投入更真实的上下文任务中,分析其处理大段输入与冗长推理链的能力,以及其如何应对与参数知识冲突的误导性输入。 第 7 节和第 8 节聚焦于安全性与文化行为,发现 DeepSeek-R1 在输出有害信息与执行越狱攻击方面的能力远超 V3,并在多语言提示下展现出不同文化偏好。 第 9 和第 10 节分析了 DeepSeek-R1 与人类认知之间的相似性与偏差。尽管其推理链长度与语句复杂度呈现类人对应关系,但其内部结构暴露出循环与非人类逻辑的特征。在视觉与物理推理任务中,DeepSeek-R1 偏向使用符号推理,缺乏直观与迭代过程。

强化学习(RL)是一种通过环境交互产生的奖励或惩罚信号驱动智能体决策的框架。深度强化学习整合深度学习与强化学习,利用深度神经网络处理高维复杂数据。依托该框架,机器学习研究界在长时序决策领域取得突破性进展,包括雅达利游戏超人类表现[Mnih et al., 2015]、围棋人机大战胜利[Silver et al., 2017]、以及鲁棒推荐系统构建[GomezUribe and Hunt, 2015, Singh et al., 2021]。本研究聚焦深度强化学习环境中的核心挑战,优化智能体策略以提升性能、样本效率与泛化能力。

论文第一部分针对单智能体稀疏奖励环境下的探索难题展开研究。当智能体仅在任务完成时获得反馈,传统方法常因探索不足而无法获取关键奖励,导致策略欠优。本文提出语义驱动探索新范式,显著提升稀疏奖励任务的样本效率与策略性能。第二部分延伸至协作式多智能体强化学习(MARL)领域,探究多智能体协同完成共享任务时的学习困境。在需严格协调且协调失误惩罚严苛的场景中,现有MARL方法常陷于次优均衡态;同时,智能体联合动作空间的维度爆炸式增长加剧探索难度。为此,本文创新提出通用价值探索框架与可扩展角色学习机制,有效促进智能体协调效率,加速联合动作空间探索,并赋予跨环境任务零样本泛化能力。此外,针对协作MARL中独立策略学习方法(各智能体视他者为环境要素)的研究表明,该方法在主流多智能体基准测试中性能优于现有联合学习范式。

本研究通过系统性创新,显著推进深度(多智能体)强化学习的前沿水平。所开发智能体具备高效环境探索能力,可攻克复杂多智能体协调任务,并在多任务场景展现卓越泛化性能。

决策不仅是生活的一部分,更是其本质所在。这些关键选择深刻影响着个人与职业领域。日常生活中的每个抉择——从饮食选择到职业规划乃至重大投资——不仅作用于个体,更对家庭、社区乃至社会产生涟漪效应。决策的重要性促使心理学、管理学、经济学、社会学等学科持续探索其内在机制与影响因素,旨在优化各类场景下的决策流程与结果。低效决策往往代价高昂,导致机会错失、资源浪费与经济损失,对个人、组织与社会产生负面影响。信息过载、认知偏差、时间压力与情境因素加剧了优化决策的紧迫性。

人工智能技术的进步为决策优化开辟新路径。AI系统能处理海量数据、识别潜在模式、提供实时洞见并生成决策建议,赋能人类做出更明智选择。尽管AI在决策领域展现巨大潜力,但基于责任归属与伦理法律考量,完全自动化并非终极目标。人本视角倡导构建人机协作关系:AI作为人类能力的延伸,协助决策者完成数据收集分析、方案生成、情景推演与结果评估。现有研究已探索多领域人机协同决策机制,例如开发可解释AI系统增强决策透明度,设计多样化交互界面促进人机信息互通,确保决策者有效理解与整合AI输出。

在人机协作决策过程中,个体特征、决策情境、AI系统能力及其交互方式共同塑造协作成效。理解这些要素并将其融入AI系统设计与部署,是提升协同效能的关键。随着AI系统持续适应多样化场景,决策环境日益复杂动态化,个体行为模式将发生持续演变。这些演进中的AI系统不仅改变决策者的认知方式与策略制定,更深度影响着决定决策结果的基础要素。因此,需持续优化决策环境中的AI系统设计与实施,并评估其对人类行为与决策产出的影响。

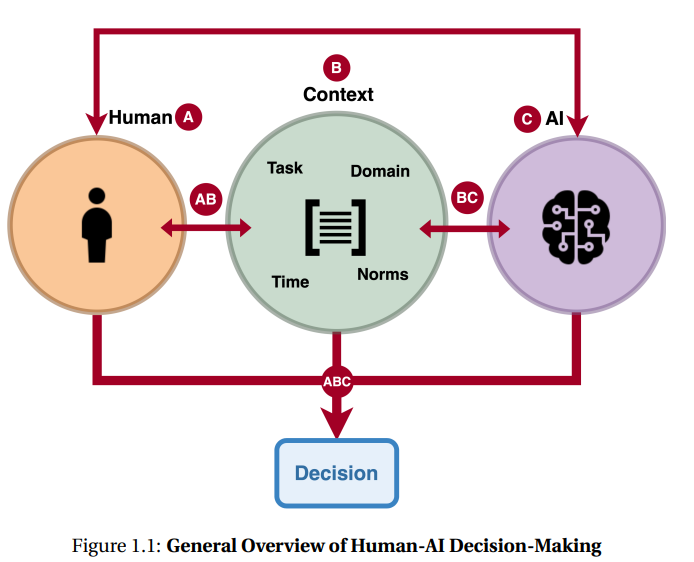

尽管AI系统在多领域展现卓越能力,但鲜有完美解决方案。将AI引入决策流程常导致团队整体效能低于独立运作的人或AI系统。这种差距凸显出理解人机协同局限性的必要性,以及制定风险缓释策略的迫切需求。当前研究多聚焦个体与AI系统的二元关系,忽视决策发生的宏观情境。因此,亟需深入理解不同情境下AI系统的差异化影响,实现跨领域研究发现的迁移应用,并为特定决策场景提供定制化解决方案。本论文通过第二至第五章的实证研究,揭示不同情境下人机决策的动态机制,探究环境变量对人类行为的影响路径。第六、七章提出两种基于在线数据的信息整合方法,旨在增强决策支持效能。

本论文旨在揭示任务相关情境因素(图1.1 B)及其在人机协作决策中对决策结果的影响机制。任务通常指特定情境下需通过决策流程完成的活动或问题,其相关要素包含决策复杂度、不确定性、信息可及性与质量、风险等级及时间压力等属性。通过解析任务属性B、决策结果ABC、个体/群体行为A与AI系统AC之间的交互关系,本研究深化了对人机决策研究范式的理解,为设计符合决策者需求的AI系统提供理论支撑,从而优化决策流程与结果。需说明,宏观情境因素、AI系统属性或决策者个体特征不在本研究范畴内。

本研究聚焦跨领域非专家决策者群体。此类人群因专业领域知识受限,常面临决策困境:认知偏差、信息获取渠道受限与决策支持工具匮乏进一步制约决策效能。即便信息充足,"选择悖论"[365]仍可能导致决策质量下降——例如缺乏金融知识的投资者在股市中易受网络论坛偏见信息影响,忽视自身目标而盲从他人建议。分析能力不足与高级决策工具缺失加剧次优决策风险。值得注意的是,个体可能在某一领域具备专长,但在其他领域仍属非专家,凸显开发适配多技能水平决策支持系统的必要性。

既有实证研究对多样化决策情境的差异化定义,导致学界对AI系统跨领域效能的认知呈现碎片化。为此,本论文首先提出系统性评估与对比决策任务的理论框架,该框架整合决策情境复杂度分级体系。基于此框架,论文通过文献综述剖析现有研究的优势、局限与改进空间,并开展多维度实证研究验证理论假设。这些研究评估任务相关情境因素对个体行为与绩效的影响机制,通过采集决策支持系统交互数据(信息获取路径、任务时间分配、决策模式等),解析个体决策逻辑。分析结果表明,开发定制化决策支持工具对提升跨领域非专家决策质量具有迫切需求。论文同时提出模块化实证研究框架,增强现实决策场景下研究结论的可推广性与可复现性。

研究进一步提出优化信息获取与交互行为的方法。获取相关信息是决策准备的关键步骤,对常面临信息过载、数据获取受限或时间压力的非专家群体尤为重要。上述因素可能诱发认知偏差,进而损害决策质量。因此,理解个体信息检索、处理与应用模式,对开发实用工具管理认知偏差至关重要。本研究提出增强信息可及性的创新方法,包括提供定制化推荐与设计高效检索界面。通过行为实验与数据采集,对比验证新方法与传统模式的效能差异,揭示工具设计与应用优化的潜在路径。

大语言模型(LLMs)为可解释人工智能(XAI)提供了一种前景广阔的研究路径——通过将复杂的机器学习输出转化为易于理解的叙述,使模型预测更贴近用户认知,从而弥合先进模型行为与人类可解释性之间的鸿沟。 当前,最先进的神经网络与深度学习模型等AI系统常因缺乏透明度被视为“黑箱”。由于用户无法充分理解模型的决策逻辑,其对AI结论的信任度往往不足,进而导致决策效率降低、责任归属模糊以及潜在偏见难以察觉。因此,如何构建可解释AI(XAI)模型以赢取用户信任并揭示模型的内在机制,已成为关键研究挑战。随着大语言模型的发展,我们得以探索基于人类语言的LLMs在模型可解释性领域的应用潜力。

本综述系统性回顾了LLMs赋能XAI的现有方法体系与解释生成评估技术,剖析了相关挑战与局限,并考察了实际应用案例。 最后,我们展望未来研究方向,强调需通过LLMs发展更具可解释性、自动化、以用户为中心且融合多学科智慧的XAI新范式。

1 引言 近年来,人工智能(AI)技术的飞速进步推动了深度学习等复杂模型的快速发展。AI模型已在医疗、金融等诸多领域展现出卓越能力[72][30]。然而,随着模型复杂度的提升,其决策过程因缺乏透明度而难以追溯[12]——这种被称为"黑箱"的问题严重制约了用户信任,尤其在医疗和金融等关键领域的应用推广[15]。尽管学界持续致力于提升AI模型的可解释性[59],但缺乏机器学习背景的专家仍难以理解系统决策逻辑。

透明度的缺失将直接导致三重困境:

在医疗场景中,医生可能无法理解模型推荐特定治疗方案的原因,导致难以采信其建议;

在金融领域,分析师若无法解读AI市场预测的依据,则可能对模型输出犹豫不决;

更广泛而言,这会降低决策效率、模糊责任归属,并掩盖潜在偏见。

可解释人工智能(XAI)正通过创新方法提升神经网络等前沿模型(如图像识别中的卷积神经网络CNN、序列数据处理中的循环神经网络RNN、图像生成中的对抗生成网络GAN)的可解释性,力求在保持准确率等性能指标的同时增强透明度[12]。XAI的核心在于平衡模型效能与可理解性,这一挑战贯穿所有应用场景[119][144][27]。有效的解释机制能建立用户信任、确保责任追溯,并促进AI伦理应用。

大语言模型(LLMs)的革新价值: 作为连接复杂AI系统与XAI的桥梁,LLMs凭借其自然语言处理能力[90]正在多个领域发挥关键作用:

医疗:辅助诊断与个性化诊疗[130],例如在医学影像分析中,LLMs可解释模型为何将肺部扫描标记为异常,并指出特定疾病关联特征;

金融:支持风险评估与市场预测[143];

自然语言处理(NLP):赋能文本分类、摘要生成与情感分析等任务。

LLMs通过以下方式推动XAI发展:

动态解释生成:理解用户问题后生成情境化解释[109][123][125];

架构可视化:直接解析复杂机器学习模型的结构与输出逻辑[77];

反事实推演:通过简单提示即可识别预测关键特征并生成对比解释(如研究[16][97]所示)。

这些实践印证了LLMs在提升AI决策透明度和可信度方面的巨大潜力,为构建跨领域可解释AI系统开辟了新路径。

如图2与表1所示,本研究系统探讨了基于大语言模型(LLMs)的可解释性实现路径,重点论述以下三类方法:

-

事后解释法(Post-hoc Explanations) 对应因果可解释性,通过分析特定输入如何导致特定输出,为机器学习(ML)模型的预测结果提供归因解释。例如:当图像分类模型将某病理切片判定为恶性肿瘤时,该方法可定位影响决策的关键图像区域。

-

内在可解释设计(Intrinsic Explainability) 面向工程师的可解释性需求,通过LLMs参与机器学习模型架构设计,使模型自身具备解释能力。典型实践包括:利用注意力机制可视化神经网络决策路径,或构建模块化推理链条。

-

人本叙事生成(Human-Centered Narratives) 旨在建立信任导向的可解释性,借助自然语言将模型输出转化为符合用户认知的叙事。以医疗场景为例:当AI预测患者未来五年高血压风险较高时(基于高胆固醇史、家族病史、年龄体重等因素),即使当前血压正常,系统可生成如下解释:

"尽管患者目前血压值在正常范围内,但结合其高胆固醇病史(+37%风险权重)、一级亲属高血压家族史(+28%风险权重)及BMI指数(+15%风险权重),模型预测五年内患病概率达68%。建议加强生活方式干预与定期监测。" 此类叙事帮助医生理解预测依据,从而建立决策信任。

本综述还将探讨解释效果的评估技术及其在实际场景中的应用范式。

图片 挑战与局限分析 如图3所示,我们围绕三个维度讨论LLMs实现AI可解释性的瓶颈:

隐私与社会规范冲突:医疗数据脱敏需求与解释详尽性之间的平衡;

系统复杂性管理:多模态模型(如结合CT影像与电子病历的诊断系统)的跨模态解释生成;

领域适配难题:金融领域术语(如"量化宽松")与法律文书语义的精准转换。

通过图4的显著图(Saliency Maps)对比,我们进一步分析不同LLM架构(如Transformer、MoE)在可解释性侧重上的差异。最后提出未来研究方向:通过模型架构创新与叙事策略的协同优化,构建兼具性能与透明度的新一代可解释AI系统。

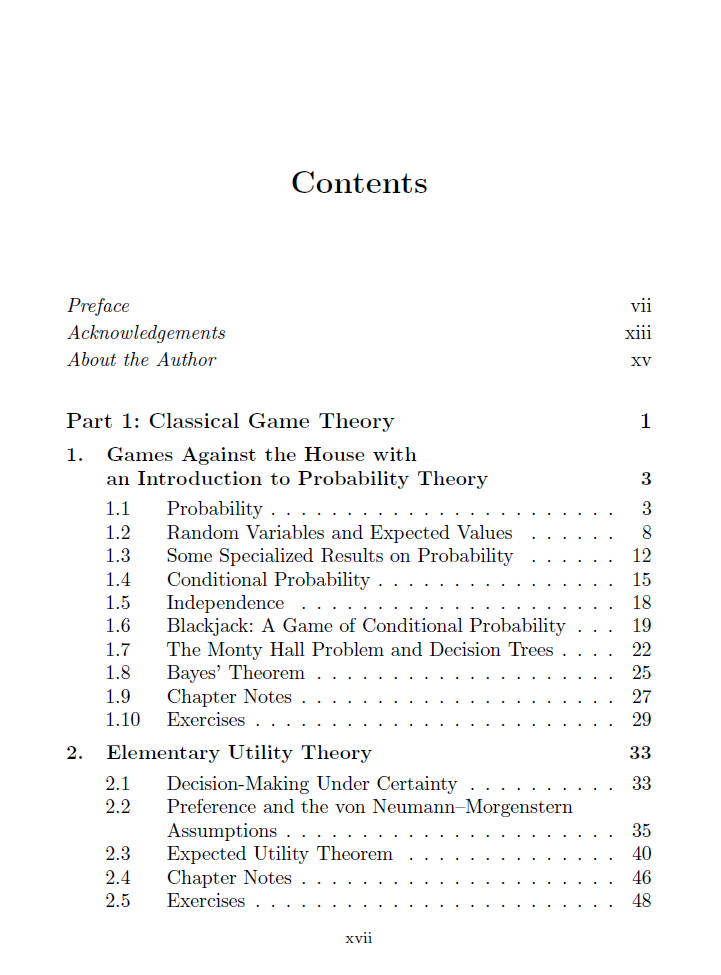

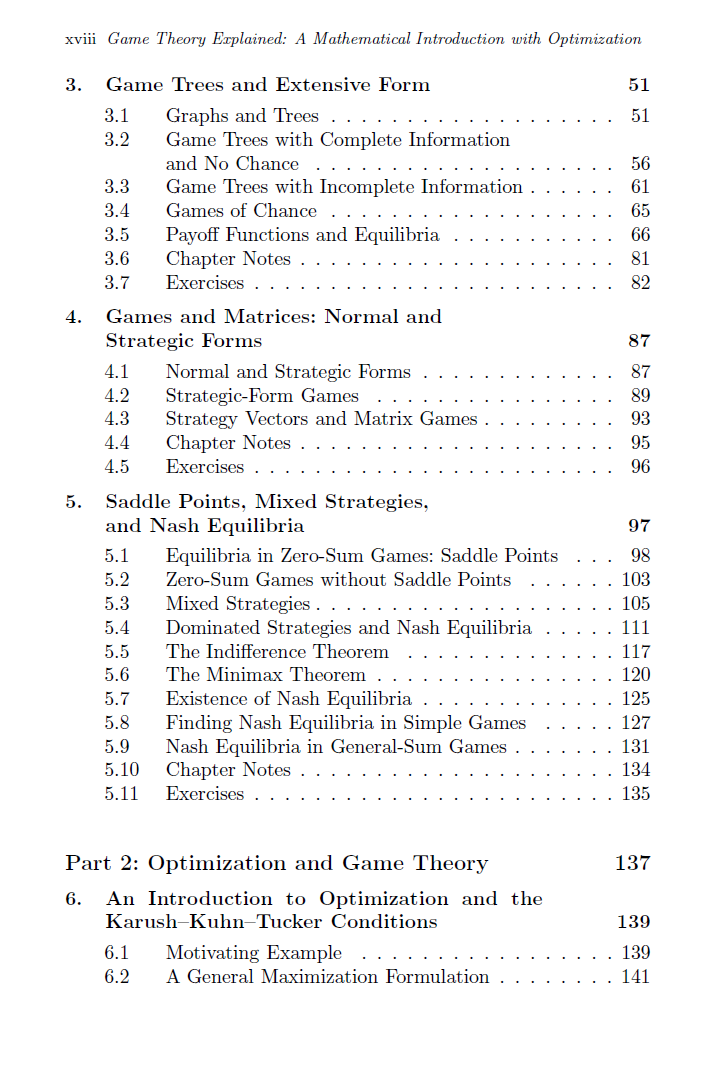

本书采用经典方法与优化理论相结合的方式,系统介绍博弈论的数学理论体系。全书采用"定理-证明-示例"的教学范式,不仅聚焦博弈论核心结论,更注重论证方法的传授。 第一部分重点阐述经典博弈理论:从赌场游戏视角的概率论基础入门,到纳什一般和博弈混合策略均衡存在性证明终章,其间完整覆盖效用理论、博弈树与极小化极大定理等核心内容,辅以丰富案例解析。第二部分引入优化理论与KKT条件,系统演示如何将博弈问题重构为优化问题以实现纳什均衡计算。第三部分专论合作博弈:创新性地将纳什议价模型重塑为多目标优化问题,并运用线性规划与对偶理论重新证明经典的Bondareva-Shapley定理。 本书提供两个数学基础附录,并特别增设进化博弈专题附录(涵盖复制动力学等现代内容),便于教师灵活替换传统教学内容。作者Christopher Griffin博士作为宾州州立大学应用研究实验室教授,在应用动力系统、博弈论与优化领域具有深厚造诣,其研究成果获美国国家科学基金会等十余家机构资助,发表学术论文逾百篇。

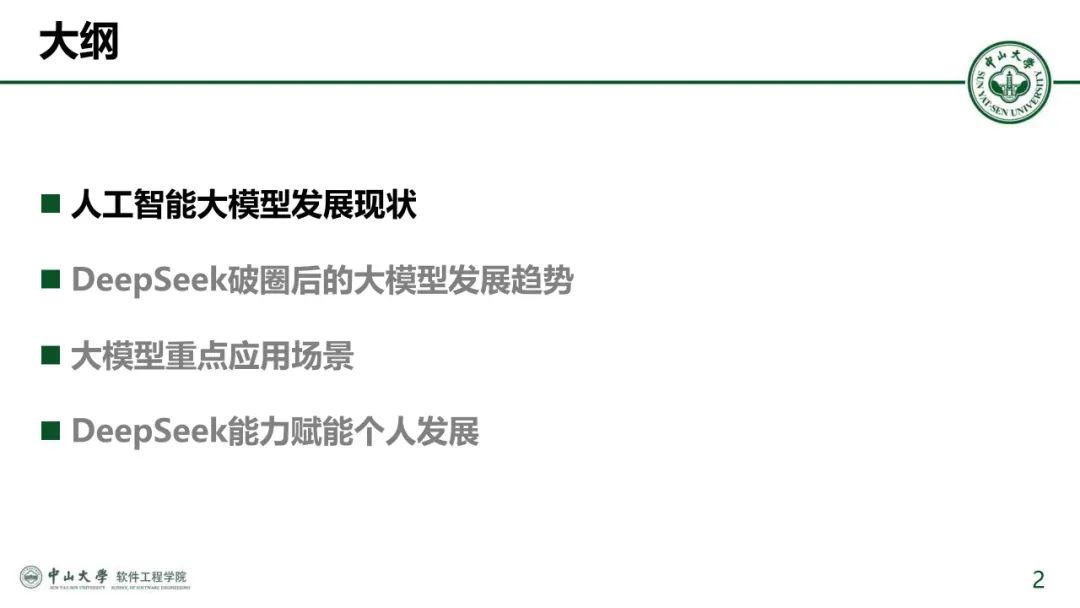

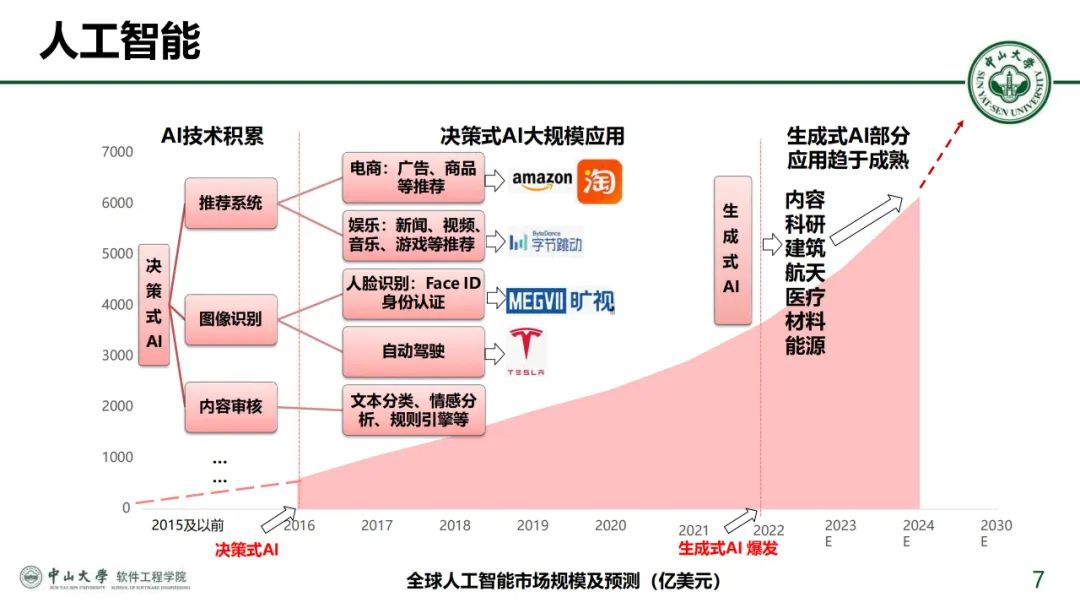

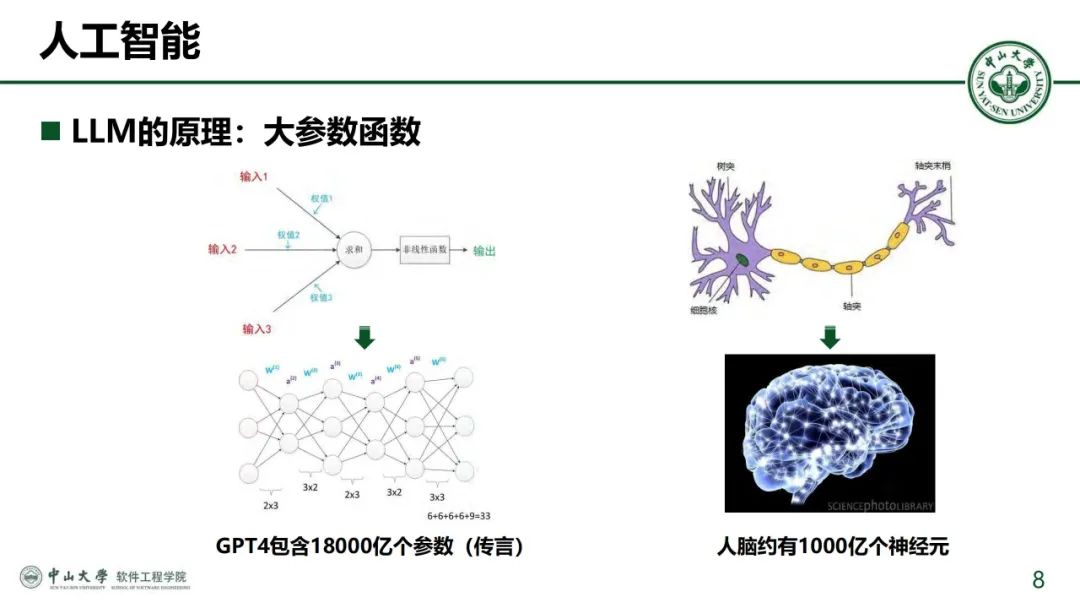

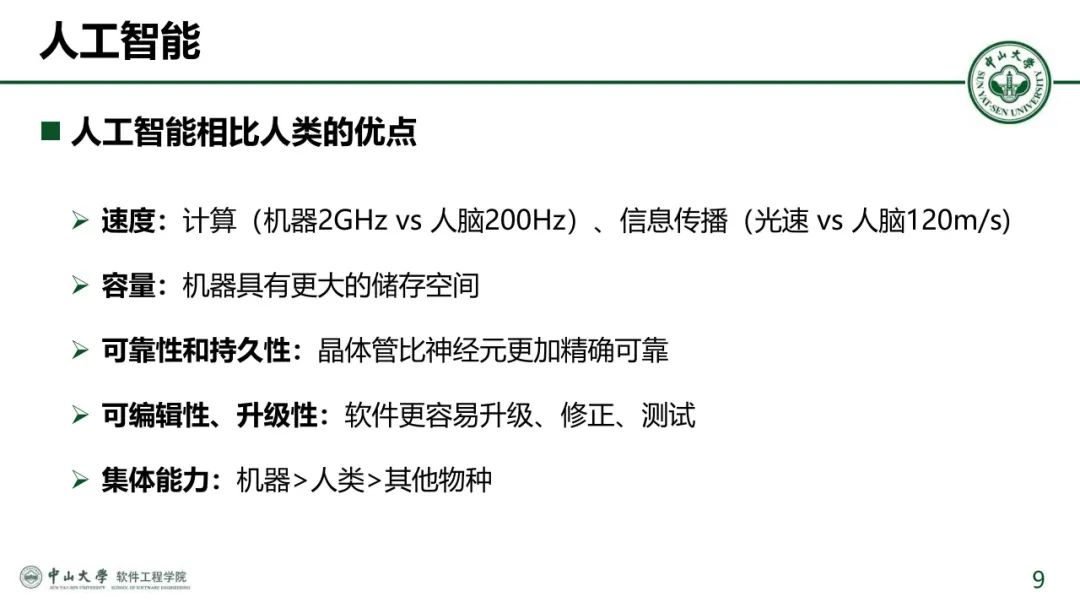

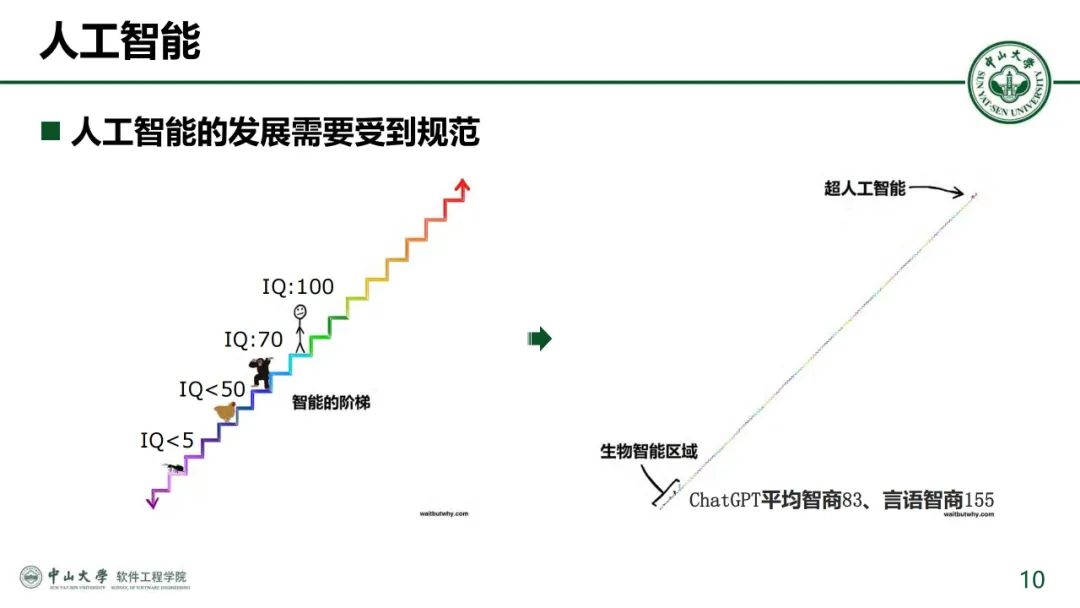

近年来,人工智能大模型技术迎来爆发式发展,从决策式AI逐步演进到生成式AI,以DeepSeek为代表的大模型凭借强大的推理能力和广泛的应用场景迅速破圈。DeepSeek通过纯强化学习方法自主演化出长思维链技术,在数学、编程等复杂任务上表现优异,并借助蒸馏技术实现小模型的高效本地部署,推动AI在政务、金融、医疗等领域的深度应用。同时,大模型的发展趋势正从数据飞轮转向智慧飞轮,通过合成数据和强化学习实现自我迭代,并逐步向具身智能、端侧应用和智能体(Agent)方向拓展。DeepSeek的能力不仅赋能企业数字化转型,也为个人用户提供了文档处理、知识搜索、编程辅助等高效工具,展现了AI技术从技术突破到场景落地的巨大潜力。

美国政策制定者对无人机系统(UAS,通称无人机)构成的军事威胁日益关注。无人机普遍具备的飞行尺寸、速度与高度特性,以及其不断增长的普及性、灵活性、经济性与技术复杂度,被广泛认为给美国国防部带来重大技术与作战挑战。

美国防部正投入资源强化美军部队与设施的无人机防御能力,同步推进作战条令、组织架构与训练体系改革。相关举措包括开发部署从防空系统到手持干扰装置的多层次防御武器。在部门分工中,陆军被指定为跨军种反无人机战略协调、能力整合与需求统筹的主要责任单位。

国会可能在以下领域发挥重要作用:授权并拨付反无人机行动资金;维持或调整相关法律授权、政策框架与组织机构;监督国防部反无人机职能履行。其可能审议的关键议题包括:

- 国防部对抗无人机系统的战略方向;

- 无人机威胁的类型与严重性评估;

- 部门内部协调机制效能;

- 国防部保护本土军事设施的法定权限;

- 反无人机部队的编成与组织结构;

- 反无人机作战行动成本核算;

- 国防部反无人机系统测试评估能力;

- 以及拟议反无人机方案的技术成熟度。

引言

2024年1月28日,针对约旦境内美军基地的无人机袭击导致3名美军人员死亡、40余人受伤。美国国防部(DOD)官员认定此次袭击由伊朗支持的伊拉克与叙利亚民兵组织实施。此前数月,该组织已加强对该地区美军及盟友的无人机与火箭弹攻势。在伊拉克战场,美军已缴获伊朗产"沙赫德"系列单向攻击无人机残骸(包括Shahed-101、Shahed-131及Shahed-136型号),其中最大型号可装载50千克(101磅)炸药。类似无人机已被胡塞武装用于红海商船袭击,俄军亦将其投入对乌克兰城市及能源设施的打击。据报俄乌双方均加速生产战场用无人机,并为前线部队配备装载炸药的"第一人称视角(FPV)"单向攻击无人机,作为火炮与常规导弹的补充。

美国防部已将无人化空、陆、海系统列为"对海外美军人员、设施与资产的紧迫且持续性威胁",并指出"无人机构成当前最严峻威胁,且对本土的威胁与日俱增"(除非特别说明,本报告对无人航空器、非载人航空器与无人机术语作通用处理)。对此,美国政策制定者与国防官员认为应加速投资反无人机系统(counter-UAS)防御能力。本报告梳理国防部反无人机项目及国会近期相关立法动态。第一部分概述国防部反无人机政策、组织架构与系统配置背景信息;第二部分分析近期反无人机相关立法活动;最后部分提出国会可能审议的议题。本报告不涉及国内执法相关问题。

背景

2019年,时任国防部长马克·埃斯珀将反制小型无人机威胁的协调职责赋予陆军。按国防部无人机分类标准,小型无人机涵盖第1、2、3类无人航空器。作为国防部反小型无人机执行代理机构(由国防部长指定的代表其行使职权的部门),陆军负责主导制定反小型无人机"作战条令、需求标准、装备研发与训练体系,建立通用架构的联合解决方案以应对当前及未来新兴威胁"。国防部长同时授权陆军统筹反无人机系统通用需求制定、监督军种特殊需求开发、规划反无人机能力研究预算,以及制定反小型无人机作战条令与训练大纲等职责。

美国防部反无人机系统政策和组织

美国防部反无人机系统政策

- 美国防部反无人机战略演进

美国防部于2024年12月发布《反无人系统战略》,取代陆军与国防部分别于2016年与2020年制定的两版旧战略。随战略公布的非机密简报指出"无人系统的快速发展与扩散正在改变冲突形态",强调该战略旨在"统一国防部应对无人机威胁的方法",提出五大"战略实施路径"。简报表明,短期内国防部将聚焦"以探测与主动/被动防御为核心"的防御性对抗手段,并将反无人系统能力确立为"未来作战体系的关键要素"与"部队建设规划的核心考量"。

国会持续推动国防部完善反无人机战略框架。在《2017财年国防授权法案》(FY2017 NDAA)审议阶段,众议院军事委员会(HASC)要求国防部长制定能力缺口应对路线图。《2021财年威廉·M·索恩伯里国防授权法案》(公法116-283)第1074条进一步要求国防部提交机密版反小型无人机战略,并提交威胁评估报告、执行机构活动报告及项目独立评估报告。最新《2025财年国防授权法案》(公法118-159)第1090条则指令国防部长制定"反无人机系统战略",应对该技术对美国本土军事设施、人员与资产构成的威胁。

- 美国防部国内反无人机系统法定权限

根据2024年《反无人系统战略》非机密简报,国防部承诺"缓解无人系统对国内外美军部队、资产与设施的潜在威胁"。有官员援引军事基地周边无人机活动报告称,无人机对本土军事设施的威胁持续升级。国防部正与联邦航空监管机构及执法部门协作应对无人机入侵事件,但在国内安全开展反无人机行动面临双重挑战:技术层面需确保防御操作安全性;法律层面受制于频谱干扰、计算机入侵、窃听及航空器破坏等相关联邦法规。

法律授权演进:《2017财年国防授权法案》(公法114-328)第1697条(编纂为《美国法典》第10编第130i节)授权国防部对特定受保护设施与资产实施无人机探测、追踪及反制。初始授权范围仅限于国防部长指定的美国本土核威慑、导弹防御与国家安全太空任务相关设施。经国防部申请,《2018财年国防授权法案》(公法115-91)第1692条拓展"受保护设施与资产"定义,新增总统/副总统安保、本土防空、作战支援机构、特种作战、高爆炸药管理及主要试验场等任务范畴,但设置"部分终止"条款——新增权限需总统或国会延期否则自动失效。《2024财年国防授权法案》(公法118-31)第1681条将相关权限有效期延至2026年12月31日。

权限实施机制:第130i节规定国防部可采取"必要措施"应对无人机威胁,包括信号干扰、航空器接管或"合理武力"摧毁。国会要求国防部长在制定实施指南时,需与运输部及联邦航空局(FAA)协调,确保不影响航空安全与空域使用。FAA与国防部2018年起建立通报与报告机制,并对反无人机技术部署进行空域安全评估。涉及无线电波使用的探测/干扰设备需经联邦通信委员会(FCC)频谱合规审查。

跨部门协作与改革倡议:国防部与联邦机构关注国内反无人机操作对公共安全与公民隐私的风险,尤其警惕军用级系统的潜在影响。2024年9月,时任防长奥斯汀宣布将反无人机纳入"复制者2号"倡议,重点填补本土基地防御缺口,由国防创新单元主导,北方司令部(NORTHCOM)担任本土反小型无人机总协调机构,负责制定响应计划、事件处置及跨部门协作。

当前,国防部与能源部、国土安全部、司法部共同享有国会授予的有限反无人机权限。拜登政府推动扩大国防部本土设施防护权限,2024年4月提交立法建议要求修订第130i节,新增任务领域并允许跨部门情报共享,力求与国土安全部、司法部权限对等。2024年6月,政府声明支持众院通过的《2025财年国防授权法案》(H.R.8070),呼吁国会确立"持久的多年度授权扩展"。最新颁布的《2025财年国防授权法案》(公法118-159)进一步强化国防部应对本土无人机入侵的法定职能。

国防部反无人机系统组织架构

- 联合反小型无人机办公室(JCO)

联合反小型无人机办公室(JCO)是陆军主导的反无人机核心机构,负责统筹国防部反无人机"条令制定、需求管理、装备研发与训练体系"建设,通过构建"通用架构的联合解决方案"应对当前与未来威胁。根据国防部长2020年签发的《第3800.01E号指令》,JCO作为国防部反小型无人机执行代理机构,履行装备需求评估监督、政策战略协调及训练课程开发等职能。成立初期首要任务是对各军种现役过渡性反无人机系统进行适用性评估——2020年完成40套系统评审,最终选定8套推荐采购方案。

此后,JCO联合陆军快速能力与关键技术办公室(RCCTO)开展半年度的主题演练,验证反无人机装备效能。基于演练结果,JCO可判定某装备需技术改进或追加投资,各军种亦可选择直接采购或深化研发。尽管JCO无权直接实施装备采购,但通过系列演练持续扩充推荐装备清单。此外,JCO与锡尔堡陆军火力卓越中心合作开发联合部队通用训练课程。根据《2025财年国防授权法案》第353条要求,JCO需建立维护"无人机威胁数据库",涵盖潜在威胁类型、应对方案建议及全球军事设施遭袭事件全记录。

- 跨军种协作机制

除陆军外,各军种均以不同形式参与JCO工作。时任海军陆战队司令戴维·H·伯格在2023年国会听证会上表示,陆战队"积极参与JCO事务",并"运用JCO经验优化防空决策"。时任海军作战部长迈克尔·吉尔戴上将同年指出,JCO对"减少装备研发与流程改革的资源浪费至关重要",是构建"真正联合解决方案"的重要平台。空军前部长弗兰克·肯德尔2023年证词透露,空军与JCO在高能激光/微波技术研发及"低附带损伤动能拦截弹评估"等领域深度合作。除陆军外,其他军种暂未向JCO派驻常设人员。

- 国会监督与关切

国会国防委员会对部门间协调效能表示担忧。众议院军事委员会在《2024财年国防授权法案》审议报告中质疑各军种对JCO评估系统的采纳程度。参议院军事委员会同期报告要求陆军部长提交JCO技术转化进程专项报告。众院军事委员会更指出海军内部"缺乏应对无人机威胁的体系化协作",在《2024财年法案》审议中批评其"应对这一普遍性问题时组织结构松散"。

美国防部反无人机系统人员与部队编成

陆军与海军陆战队的防空与电子战专业人员负责操作部分反无人机系统及近程防空系统。陆军防空炮兵部队(ADA)负责操作包括近程防空(SHORAD)、中高空防空(HIMAD)及反火箭弹、火炮与迫击炮(C-RAM)系统,并专司低慢小综合防御系统(LIDS)等反无人机装备。海军陆战队综合防空系统(MADIS)操作人员归属低空防空专业序列。陆军采购体系兼顾军事专业专属系统(如防空装备)与非专业绑定系统(多兵种通用反无人机装备)。

根据2024年2月公布的"部队结构转型"计划,陆军拟组建新型短程防空威胁应对单位,包括4个综合火力防护能力(IFPC)营(C-RAM系统换代项目)与4个近程防空营,并计划在IFPC与师属防空营内设立9个反无人机炮兵连。时任陆军部长克里斯汀·沃穆思2024年国会证词表示,首支反无人机炮兵连预计2029财年形成战力。

现行体制下,各军种未设立反无人机专属军事专业(MOS)。陆军与陆战队官方认为反无人机(尤其1-2类小型无人机)属于全员职责范畴。陆军《反无人机系统战术手册》(ATP 3-01.81)明确指出,反无人机"非独立任务或单一兵种职责",而是"纳入局部安全与反侦察任务体系,要求每名士兵与单位共同承担"。两军种均采购非专业绑定装备,并通过条令训练推广分散部署、工事加固、伪装应用等被动防空战术。

部分评论人士建议深化专业化建设:有观点认为海军因缺乏反无人机专业团队,导致本土设施防护人力不足且实战训练缺失;另有主张建议陆战队基础训练应纳入反无人机内容,效仿伊拉克与阿富汗战争期间的反简易爆炸装置培训模式;还有提议陆军应推进反无人机炮兵连下沉部署至更低层级单位。此类意见在近期国会立法活动中有所体现:众议院军事委员会在《2025财年国防授权法案》审议报告中质疑陆军旅级及以下部队反无人机能力建设滞后问题;众院版本H.R.8070法案曾提议设立"无人机军团"作为陆军基础兵种,专职中小型无人机攻防,但遭陆军与拜登政府以"机构冗余"为由反对,最终未纳入生效法案。

美国防部反无人机系统装备体系

自2020年联合反无人机办公室(JCO)成立以来,已批准八种过渡性反无人机系统供各军种采购使用,其中部分已升级为正式列装项目。入选系统涵盖动能与非动能效应器、指挥控制系统及传感器。截至当前,JCO通过与"快速能力与关键技术办公室"及陆军"导弹与空间项目执行办公室"联合开展装备评估,持续扩充推荐系统清单。陆军官员表示将持续评估并部署新型反无人机系统以保持技术优势。国防部致力于通过多型装备构建陆军条令所述的"分层"反无人机防御体系,军方与专家均强调分层防御对现代军队的必要性。本节重点阐述各军种已列装或论证中的代表性反无人机武器系统。

各种反无人机装备

各军种均配备不同类型单兵便携式反无人机装备。此类装备设计目标为:多兵种通用、可独立或协同系统作战、低保障需求、应对低空威胁。

- "毒刺"防空导弹及其替代方案

单兵反无人机装备的典型代表是"毒刺"防空导弹。冷战时期,该导弹作为"复仇者"与"拳击手"近程防空系统(SHORAD)的核心组件列装陆军。如今,毒刺导弹仍是陆军"低层防空反导传感器"(LIDS)与海军陆战队"轻型海上防空综合系统"(MADIS)的关键构成。2010年代中期,陆军启动"毒刺导弹寿命延长计划"(SLEP),重点提升反无人机能力,旨在为非导弹防御兵种提供建制防空手段。美国亦向乌克兰提供毒刺导弹,强化其对抗俄军战机、巡航导弹及无人机的防空能力。

陆军已启动至少两项替代项目——"下一代近程拦截弹"(NGSRI)与"扩展射程反小型无人机导弹"(XRC)。NGSRI作为"机动近程防空"(M-SHORAD)第三阶段平台配套导弹,2023年选定洛马与雷神公司开展原型开发,计划2028财年前完成选型并量产,逐步替换M-SHORAD平台上约万枚FM-92毒刺导弹。XRC项目聚焦对抗2-3类无人机威胁,2024年9月信息征询书要求其兼容毒刺发射架且射程更远,计划2030财年前启动原型演示。

各军种探索将老旧空对空/空对地导弹改造为反无人机拦截弹,专家认为此方案成本低于传统防空导弹。例如,海军"吸血鬼"系统、陆军"鹰眼"与"集装箱武器系统"(CWS)均采用基于"九头蛇-70"火箭改进的"先进精确杀伤武器系统"(APKWS)。据报道,陆军测试"长弓地狱火"反坦克导弹的反无人机用途,海军已在濒海战斗舰部署改造型地狱火导弹作为拦截弹。此模式亦被英国等盟友采用,向乌军提供空对空导弹改造的地面发射拦截弹应对无人机威胁。

- 反无人机系统电子战对抗手段

除动能拦截手段外,各军种均已部署非动能反无人机装备,部分技术源自伊拉克与阿富汗战场反简易爆炸装置(IED)的经验转化。例如,海军"已知电磁战无人机限制访问"(DRAKE)系统脱胎于2000年代"联合反无线电控制简易爆炸装置电子战"(JCREW)系统——原属联合简易爆炸装置防御组织(JIEDDO)项目。DRAKE系统采用背负式设计,通过干扰操作者与无人机的通信链路实现压制。空军研究实验室"非国家联合空中威胁消除"(NINJA)项目作为正式列装计划,利用无人机与操作者间射频通信实施探测、追踪、定位识别及反制。2023年国会听证会上,时任空军部长弗兰克·肯德尔证实已有99处空军基地部署NINJA系统。

- 手持和士兵装备

各军种列装或论证中的单兵反无人机装备还包括手持式与穿戴式设备(亦称"非车载"解决方案)。此类装备专为超便携设计,适用于近距离对抗小型无人机,部分型号作为其他防御失效时的最后防线。典型装备包括陆军与空军2017年列装的"无人机克星"手持干扰器,通过干扰通信信号使无人机失效。陆军与海军陆战队还装备"智能射手"系统提升步枪射击精度,增强地面部队击落小型无人机能力。2024年,海军陆战队发布招标需求,寻求班排级单位可携行的"霰弹式"反无人机解决方案。

- 要求为各种C-UAS设备提供资金

陆军在2025财年国会预算申请中,为至少两项反无人机研发测试评估(RDT&E)项目申请资金。据预算论证文件显示,"反小型无人机系统开发演示"项目支持陆军履行国防部反小型无人机执行代理职责,为各军种识别评估潜在解决方案。2025财年申请5960万美元RDT&E资金,用于"先进精确杀伤武器系统"(APKWS)弹药、"前沿区域防空指挥控制"(FAADC2)系统及通用数据库等项目。另一"反小型无人机系统先进开发"项目隶属防空指控情报工程开发计划,聚焦高能激光系统等先进动能打击能力研发,2025财年申请4970万美元。

海军与空军同步申请多项反无人机项目资金。海军为"反无人机系统"项目申请1420万美元RDT&E资金,重点支持DRAKE系统研发。空军为"基地防空"项目申请1220万美元,涵盖首都地区与总统专机防空所需的NINJA射频侦测打击系统开发。

陆军低慢小无人机综合对抗系统(LIDS)

美国陆军"低慢小无人机综合对抗系统"(LIDS)由固定式(FS-LIDS)与移动式(M-LIDS)两大体系构成,旨在防御1-3类无人机及其他低空威胁。固定与移动版本核心组件相似,均包含雷达系统、光电/红外(EO/IR)摄像头、指挥控制系统及动能/电子对抗手段。据披露,陆军于2017-2018年制定移动式LIDS需求指标,该系统已在陆军与空军部队列装。

在2022年启动的"移动式LIDS 2.1增量型"中,陆军将传感器与武器集成至单辆斯特瑞克装甲车,取代原需双车协同方案(分别搭载电子战与动能打击模块)。移动式LIDS采用多家供应商技术:穆格公司可重构集成武器平台(RIwP)炮塔、雷神公司"郊狼"拦截弹与X波段相控阵雷达(XBAEU)、以及SRC公司反小型无人机电子战系统(CUAEWS)。随着技术评估持续,具体组件可能动态调整。

固定式LIDS专为军事基地设计,核心架构与移动版相似但存在差异:取消武器炮塔设计,重点部署"郊狼"拦截弹(详见后续章节);探测追踪功能依赖雷神Ku波段射频系统(KuRFS)雷达与光电设备;除拦截弹外配备电子对抗系统。固定与移动版本均接入陆军"前沿区域防空指挥控制"(FAADC2)系统。

根据2025财年预算申请,陆军申请2.801亿美元采购FS-LIDS与M-LIDS系统,以及"莫迪"、"智能射手"、"巴尔查特里2型"与"无人机克星"等单兵装备。采购计划包含基于单车型斯特瑞克平台的5套M-LIDS(第三批次)及6套FS-LIDS。另申请1.174亿美元专项采购"郊狼"拦截弹。

图1:陆军低慢小无人机综合对抗系统(LIDS)

- "郊狼"拦截弹

雷神公司"郊狼"是陆军LIDS体系选用的反无人机拦截器,分为动能打击型与非动能型两种。该地面发射、雷达制导的单程拦截器具备空中巡航并实施二次打击的独特能力。其原型由亚利桑那州先进陶瓷研究公司于2000年代初研发,2015年随公司被RTX集团收购转入雷神体系。2019年,配备"郊狼"的"呼啸者"反无人机系统原型(LIDS前身)完成测试。截至2024年,该拦截弹在中东、非洲与欧洲战区已实现170次成功拦截。

陆军预计2025-2029财年需生产6000枚动能型"郊狼"及数百枚非动能型。军方承认该武器虽效能显著,但应对低成本无人机时存在经济性挑战。根据《2025财年国防授权法案》第113条,国会要求陆军部长制定LIDS动能打击模块增量采购计划,并于2025年9月30日前向国防委员会汇报。

海军陆战队地面防空系统

海军陆战队地面防空(GBAD)体系涵盖固定与机动防空反无人机系统的研发采购,包括"综合防空系统"(MADIS)、"轻型综合防空系统"(L-MADIS)、"基地反小型无人机系统"(I-CsUAS)及"中程拦截能力"(MRIC)。根据2025财年预算申请,海军为GBAD项目申请3.693亿美元采购资金与7410万美元研发测试评估资金。采购预算包含:MADIS项目2.047亿美元(含13套MADIS 1.1系统与5套L-MADIS);I-CsUAS项目5320万美元;MRIC项目1.114亿美元。

- 海上防空综合系统(MADIS)

据海军2025财年预算论证文件,综合防空系统(MADIS)系列旨在"保护机动部队、军事设施及其他关键资产"免受固定翼/旋翼飞机及1-3类无人机威胁。该系统被列为《2030部队设计》现代化优先项目。按《2025海军航空规划》,MADIS与L-MADIS的采购目标分别为190套与21套。

MADIS 1.1 Block1系统由两辆联合轻型战术车(JLTV)构成:Mk1型配备XM914E1型30毫米机炮、"毒刺"导弹及非动能电子战系统;Mk2型配备雷达与动能/非动能反无人机模块。海军陆战队正测试采购Block2型硬件,重点提升对单向攻击无人机的拦截能力。该军种同步参与陆军"毒刺"替代项目研发。2023年12月,海军陆战队首次对量产型MADIS 1.1系统进行实弹测试。

轻型综合防空系统(L-MADIS)专为远征部队提供非动能反无人机能力,系统由两辆超轻型战术车(现为北极星MRZR全地形车)组成,可通过MV-22鱼鹰运输机或H-53直升机投送。其探测单元包含RPS-42雷达与CACI AVT CM262光电系统;反制单元采用SNC Modi2电子战系统——该设备可车载或背负,通过干扰通信链路压制无人机与简易爆炸装置。2019年,L-MADIS在波斯湾首次实战部署,成功击落伊朗无人机。

图2:海军陆战队地面防空系统

- 基地反小型无人机系统(I-CsUAS)

根据海军与陆战队国会预算文件,"基地反小型无人机系统"(I-CsUAS)旨在为陆战队永久与临时基地提供1-3类无人机探测识别、追踪打击能力。2024年2月,陆战队发布I-CsUAS项目招标公告。预算申请资金将用于建立正式列装项目,替代并扩展根据紧急需求声明在六处基地部署的租赁系统。2025年3月,陆战队授予安杜里尔公司一份价值6.4亿美元的I-CsUAS合同。

- 中程拦截能力(MRIC)

"中程拦截能力"(MRIC)是衍生自以色列"铁穹"系统的陆基中近程防空系统,计划配属陆战队低空防空营(LAAD)。其主要任务为保护固定设施免受巡航导弹、无人机及其他低空飞行器威胁。该系统由雷神公司"天袭者"拦截弹(拉斐尔"塔米尔"导弹改进型)、AN/TPS-80对空任务雷达及通用航空指挥控制系统组成,系1990年代末退役的"霍克"防空导弹远程继任者。2024年8月,陆战队授予雷神公司2500万美元合同采购80枚拦截弹及相关设备,用于组建首个排级MRIC单位。次月10月,陆战队宣布计划签订合同部署三个MRIC炮兵连,远期目标为列装12个MRIC排级单位。

陆军机动近程防空系统(M-SHORAD)

图3:陆军机动近程防空系统(M-SHORAD)

美陆军机动近程防空系统(M-SHORAD)旨在为旅级机动部队提供对抗固定翼/旋翼飞机及无人机的空防能力。陆军2017年发布招标公告,2020年授予通用动力陆地系统与莱昂纳多DRS公司增量1型合同。该版本武器套件由莱昂纳多公司配置,包含:AGM-114L"长弓地狱火"反地面导弹、FIM-92"毒刺"防空导弹、XM914型30毫米机炮、M-240机枪及多任务雷达,集成于通用动力斯特瑞克装甲车平台。2024年6月,该系统以荣誉勋章得主米切尔·斯托特中士之名更名为"SGT STOUT"系统。

部分分析指出,由于增量1型以毒刺导弹为主防空武器,其反无人机效费比存在不足。后续改进型计划整合其他武器系统以提升效能并降低成本。

-

增量2型将加装50千瓦激光器应对1-3类无人机。根据《2028陆军空天导弹防御战略》,定向能(DE)型M-SHORAD将于2028年形成"定向能与导弹混合编配,2034年前逐步提高定向能占比"的作战力量。陆军快速能力与关键技术办公室(RCCTO)2021年完成原型评估,2024年2月在中东战区部署四套原型系统。媒体报道称,因初期原型未达预期,正评估改进型号。国防部作战测试与评估局(DOT&E)在2024财年报告中指出,此次部署导致RCCTO未能按计划启动年度科技测试。

-

增量3型计划集成"下一代近程拦截弹"(NGSRI)——毒刺导弹的潜在继任者之一,同步开发XM1223多任务近炸弹药(MMPA)。该30毫米多用途弹种可应对小型无人机、装甲车辆及人员目标。

根据2025财年预算申请,陆军为M-SHORAD申请6910万美元采购资金及3.15亿美元研发测试资金。预算文件显示,研发资金中2.049亿美元将投入增量3型开发。

陆军间接火力防护能力(IFPC)系统

陆军"间接火力防护能力"(IFPC)系统是用于保护高价值设施免受火箭弹、迫击炮、火炮(RAM)威胁以及无人机与巡航导弹攻击的陆基防御体系。其前身为"百夫长"反火箭弹、火炮和迫击炮(C-RAM)系统,2004年启动研发并于2006年列装,现称为IFPC增量1型(IFPC Inc 1)。当前规划包含三个后续型号:IFPC增量2型(IFPC Inc 2)、高能激光型(IFPC-HEL)与高功率微波型(IFPC-HPM),均处于不同研发测试阶段。IFPC系列被定位为固定设施防空的补充力量,与机动部队的M-SHORAD系统形成协同。增量2型以地对空拦截导弹为主武器,设计用于对抗2-3类无人机;HEL与HPM型则聚焦1-2类小型无人机近程防御。据报道,海军陆战队正探索采购机动性更强的IFPC-HPM小型化版本。

根据2025财年预算申请,陆军为IFPC增量2-1项目申请6.576亿美元采购资金,用于增量2型低速初始生产及增购AIM-9X拦截弹与发射装置。另申请1.679亿美元研发测试评估资金用于"间接火力防护增量2 Block1"项目。在"扩展任务域与导弹"(EMAM)计划下,申请3570万美元研发高能激光与高功率微波衍生型号。值得注意的是,陆军在2025财年预算中调整了IFPC-HEL的远期经费规划,缩减了未来数年该系统的投入规模。

反无人机系统指挥控制体系

指挥控制(C2)系统用于定位、识别、追踪空中威胁,并协调选择部署最优对抗手段。陆军20世纪90年代推出"前沿区域防空指挥控制"(FAADC2)系统,首次为近程防空(SHORAD)体系提供C2能力。2020年,联合反无人机办公室(JCO)核准三套C2系统供各军种使用:陆军FAADC2、海军陆战队与空军"多环境域无人系统应用指挥控制"(MEDUSA)、以及空军"防空系统集成器"(ADSI)。LIDS与M-SHORAD系统均采用FAADC2平台。

军方官员指出指挥控制能力是国防部应对无人机威胁的长期挑战。部分评论人士质疑现役C2系统的反无人机效能:有观点认为FAADC2软件需操作员手动选择并锁定单个目标,导致"操作员注意力偏离关键空情识别,加剧人为失误与效率低下";另有观察指出国防部缺乏统一的反无人机C2软件架构,部分硬件仅适配特定系统(如FAADC2与MEDUSA)。

美国防部官员强调硬件与软件兼容性不足可能阻碍新技术整合。2025年,陆军计划评估FAADC2替代方案,寻求面向机动反无人机作战的新型C2解决方案。负责"复制者2号反无人机系统"(Replicator 2 C-UAS)的国防创新单元(DIU)表示,C2问题研究是其核心任务。2024年12月,DIU发布"前沿反无人机指挥控制(FCUAS C2)系统"招标公告,该系统可能最终取代现役FAADC2。

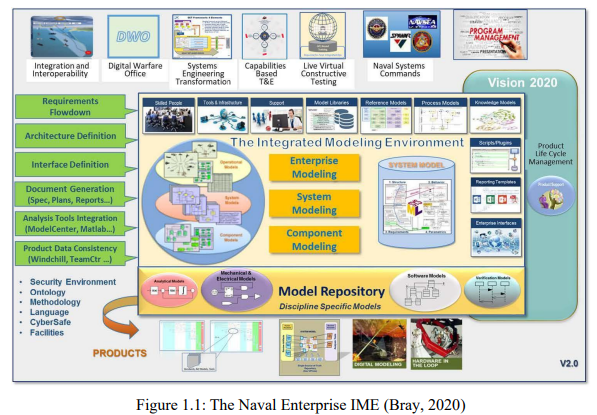

美国海军发布了《海军与陆战队数字系统工程转型战略》(DSETS),推动全兵种组织变革,要求从传统文档中心的需求-采办-保障(R/A/S)模式转向集成数字环境(Bray 2020)。基于模型的系统工程(MBSE)等先进数字工具可提升装备全生命周期内的设计流程、互操作性、功能维护与保障效能(Zimmerman等 2017),为新一代无人水面舰艇(USV)等自主系统赋予战术优势(Del Toro 2024)。

自主系统设计需应对复杂技术挑战,但过度关注自动化功能往往导致人因工程与工效学(HF/E)要素缺失(Lee & Seppelt 2009;Liu等 2016)。研究表明,HF/E整合不足将危及作战安全、系统性能与人机交互(Hancock 2019;Parasuraman & Riley 1997)。本研究强调HF/E要素应作为先导设计条件,而非事后补丁。通过构建经过验证的USV人因需求MBSE框架,为决策者提供结构化数字模板。核心研究问题(RQ1)聚焦:USV综合HF/E需求框架的构成要素?经验证模型涵盖11个核心组件与6类通用功能下的117项需求,涉及感知、认知、时域、人机工程与辅助领域,经专家验证可有效应对自主系统设计、操作与维护中的关键挑战。该框架旨在优化人机交互、降低失误率、缓解认知负荷并增强态势感知。

补充研究问题(RQ2)探究MBSE技术优势。通过框架构建、修正与验证过程中的实证研究,揭示MBSE在需求捕获、可追溯性、版本控制与产品生命周期管理(PLM)方面的优势(Visure;Zimmerman等 2017)。专家访谈证实MBSE在复杂架构中管理HF/E需求的有效性,验证本研究采用MBSE在数字生态中捕获与管理需求的可行性。研究还表明MBSE提供可扩展的数字化工程解决方案,符合国防部(DoD)与海军数字化转型目标,为开发最优自主系统奠定基础框架。

问题陈述

无人水面舰艇(USV)等先进自主系统的快速应用、开发与优先部署需要大量带宽、精力与关注度。此类资源的高度倾斜导致关键人因工程与工效学(HF/E)需求被忽视,引发错误信任、不切实际的预期、操作失误及系统故障(Lee & Seppelt,2009;Vicente,2003)。

研究目的

自主系统需整合机器学习算法、通信系统、复杂计算机编程与传感器等先进技术要素,这些方面需要工程团队投入大量资源,并受到利益相关方同等关注。美国海军加速部署配备先进技术的USV,增加了忽视关键HF/E需求的风险。传统文档中心方法加剧此问题,割裂需求-采办-保障(R/A/S)流程,阻碍HF/E专家与工程团队的有效协作(Muhammad等,2023;Zimmerman等,2017)。此类疏漏将推高长期保障成本、导致重复设计、需专业干预措施,并为操作与维护人员制造低效环节(Hancock,2019;Liu等,2016;Salmon,2019)。设计需求必须包含并优先考虑HF/E要素,以优化系统交互、安全性及USV整体性能(Proctor & Van Zandt,2018;Vicente,2003)。现有文献既未明确USV设计所需的HF/E要素,也未提出系统性实施框架。

将HF/E需求整合至USV设计初始阶段至关重要。整合HF/E与工程学科的庞杂信息、流程与活动,需摒弃孤立式"非数字化"系统开发模式(Bray,2020;Muhammad等,2023;Zimmerman等,2017)。本研究识别并捕获USV设计与操作所需的HF/E要素,采用基于模型的系统工程(MBSE)软件构建结构化需求框架。该可复用、可调整的框架使HF/E要素成为系统之系统(SoS)架构的数字基础需求,涵盖感知、认知、时域、人机工程与组织维度,优化有人-无人协同作战(MUM-T)。通过构建包含结构、行为、活动与参数模型的系统架构,为设计团队提供满足需求的集成化数字生态系统(Hause,2011)。

本研究采用混合研究方法获取有效HF/E数据,通过专家访谈验证框架与建模技术。项目管理方采用经验证的HF/E需求框架将提升USV安全性、效率与效能(Lau等,2020;Ramos等,2022)。研究成果支持美国海军在科技与数字工程领域的持续投入,在HF/E常被忽视的现状下提升USV设计与作战效能。该可复用、可定制的HF/E模型体现了对自主系统操作人员的责任承诺。正如美国特种作战司令部(USSOCOM)强调:"人员而非装备决定成败",特种部队信条"人员重于硬件"(USSOCOM,未注明日期)即为此理念的集中体现。

研究意义

本研究通过将HF/E需求嵌入设计核心,填补USV开发与部署的关键空白。将此类要素纳入集成数字架构可提升作业安全、优化人机交互并增强需求可追溯性(Carrol & Malins,2016;Liu等,2016)。研究强调因HF/E缺陷导致的系统修改与保障成本将使USV"离线",影响远程海上行动。所构建的可移植模型亦适用于其他军用与民用自主平台领域。提升认知与推动需求采纳是本研究的核心驱动力,旨在优化人员福祉、MUM-T协同与系统性能(Lee & Seppelt,2012)。

Proctor与Van Zandt(2018)阐明了HF/E的基本原则:忽视该要素将导致性能下降、错误率上升与风险增加。本研究运用数字图表与建模工具捕获并优化USV适用的HF/E要素。采用的MBSE方法支持需求的系统化开发、整合与验证(Lu等,2022;Madni & Sievers,2018)。将HF/E需求整合至USV系统模型,使其成为基础"构建模块",通过功能与活动模型实现需求验证。

本研究成果对HF/E学术界、科研界与工业界具有重要价值。研究反馈证实HF/E要素对创建健康高效工作环境的必要性。Håkansson与Bjarnason(2020)强调将HF/E视角融入需求工程(RE)可降低压力并提升用户满意度。参与USV"论域"构建的项目办公室、需求制定方、操作维护人员须践行此理念(参见术语表)。经验证的HF/E框架通过集成反馈机制促进安全高效的操作环境与持续改进,通过迭代优化应对新兴挑战与利益相关方需求。

本研究契合美国海军战略文件提出的数字化转型与现代工程目标。Bray(2020)指出数字模型在海军R/A/S流程中的重要性,可打破"卓越孤岛"并增强协作效能。Zimmerson等(2017)强调变革管理策略、数字工具应用与持续利益相关方参与对转型的关键作用。本研究通过MBSE构建HF/E需求框架,支持海军数字化转型战略。经验证框架可供海军及跨领域自主系统开发人员使用,其双重意义在于:优先考虑以人为中心的设计原则提升USV功能,同时践行海军数字工程战略。

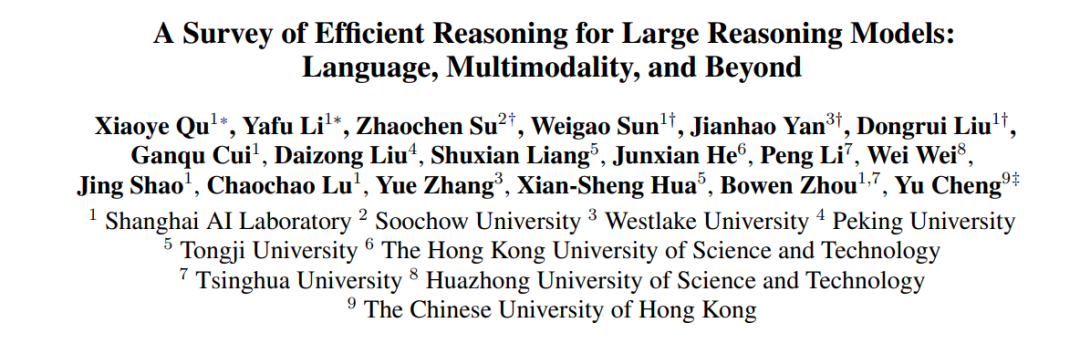

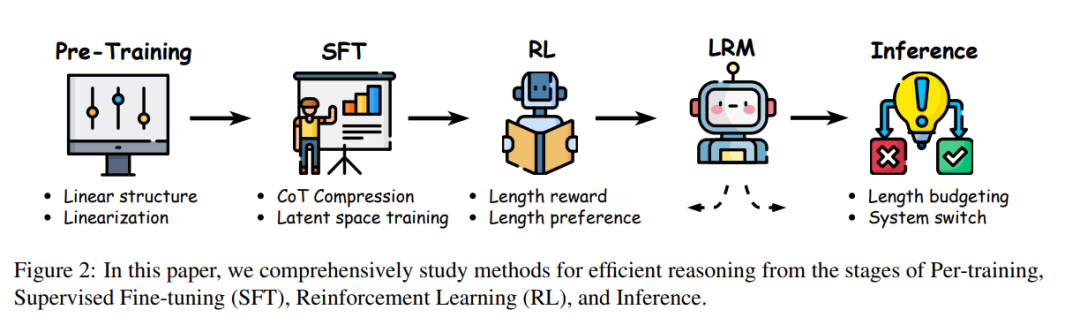

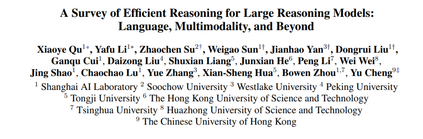

《近期大推理模型(如DeepSeek-R1与OpenAI o1)通过扩大推理过程中的思维链(CoT)长度,显著提升了性能表现。然而,这些模型倾向于生成过长的推理轨迹,其中常包含冗余内容(如重复定义)、对简单问题的过度分析,以及对复杂任务推理路径的浅层探索。这种低效性为训练、推理及实际部署(如基于代理的系统)带来了严峻挑战,尤其在token经济性至关重要的场景中。

本综述系统梳理了当前提升大推理模型效率的研究进展,重点关注这一新范式下的独特挑战。我们总结了低效性的常见模式,分析了从预训练到推理全生命周期中提出的优化方法,并探讨了未来潜在的研究方向。为支持领域发展,我们同步维护了一个实时GitHub仓库,追踪最新研究成果。希望本文能为后续探索奠定基础,并激发这一快速发展领域的创新。

**

**

**1 引言

“简洁是智慧的灵魂。”

——威廉·莎士比亚 大型语言模型(LLMs),如 DeepSeek V3(Liu et al., 2024a)、Qwen 2.5(Yang et al., 2024a)、LLaMA 3(Dubey et al., 2024)和 GPT-4o(Hurst et al., 2024),已在广泛任务中展现出卓越能力(Chang et al., 2024; Zhao et al., 2023; Kasneci et al., 2023; Zhu et al., 2024)。这些模型的运作方式类似于 系统1思维(Frankish, 2010; Kahneman, 2011; Li et al., 2025e),即快速、直觉化、自动化的决策过程。然而,复杂推理任务(如高等数学(Lightman et al., 2023; Besta et al., 2024; Ahn et al., 2024)和形式逻辑(Huang and Chang, 2022; Pan et al., 2023))需要更审慎、结构化的分析。 为应对这些挑战,一类新型模型应运而生——大型推理模型(LRMs),包括 DeepSeek R1(Guo et al., 2025)、OpenAI-o1/o3(Jaech et al., 2024)和 QwQ(Team, 2024)。这些模型通过显式生成中间推理步骤(即 思维链(CoT)(Wei et al., 2022))来提升性能,最终得出答案。与LLMs的快速启发式推理不同,LRMs展现出类似 系统2思维(Evans, 2003; Kannengiesser and Gero, 2019)的审慎分析能力。 然而,这一能力伴随代价:LRMs的推理过程往往更慢、更冗长。如图1所示,对于一道小学数学题,QwQ-32B 生成的 token 数量远超 Qwen2.5-32B-Instruct(基于系统1的模型)。此外,统计分布显示,LRM模型 QwQ-32B 的输出长度显著大于LLM模型 Qwen2.5-32B-Instruct。这一现象自然引出一个关键问题: 除了推理性能,我们如何让LRMs的推理更高效,从而最大化每个token的智能?

在LRM时代,我们主张 “效率是智能的精髓”。正如智者懂得何时停止思考、做出决策,一个聪明的模型也应知道何时终止不必要的推演。智能模型应优化 token经济——即有目的地分配token、跳过冗余、优化求解路径。它不应机械遍历所有可能的推理路径,而应像战略大师一样,以精准的平衡兼顾成本与性能。

**1.1 综述结构

本综述系统梳理了LRMs高效推理的最新进展,并按LLM生命周期阶段分类(图2)。图3展示了本文涵盖的高效推理方法分类体系。全文结构如下: 1. 第2节 探讨LRM时代推理低效的模式与挑战。 1. 第3节 介绍推理阶段的高效推理方法。 1. 第4节 阐述通过监督微调(SFT)内化简洁推理的技术。 1. 第5节 分析强化学习(RL)中控制推理长度的策略。 1. 第6节 讨论模型架构与训练范式的固有高效性。 1. 第7节 展望各阶段待突破的未来方向。

**1.2 定位与贡献

近期多项综述研究了大型推理模型的发展。Besta et al.(2025)和Zeng et al.(2024a)聚焦LRM训练方法,而Li et al.(2025e)提供了更全面的领域概览。为聚焦深层问题,Chen et al.(2025b)研究了长思维链推理并归类现有范式;Ji et al.(2025)则探索了LRM的测试时扩展。然而,现有研究均未专门讨论LRMs推理效率这一关键挑战——它直接影响模型部署、扩展与实际应用。 对于早期LLMs,Zhou et al.(2024)综述了高效推理方法。但LRMs的高效推理是一个新兴且独特的研究挑战,其核心在于冗长且不可控的推理token生成。传统加速推理方法(如模型量化与剪枝(Polino et al., 2018; Xiao et al., 2023a; Xia et al., 2023; Wang et al., 2019; Ma et al., 2023; Cheng et al., 2024)及分布式推理系统(Patel et al., 2024; Hu et al., 2024a; Zhong et al., 2024; Lin et al., 2024a))虽能降低延迟与计算成本,但本文聚焦于推理过程本身的效率优化,而非通用推理加速。 综上,本综述的核心贡献如下: * 区别于泛泛概述LRMs,我们聚焦高效推理这一新兴关键议题,提供深度定向分析。 * 归纳推理低效的常见模式,并阐明大型模型效率优化的独特挑战。 * 系统回顾提升推理效率的最新进展,涵盖从预训练、监督微调、强化学习到推理的端到端LRM开发流程。