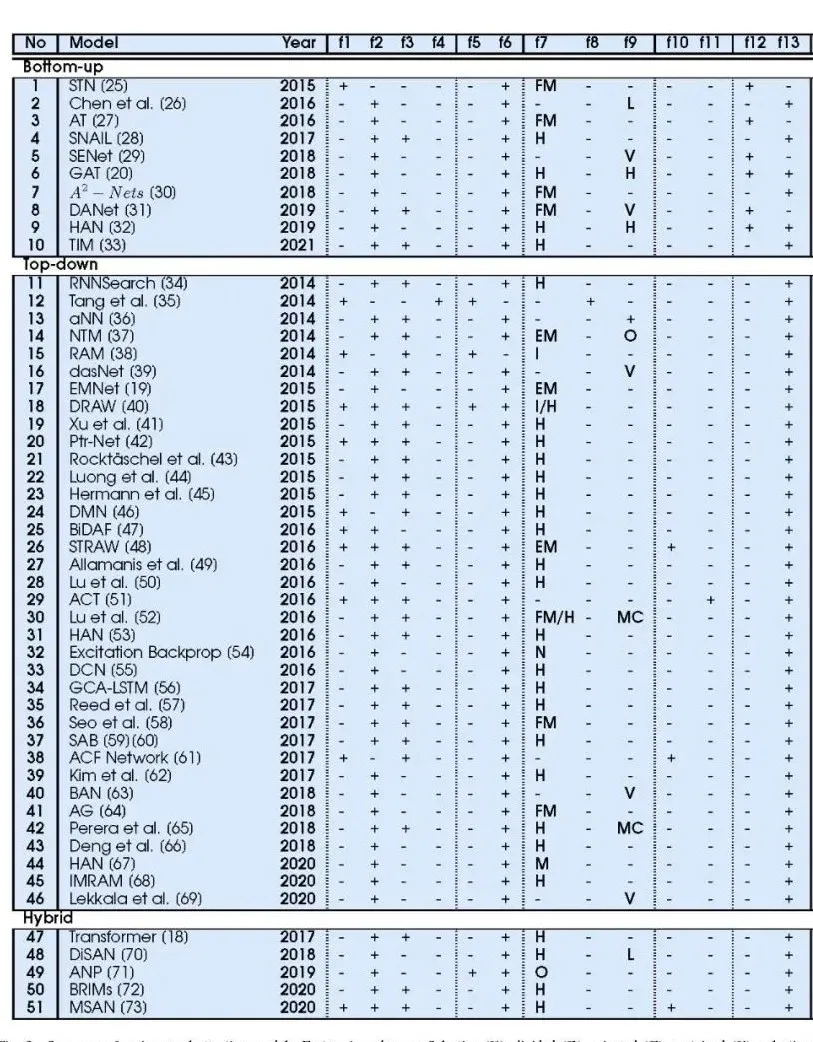

注意力是一种能够通过选择性地关注某一信息而忽略其他可感知信息来处理人类有限的处理瓶颈的唤醒状态。几十年来,注意力的概念和功能在哲学、心理学、神经科学和计算机领域都得到了研究。目前,这一特性已经在深度神经网络中得到了广泛的研究。现在有许多不同的神经注意力模型,在过去的六年中已经成为一个非常活跃的研究领域。本研究从注意力理论的角度,对主要的神经注意力模型进行了批判性的分析。在这里,我们提出了一个分类法,它与深度学习之前的理论方面相印证。我们的分类法提供了一个组织结构,提出了新的问题,并构建了对现有注意力机制的理解。特别是,从心理学和神经科学经典研究中提取的17个标准被制定出来,用于定性比较和批判性分析在一组650多篇论文中发现的51个主要模型。此外,我们强调了几个尚未被探索的理论问题,包括讨论生物学的合理性,强调了当前的研究趋势,并为未来提供见解。

注意力是一种能够通过选择性地关注某一信息而忽略其他可感知信息[1]来处理有限的处理瓶颈的唤醒状态。根据James[2],注意力可以被认为是一种内在的力量,自发地或自愿地创造一种感官或运动性质的心理期望,有利于刺激的感知和反应的产生。这种内在的力量也可以理解为一种认知需求,因为在任何时候,环境呈现的感知信息都超过了所能支持的范围,不可能同时对所有的外部刺激做出所有的运动动作。在自然界中,注意力是关系到一切形式生命生存的基本活动,是生物认知进化的长期过程。在进化尺度最低的生物中,注意力主要表现在感知、选择和调节环境相关刺激。这种机制对物种的延续和进化起着决定性的作用,因为它的特征是能够在环境中感兴趣的地点安顿下来,并识别可能的猎物、捕食者或竞争对手。在人类的认知周期中,注意力内在地存在于大脑中,从感知刺激、组织复杂的心理过程到做出决策。

几十年来,一些科学领域一直在关注理解注意力的作用。在心理学方面,早在1890年就有研究在寻找反映人类大脑中注意力过程表现的行为相关性,例如监视时间[3],非注意力盲点[4],注意力眨眼[5],认知处理的反应时间[6],以及过滤外部刺激的选择性能力[7]。认知神经科学研究已经采用了侵入性和非侵入性的方法,如神经解剖/神经生理学技术、脑电图、正电子发射断层扫描(PET)和功能磁共振成像(fMRI),以捕捉关于注意障碍[8]的见解。神经生理学家试图研究神经元如何对表示感兴趣的外部刺激作出反应。最后,计算神经科学家从不同的角度捕捉所有的见解,并支持现实的计算模型来模拟和解释注意力行为,寻求理解如何,在哪里和何时发生注意力过程或需要[10]。

受这些研究的启发,计算机科学家在20世纪90年代首次提出了计算机系统的注意力机制,以解决当时存在的算法的高计算复杂性所固有的性能限制。最初,几个注意力视觉模型用于物体识别[11],图像压缩[12],图像匹配[13],图像分割[12],目标跟踪、主动视觉[14]和识别[11]的灵感来自于特征整合理论——这是最早将视觉注意形式化的理论之一——在该理论中,系统会从单独观察的场景中提取一组简单的特征,在随后的步骤中,刺激的整合发生,支持识别环境中的相关物体。随后,视觉注意力成为一种能够为机器人决策提供必要环境信息的工具。因此,几个机器人导航系统[15],SLAM[16]和人机交互[17]集成注意力来提高这些自主代理的性能。

人工智能作为提高深度神经网络性能的一个基本概念,在过去的十年中引起了科学家们的关注。在深度学习中,Attention带来了一种受人脑启发的计算新形式,这与今天的神经网络所做的完全不同。注意力机制使网络更易于扩展,更简单,促进多模态,并减少了长期空间和时间依赖带来的信息瓶颈。目前,注意力接口集中在两个主要的发展和研究前沿,即可以很容易地插入到经典DL架构和端到端注意力网络中,注意力在整个架构中都内在地存在。注意力接口通常是对卷积和递归操作的补充,允许控制来自神经结构的特定部分或其他外部认知元素(如外部记忆、预训练层)的资源和内部或外部信息的动态流动。端到端注意力网络代表了深度学习的主要进展。自然语言处理的先进方法,多模态学习,以及通过图神经网络的非结构化数据学习使用端到端注意力方法。目前,许多针对DL的研究在最多样化的应用领域中使用了注意力结构,因此,自2014年以来,我们已经能够在主要出版物库中发表了6000多篇论文。

尽管在计算机、心理学、神经科学、甚至哲学的各个领域都有大量的研究,但历史问题是注意力在大脑中无处不在,因为没有一个单一的注意力中心,这使得研究的概念和方面非常抽象,难以验证。当一组相关概念和想法变得难以管理时,分类法是有用的。通过分类学,可以对不同的方面进行分类和系统的研究。在心理学和神经科学中,这个问题仍然存在,但已经有一些理论和分类被一些认知行为研究者广泛接受。具体来说,在深度学习中,没有基于注意力的理论概念的分类,因为存在的少数几个概念远远不是理论概念,而且在给定的范围[23][24]中非常具体。从这个意义上说,一个由基于心理学和神经科学概念的分类法支持的统一的注意力框架是必要的,以阐明不同的注意力机制如何在DL中发挥作用,促进新的研究机会的可视化。因此,我们的目标是在本工作中为读者提供一个神经网络的注意力分类,基于对注意力的各种理论见解和深度学习[1]之前的几个相关研究。

这项综述提出了一个分类法,证实了在深度学习之前的注意力理论方面。在分类法的基础上,提出并讨论了该领域的主要神经注意力模型。作为我们工作的主要贡献,我们强调:

- 提出了统一的注意力框架;

- 引入了第一个综述,以注意力的理论概念为基础进行分类;

- 系统回顾了主要的神经注意力模型,并提供了我们所有的搜索和过滤工具,以帮助研究人员在未来的搜索主题;

- 通过穷举搜索和过滤技术选择主要工作,从批判性分析的650多篇论文中选择最相关的来进行调研;

- 在分类的基础上,探讨了主要注意力机制的生物学合理性;

- 根据分类中提出的概念,详细描述了该领域的主要注意力系统;

- 最后,我们对趋势和研究机会进行了广泛的描述。

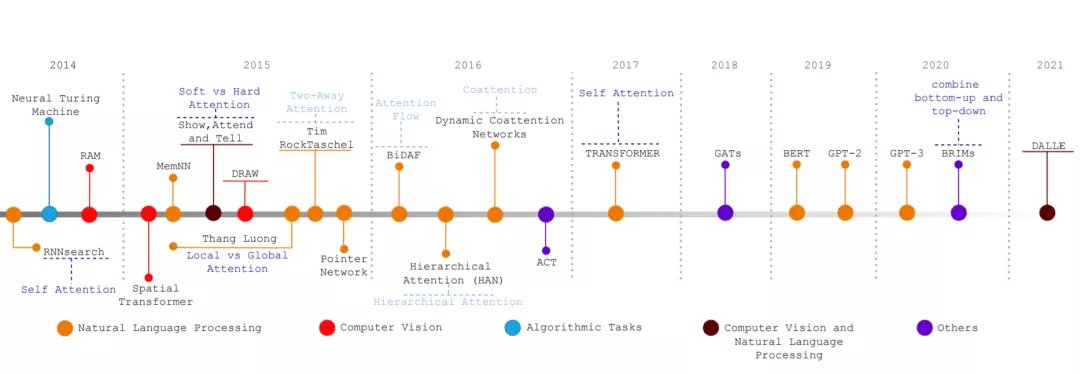

从2014年到现在的主要关键发展。RNNSearch[34]呈现第一注意力机制。神经图灵机[37]和记忆网络[89]引入了记忆和动态流控制。RAM[38]和DRAW[40]学会了将多一瞥、视觉注意力和顺序处理结合起来。空间变换器[25]引入了一个模块,以增加CNN对变化的鲁棒性。展示,参加和告诉[41]创造了多模态的注意力。指针网络[42]将注意力呈现为一个指针。BiDAF[47]、HAN[53]和DCN[55]提出了将数据与不同层次级别对齐的注意力技术。ACT[51]介绍了计算时间的主题。神经变换器[18]是第一个具有端到端注意力方法的自我注意力神经网络。GATs[20]在GNN中引入了注意力。BERT[90]、GPT-2[91]、GPT-3[92]和DALLE[93]是语言模型和文本-图像生成技术的最新进展。最后,BRIMs[72]学会了自下而上和自上而下信号的结合。