【综述】医疗可解释人工智能综述论文

【导读】近年来,随着深度学习的出现,人工智能,特别是机器学习在许多任务中表现出了非凡的表现,并涉足许多不同的领域和学科。其中一些,例如医疗领域,需要透明度,这意味着我们需要解释机器决策,预测并证明其可靠性。这需要更高的可解释性,并促使我们理解算法背后的机制。不幸的是,深度学习的黑盒问题仍然没有得到解决。我们整理了对不同研究工作所提出的解释性,并对其进行了分类,旨在提供替代视角,希望今后采用可解释性标准更易于处理。我们进一步探讨了医学领域的可解释性,说明了可解释性问题的复杂性。

介绍

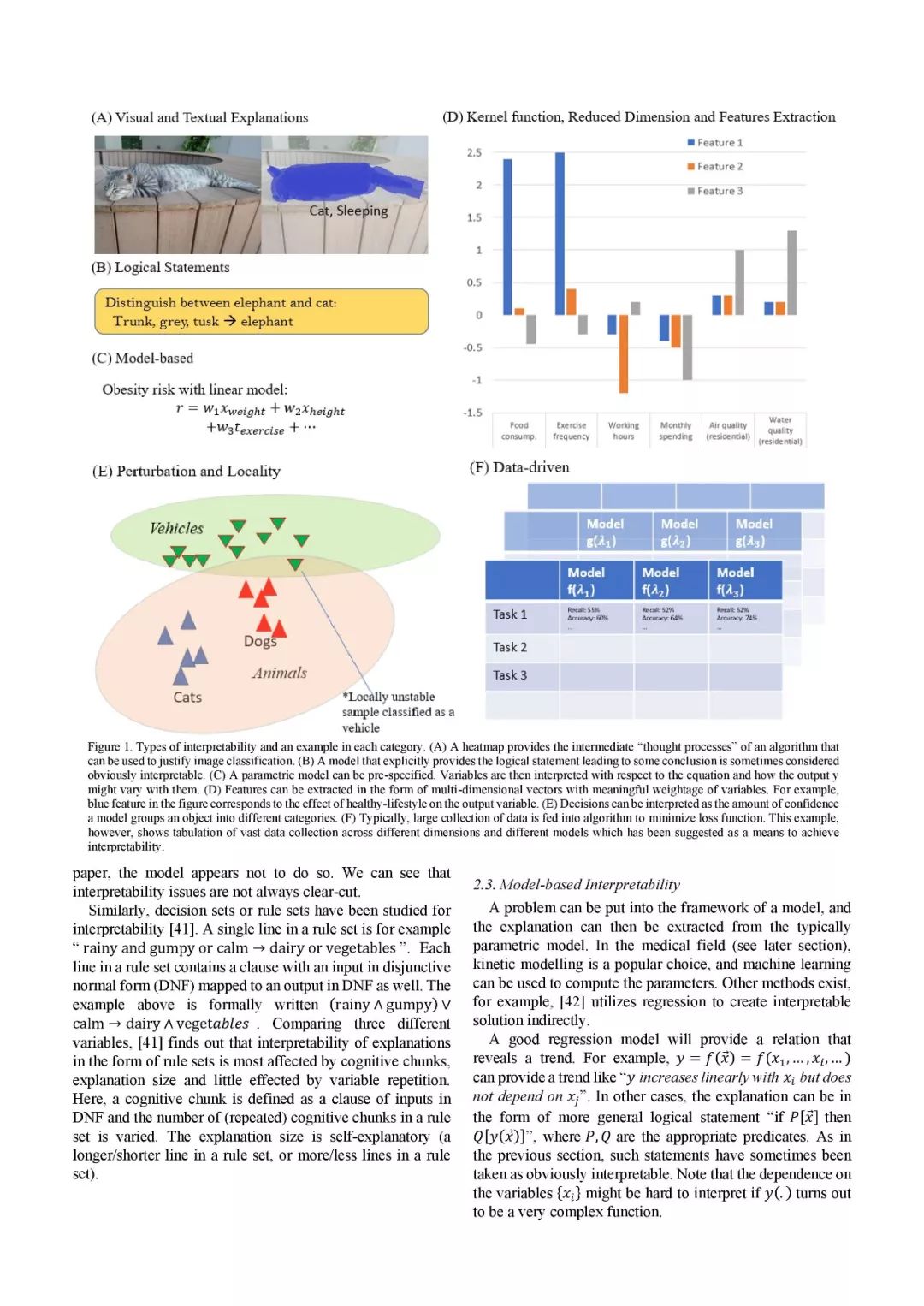

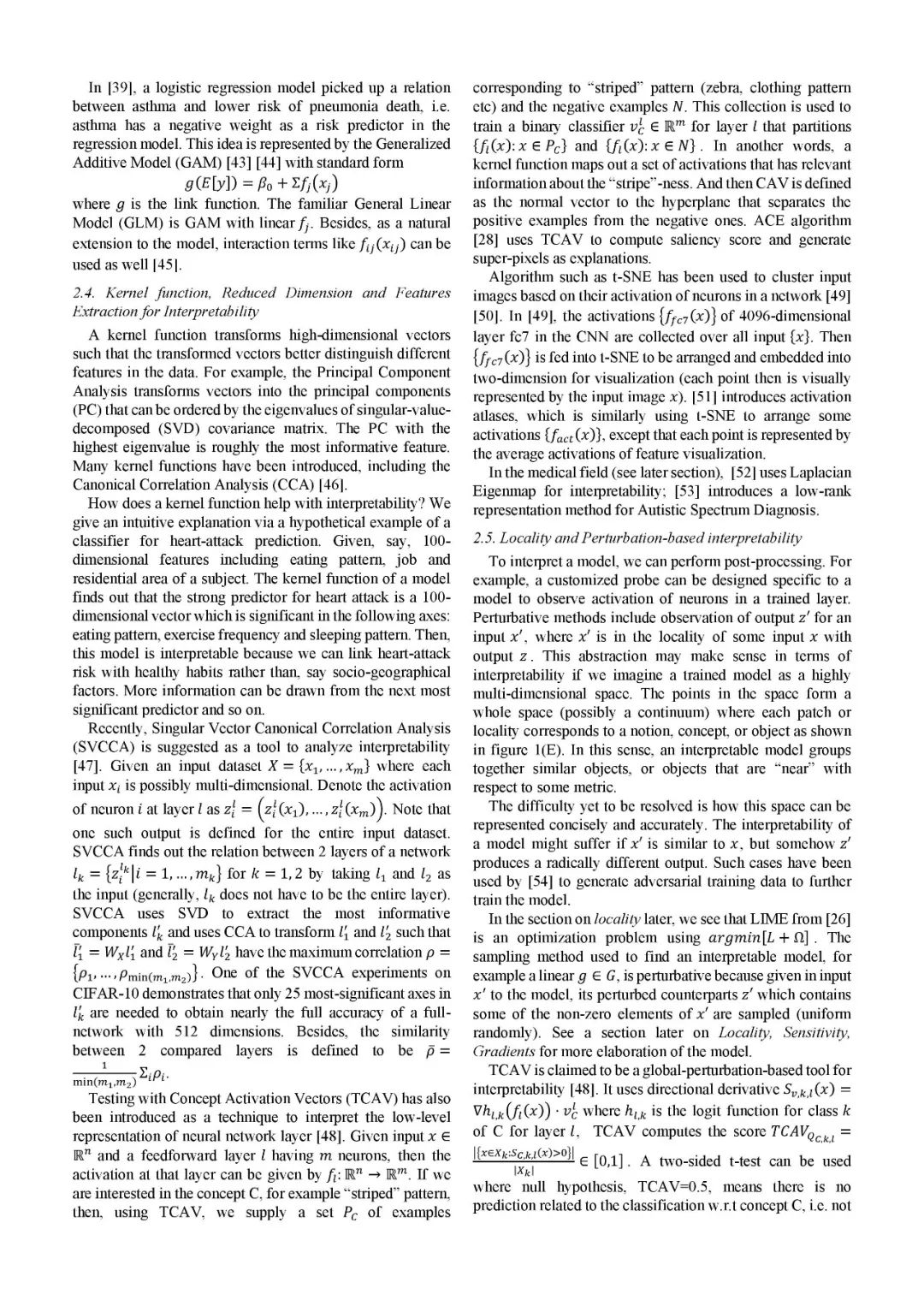

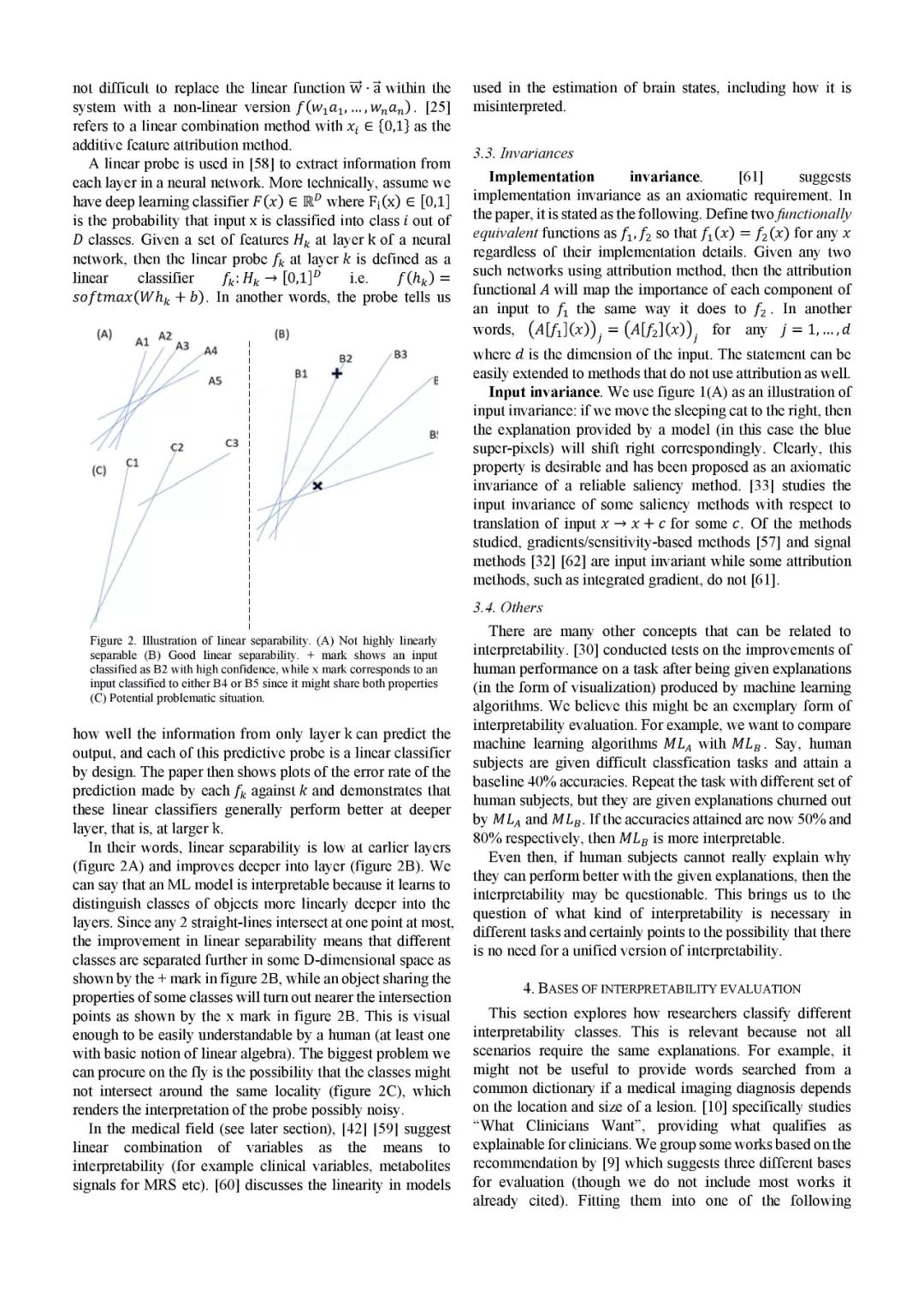

在某些领域,失败是不允许出现的:在自动驾驶中,即使是暂时功能失调的计算机视觉算法也容易导致车祸。在医疗领域,在早期阶段检测疾病通常对于患者的康复或防止疾病进展到更严重的阶段是至关重要的。虽然机器学习,人工神经网络,脑机接口和相关子领域,在执行医疗任务方面表现出了很好的表现,但它们并不完美提供机器学习的可解释性。可解释性因此成为迫切的问题:如果出现问题,谁负责?我们可以解释为什么出问题吗?如果事情运作良好,我们是否知道为什么以及如何进一步利用它们?许多论文提出了不同的措施和框架来捕捉可解释性,而可解释的人工智能(XAI)这一主题已成为ML研究界的热点。此外,可解释性评估标准(例如可靠性,因果关系和可用性)的激增有助于机器学习社区跟踪算法的使用方式以及如何改进其使用,为进一步的开发提供指导。

在这项工作中,我们通过与机器学习的可解释性相关的研究工作进行一般性的调查,对它们进行分类,然后将相同的类别应用于医学领域的可解释性。我们不会试图涵盖所有相关的工作,其中许多已经在我们引用的研究和调查工作中提出。本文安排如下:第2节探讨了可解释性的类型;第3节列出了可解释性研究中经常出现的一些概念;第4节对可解释性的方法进行分类;第5节将前面的部分扩展到医学领域。

论文链接:

https://arxiv.org/abs/1907.07374

获取全文PDF

请关注专知公众号(点击上方蓝色专知关注)

后台回复“XAIMed” 就可以获取《3医疗可解释人工智能综述论文》论文的下载链接。

附论文部分预览:

END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!550+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程