注意力机制综述(中文版)

现在注意力机制已广泛地应用在深度学习的诸多领域。基于注意力机制的结构模型不仅能够记录信息间的位置关系,还能依据信息的权重去度量不同信息特征的重要性。通过对信息特征进行相关与不相关的抉择建立动态权重参数,以加强关键信息弱化无用信息,从而提高深度学习算法效率同时也改进了传统深度学习的一些缺陷。因此从图像处理领域、自然语言处理、数据预测等不同应用方面介绍了一些与注意力机制结合的算法结构,并对近几年大火的基于注意力机制的transformer和reformer算法进行了综述。鉴于注意力机制的重要性,综述了注意力机制的研究发展,分析了注意力机制目前的发展现状并探讨了该机制未来可行的研究方向。

https://kns.cnki.net/kcms/detail/detail.aspx?dbcode=CAPJ&dbname=CAPJDAY&filename=JSJY20210122003&v=5lc3RO%25mmd2BEUUDZ5VKfFMXXRYqRj2gJNUsuDvVgyw8OHyIxoY4RlsajnkKOO%25mmd2Fg2oJ44

信息一直在人们生活交往中扮演的重要角色,如图像处 理、信息识别、智能计算、自动控制等方面,都是以信息为基 础进行研究[1]。但是繁琐庞大、又时常模糊的信息往往让专 家学者在探索信息内容时遇到了阻碍,因此一些关于处理信 息的科学技术便如雨后春笋般的涌现。其中以深度学习为主 要代表的人工智能开始活跃在人们视线中。

近年来,深度学习在人工智能的领域一直充当领跑者的 身份,在模式识别、计算机视觉、自然语言处理中有着广泛的 应用[2]。深度学习的想法源于人工神经网络的研究,而神经网 络的研究是由真实大脑结构激发的,神经网络有很多种类型, 如[3]中介绍,但基本原理是非常相似的。网络中的每个神经元 都能够接收、处理输入信号并发送输出信号。每个神经元与 其他神经元连接的关系用一个称为权系数的实数来评估,该 实数反映了给定连接在神经网络中的重要程度[4]。深度学习 就是像神经网络结构一样,通过每层间的输入输出相连接关 系,人们可以学习到大量信息特征[5]。

而注意力机制是自深度学习快速发展后广泛应用于自然 语言处理、统计学习、图像检测,语音识别和计算机等领域的 核心技术[6]。专家学者根据对人类注意力的研究,提出了注意 力机制,本质上说就是实现信息处理资源的高效分配[7]。当一 个场景进入人类视野时,往往会先关注场景中的一些重点,如 动态的点或者突兀的颜色,剩下的静态场景可能会暂时性的 忽略[8]。例如当人们需要寻找图片中的人物信息时,会更多的 注意符合人物特征的图片区域,而忽略那些不符合人物特征。

的图片区域,这样就是注意力的合理有效分配。注意力是人类 大脑中一项不可或缺的复杂认知功能,在日常生活中,人们通 过视觉、听觉、触觉等方式接收大量的信息,但是人们可以在 这些外界的信息轰炸中还能有条不紊地工作,是因为人脑可 以有意或无意地从这些大量输入信息中选择小部分的有用信 息来重点处理,并忽略其他信息,这种能力就叫作注意力。注意 力机制能够以高权重去聚焦重要信息,低权重去忽略不相关 的信息,并且还可以不断调整权重,使得在不同的情况下也可 以选取重要的信息,因此具有更高的可扩展性和鲁棒性[9]。其 基本网络框架如图 1 所示。

此外,它还能通过共享重要信息(即选定的重要信息)与其 他人进行信息交换,从而实现重要信息的传递[10]。因此注意力 机制得到广大研究学者的关注,基于注意力机制的一些新的 研究算法也在不断被提出验证和应用。注意力机制在深度学习中能够发展迅速的原因主要有以 下三个方面。

1) 这个结构是解决多任务最先进的模型,如机器翻译、问 题回答、情绪分析、词性标记、对话系统、数据监测、 故障诊断等[11-17];

2) 注意力机制的显著优点就是关注相关的信息而忽略不 相关的信息,不通过循环而直接建立输入与输出之间的 依赖关系,并行化程度增强,运行速度有了很大提高 [18-19]。

3) 它克服了传统神经网络中的一些局限,如随着输入长度 增加系统的性能下降、输入顺序不合理导致系统的计算 效率低下、系统缺乏对特征的提取和强化等。但是注意 力机制能够很好地建模具有可变长度的序列数据,进一 步增强了其捕获远程依赖信息的能力,减少层次深度的 同时有效提高精度[9,20]。

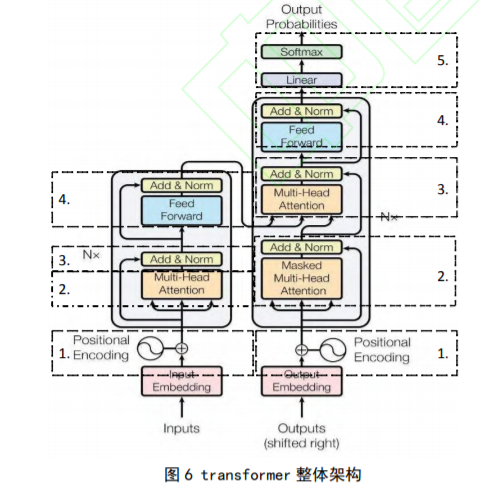

本文以注意力机制中重要的 transformer 算法为分界点, 分别介绍了前期注意力机制与传统算法循环神经网络 (Recurrent Neural Networks, RNN) 、 编 - 解 码 器 (encoder-decoder)、长短期记忆人工神经网络( Long short-term memory, LSTM)等的结合,并应用于图像处理、自然语言处理 和数据预测等领域;和后期以自注意力(self-attention)为基本 结构单元的 transformer、reformer 和 hopfield 等算法的发展与应用。最后在文末综述了注意力机制的应用领域和未来研究 方向的展望。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“注意力机制” 可以获取《注意力机制综述》专知下载链接索引