Open AI Jasonwei 在斯坦福大学的CS330课程,"深度多任务与元学习"上做客座讲座!讲述了一些关于如何理解大型语言模型的非常简单的直觉。

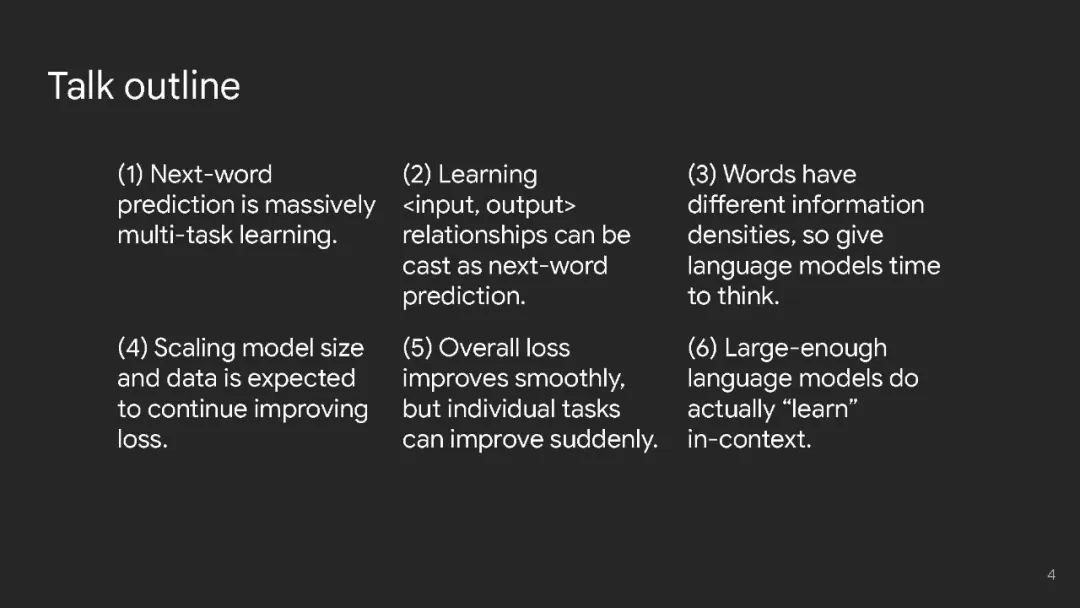

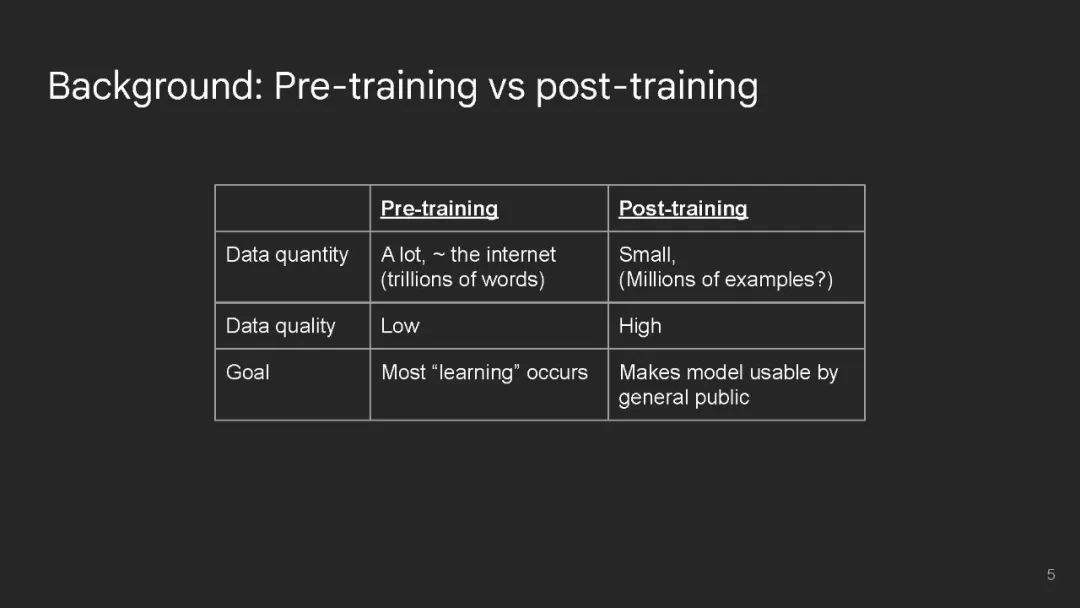

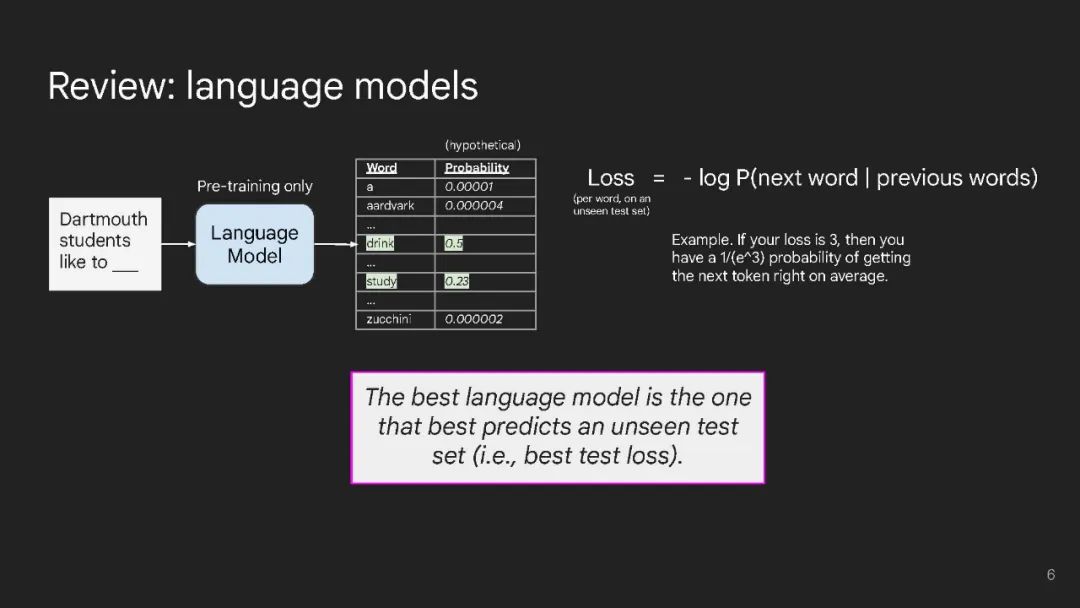

我讨论了一些关于我个人如何理解大型语言模型的非常简单的直觉。 以下是六种直觉: (1) 首先,将下一个词的预测视为大规模多任务学习。尽管下一个词的预测非常简单,但因为预训练数据非常庞大且多样化,语言模型(LM)通过下一个词的预测学习了很多任务。这可以涵盖从简单的语法到更难的任务,比如算术推理。任何可以在预训练数据中找到的东西,都有可能被LM学习。 (2) 接下来,从<input, output>对(即上下文学习)中学习可以被看作是下一个词的预测。这在GPT-3论文中得到了普及([链接])。用<input, output>对来构建任务非常方便,因为这是我们在过去几十年中进行人工智能研究的方式。然而,我不确定这种情况会持续多久。我们可以通过添加自然语言指令、展示推理过程、列举边界情况、给出不应该做的示例等方式做得更好。 (3) 一个基本的观察是,token具有非常不同的信息密度。有些token很容易预测(例如,“大型语言___”显然是“模型”)。其他token则很难预测(例如,数学问题的答案),因此LM在尝试预测它们之前应该花费更多的计算。做到这一点的一种方式是链式思考提示([链接]),它鼓励LM在给出最终答案之前给出一个推理路径,使它们能够完成复杂的推理任务。我梦想着有一天AI能够帮助我们完成极其具有挑战性的任务,比如撰写减少气候变化的提案。在推理上花费更多计算是朝这个方向迈出的第一步。 (4) 预训练时增加计算量预计将改善损失(规模定律,[链接])。这似乎很简单,但损失没有饱和的事实意味着继续投资于扩展将可能产生更有能力的模型。为什么扩展可以提高性能,这是一个自然的问题;我的两个揣测假设是:(1) 大型LM可以记住更多关于世界的知识,(2) 大型LM使用更复杂的启发式方法来尽可能降低损失。 (5) 尽管整体损失随规模平滑改善,但个别任务可能会突然改善(突现能力,[链接])。由于下一个词的预测是大规模多任务学习,你可以将损失视为许多个别任务的加权和。当你减少损失时,可能不是所有个别任务都均匀改善。一些任务的损失可能已饱和(更大的模型在语法上不再有改进,因为它们已经拥有完美的语法),而其他任务可能以更突然的方式改善(为了进一步降低损失,更大的模型必须弄清楚如何解决难度大的数学问题)。 (6) 最后,我认为大型LM实际上可以在上下文中学习<input, output>关系。尽管一篇论文显示,在上下文示例中的随机标签几乎不影响性能([链接]),但我们最近的工作发现,语言模型可以遵循翻转标签和语义无关的标签([链接])。不过,这种能力只存在于足够大的语言模型中(例如,GPT-3.5和PaLM-1或更大)。 地址: https://www.jasonwei.net/blog/some-intuitions-about-large-language-models