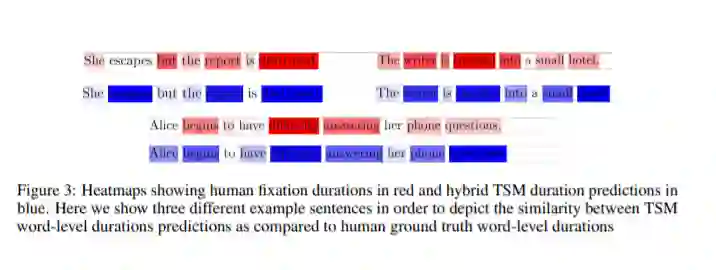

由于语料库的缺乏,在自然语言处理(NLP)的神经注意机制中整合人类凝视数据作为监督信号方面的进展有限。我们提出了一种新的混合文本显著性模型(TSM),这是第一次将阅读的认知模型与明确的人类注视监督结合在一个单一的机器学习框架中。在四个不同的语料库上,我们证明了我们的混合TSM持续时间预测与人类凝视地面真相高度相关。我们进一步提出了一种新的联合建模方法,将TSM预测集成到为特定上游NLP任务而设计的网络的注意层中,而不需要任何特定任务的人类凝视数据。我们证明,在BLEU-4中,我们的联合模型在Quora问题对语料库上的释义生成比目前的水平高出10%以上,并且在具有挑战性的谷歌句子压缩语料库上实现了最先进的句子压缩性能。因此,我们的工作引入了一种连接数据驱动和认知模型的实用方法,并展示了一种将人类注视引导的神经注意整合到NLP任务中的新方法。

https://arxiv.org/abs/2010.07891

成为VIP会员查看完整内容

相关内容

Arxiv

7+阅读 · 2018年5月21日