可应用于实际的14个NLP突破性研究成果(一)

摘要:最好的论文是可以直接走出实验室!NLP年度最佳应用论文大集锦!

语言理解对计算机来说是一个巨大的挑战。幼儿可以理解的微妙的细微差别仍然会使最强大的机器混淆。尽管深度学习等技术可以检测和复制复杂的语言模式,但机器学习模型仍然缺乏对我们的语言真正含义的基本概念性理解。

但在2018年确实产生了许多具有里程碑意义的研究突破,这些突破推动了自然语言处理、理解和生成领域的发展。

我们总结了14篇研究论文,涵盖了自然语言处理(NLP)的若干进展,包括高性能的迁移学习技术,更复杂的语言模型以及更新的内容理解方法。NLP,NLU和NLG中有数百篇论文,由于NLP对应用和企业AI的重要性和普遍性,所以我们从数百篇论文中寻找对NLP影响最大的论文。

2018年最重要的自然语言处理(NLP)研究论文

1.BERT:对语言理解的深度双向变换器的预训练

作者:JACOB DEVLIN,MING-WEI CHANG,KENTON LEE

和KRISTINA TOUTANOVA

论文地址

https://arxiv.org/abs/1810.04805?spm=a2c4e.11153940.blogcont689035.14.192f7c6ar8fwPc&file=1810.04805

论文摘要

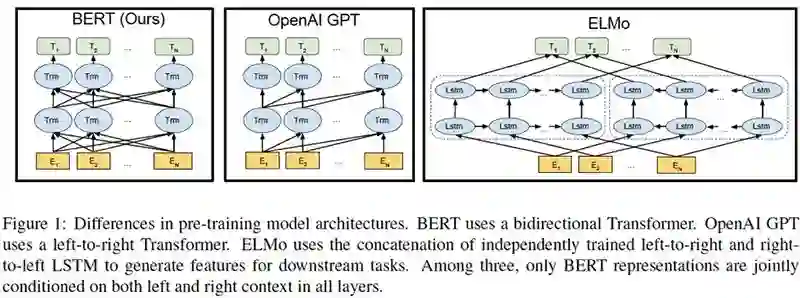

我们引入了一种名为BERT的新语言表示模型,它是Transformer的双向编码器表示。与最近的语言表示模型不同,BERT旨在通过联合调节所有层中的左右上下文来预训练深度双向表示。因此,预训练的BERT表示可以通过一个额外的输出层进行微调,以创建适用于广泛任务的最先进模型,例如问答和语言推理,而无需实质性的具体的架构修改。

BERT在概念上简单且经验丰富,它获得了11项自然语言处理任务的最新成果,包括将GLUE基准推至80.4%(提升了7.6%)、MultiNLI准确度达到86.7%(提升了5.6%)、SQuADv1.1问题回答测试F1到93.2%(提升了1.5%)。

总结

谷歌AI团队提出了自然语言处理(NLP)的新前沿模型-BERT,它的设计允许模型从每个词的左侧和右侧考虑上下文。BERT在11个NLP任务上获得了新的最先进的结果,包括问题回答,命名实体识别和与一般语言理解相关的其他任务。

论文的核心思想是什么?

·通过随机屏蔽一定比例的输入token来训练深度双向模型-从而避免单词间接“看到自己”的周期。

https://www.reddit.com/r/MachineLearning/comments/9nfqxz/r_bert_pretraining_of_deep_bidirectional/

·通过构建简单的二进制分类任务来预训练句子关系模型,以预测句子B是否紧跟在句子A之后,从而允许BERT更好地理解句子之间的关系。

·训练一个非常大的模型(24个Transformer块,1024个隐藏层,340M参数)和大量数据(33亿字语料库)。

什么是关键成就?

·刷新了11项NLP任务的记录,包括:

·获得80.4%的GLUE分数,这比之前最佳成绩提高了7.6%;

·在SQuAD 1.1上达到93.2%的准确率。

·预训练的模型不需要任何实质的体系结构修改来应用于特定的NLP任务。

AI社区对其看法?

·BERT模型标志着NLP的新时代;

https://www.topbots.com/most-important-ai-research-papers-2018/

·两个无人监督的任务在一起为许多NLP任务提供了很好的性能;

https://twitter.com/Reza_Zadeh/status/1051182968998252544

·预训练语言模型成为一种新标准;

https://twitter.com/seb_ruder/status/1050694435200278528

未来的研究领域是什么?

·在更广泛的任务上测试该方法。

·收集BERT可能捕获或未捕获的语言现象。

最可能的商业应用是什么?

BERT可以帮助企业解决各种NLP问题,包括:

提供更好的聊天机器人客服体验;

客户评论分析;

搜索相关信息;

你在哪里可以代码?

·Google Research发布了一个官方Github存储库,其中包含Tensorflow代码和BERT预训练模型。

https://github.com/google-research/bert

·BIT的PyTorch实现也可以在GitHub上获得。

https://github.com/codertimo/BERT-pytorch

2.人类注意力的序列分类

作者:MARIA BARRETT,JOACHIM BINGEL,NORA HOLLENSTEIN,MAREK REI,ANDERSSØGAARD

论文地址

http://aclweb.org/anthology/K18-1030?spm=a2c4e.11153940.blogcont689035.21.192f7c6annqg2o

论文摘要

学习注意力函数需要非常大规模的数据,不过有很多自然语言处理任务都是对人类行为的模拟,在这篇论文中作者们就表明人类的注意力确实可以为 NLP 中的许多注意力函数提供一个不错的归纳偏倚。具体来说,作者们根据人类阅读语料时的眼睛动作追踪数据估计出了「人类注意力」,然后用它对 RNN 网络中的注意力函数进行正则化。作者们的实验表明,人类注意力在大量不同的任务中都带来了显著的表现提升,包括情感分析、语法错误检测以及暴力语言检测。

总结

Maria Barrett和她的同事建议使用从眼动(eye-tracking)追踪语料库中获取的人类注意力来规范循环神经网络(RNN)中的注意力。通过利用公开可用的眼动追踪语料库,即通过眼睛跟踪测量(例如注视持续时间)增强的文本,它们能够在NLP任务中显着提高RNN的准确性,包括情绪分析、滥用语言检测和语法错误检测。

论文的核心思想是什么?

· 使用人的注意力,从眼动追踪语料库中估计,以规范机器注意力。

· 模型的输入是一组标记序列和一组序列,其中每个标记与标量值相关联,该标量值表示人类读者平均专注于该标记的注意力。

· RNN联合学习循环参数和注意力功能,但可以在来自标记序列的监督信号和眼睛跟踪语料库中的注意力轨迹之间交替。

· 建议的方法不要求目标任务数据带有眼睛跟踪信息。

什么是关键成就?

· 在注意力序列分类任务中引入循环神经结构。

· 证明使用人眼注意力(从眼动追踪语料库中估计)来规范注意力功能可以在一系列NLP任务中实现显著改善,包括:

§ 情绪分析,

§ 检测语言检测,

§ 语法错误检测。

· 性能比基线平均误差减少4.5%。这些改进主要是由于召回率(recall)增加。

AI社区对其看法?

· 该论文获得了关于计算自然语言学习顶级会议的CoNLL 2018人类语言学习和处理启发的最佳研究论文特别奖。

未来的研究领域是什么?

· 在学习人类相关任务时,探索利用人类注意力作为机器注意力的归纳偏见的其他可能性。

什么是可能的商业应用?

· RNN结合人类注意力信号,可应用于商业环境:

§ 加强客户评论的自动分析;

§ 过滤掉滥用的评论,回复。

你在哪里可以得到实现代码?

· 本研究论文的代码可在GitHub上获得。

https://github.com/coastalcph/Sequence_classification_with_human_attention

3.基于短语和神经元的无监督机器翻译

作者:GUILLAUMELAMPLE,MYLE OTT,ALEXISCONNEAU,LUDOVIC DENOYER,MARC'AURELIORANZATO

论文地址

https://arxiv.org/abs/1804.07755?spm=a2c4e.11153940.blogcont689035.23.192f7c6aZlkZCJ&file=1804.07755

论文摘要

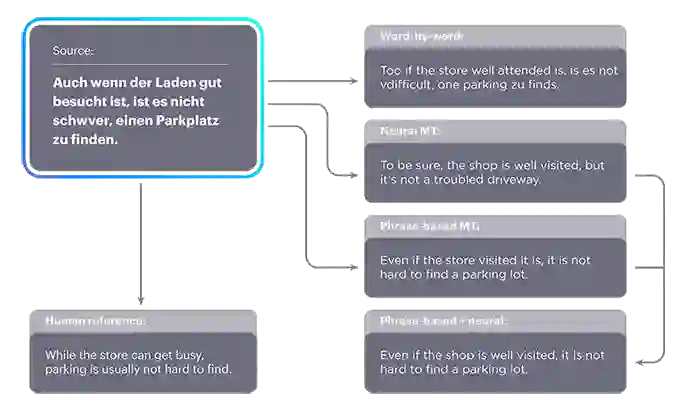

机器翻译系统在某些语言上实现了接近人类的性能,但其有效性强烈依赖于大量并行句子的可用性,这阻碍了它们适用于大多数语言。本文研究了如何在只能访问每种语言的大型单语语料库时学习翻译。我们提出了两种模型变体,一种神经模型,另一种基于短语的模型。两个版本都利用参数的初始化、语言模型的去噪效果以及通过迭代反向翻译自动生成并行数据。这些模型明显优于文献中的方法,同时更简单且具有更少的超参数。在广泛使用的WMT'14英语-法语和WMT'16德语-英语基准测试中,我们的模型不使用单个平行句的情况下分别获得28.1和25.2 BLEU分数,超过现有技术水平11 BLEU分。在英语-乌尔都语和英语-罗马尼亚语等低资源语言中,我们的方法比半监督和监督方法获得的效果都要好,我们的NMT和PBSMT代码是公开的。

总结

FacebookAI研究人员承认了缺乏用于训练机器翻译系统的大型并行语料库,并提出了一种更好的方法来利用单语数据进行机器翻译(MT)。特别是,他们认为通过适当的翻译模型初始化、语言建模和迭代反向翻译,可以成功地完成无监督的MT。研究人员提出了两种模型变体,一种是神经模型,另一种是基于短语的模型,它们的性能都极大地超越了目前最先进的模型。

论文的核心思想是什么?

· 无监督的MT可以通过以下方式完成:

§ 合适的翻译模型初始化(即字节对编码);

§ 在源语言和目标语言中训练语言模型,以提高翻译模型的质量(例如,进行本地替换,单词重新排序);

§ 用于自动生成并行数据的迭代反向转换。

· 有两种模型变体:神经和基于短语:

§ 神经机器翻译一个重要的属性:跨语言共享内部表示。

§ 基于短语的机器翻译在低资源语言对上优于神经模型,且易于解释和快速训练。

什么是关键成就?

· 基于神经和短语的机器翻译模型显著优于以前的无监督,例如:

§ 对于英语-法语任务,基于短语的翻译模型获得的BLEU分数为28.1(比之前的最佳结果高出11 BLEU分);

§ 对于德语-英语任务,基于神经和短语的翻译模型组合得到BLEU得分为25.2(高出基线10个BLEU点)。

· 无监督的基于短语的翻译模型实现了超过使用10万个并行句子训练的监督模型对应的性能。

AI社区的对其想法?

· 该论文在自然语言处理领域的领先会议被评为EMNLP 2018评为最佳论文奖。

https://vimeo.com/306145842

未来的研究领域是什么?

· 寻找更有效的原则实例或其他原则。

· 扩展到半监督模型。

什么是可能的商业应用?

· 改进其中没有足够的并行语料库来训练受监督的机器翻译系统的机器翻译结果。

你在哪里可以得到实现代码?

· Facebook团队在GitHub上提供了本研究论文的原始实现代码。

未完待续......

本文由阿里云云栖社区组织翻译。

文章原标题《WE SUMMARIZED 14 NLP RESEARCH BREAKTHROUGHS YOU CAN APPLY TO YOURBUSINESS》作者:Mariya Yao

译者:虎说八道,审校:袁虎。

点击左下角阅读原文获取本文推荐的论文资料!

更多精彩

如果觉得本文还不错,点击好看一下!