编译 | 沈祥振 审稿 | 夏忻焱 今天为大家介绍的是来自Maxwell W. Libbrecht,Wyeth W. Wasserman和Sara Mostafavi的一篇关于人工智能对于基因组学的可解释性的研究的综述。基于深度学习的人工智能(AI)模型现在代表了基因组学研究中进行功能预测的最先进水平。然而,模型预测的基础往往是未知的。对于基因组学研究人员来说,这种缺失的解释性信息往往比预测本身更有价值,因为它可以使人们对遗传过程有新的认识。作者回顾了可解释人工智能(xAI)新兴领域的进展,以启发生命科学研究人员对复杂深度学习模型的洞察力。之后,作者分类讨论了模型解释的方法,包括直观地理解每种方法的工作原理及其在典型高通量生物数据集中的基本假设和局限性。

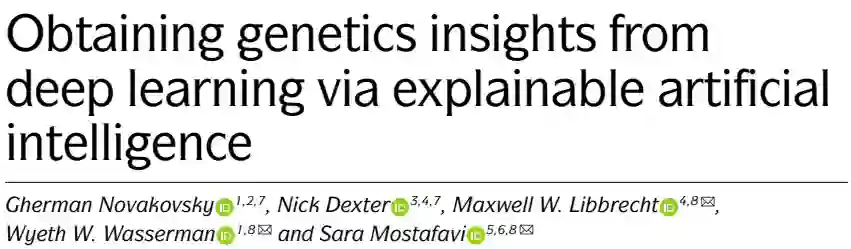

在接下来的章节中,作者首先介绍了关于深度学习方法在调节基因组学中如何使用的基础知识,然后对四种解释方法进行了分类:基于模型的解释、影响的数学传播、特征之间相互作用的识别以及透明模型的先验知识的使用(图1)。在整个综述中,作者使用了调控基因组学领域的例子,其所提出的概念可以广泛推广。

图1:可解释人工智能的概念方法

深度学习之于调控基因组学

神经网络和序列-活性模型

深度神经网络(DNN)模型已成为调控基因组学预测模型的主要类型。本综述重点介绍基于神经网络的序列-活性模型。这些模型以假定的调控DNA序列(通常为100–10000 bp)为输入,旨在预测序列活性的某些动态特性(即细胞或环境特异性)。目前对于如何为给定任务设计最佳神经网络结构没有共识,因此研究人员通常使用多种结构进行实验。

DNN模型为何解释困难?

作者总结了DNN模型的三大挑战。首先,DNN对潜在特征表示进行编码的高容量导致了最先进的预测精度,但它也面临着识别模型所学习的特征和特征组合的挑战。第二个挑战是从局部解释(一次估计给定输入示例上的特征重要性)到对整个数据集上的重要特征组合的全局理解。另一个关键困难是无法系统地评估解释策略,首先是因为缺乏基准数据集,其中真正的重要特征集是提前知道的,其次是因为各种算法所做假设的有效性取决于输入数据集的属性和所涉及的生物过程。

基于模型的解释

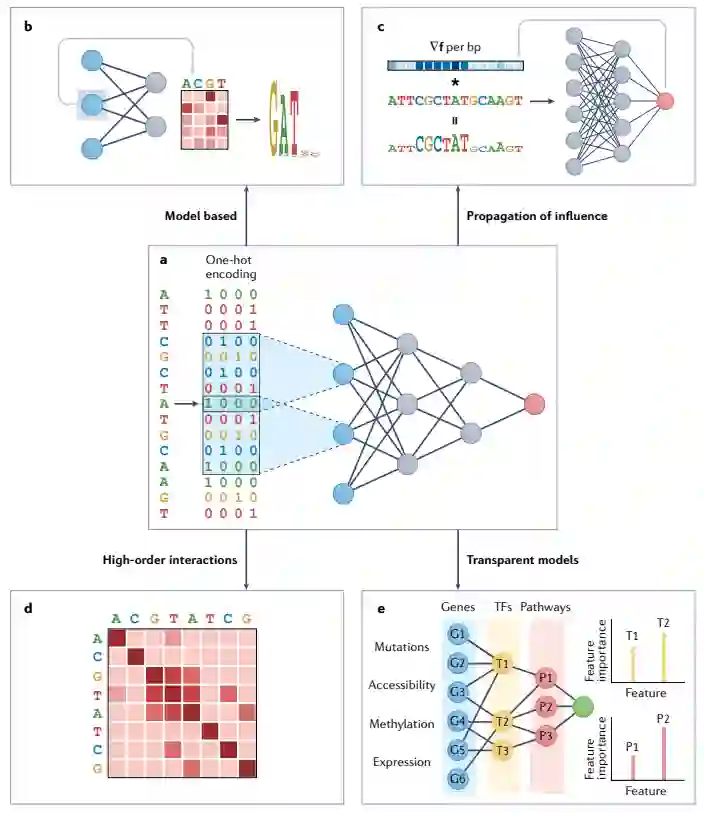

模型解释的直观方法是检查网络的各个组件,以了解它们代表的(隐藏的)模式及其对预测性能的贡献。可以考虑基于模型的解释的两种主要方法类别:最简单的方法是直接检查隐藏神经元的活动,以提取一组相关特征;第二种方法是使用注意机制训练模型,通过一组学习的注意权重直接产生每个输入特征的相关性度量。在本节中,作者描述了如何将这些方法应用于序列-活性模型,以了解网络第一层学习到的单个特征。

解释第一层卷积节点

在卷积序列-活性模型中,第一层神经元(滤波器)捕获短序列模体,编码在卷积权重矩阵中。从数学上讲,将卷积权重矩阵应用于序列所执行的操作相当于使用位置权重矩阵(PWM)扫描序列(图2a)。在实践中,常见的策略是搜索在选定阈值以上激活给定滤波器的子序列,并根据激活子序列集的对齐情况直接构建PWM(图2b)。由于神经网络在设计上过于参数化,仅仅存在PWM并不意味着它是一个预测性、有趣或有用的特征。因此,我们需要测量PWM对模型预测的贡献。在基于节点的策略中,这是通过依次对每个滤波器进行置零,并测量这种置零对模型预测结果的影响来实现的(图2c)。

图2:基于模型的解释方法

用于可视化特征重要性的注意权重机制

先前的实证研究表明,将注意力权重按顺序直接解释为活动设置方面有一定的前景。注意力可以被视为一种权重正则化形式,其为输入序列引入了权重,以对输入中的位置进行优先级排序,尽可能保留相关信息以进行处理。注意力机制可以提高神经网络模型的性能和可解释性。顾名思义,当与模型训练相结合时,注意力权重迫使模型在学习隐藏特征的同时关注输入的有限部分。在序列-活性模型的情况下,可以直接检查注意力向量,以帮助识别在模型内部表示中起关键作用的输入部分(图2d)。

影响的数学传播

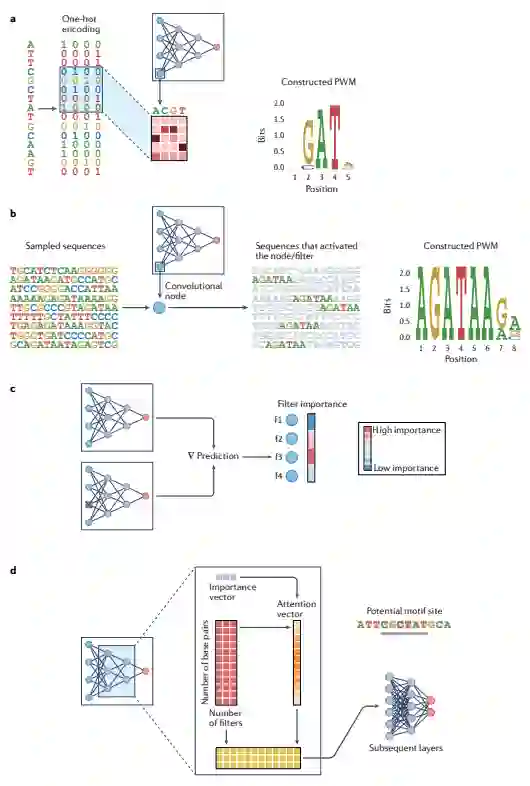

该算法通过在模型中传播扰动数据并观察对预测的影响,直接对输入示例进行操作。基于传播的归因方法可以分为两大类:向前和向后。在本节中,作者讨论了最流行的归因方法背后的概念基础、它们的缺点以及遗传数据背景下的缓解策略。

影响的正向传播

本节主要介绍了硅诱变(ISM)策略。ISM与图像像素翻转类似,考虑翻转与生物序列核苷酸相对应的元素,以确定训练模型的特征重要性(图3a)。与单核苷酸ISM不同,输入序列的较大延伸可以改变,以识别依赖于重要碱基对组合的重要基序(类似于实验室扫描诱变)(图3b)。

影响的反向传播

由于生成准确统计数据需要大量的前向传递,因此前向传播方法的计算成本很高。反向传播方法是为了解决这个问题而开发的。这些方法通过评估给定输入序列下模型F的导数来近似ISM,以计算序列的微小变化对模型预测的影响(图3c)。

从局部传播结果到全局解释

为了从基于传播的方法生成的逐序列属性图中进行概括,以揭示对重要模体的全局理解,需要聚合许多输入示例的结果。可以使用TFMoDisco作为针对DNA输入序列的方法。

图3:基于传播的解释方法

特征之间相互作用的识别

在基因调控的背景下,人们普遍认识到,转录因子(TF)之间的相互作用可以解释除单独附着于每个TF之外的活动。本节描述了前面提到的生成局部解释的方法如何解释特征之间的相互作用。

基于模型的交互识别

检查较深层的神经元是一个明显策略。神经网络的较深层往往会聚合在较低层中学习到的特征。搜索那些最大限度地激活给定隐藏神经元的输入,效果最好。可以应用自注意机制模型来实现对神经元重要程度的量化。

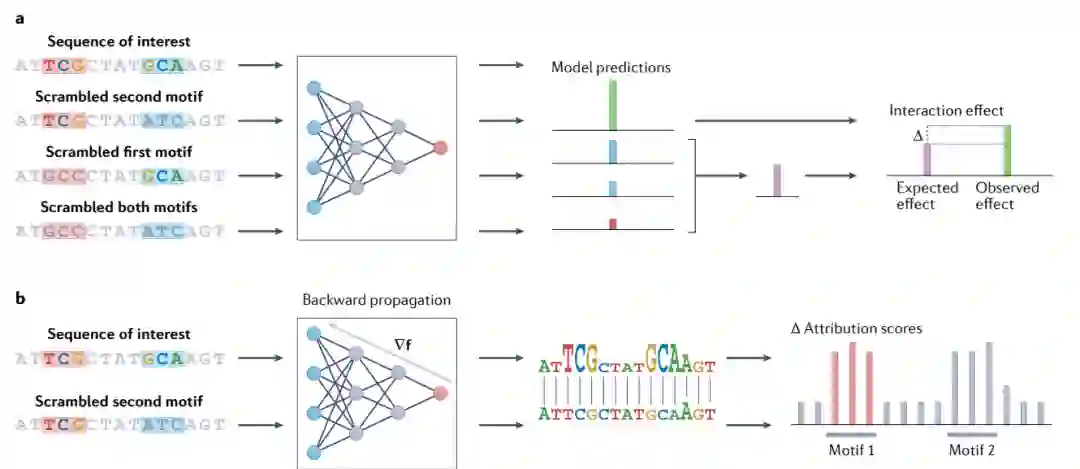

通过数学传播解释相互作用

基于ISM的传播方法(向前和向后)可以用于解释模型内的交互。但该领域应用ISM的计算成本非常高。可以以受限的方式应用来降低其计算成本,这些方式包括:将两个基序插入随机序列,对包含特定基序对的序列进行有针对性的分析(图4a);正向和反向传播方法的折衷结合,即深层特征交互图(DFIM)(图4b)。

图4:揭示模型特征之间相互作用的方法

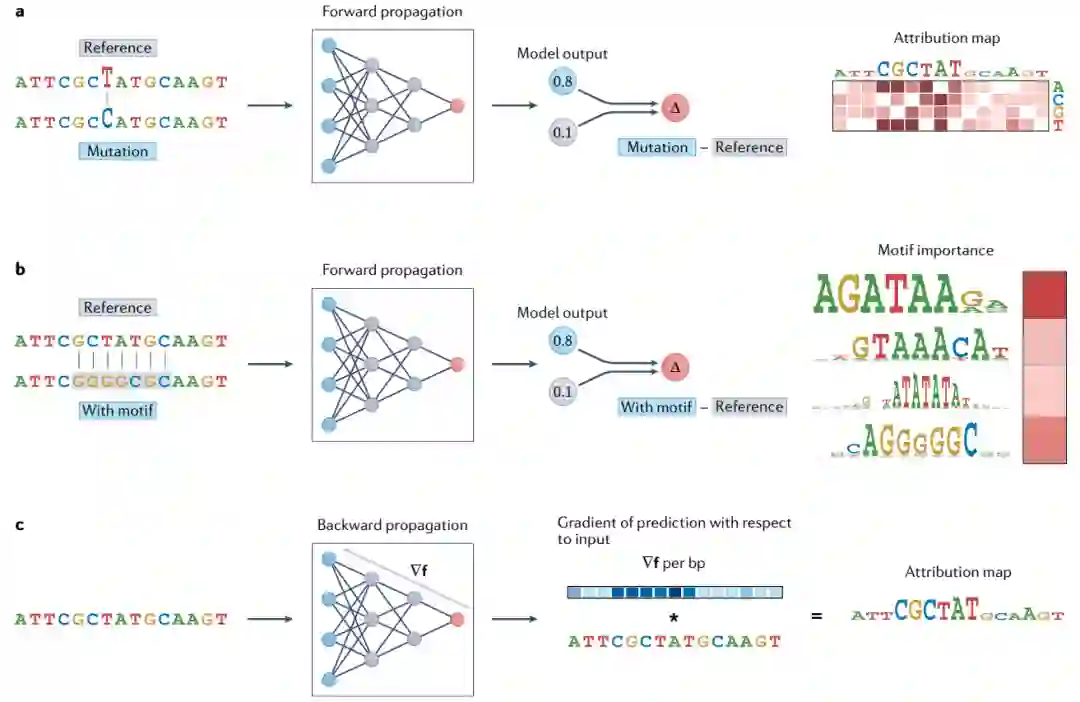

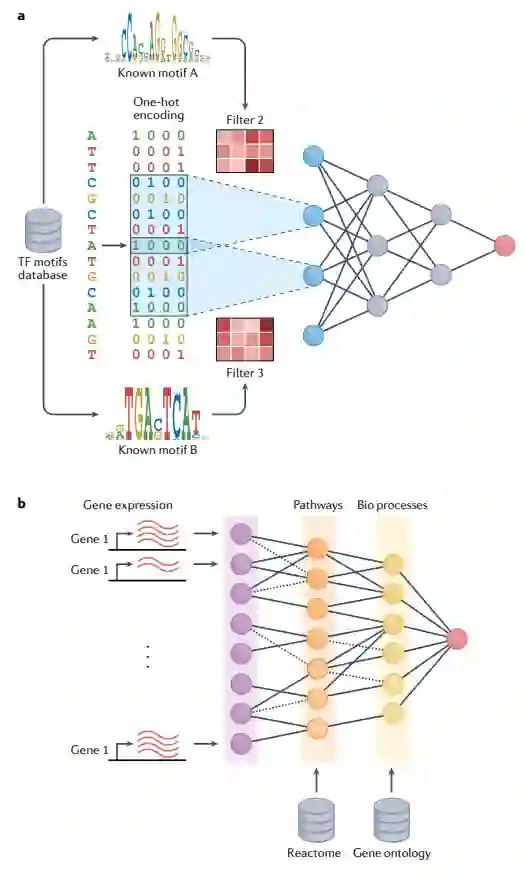

透明模型中先验知识的应用

透明神经网络模型是这样一种模型,其中隐藏的节点被构造成在物理上对应于粒度级别上的生物单元,这有助于解释更深层的隐藏节点(图5)。图5a展示了根据已知的TF绑定基序初始化过滤器,以演示如何使用先验知识来设计网络架构,构建具有固有可解释单元的模型。图5b展示了如何检查训练的模型,以深入了解给定上下文中存在的此类先验交互作用。

图5:利用先验知识构造透明神经网络

结论和未来展望

在本综述中,作者重点介绍了序列-活性模型,其所述的xAI方法可广泛应用于基因组学的深度学习应用。模型解释的目的和效用在很大程度上取决于目标应用,因此应该根据目标指导解释方法的选择。解释模型有其实际意义,但也不可盲目相信。解释模型可用于识别训练数据中存在的虚假相关性,防止预测模型通过学习非生物“捷径”实现高精度。然而,解释模型的“不可识别性”阻碍了解释的可靠性。因此,必须谨慎使用解释模型,并理解某些特性以及由此产生的特征可能是偶然的结果。对于哪种xAI方法最有效还没有达成共识,作者预计,随着这一领域的成熟,最佳实践将得到确立,并集成到可访问的分析工具中。随着生物数据集的规模和可用性的增长,使用模型研究特征之间的复杂关系变得越来越重要。从这些模型中提取洞察力需要有效的xAI方法。因此,xAI将在基因组学中发挥越来越重要的作用。 参考资料 Novakovsky, G., Dexter, N., Libbrecht, M.W. et al. Obtaining genetics insights from deep learning via explainable artificial intelligence. Nat Rev Genet (2022). https://doi.org/10.1038/s41576-022-00532-2