GNN如何可解释?悉尼科大最新《可解释图神经网络研究》综述,全面阐述可解释GNN的方法与评价指标

来自悉尼科技大学最新《可解释图神经网络研究》综述,重点研究可解释图神经网络,并基于可解释方法对其进行分类。

-

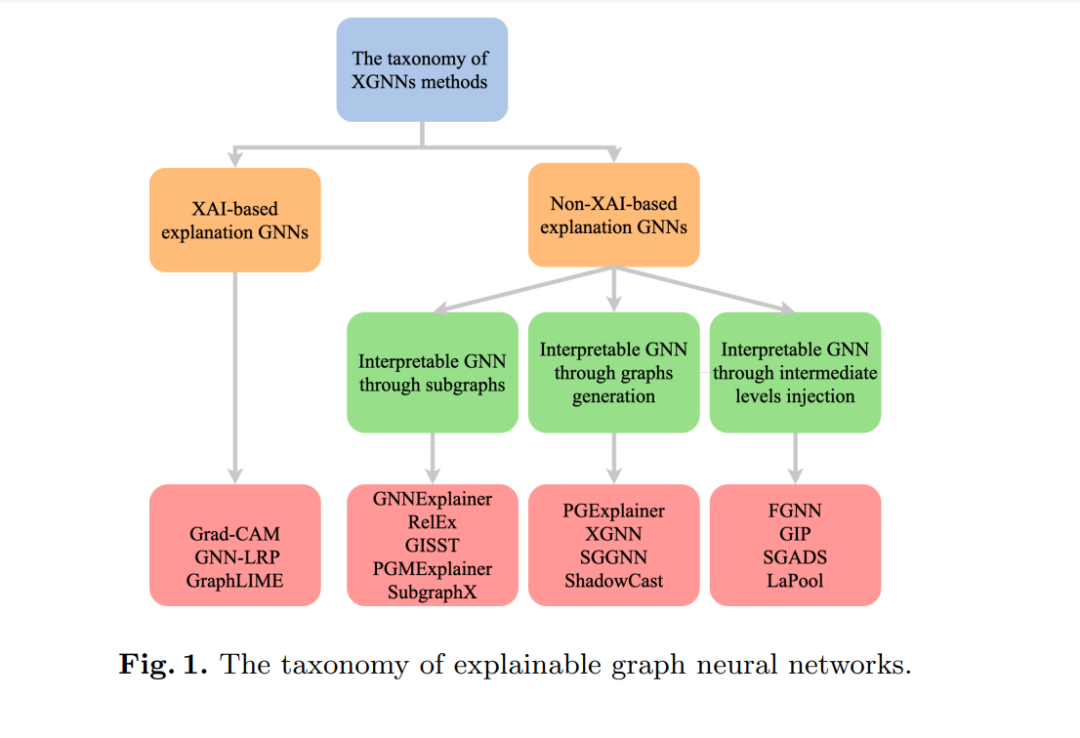

我们系统地分析了最新的XGNNs方法,并将其分为两组: 基于XAI的XGNNs ,利用现有的XAI方法来解释GNN;基于非XAI的XGNNs,它脱离了当前的XAI方法,同时试图通过利用图的固有结构和特性来解释GNN。

-

我们提出了XGNNs的评估指标,可以用来衡量XGNNs方法的性能 ,因为评估指标的知识对于教育XGNNs的最终用户/从业者是必要的。

-

讨论了XGNNs研究中经常出现的问题和可能的解决方案,最后指出了进一步提高XGNNs可解释性的几个潜在研究方向 。

基于XAI的可解释图神经网络

通过分析XGNNs的文献,我们对可解释GNN的方法进行了二元分类,分为基于XAI的方法和基于非XAI的方法两类。XGNN的分类如图1所示。我们首先简要介绍XAI,然后介绍XGNN,因为它将有助于理解XGNN基于XAI的可解释技术。

可解释人工智能

在过去的几年里,XAI已经成为一个热门的研究课题,在这一领域的研究越来越多。多项研究综述了它的历史、分类、评价、挑战和机遇,主要集中在深度神经网络(DNNs)[1][4][6][20][8]的解释。XAI技术可以按照[6]中讨论的三种分类: (i)可解释范围的差异,(ii) 方法的差异,和 (iii) ML模型使用的差异(见图2)。

根据ML模型使用的不同,我们还可以将XAI分为模型特定的XAI和模型无关的XAI。特定于模型的XAI是指专注于单个或一组特定AI模型的可解释性的任何方法;而模型无关的XAI并不强调底层的AI模型。

模型无关的XAI可以用于评估大多数AI模型,通常在训练后应用,因此它们通常被视为事后方法。模型无关的XAI依赖于分析输入和输出特征对,并且无法访问AI模型的具体内部工作方式(例如,权重或结构信息),否则将不可能将其与黑箱模型[21]解耦。通过分析模型特定型XAI和模型无关XAI的特点可以看出,模型特定型XAI方法对特定参数的依赖程度较高,而模型架构的任何变化都可能导致解释方法本身或对应的可解释算法发生显著变化。因此,特定于模型的XAI方法无法扩展以解释GNN。然而,一些模型无关的XAI方法可以被扩展来解释GNN。

用XAI方法解释图神经网络

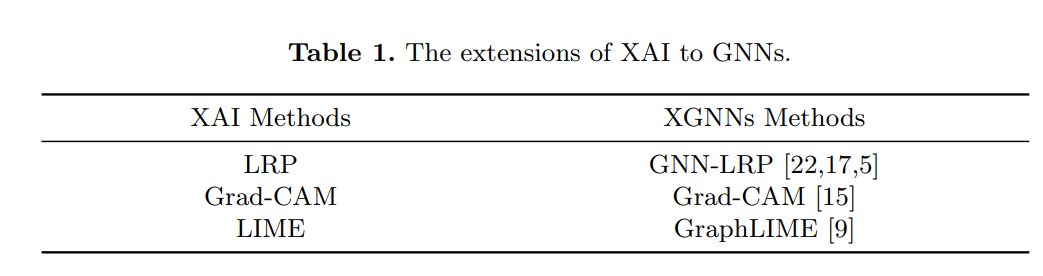

卷积神经网络(CNNs)通过将卷积运算扩展到图和一般的非欧几里得空间,可用于图结构数据。将神经网络扩展到非欧几里得空间视为图卷积神经网络(GCNNs)。因此,我们可以将最初为CNN设计的常见解释方法,扩展到GCNN。我们发现XAI的多种方法都可以很容易地推广到GNN,如LRP [2], LIME [16], Grad-CAM[18]。表1总结了这些扩展。

分层关联传播(LRP)假设分类器可以分解为多个计算层,并将顶层的DNNs输出传播到输入层。在每一层,应用一个传播规则[2]。对目标输出节点的贡献反向传播到输入特征,形成对该节点贡献的特征映射。因此,LRP在可视化输入特征对模型预测的贡献方面非常有用,特别是对于基于核的分类器和多层神经网络。受此激励,研究人员[22]在GNN中使用LRP来获得GNN模型黑箱的洞见。Schnake等人[17]提出了基于GNN-LRP的高阶泰勒展开法。GNN- LRP生成包含GNN模型和输入图之间复杂嵌套交互的详细解释。此外,Cho等人[5]使用LRP对个体预测进行了事后解释。LRP通过网络反向传播计算每个神经元的相关性,从预测的输出水平到输入水平,相关性表示给定神经元对预测的定量贡献。此外,Baldassarre等[3]也将LRP应用于图模型。LRP方法通过将输出预测分解为输入的组合来计算显著性映射。

局部可解释模型无关解释(LIME)是XAI中另一种流行的方法。LIME从黑盒模型中提取单个预测实例,并生成一个更简单、可解释的模型,如线性模型,以近似其决策特征。然后可以解释这个简单的模型,并使用它来解释原始的黑盒预测[16]。许多其他的论文已经改进和扩展了LIME。Zhao等人[35]引入了BayLIME,将LIME与贝叶斯相结合。Zafar等人[33]使用了多个生成解释之间的Jaccard相似性,并提出了一个确定性版本的LIME。此外,LIME也被广泛应用于GNN中来解释GNN模型。Huang等[9]提出了GraphLIME,一种使用Hilbert-Schmidt独立准则(HSIC) Lasso的图的局部可解释模型解释,这是一种非线性特征选择方法来实现局部可解释。它们的框架是通用的GNN模型解释框架,该框架在被解释节点的子图中局部学习非线性可解释模型。

梯度加权类激活映射(Gradient-weighted Class Activation Mapping, Grad-CAM)通过放松倒数第二层必须是卷积[18]的架构限制来改进CAM。通过将目标概念的梯度流到最终的卷积层,生成粗略的定位图,以突出输入图像中的重要区域。CAM已广泛应用于各种卷积神经网络模型族[18]。Pasa[14]直接将其作为卷积神经网络解释的可视化工具。Vinogradova等人[25]进一步扩展了Grad-CAM,并将其应用于局部生成热图,显示语义分割中单个像素的相关性。Grad-CAM也可以扩展到GNN。Pope等人[15]描述了将CNN可解释方法扩展到GCNNs。他们为GCNNs的决策引入了解释法(Grad-CAM)。Grad-CAM能够生成关于网络不同层的热图。

基于非XAI的可解释图神经网络

大多数基于XAI的XGNN方法不需要知道GNN模型的内部参数,用于解释的XAI方法也不是专门为CNN模型设计的。因此,当人们需要进一步探索GNN模型的结构时,尤其是对于大型和复杂的模型来说,这些方法可能无法给出令人满意的解释,这并不奇怪。为了缓解这一问题,近年来,研究人员开始考虑图结构的特点,开发适合GNN模型的可解释方法。有三种不同的方法来实现这个目标:(1)通过找到重要的子图来解释GNN模型;(2)通过生成新的图来解释GNN模型,而生成的图应该保持最多的信息特征(如节点、节点特征和边);(3)通过添加中间层次解释GNN模型。

通过子图可解释的GNN

通过子图可解释的GNN是一组使用子图添加GNN模型可解释性的方法,它通常专注于局部特性,然后只产生最重要的子图

通过图生成可解释的GNN

与关注子图不同,通过图生成解释GNN需要考虑整个图结构(或全局结构)。它考虑了图的整体结构。然后生成一个新的图,其中只包含GNN进行决策所需的结构。

可通过中间层解释GNN

通过中间层注入解释GNN可以直接将知识/信息作为因子图编码到模型体系结构中。如Ma等人[12]建立的因子图神经网络(Factor Graph Neural Network, FGNN)模型,将基因本体等生物知识直接编码到模型架构中。因子图神经网络模型中的每个节点对应一些生物实体,如基因或基因本体术语,使模型具有透明性和可解释性。

可解释技术的评估指标

由于解释者被用来解释为什么做出了某个决定,而不是描述整个黑盒,所以解释者本身的保真度存在不确定性。因此,使用正确的度量来评估可解释性技术的正确性和完整性是至关重要的。此外,XAI[36]的一些评估指标也可以应用到XGNNs 中。本节简要介绍xgnn解释的常用评估指标。我们特别关注保真度、稀疏性、准确性、鲁棒性和对比度。

讨论

本综述的重点是为可解释GNN提供一个清晰的分类。通过对可解释GNN相关文献的分析,我们总结出以下问题。

如何解释图神经网络? 主要有两种观点。

GNN可以被视为一个黑箱,并找到一种独立的方式来解释输入和输出之间的联系,如GraphLIME或RelEx。

另一种方法试图解释GNN的细节,利用节点和边本身的信息。

如何将XAI方法扩展到神经网络图?有一些研究使用XAI方法来解释gnn(见第2.2节)。XAI方法包括Saliency Maps、LRP、LIME、Guided BP、Grad-CAM等,具有较好的性能,可以推广用于解释GNN。然而,这些方法并不是专门为gnn设计的,需要了解模型的内部参数。

如何找到影响图神经网络预测的最重要的子图结构?正如我们在第3.2节中提到的,有几种方法可以通过聚焦子图结构来解释GNN。例如,GNNExplainer识别出一个紧凑的子图结构和一个小子集的节点特征,这可能在GNN的预测中发挥关键作用。此外,PGMExplainer和GISST通过生成与任何基于图的任务相关的重要子图和节点特征子集来生成解释。然而,这些方法只关注局部信息的子图结构,而没有考虑任何全局特征。

如何从全局角度解释图神经网络?相对于通过局部图结构获得的分段信息,全局结构往往可以提供更有趣、更完整的信息。例如,PGExplainer专注于解释完整的图结构,并提供了GNN所做预测的全局理解。它可以在一组实例上集体解释GNN的预测,并很容易将学习到的解释器模型推广到其他实例。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GNNX” 就可以获取《GNN如何可解释?悉尼科大最新《可解释图神经网络研究》综述,全面阐述可解释GNN的方法与评价指标》专知下载链接