因果机器学习

·

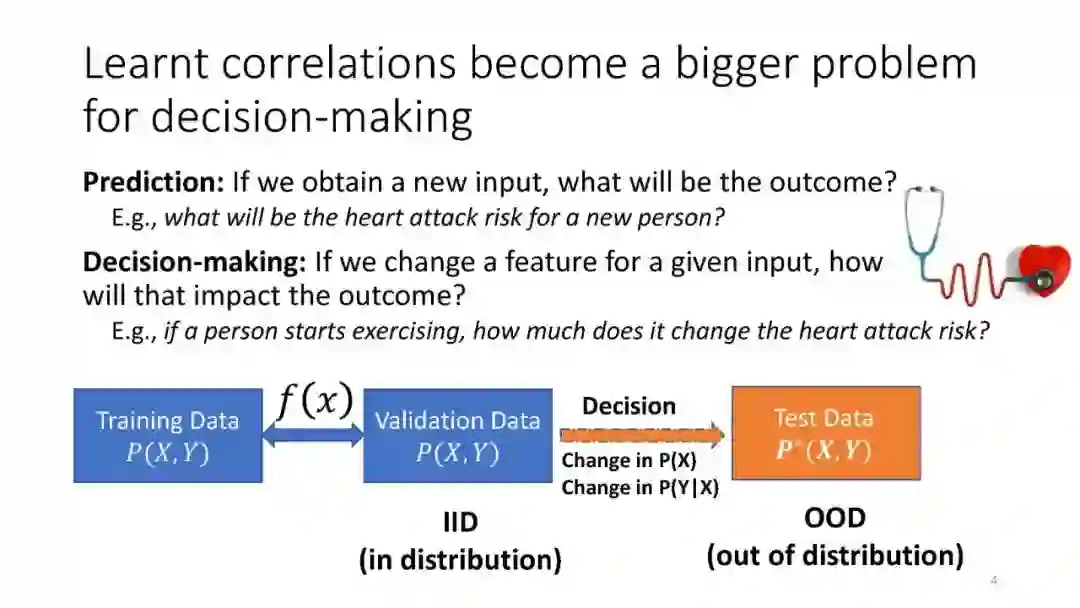

由于深度神经网络在计算机视觉、自然语言处理和游戏(最显著的是通过强化学习)方面的成功应用,机器学习已经获得了科学界的巨大关注。然而,机器学习社区中越来越多的人认识到,AI拼图中仍然缺少一些基本的东西,其中包括因果推理。这种认识来自于这样一种观察:尽管因果关系是贯穿科学、工程和人类认知的许多其他方面的核心组成部分,但在当前的学习系统中,对因果关系的明确引用很大程度上是缺失的。 这需要一个新的目标,即将因果推理和机器学习能力集成到下一代智能系统中,从而为更高水平的智能和以人为中心的AI铺平道路。这种协同作用是双向的;因果推理受益于机器学习,反之亦然。 当前的机器学习系统缺乏利用潜在因果机制所留下的不变性的能力,无法对可泛化性、可解释性、可解释性和鲁棒性进行推理。 随着数据分布从训练集偏移,最先进的机器学习模型无法泛化,即使是在很小的偏移下,如旋转(图像)或改变语义等效的单词(文本)。这些失败通常是因为模型倾向于从出现新数据的训练数据中学习虚假的相关性。虽然已经提出了许多基于正则化或数据增强的解决方案,但最近的实证研究表明,它们没有一个在数据集上可靠地工作。原因是这些方法没有考虑底层数据生成过程的因果结构,该结构控制着分布如何发生。我将提出一个用于构建可泛化ML模型的新框架,该框架将已知的因果知识直接注入神经网络的训练中。它是通过使用因果图描述不同类型的分布偏移并自动推断要应用的正确正则化来实现的。

成为VIP会员查看完整内容