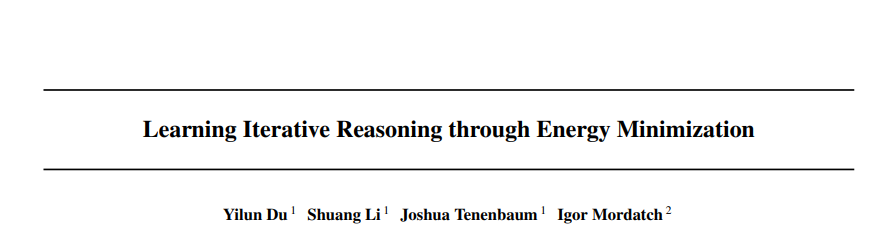

深度学习在图像分类和物体识别等复杂的模式识别任务中表现出色。然而,它很难处理需要困难推理的任务,比如算法计算。人类能够通过迭代推理来解决这样的任务——花更多的时间来思考更难的任务。然而,大多数现有的神经网络都表现出由神经网络体系结构控制的固定计算开销,从而阻止了对更难的任务进行额外的计算处理。在这项工作中,我们提出了一个新的框架迭代推理与神经网络。我们训练一个神经网络,将所有输出的能量参数化,并将迭代推理的每一步作为能量最小化步骤来实现,以找到最小能量解决方案。通过将推理作为一个能量最小化问题,对于导致更复杂的能量景观的更难的问题,我们可以通过运行一个更复杂的优化程序来调整我们的潜在计算预算。我们的经验表明,我们的迭代推理方法在图和连续域可以解决更精确和可泛化的算法推理任务。最后,我们说明了我们的方法可以递归地解决需要嵌套推理的算法问题。可以在https://energy-based-model.github.io/iterativereasoning-as-energy-minimization/上获得代码和其他信息。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年8月21日

Arxiv

0+阅读 · 2022年8月10日