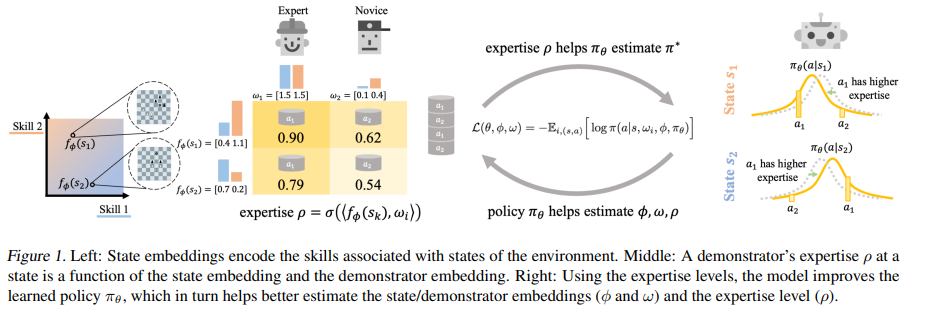

许多现有的模仿学习数据集是从多个演示者那里收集的,每个演示者在环境的不同部分具有不同的专长。然而,标准的模仿学习算法通常将所有演示者视为同质的,而不考虑他们的专业知识,吸收任何次优演示者的弱点。在这项工作中,我们表明,在演示者专业知识上的无监督学习可以导致模仿学习算法性能的持续提高。我们根据经验丰富的策略和演示者的专业水平,开发和优化一个联合模型。这使得我们的模型能够从最优行为中学习,并过滤掉每个演示者的次优行为。我们的模型学习了一个单一的策略,这个策略甚至可以超过最好的演示者,并且可以用来评估任何状态下任何演示者的专业知识。我们阐述了我们在Robomimic和离散环境(如MiniGrid和国际象棋)中对真实机器人连续控制任务的研究结果,在23个设置中有21个优于竞争方法,在最终奖励方面平均提高7%,最高提高60%。

成为VIP会员查看完整内容